- IBM planuje komputer kwantowy o ponad 4 000 kubitów do 2025 roku, osiągnięty przez połączenie trzech układów Kookaburra po 1 386 kubitów, tworząc system o 4 158 kubitach.

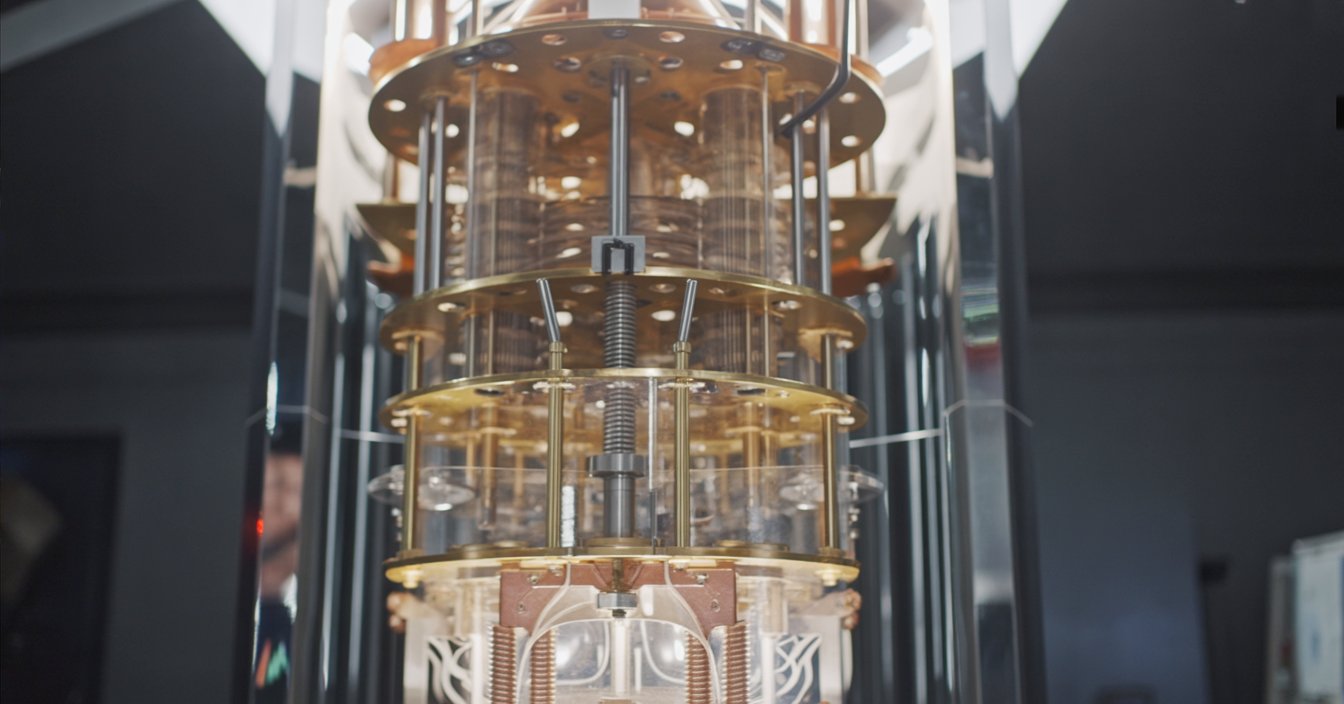

- Modułowa platforma Quantum System Two, zaprezentowana w 2023 roku, została zaprojektowana do obsługi wielu układów i wyposażona jest w kriogeniczną lodówkę oraz zaawansowaną elektronikę sterującą.

- Pod koniec 2023 roku IBM uruchomił pierwszy Quantum System Two, obsługując równolegle trzy procesory Heron po 133 kubity.

- Do końca 2025 roku IBM zamierza umieścić trzy układy Kookaburra w System Two, tworząc jedną maszynę z 4 158 kubitami.

- IBM wykorzystuje sprzęgacze krótkiego zasięgu chip-to-chip oraz połączenia kriogeniczne do łączenia układów w jedną strukturę obliczeniową.

- Firma nazywa to podejście superkomputerem zorientowanym na kwanty, łącząc QPU z CPU i GPU w jednolitą strukturę obliczeniową.

- Qiskit Runtime i circuit knitting umożliwiają deweloperom uruchamianie dużych zadań kwantowych na wielu układach z wbudowaną redukcją błędów.

- System o ponad 4 000 kubitów będzie działał w reżimie NISQ w 2025 roku, opierając się na redukcji błędów zamiast pełnej korekcji błędów kwantowych.

- Eksperci szacują, że złamanie RSA-2048 wymagałoby około 4 000 logicznych kubitów z korekcją błędów, co prawdopodobnie oznacza miliony fizycznych kubitów.

- Konkurenci to m.in. Google, dążący do odpornego na błędy obliczania kwantowego do 2029 roku, IonQ rozwijający kubity algorytmiczne, Quantinuum skupiający się na wysokiej wierności i odporności na błędy oraz D-Wave oferujący system wyżarzania o ponad 5 000 kubitów.

IBM jest na progu przełomu w obliczeniach kwantowych: „superkomputer kwantowy” z ponad 4 000 kubitów do 2025 roku. Ambitny plan giganta technologicznego – będący częścią szerszej strategii kwantowej – ma zrewolucjonizować obliczenia, rozwiązując problemy, z którymi nie radzą sobie najszybsze dzisiejsze superkomputery. W tym raporcie przeanalizujemy drogę IBM w dziedzinie kwantów, projekt systemu o ponad 4 000 kubitów, opinie ekspertów (i hype), porównanie z rywalami jak Google i IonQ oraz co może oznaczać maszyna o 4 000 kubitów dla świata.

Tło: Dążenie IBM do komputerów kwantowych

IBM był pionierem w dziedzinie obliczeń kwantowych, przewodząc zarówno w rozwoju sprzętu, jak i oprogramowania. Już w 2020 roku IBM przedstawił mapę drogową dla kwantów i od tego czasu realizuje kolejne etapy. W 2021 roku zaprezentowali procesor Eagle o 127 kubitach – układ tak złożony, że jego obwodów „nie można wiarygodnie zasymulować dokładnie na klasycznym komputerze” [1]. W 2022 roku IBM wprowadził układ Osprey o 433 kubitach, co stanowiło duży skok względem Eagle pod względem liczby kubitów [2]. Najnowszym osiągnięciem, pod koniec 2023 roku, było osiągnięcie poziomu 1 121 kubitów dzięki procesorowi Condor – pierwszemu procesorowi kwantowemu, który przekroczył barierę tysiąca kubitów [3]. Każdy z tych postępów stanowił kluczowy fundament do skalowania do tysięcy kubitów.

Ale strategia IBM nie polega tylko na dokładaniu kolejnych kubitów. Firma podkreśla podejście pełnostosowe: solidny kwantowy sprzęt, inteligentne kwantowe oprogramowanie oraz szeroki ekosystem użytkowników i partnerów [4], [5]. W 2016 roku IBM udostępnił pierwszy komputer kwantowy w chmurze do użytku publicznego, a dziś ponad 200 organizacji i 450 000 użytkowników jest połączonych z usługami kwantowymi IBM przez chmurę [6]. Ramy programistyczne IBM (Qiskit) oraz środowisko Qiskit Runtime umożliwiają deweloperom wydajne uruchamianie programów kwantowych, z wbudowanymi narzędziami do ograniczania błędów i orkiestracji hybrydowych obciążeń kwantowo-klasycznych [7], [8]. To ścisłe połączenie sprzętu i oprogramowania – wraz z siecią akademickich i przemysłowych współpracowników – jest kluczowe dla szerszego celu IBM: wprowadzenia użytecznego komputerowania kwantowego na świat, a nie tylko demonstracji laboratoryjnych.

IBM lubi nazywać tę wizję „superkomputerem zorientowanym na kwanty”. Chodzi o to, by ostatecznie splatać procesory kwantowe (QPU) z klasycznymi CPU i GPU w jednolitą strukturę obliczeniową [9]. Tak jak współczesne superkomputery łączą CPU i akceleratory AI do obsługi zadań AI, IBM widzi przyszłe superkomputery łączące silniki kwantowe i klasyczne, by rozwiązywać problemy, których żaden z nich nie mógłby rozwiązać samodzielnie [10]. Jak mówi dr Jay Gambetta, wiceprezes IBM ds. kwantów, „Teraz IBM wprowadza erę superkomputera zorientowanego na kwanty, gdzie zasoby kwantowe – QPU – będą splecione z CPU i GPU w strukturę obliczeniową”, mającą na celu rozwiązywanie „najtrudniejszych problemów” w nauce i przemyśle [11]. To śmiała wizja, która wykracza poza samo przyspieszanie komputerów; chodzi o zmianę samej istoty obliczeń.

Projektowanie superkomputera kwantowego z ponad 4 000 kubitów

Jak zbudować komputer kwantowy z ponad 4 000 kubitów? Odpowiedź IBM: modularność. Zamiast jednego ogromnego układu, IBM łączy wiele mniejszych układów kwantowych w jeden system – trochę jak łączenie węzłów w superkomputerze. Nowa platforma firmy, nazwana IBM Quantum System Two, została zaprojektowana właśnie do tego celu. Zadebiutowała w 2023 roku i jest pierwszym modułowym systemem komputerów kwantowych IBM, wyposażonym w nowoczesną lodówkę kriogeniczną i elektronikę sterującą, które mogą obsługiwać jednocześnie wiele procesorów kwantowych [12], [13]. To fizyczny „dom”, który będzie gościł nadchodzącą flotę połączonych układów IBM, wszystkie schłodzone do temperatury bliskiej zeru absolutnemu. Dzięki łączeniu układów, IBM może szybko zwiększać liczbę kubitów bez konieczności produkowania niemożliwie dużych pojedynczych układów – podejście to jest kluczowe, by przejść od setek do tysięcy kubitów.

Ilustracja: Wizja IBM dotycząca superkomputera kwantowego polega na połączeniu wielu układów kwantowych w jeden system. W 2025 roku IBM planuje wprowadzić „Kookaburra”, procesor z 1 386 kubitami i łączami komunikacji kwantowej; trzy układy Kookaburra można połączyć w jeden system z 4 158 kubitami [14]. Taka modułowa architektura pozwala IBM skalować się do tysięcy kubitów poprzez sieciowanie mniejszych procesorów, zamiast polegać na jednym ogromnym układzie.

Serce planu IBM dotyczącego 4 000 kubitów stanowi nadchodząca rodzina procesorów o ptasich nazwach kodowych. W 2024 roku IBM ma wprowadzić „Flamingo”, układ o 462 kubitach, zaprojektowany do testowania komunikacji kwantowej między układami [15]. IBM planuje zademonstrować konstrukcję Flamingo, łącząc trzy procesory Flamingo w jeden system o 1 386 kubitach – zasadniczo pokazując, że wiele układów może współpracować tak, jakby były jednym [16]. Następnie przyjdzie czas na coś większego: w 2025 roku IBM zaprezentuje „Kookaburra”, procesor o 1 386 kubitach stworzony z myślą o modułowej skalowalności [17]. Dzięki wbudowanym łączom komunikacyjnym, trzy układy Kookaburra mogą się połączyć, tworząc jedną maszynę z 4 158 kubitami [18]. Jak mówi IBM, będzie to pierwszy superkomputer skoncentrowany na kwantach, przekraczający granicę 4 000 kubitów.Jak wygląda ta architektura? Zasadniczo IBM wykorzystuje krótkodystansowe sprzęgacze chip-to-chip i połączenia kriogeniczne, aby łączyć kubity na różnych układach [19]. Wyobraź sobie każdy układ jako „płytkę” kubitów; sprzęgacze pozwalają sąsiadującym płytkom dzielić się informacją kwantową, a specjalne kable mikrofalowe mogą łączyć układy oddalone od siebie [20]. Wyzwanie polega na tym, by kubity na oddzielnych układach zachowywały się niemal tak, jakby były na tym samym układzie – co nie jest łatwe, ponieważ stany kwantowe są bardzo kruche. IBM opracowuje nową technologię sprzęgaczy, aby zachować koherencję splątanych kubitów między układami [21]. System Two zapewnia ultrazimne, wolne od drgań środowisko oraz elastyczną konfigurację okablowania, aby obsłużyć te sieci wieloukładowe [22]. Całością zarządza „inteligentna” warstwa sterująca (oprogramowanie i klasyczne obliczenia), która kieruje operacjami kwantowymi na różnych układach, sprawiając, że działają one wspólnie [23].

Harmonogram IBM zakłada, że system z ponad 4 000 kubitów będzie działał operacyjnie w 2025 roku [24]. W rzeczywistości pierwsze elementy są już na miejscu. Pod koniec 2023 roku, podczas IBM Quantum Summit, IBM uruchomił pierwszy Quantum System Two, obsługujący równolegle trzy mniejsze procesory „Heron” o 133 kubitach [25]. Służyło to jako prototyp: Heron to stosunkowo niskokubitowy układ, ale z znacząco poprawionymi wskaźnikami błędów, a IBM wykorzystał System Two, aby pokazać, że może obsługiwać wiele procesorów razem jako jeden system [26]. W ciągu najbliższego roku lub dwóch IBM będzie to skalować – wymieniając na większe układy (takie jak Flamingo, a następnie Kookaburra) i łącząc ich więcej. Celem jest, aby do końca 2025 roku IBM Quantum System Two obsługiwał trzy układy Kookaburra, a tym samym ponad 4 000 połączonych kubitów w jednej maszynie [27]. Patrząc dalej w przyszłość, IBM przewiduje nawet łączenie wielu System Two: na przykład połączenie trzech takich systemów mogłoby w przyszłości dać klaster ponad 16 000 kubitów [28]. Innymi słowy, 4 000 kubitów to nie jest cel końcowy – to kamień milowy na drodze do jeszcze większych maszyn kwantowych, budowanych przez sieciowanie modułów, podobnie jak klasyczne superkomputery skalują się przez dodawanie kolejnych węzłów.

Wizja IBM: Wnioski od liderów kwantowych

Zespół IBM ds. komputerów kwantowych jest, co zrozumiałe, podekscytowany – i pełen optymizmu – wobec tego, co oznacza ten skok do 4 000 kubitów. Dyrektor ds. badań w IBM, dr Darío Gil, wielokrotnie mówił o wejściu w nową erę praktycznego obliczania kwantowego. „Realizacja naszej wizji dała nam jasny wgląd w przyszłość kwantów i to, co będzie potrzebne, aby wejść w erę praktycznego obliczania kwantowego”, powiedział Gil, gdy IBM rozszerzył swoją mapę drogową [29]. Mając na horyzoncie cel 4 000+ kubitów, określił to jako wprowadzenie „ery superkomputerów skoncentrowanych na kwantach, które otworzą ogromne i potężne przestrzenie obliczeniowe” dla deweloperów, partnerów i klientów [30]. Innymi słowy, IBM postrzega to jako świt komputerów kwantowych, które nie są już tylko eksperymentami laboratoryjnymi, ale potężnymi narzędziami do zastosowań w rzeczywistym świecie.

Jay Gambetta, IBM Fellow i wiceprezes ds. kwantów, nazwał rok 2023 przełomowym momentem – chwilą, gdy koncepcja superkomputera skoncentrowanego na kwantach stała się rzeczywistością w formie prototypu [31]. Według Gambetty, samo posiadanie większej liczby kubitów to za mało; „superkomputery skoncentrowane na kwantach będą wymagały czegoś więcej niż tylko dużej liczby kubitów”, wyjaśnił – potrzebna jest także większa głębokość obwodów i ścisła integracja z systemami klasycznymi [32]. Odzwierciedla to nacisk IBM na jakość kubitów oraz płynne połączenie obliczeń kwantowych i klasycznych. „Naszą misją jest dostarczenie użytecznych komputerów kwantowych światu,” powiedział Gambetta. „Będziemy nadal oferować najlepszy pełny stack rozwiązań kwantowych w branży — a to od branży zależy, jak te systemy zostaną wykorzystane” [33]. Przekaz: IBM dostarczy sprzęt i oprogramowanie, a oni oczekują, że firmy i naukowcy zaczną robić z tym coś przełomowego.

Podczas Quantum Summit 2023 zespół IBM wyraził optymistyczne podejście do dojrzałości tej technologii. „Znajdujemy się zdecydowanie w erze, w której komputery kwantowe są wykorzystywane jako narzędzie do eksploracji nowych granic nauki,” skomentował dr Darío Gil, zauważając, że maszyny kwantowe nie są już tylko ciekawostkami [34]. Podkreślił postępy IBM w skalowaniu tych systemów dzięki modułowej konstrukcji i obiecał, że „dalsze zwiększanie jakości stosu technologii kwantowej na skalę użytkową – i oddanie go w ręce naszych użytkowników oraz partnerów, którzy będą przesuwać granice coraz bardziej złożonych problemów” [35]. W istocie, gdy IBM zwiększa liczbę kubitów, pracuje także nad poprawą wierności kubitów i „inteligencji” oprogramowania, aby te tysiące kubitów mogły faktycznie wykonywać użyteczną pracę nad złożonymi problemami.

IBM używa nawet barwnej metafory dla nadchodzącej zmiany. Firma porównuje przejście od dzisiejszych wczesnych komputerów kwantowych do kwantowego superkomputera w 2025 roku do „zastąpienia papierowych map satelitami GPS” w nawigacji [36]. To sugestywny obraz: kwantowe superkomputery mogłyby prowadzić nas przez problemy obliczeniowe w zupełnie nowy sposób, tak jak GPS zrewolucjonizował sposób, w jaki się poruszamy. Czy rzeczywistość dorówna optymizmowi IBM, dopiero się okaże, ale nie ma wątpliwości, że najlepsi specjaliści IBM wierzą, iż są o krok od czegoś wielkiego.

Co mówią eksperci: Hype i zderzenie z rzeczywistością

Ogłoszenie IBM o 4 000 kubitach wywołało sporo szumu, ale zewnętrzni eksperci często przypominają, by zachować zdrowy rozsądek w oczekiwaniach. Zwracają uwagę na kluczową kwestię: więcej kubitów samo w sobie nie gwarantuje użytecznych rezultatów. Dzisiejsze kubity kwantowe są „hałaśliwe” – podatne na błędy – więc samo połączenie tysięcy niedoskonałych kubitów nie rozwiąże magicznie problemów, jeśli te kubity nie potrafią utrzymać koherencji. IEEE Spectrum zauważył, że plan IBM będzie musiał być wspierany przez „inteligentną warstwę oprogramowania”, która zarządza błędami i koordynuje hybrydowe obciążenie kwantowo-klasyczne [37]. W rzeczywistości, nowy potężny stos oprogramowania może być „kluczem do zrobienia czegokolwiek użytecznego” z procesorem 4 000-kubitowym, poprzez obsługę łagodzenia błędów i podział zadań między sprzęt kwantowy a klasyczne koprocesory [38]. Krótko mówiąc, liczba kubitów to nie wszystko – równie ważne jest, jak się je wykorzystuje i kontroluje.

Niektórzy obserwatorzy branży zwracają również uwagę na lukę między fizycznymi kubitami a kubitami logicznymi. Logiczny kubit to kubit z korekcją błędów, będący w istocie klastrem wielu fizycznych kubitów współpracujących, by działać jak jeden bardzo niezawodny kubit. Eksperci szacują, że złamanie współczesnych zabezpieczeń (takich jak 2048-bitowe klucze RSA chroniące bezpieczeństwo online) wymagałoby około 4 000 kubitów logicznych z korekcją błędów – co w praktyce może oznaczać miliony fizycznych kubitów, biorąc pod uwagę obecne narzuty związane z korekcją błędów [39]. Jak ujął to jeden z analityków ds. bezpieczeństwa, „4 000 kubitów logicznych to nie to samo co 4 000 rzeczywistych kubitów” – w pełni skorygowany komputer kwantowy z tysiącami kubitów logicznych to wciąż odległe marzenie [40]. Maszyna IBM z ponad 4 000 kubitów będzie daleka od tej odpornej na błędy wizji; będzie się składać z fizycznych kubitów, które wymagają sprytnych technik łagodzenia błędów, by były użyteczne. Badacze szybko ostrzegają, że nie powinniśmy oczekiwać, iż ta maszyna, na przykład, złamie szyfrowanie internetu lub rozwiąże wszystkie nierozwiązywalne problemy z dnia na dzień.Mimo to agresywna mapa drogowa IBM stawia firmę przed wieloma konkurentami w wyścigu na liczbę kubitów, a niektórzy eksperci chwalą modułowe podejście jako pragmatyczny sposób na skalowanie. „Wierzymy, że zasoby klasyczne mogą naprawdę zwiększyć możliwości kwantowe i pozwolić w pełni wykorzystać ten zasób kwantowy” – zauważył Blake Johnson, szef platformy IBM Quantum, podkreślając potrzebę współdziałania komputerów kwantowych i klasycznych, by wykorzystać potencjał tych dużych systemów [41]. To podejście jest szeroko podzielane: przyszłość to „kwantowo-plus-klasyczne” działające wspólnie.

Konkurencyjne wizje: IBM kontra Google, IonQ i inni

IBM nie jest osamotnione w wyścigu kwantowym, ale jego strategia różni się od innych głównych graczy. Google, na przykład, skupia się mniej na liczbie kubitów w krótkim okresie, a bardziej na osiągnięciu w pełni skorygowanego błędami komputera kwantowego. Plan działania Google zakłada stworzenie użytecznej, skorygowanej błędami maszyny kwantowej do 2029, a firma konsekwentnie pracuje nad demonstrowaniem kubitów logicznych i redukcją błędów, zamiast próbować pobijać rekordy liczby kubitów [42]. (Obecne urządzenia Google, takie jak 72-kubitowy Bristlecone czy nowsze wersje 53-kubitowego Sycamore, mają znacznie mniej kubitów niż urządzenia IBM, ale Google niedawno pokazało, że zwiększenie liczby fizycznych kubitów w jednym kubicie logicznym może zmniejszyć wskaźnik błędów, co jest obiecującym krokiem w kierunku skalowalności [43].) W publicznych wypowiedziach kierownictwo Google przewiduje, że komputery kwantowe zaczną mieć realny wpływ w perspektywie 5–10 lat [44]. Tak więc, podczas gdy IBM zmierza w stronę prototypu z 4 000 kubitów, Google gra na dłuższą metę, dążąc do w pełni odpornego na błędy komputera kwantowego, nawet jeśli w najbliższym czasie będzie mieć tylko kilkadziesiąt kubitów.

Quantinuum (firma utworzona przez Honeywell i Cambridge Quantum) to kolejny potentat, ale podąża inną ścieżką technologiczną: kubity pułapkowane jonowo. Quantinuum nie goni od razu za tysiącami fizycznych kubitów – ich najnowszy system pułapek jonowych ma rzędu 50–100 kubitów o wysokiej wierności – ale firma wykazała się rekordową objętością kwantową (miarą ogólnych możliwości) i nawet stworzyła 12 „logicznych” kubitów poprzez korekcję błędów w 2024 roku [45]. Plan działania Quantinuum zakłada w pełni odporną na błędy informatykę kwantową do 2030 roku, a firma kładzie nacisk na osiągnięcie „trzech dziewiątek” wierności (99,9% niezawodności) oraz przełomów w kubitach logicznych jako kamieni milowych [46]. Ich CEO, Rajeeb Hazra, twierdzi, że jakość i postępy w korekcji błędów odblokują „rynek wart bilion dolarów” dla technologii kwantowej, i utrzymuje, że Quantinuum ma „najbardziej wiarygodną mapę drogową w branży w kierunku… odpornej na błędy informatyki kwantowej” [47]. Podsumowując, Quantinuum skupia się na doskonaleniu kubitów i korekcji błędów, nawet jeśli oznacza to na razie mniejszą liczbę kubitów – co kontrastuje z dużą inwestycją IBM w skalowanie i radzenie sobie z szumem poprzez jego łagodzenie.

Kolejny kluczowy konkurent, IonQ, również wykorzystuje technologię pułapkowania jonów i podobnie podkreśla jakość kubitów. Kierownictwo IonQ często promuje „kubitów algorytmicznych” – wewnętrzny wskaźnik uwzględniający współczynniki błędów i łączność – zamiast samej liczby fizycznych kubitów [48]. Plan rozwoju IonQ zakłada „szeroką przewagę kwantową do 2025 roku”, ale poprzez stopniowe ulepszanie wydajności swoich kubitów i budowanie modułowych, montowanych w szafach systemów pułapek jonowych, a nie poprzez osiągnięcie konkretnej wysokiej liczby kubitów [49]. W rzeczywistości IonQ przewiduje, że potrzeba jedynie kilkudziesięciu wysokiej jakości kubitów, aby przewyższyć znacznie większe, szumiące komputery kwantowe w niektórych zadaniach. Były CEO Peter Chapman przewidywał, że technologia IonQ „będzie kluczowa dla komercyjnej przewagi kwantowej”, szczególnie podkreślając kubity algorytmiczne zamiast liczby fizycznych jako klucz do użytecznych zastosowań [50]. Ta filozofia podkreśla debatę w tej dziedzinie: czy komputery kwantowe to „gra liczb” (więcej kubitów szybciej), czy „gra jakości” (lepsze kubity, nawet jeśli wolniej się skalują)? IBM stawia na liczby (z uwzględnieniem jakości), podczas gdy IonQ zdecydowanie stawia na jakość.

Jest też Rigetti Computing, mniejszy gracz wykorzystujący kubity nadprzewodzące. Plan rozwoju Rigetti napotkał opóźnienia – firma miała nadzieję osiągnąć 1000 kubitów dzięki modułom wieloukładowym do 2024 roku, ale w praktyce ich systemy wciąż mają kilkadziesiąt kubitów. Na połowę 2025 roku Rigetti celuje w bardziej skromny system 100+ kubitowy do końca 2025 roku [51], koncentrując się po drodze na poprawie wierności i wydajności bramek dwukubitowych. Firma ma trudności z dotrzymaniem tempa szybkiej ekspansji IBM, co pokazuje, jak trudno nowym graczom dorównać zasobom i doświadczeniu IBM w tej dziedzinie. Mimo to Rigetti i inni przyczyniają się do innowacji (na przykład Rigetti był pionierem niektórych wczesnych technik integracji wieloukładowej) i podkreślają, że przewaga IBM nie jest nie do pokonania, jeśli pojawią się fundamentalne przełomy (takie jak lepsze projekty kubitów lub materiały).

Warto również wspomnieć o D-Wave Systems w tym kontekście. D-Wave, kanadyjska firma, posiada maszyny do wyżarzania kwantowego (inny model obliczeń kwantowych) z ponad 5 000 kubitami obecnie [52]. Jednak kubity D-Wave są zaprojektowane do rozwiązywania problemów optymalizacyjnych poprzez wyżarzanie, a nie do ogólnych algorytmów kwantowych. Osiągają wysoką liczbę kubitów dzięki specjalistycznej architekturze, ale te kubity nie mogą uruchamiać dowolnych obwodów kwantowych, jak urządzenia IBM czy Google. CEO D-Wave, Alan Baratz, zauważył, że ich technologia już przynosi wartość w niektórych zastosowaniach (takich jak optymalizacja grafików w handlu detalicznym czy tras w telekomunikacji) [53]. Istnienie systemu D-Wave z 5 000 kubitów przypomina, że nie wszystkie kubity są sobie równe – kubity D-Wave są przydatne do określonych zadań, ale nie można ich bezpośrednio porównywać z kubitami komputerów kwantowych opartych na bramkach. Cel IBM dotyczący ponad 4 000 kubitów odnosi się do uniwersalnych kubitów opartych na bramkach, co jest znacznie trudniejszym zadaniem pod względem złożoności i możliwości.

Podsumowując, IBM wyróżnia się agresywnym skalowaniem sprzętu opartego na nadprzewodzących kubitach i dąży do integracji go z klasycznym przetwarzaniem w krótkim czasie. Google koncentruje się na kamieniach milowych związanych z korekcją błędów, Quantinuum i IonQ skupiają się na wierności kubitów (przy mniejszej liczbie kubitów w najbliższym czasie), a firmy takie jak Rigetti pozostają w tyle z mniejszymi urządzeniami. Każde podejście ma swoje zalety. Jeśli IBM odniesie sukces, wyznaczy wysoką poprzeczkę pod względem liczby kubitów i być może szybciej osiągnie przewagę kwantową w użytecznych zadaniach. Jednak jeśli kubity będą zbyt zaszumione, te 4 000 kubitów może nie przewyższyć 100 doskonałych kubitów konkurencji. Najbliższe lata będą fascynującym wyścigiem pomiędzy różnymi filozofiami w obliczeniach kwantowych – i nie jest powiedziane, że więcej kubitów zawsze wygrywa, jeśli nie idzie to w parze z jakością i sprytnym oprogramowaniem.

Dlaczego 4 000 kubitów? Potencjalne zastosowania i wyzwania

Co mógłby faktycznie zrobić komputer kwantowy z 4 000 kubitami, jeśli działałby zgodnie z założeniami? Dla porównania, dzisiejsze komputery kwantowe (z kilkudziesięcioma lub kilkuset kubitami) jeszcze nie przewyższyły wyraźnie komputerów klasycznych w żadnym praktycznym problemie. IBM i inni uważają, że przekraczając tysiące kubitów, wejdziemy w strefę, w której użyteczna przewaga kwantowa stanie się możliwa dla określonych klas problemów [54]. Oto niektóre zastosowania i wpływy, które może odblokować system z 4 000 kubitów:

- Chemia i nauka o materiałach: Komputery kwantowe są szczególnie dobrze przystosowane do symulowania układów molekularnych i atomowych. Nawet największe klasyczne superkomputery mają trudności z dokładnym modelowaniem zachowania złożonych cząsteczek i reakcji chemicznych. Badacze IBM zauważają, że „niewiele dziedzin tak szybko skorzysta z komputerów kwantowych jak chemia”, ponieważ maszyny kwantowe mogą natywnie obsługiwać kwantową naturę interakcji chemicznych [55]. System z 4 000 kubitów mógłby potencjalnie symulować średniej wielkości cząsteczki lub nowe materiały z dużą dokładnością – wspierając odkrywanie leków, rozwój nowych materiałów (do baterii, nawozów, nadprzewodników itp.) oraz zrozumienie złożonych procesów chemicznych. Są to problemy, w których metody klasyczne napotykają ścianę z powodu wykładniczej złożoności. Do 2025 roku IBM przewiduje, że komputery kwantowe zaczną badać użyteczne zastosowania w naukach przyrodniczych, takich jak chemia [56].

- Optymalizacja i finanse: Wiele problemów rzeczywistych – od logistyki łańcucha dostaw po optymalizację portfela – polega na znalezieniu najlepszego rozwiązania spośród astronomicznie wielu możliwości. Komputery kwantowe, dzięki algorytmom takim jak QAOA czy technikom wyżarzania kwantowego, oferują nowe sposoby rozwiązywania niektórych problemów optymalizacyjnych. Maszyna z tysiącami kubitów mogłaby obsłużyć większe instancje problemów lub dostarczyć bardziej precyzyjne rozwiązania niż obecne urządzenia. CEO IBM, Arvind Krishna, zasugerował, że komputery kwantowe umożliwią nowe algorytmy optymalizacyjne, z których firmy będą mogły korzystać, co potencjalnie stanie się kluczową przewagą konkurencyjną dla branż takich jak finanse, energetyka i produkcja [57]. System z 4 000 kubitów mógłby na przykład rozwiązywać złożone problemy analizy ryzyka lub optymalizacji tras, których algorytmy klasyczne nie są w stanie rozwiązać w rozsądnym czasie.

- Uczenie maszynowe i AI: Coraz więcej badań dotyczy kwantowego uczenia maszynowego, gdzie komputery kwantowe mogą przyspieszyć niektóre typy zadań uczenia maszynowego lub zaoferować nowe możliwości modelowania. Mając tysiące kubitów, komputery kwantowe mogłyby zacząć implementować kwantowe modele sieci neuronowych lub wykonywać szybsze podprogramy algebry liniowej, które są podstawą algorytmów ML. IBM szczególnie traktuje uczenie maszynowe jako przypadek testowy dla zastosowań kwantowych – oczekując, że do 2025 roku komputery kwantowe będą wykorzystywane do badania przypadków użycia uczenia maszynowego obok klasycznego ML, co może poprawić sposób rozpoznawania wzorców w danych lub optymalizacji modeli ML [58]. Praktycznym przykładem może być kwantowo wspomagany wybór cech lub klasteryzacja na złożonych zbiorach danych, które mogą zostać przyspieszone przez kwantowe podprogramy.

- Badania naukowe i „Wielkie Wyzwania”: Poza wybranymi branżami, 4-tysięczny kubitowy superkomputer kwantowy byłby dobrodziejstwem dla nauki podstawowej. Mógłby być używany do symulacji scenariuszy fizyki wysokich energii, optymalizacji projektów materiałów kwantowych, a nawet badania zagadnień z kryptografii i matematyki. IBM wspominał ogólnie o naukach przyrodniczych – na przykład problemy z fizyki lub biologii, które obecnie są nierozwiązywalne, mogą ulec rozwiązaniu dzięki hybrydowemu podejściu kwantowemu [59]. Pomyśl o projektowaniu katalizatorów do wychwytywania dwutlenku węgla lub analizie układów kwantowych w fizyce jądrowej – to niezwykle złożone obliczenia, w których komputer kwantowy może dostarczyć nowych wglądów. Badacze IBM wskazywali na zastosowania w chemii, optymalizacji i uczeniu maszynowym jako wczesne cele osiągnięcia przewagi kwantowej [60].

To jest ta błyszcząca obietnica – ale co z wyzwaniami? 4-tysięczny komputer kwantowy napotka poważne przeszkody:

- Szum i wskaźniki błędów: Dzisiejsze kubity są podatne na błędy; dekoherują (tracą swój stan kwantowy) w ciągu mikrosekund, a operacje („bramki”) między kubitami są niedoskonałe. Przy zaledwie 50-100 kubitach algorytmy kwantowe mogą wykonać tylko bardzo krótki ciąg operacji, zanim błędy zdominują wynik. Jeśli masz tysiące kubitów, problem szumu się mnoży. W rzeczywistości połączenie trzech chipów (jak planuje IBM) może wprowadzić jeszcze więcej błędów z powodu nieco wolniejszych, mniej precyzyjnych operacji między chipami [61]. IBM przyznaje to i projektuje oprogramowanie Systemu Two tak, aby było „świadome” architektury – na przykład, aby planować kluczowe operacje na tym samym chipie i ostrożnie zarządzać wolniejszymi operacjami między chipami [62]. Bez korekcji błędów (która nie będzie w pełni wdrożona do 2025 roku), IBM będzie polegać na łagodzeniu błędów: sprytnych trikach zmniejszających wpływ błędów. Obejmuje to techniki takie jak probabilistyczna kompensacja błędów, gdzie celowo wprowadza się dodatkowy szum, aby poznać jego charakter, a następnie klasycznie przetwarza wyniki, by zniwelować błędy [63]. Metody te są kosztowne obliczeniowo i nie są doskonałe, ale badania IBM sugerują, że niektóre z nich mogą skalować się do urządzeń tej wielkości [64]. Mimo to, zarządzanie szumem to kluczowa kwestia – to powód, dla którego komputery kwantowe jeszcze nie rozwiązały problemów rzeczywistych, a maszyna z 4 000 kubitów odniesie sukces tylko wtedy, jeśli IBM zdoła utrzymać błędy na tyle niskim poziomie, by wykonywać głębokie obliczenia.

- Korekcja błędów i kubity logiczne: Długoterminowym rozwiązaniem problemu szumów jest korekcja błędów kwantowych (QEC), która polega na grupowaniu wielu kubitów fizycznych w jeden kubit logiczny, zdolny przetrwać błędy. System IBM z 4 000 kubitów prawdopodobnie nadal będzie działał w reżimie „NISQ” (Noisy Intermediate-Scale Quantum), co oznacza, że nie będzie jeszcze szeroko zakrojonej korekcji błędów – po prostu nie będzie wystarczającej liczby kubitów, aby w pełni korygować błędy wszystkich 4 000. (Dla porównania, zamiana nawet kilku tysięcy kubitów fizycznych w garstkę kubitów logicznych mogłaby pochłonąć całą maszynę). Jednak IBM przygotowuje się do wdrożenia korekcji błędów. Firma aktywnie prowadzi badania nad nowymi kodami QEC (na przykład kodem kwantowym LDPC, który jest bardziej wydajny pod względem liczby kubitów niż tradycyjne kody powierzchniowe) oraz szybkimi dekoderami błędów [65]. W rzeczywistości IBM niedawno rozszerzył swoją mapę drogową do roku 2033, wyraźnie priorytetyzując poprawę jakości bramek i rozwój modułów z korekcją błędów po 2025 roku [66]. Superkomputer z 4 000 kubitów można postrzegać jako pomost: ma być na tyle duży, by wykonywać pewne użyteczne zadania z łagodzeniem błędów, a jednocześnie umożliwić IBM naukę wdrażania częściowej korekcji błędów na dużą skalę. IBM ogłosił nawet plan stworzenia prototypowego, odpornego na błędy komputera kwantowego do 2029 roku [67], co wskazuje, że korekcja błędów jest bardzo wysoko na ich liście priorytetów po osiągnięciu progu 4 000 kubitów. Jednak osiągnięcie w pełni skorygowanych (logicznych) kubitów będzie wymagało rzędy wielkości więcej kubitów lub znacznie lepszej wierności kubitów – prawdopodobnie połączenia obu tych czynników.

- Oprogramowanie i narzędzia deweloperskie: Nawet jeśli masz 4 000-kubitowy komputer kwantowy, potrzebujesz oprogramowania, które potrafi go efektywnie wykorzystać. Algorytmy kwantowe muszą być odwzorowane na to złożone, wieloukładowe urządzenie. IBM rozwiązuje ten problem za pomocą narzędzi takich jak Qiskit Runtime i architektura Quantum Serverless. Pozwalają one użytkownikowi podzielić problem na mniejsze obwody kwantowe, uruchomić je równolegle na różnych chipach kwantowych i połączyć wyniki za pomocą klasycznego przetwarzania [68]. Na przykład, „circuit knitting” to jedna z technik, na które wskazuje IBM – dzielenie dużego obwodu na części pasujące do mniejszych procesorów, a następnie klasyczne łączenie wyników [69]. Do 2025 roku IBM planuje wprowadzić funkcje takie jak dynamiczne obwody (gdzie wyniki pomiarów mogą wpływać na przyszłe operacje w czasie rzeczywistym) oraz wbudowane tłumienie błędów działające na ich platformie chmurowej [70]. Wyzwanie będzie polegało na tym, aby wszystko to było przyjazne dla deweloperów. IBM chce, aby obliczenia kwantowe były dostępne tak, by data scientists i eksperci dziedzinowi (nie tylko doktorzy nauk kwantowych) mogli wykorzystać te 4 000 kubitów [71]. Osiągnięcie dobrej abstrakcji – gdzie użytkownik może np. wywołać funkcję wysokiego poziomu do symulacji cząsteczki, a system sam zdecyduje, jak wykorzystać do tego 4 000 kubitów – będzie kluczowe dla praktycznej użyteczności. Podejście IBM to koncepcja kwantowego middleware i „app store” prymitywów kwantowych: gotowych funkcji do typowych zadań, takich jak próbkowanie rozkładów prawdopodobieństwa czy szacowanie właściwości układów [72]. Jeśli się to uda, chemik w 2025 roku nie będzie musiał znać szczegółów sprzętu; wystarczy, że użyje oprogramowania IBM, by wykorzystać moc 4 000 kubitów do swojej symulacji.

- Infrastruktura fizyczna: Skalowanie do tysięcy kubitów to nie tylko wyzwanie obliczeniowe, ale inżynieryjny maraton. Procesory kwantowe muszą być chłodzone do temperatur milikelwinowych – zimniejszych niż przestrzeń kosmiczna. IBM musiał zaprojektować nową lodówkę rozcieńczalnikową (IBM Quantum System Two), która jest większa i bardziej modułowa niż poprzednie, aby pomieścić wiele chipów i całe ich okablowanie sterujące [73]. Lodówka, elektronika i okablowanie stają się coraz bardziej złożone wraz z dodawaniem kolejnych kubitów. Tysiące kubitów oznaczają tysiące linii sterowania mikrofalowego, zaawansowane filtrowanie, aby zapobiec przenikaniu ciepła i szumów do kubitów, oraz ogromne przepływy danych z odczytów kubitów. Inżynierowie IBM porównują złożoność skalowania systemów kwantowych do wczesnych superkomputerów lub misji kosmicznych. Do 2025 roku IBM spodziewa się „usunięcia głównych barier na drodze do skalowania” dzięki modułowemu sprzętowi i towarzyszącej elektronice sterującej [74] – warto jednak zauważyć, że IBM dopiero teraz napotyka te bariery. System Two w Nowym Jorku to w zasadzie prototyp do zarządzania taką złożonością [75]. IBM instaluje także System Two w Europie (we współpracy z rządem Kraju Basków w Hiszpanii) do 2025 roku [76], co pozwoli sprawdzić, jak tę nowoczesną infrastrukturę można powielić poza własnym laboratorium IBM. Sukces tych wdrożeń będzie ważnym dowodem na to, że rury i okablowanie superkomputera kwantowego mogą być niezawodne i łatwe w utrzymaniu.

W świetle tych wyzwań eksperci studzą entuzjazm, zauważając, że 4-tysięczna maszyna IBM będzie prawdopodobnie wysoce wyspecjalizowanym narzędziem. Może przewyższyć klasyczne superkomputery w określonych zadaniach (symulacje chemii kwantowej, niektóre optymalizacje lub zadania uczenia maszynowego, jak wspomniano), osiągając przewagę kwantową lub nawet przebłyski supremacji kwantowej w użytecznych kontekstach. Jednak nie sprawi ona natychmiast, że komputery klasyczne staną się przestarzałe. W rzeczywistości, w wielu zadaniach klasyczne superkomputery i GPU nadal będą szybsze lub bardziej praktyczne. Nawet mapa drogowa IBM to przyznaje: superkomputer kwantowy ma współpracować z klasycznym HPC, każdy robiąc to, w czym jest najlepszy [77]. Powinniśmy więc postrzegać system 4-tysięczny jako jeden z pierwszych prawdziwych „akceleratorów kwantowych” – coś, czego używasz obok klasycznego komputera, by rozwiązać naprawdę trudne problemy, z którymi klasyczne maszyny same sobie nie poradzą. To znaczący krok w stronę ostatecznego marzenia o odpornym na błędy komputerze kwantowym, ale nie jest to jeszcze cel ostateczny.

Droga przed nami: Mapa drogowa IBM dla komputerów kwantowych po 2025 roku

Superkomputer IBM z ponad 4000 kubitów to ważny kamień milowy, ale jest to część dłuższej mapy drogowej, która sięga lat 30. XXI wieku. IBM publicznie zadeklarował, że do 2025 roku, wraz z uruchomieniem tego superkomputera skoncentrowanego na technologiach kwantowych, „usuną niektóre z największych przeszkód stojących na drodze do skalowania sprzętu kwantowego” [78]. Jednak rozwój na tym się nie skończy. W 2025 roku i później, IBM będzie coraz bardziej skupiać się na skalowaniu z jakością – poprawie wierności kubitów, korekcji błędów oraz złożoności obwodów, które można uruchomić.

W rzeczywistości pod koniec 2023 roku IBM zaktualizował swoją Quantum Development Roadmap aż do 2033. Jeden z kluczowych celów: około 2026–2027 wprowadzić operacje kwantowe z korekcją błędów na swoich systemach, zmierzając w kierunku „zaawansowanych systemów z korekcją błędów” później w tej dekadzie [79]. IBM priorytetowo traktuje poprawę wierności bramek (zmniejszanie wskaźników błędów), tak aby większe obwody kwantowe (z tysiącami operacji) stały się możliwe [80]. Sugeruje to, że po osiągnięciu progu liczby kubitów, IBM podwoi wysiłki, by każdy kubit był lepszy i stopniowo wdrażał korekcję błędów. Konkretnym przykładem są prace IBM nad nowymi kodami korekcji błędów, takimi jak kwantowe kody LDPC i szybsze algorytmy dekodowania, które mają na celu bardziej efektywne radzenie sobie z błędami niż dzisiejsze kody powierzchniowe [81]. Mówi się także o procesorze IBM o nazwie kodowej „Loon” około 2025 roku, przeznaczonym do testowania komponentów architektury z korekcją błędów (np. modułów do łączenia kubitów dla konkretnego kodu QEC) [82]. Do 2029 roku IBM zamierza zbudować demonstracyjny prototyp kwantowy odporny na błędy, dążąc do tego samego celu co konkurenci tacy jak Google [83].

Na froncie sprzętowym IBM prawdopodobnie będzie kontynuować swoją serię procesorów o nazwach ptaków także po Kookaburrze. Mapa drogowa po 2025 roku nie jest w pełni publiczna, ale IBM zasugerował, że rozważa jeszcze większe systemy wieloukładowe, a być może technologie hybrydowe. Na przykład wizja IBM dotycząca superkomputera zorientowanego na kwanty ostatecznie obejmuje łącza komunikacji kwantowej, które mogą łączyć klastry układów scalonych na odległość, a nie tylko w tej samej lodówce [84]. Możemy zobaczyć, jak IBM wdraża światłowodowe połączenia międzyukładowe lub inne metody łączenia procesorów kwantowych w różnych kriostatach – podobnie jak kwantowa sieć lokalna. To umożliwiłoby osiągnięcie dziesiątek tysięcy, a nawet milionów kubitów w dłuższej perspektywie, co – jak przyznaje IBM – będzie konieczne do rozwiązywania najtrudniejszych problemów (i pełnej korekcji błędów) [85], [86]. Według słów samego IBM, ich modułowe i sieciowe podejście powinno pozwolić na skalowanie do „setek tysięcy kubitów” z czasem [87]. System 4000-kubitowy to w zasadzie pierwsza realizacja architektury superkomputera kwantowego, która może się rozrastać przez dołączanie kolejnych modułów.Szersza mapa drogowa IBM obejmuje także rozwijanie ekosystemu kwantowego. Firma inwestuje w edukację, partnerstwa i dostępność w chmurze, aby w momencie, gdy sprzęt będzie gotowy, istniała już społeczność gotowa z niego korzystać. Na przykład IBM współpracuje z laboratoriami narodowymi, uniwersytetami, a nawet rządami regionalnymi (jak w Japonii, Korei, Niemczech i Hiszpanii), aby udostępniać systemy kwantowe i wspierać lokalny rozwój. Plan wdrożenia pierwszego w Europie systemu IBM Quantum System Two w Hiszpanii do 2025 roku [88] jest częścią tej strategii – umożliwić większej liczbie osób praktyczny kontakt z zaawansowanym sprzętem kwantowym. Kierownictwo IBM przewiduje, że obliczenia kwantowe staną się kluczowym wyróżnikiem biznesowym w nadchodzących latach [89], i chcą być w centrum tej powstającej gospodarki kwantowej.

Podsumowując, projekt IBM dotyczący kwantowego superkomputera z ponad 4000 kubitów stanowi historyczny skok w skali obliczeń kwantowych. Jeśli się powiedzie, będzie to oznaczać przejście od odizolowanych, eksperymentalnych procesorów kwantowych do sieciowych systemów kwantowych, zbliżających się do progu praktycznej użyteczności. To przedsięwzięcie znajduje się na styku najnowocześniejszej fizyki, inżynierii i informatyki. To w równym stopniu wyczyn programistyczny, co sprzętowy, wymagający nowych sposobów zarządzania i programowania zupełnie nowego rodzaju superkomputera. Świat przygląda się uważnie – nie tylko ze względu na rekordową liczbę kubitów, ale także na to, czy IBM zdoła wykazać użyteczne rezultaty na tej maszynie, które przewyższą możliwości komputerów klasycznych.

W połowie 2025 roku IBM znajduje się na progu tego osiągnięcia: projekt sprzętu jest w dużej mierze gotowy, działają pierwsze prototypy, a firma ściga się, by zintegrować wszystko w funkcjonalny superkomputer. Sukces nie jest gwarantowany, ale impet i dotychczasowe postępy są niezaprzeczalne. Nawet konkurenci i sceptycy zgodziliby się, że IBM znacząco popchnął tę dziedzinę do przodu. Oczekując na pełną premierę kwantowego superkomputera IBM, jedno jest pewne – wchodzimy w nowy rozdział sagi obliczeniowej. Jak ogłosiło samo IBM, nadchodzący kwantowo-centryczny superkomputer ma stać się „kluczową technologią dla tych, którzy rozwiązują najtrudniejsze problemy, prowadzą najbardziej przełomowe badania i rozwijają najbardziej zaawansowane technologie” [90].

Najbliższe lata pokażą, czy ta obietnica się spełni, ale jeśli zakład IBM się powiedzie, 4000 kubitów może naprawdę zmienić oblicze informatyki na zawsze – otwierając drzwi do rozwiązań problemów, które kiedyś wydawały się niemożliwe, i zwiastując nadejście ery obliczeń kwantowych.

Źródła:

- IBM Newsroom: IBM Quantum roadmap and 4,000+ qubit system plans [91]

- IBM Research Blog: Quantum roadmap update for quantum-centric supercomputing (2024) [92]

- IBM Quantum Summit 2023 Press Release [93]

- TechMonitor: IBM prezentuje kwantowy superkomputer, który może osiągnąć 4000 kubitów do 2025 roku [94]

- IEEE Spectrum: Cel IBM: procesor 4 000-kubitowy do 2025 roku (analiza planu rozwoju i wyzwań) [95]

- InsideHPC: IBM na Think 2022 – wizja superkomputerów skoncentrowanych na kwantach [96]

- The Quantum Insider: Mapy drogowe komputerów kwantowych głównych graczy (IBM, Google, IonQ, itd.) [97]

- TomorrowDesk: Przegląd celu IBM dotyczącego kwantowego superkomputera w 2025 roku i projektu modułowego [98]

- Post-Quantum (blog branżowy): O liczbie kubitów potrzebnych do złamania szyfrowania RSA-2048 [99]

- TechMonitor: Cytaty dr. Darío Gila z IBM i statystyki IBM Quantum Network [100]

References

1. insidehpc.com, 2. www.techmonitor.ai, 3. tomorrowdesk.com, 4. newsroom.ibm.com, 5. insidehpc.com, 6. www.techmonitor.ai, 7. newsroom.ibm.com, 8. insidehpc.com, 9. insidehpc.com, 10. insidehpc.com, 11. insidehpc.com, 12. www.techmonitor.ai, 13. newsroom.ibm.com, 14. www.ibm.com, 15. www.ibm.com, 16. www.ibm.com, 17. www.ibm.com, 18. www.ibm.com, 19. spectrum.ieee.org, 20. spectrum.ieee.org, 21. tomorrowdesk.com, 22. www.techmonitor.ai, 23. insidehpc.com, 24. www.techmonitor.ai, 25. newsroom.ibm.com, 26. newsroom.ibm.com, 27. www.techmonitor.ai, 28. www.techmonitor.ai, 29. newsroom.ibm.com, 30. newsroom.ibm.com, 31. www.techmonitor.ai, 32. www.techmonitor.ai, 33. www.techmonitor.ai, 34. newsroom.ibm.com, 35. newsroom.ibm.com, 36. www.ibm.com, 37. spectrum.ieee.org, 38. spectrum.ieee.org, 39. postquantum.com, 40. postquantum.com, 41. spectrum.ieee.org, 42. thequantuminsider.com, 43. thequantuminsider.com, 44. thequantuminsider.com, 45. thequantuminsider.com, 46. thequantuminsider.com, 47. thequantuminsider.com, 48. thequantuminsider.com, 49. thequantuminsider.com, 50. thequantuminsider.com, 51. thequantuminsider.com, 52. thequantuminsider.com, 53. thequantuminsider.com, 54. tomorrowdesk.com, 55. www.ibm.com, 56. www.ibm.com, 57. thequantuminsider.com, 58. www.ibm.com, 59. www.ibm.com, 60. www.ibm.com, 61. www.ibm.com, 62. www.ibm.com, 63. spectrum.ieee.org, 64. spectrum.ieee.org, 65. thequantuminsider.com, 66. newsroom.ibm.com, 67. www.hpcwire.com, 68. www.ibm.com, 69. www.ibm.com, 70. www.ibm.com, 71. www.ibm.com, 72. www.ibm.com, 73. www.techmonitor.ai, 74. www.ibm.com, 75. newsroom.ibm.com, 76. tomorrowdesk.com, 77. tomorrowdesk.com, 78. www.ibm.com, 79. newsroom.ibm.com, 80. newsroom.ibm.com, 81. thequantuminsider.com, 82. www.hpcwire.com, 83. www.hpcwire.com, 84. newsroom.ibm.com, 85. newsroom.ibm.com, 86. insidehpc.com, 87. newsroom.ibm.com, 88. tomorrowdesk.com, 89. thequantuminsider.com, 90. insidehpc.com, 91. newsroom.ibm.com, 92. www.ibm.com, 93. newsroom.ibm.com, 94. www.techmonitor.ai, 95. spectrum.ieee.org, 96. insidehpc.com, 97. thequantuminsider.com, 98. tomorrowdesk.com, 99. postquantum.com, 100. www.techmonitor.ai