- IBM prévoit un superordinateur quantique de plus de 4 000 qubits d’ici 2025, obtenu en interconnectant trois puces Kookaburra de 1 386 qubits pour former un système de 4 158 qubits.

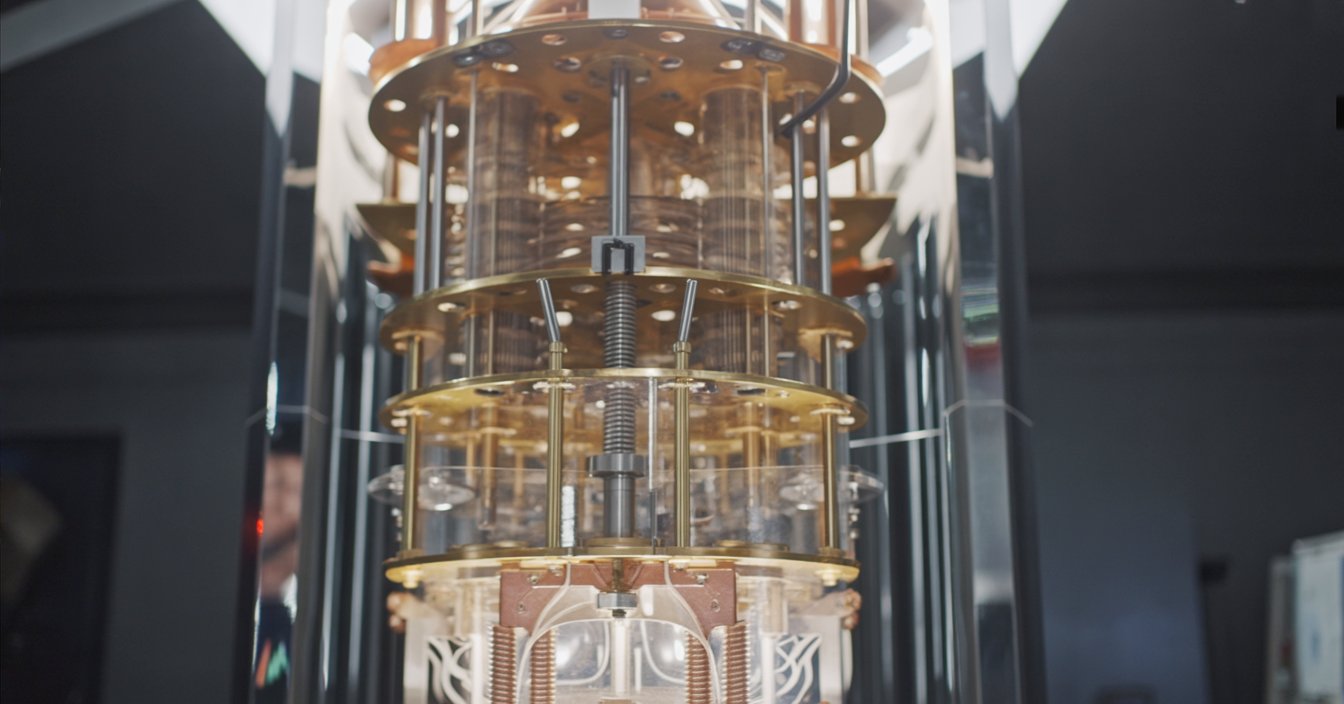

- La plateforme modulaire Quantum System Two, lancée en 2023, est conçue pour accueillir plusieurs puces et dispose d’un réfrigérateur cryogénique ainsi que d’une électronique de contrôle avancée.

- Fin 2023, IBM a mis en service le premier Quantum System Two, faisant fonctionner trois processeurs Heron de 133 qubits en parallèle.

- D’ici fin 2025, IBM prévoit d’installer trois puces Kookaburra sur le System Two, créant ainsi une seule machine de 4 158 qubits.

- IBM utilise des coupleurs de puce à puce à courte portée et des liaisons cryogéniques pour connecter les puces en un seul tissu de calcul.

- L’entreprise qualifie cette approche de supercalcul quantique centré sur le quantique, tissant des QPU avec des CPU et des GPU dans un tissu de calcul unifié.

- Qiskit Runtime et le circuit knitting permettent aux développeurs d’exécuter de grandes charges de travail quantiques sur plusieurs puces avec une atténuation d’erreur intégrée.

- Le système de plus de 4 000 qubits fonctionnera dans le régime NISQ en 2025, s’appuyant sur l’atténuation d’erreur plutôt que sur une correction complète des erreurs quantiques.

- Les experts estiment que casser RSA-2048 nécessiterait environ 4 000 qubits logiques corrigés d’erreurs, soit probablement des millions de qubits physiques.

- Les concurrents incluent Google, qui vise l’informatique quantique tolérante aux pannes d’ici 2029, IonQ qui poursuit les qubits algorithmiques, Quantinuum qui se concentre sur la haute fidélité et la tolérance aux pannes, et D-Wave qui propose un système d’optimisation quantique de plus de 5 000 qubits.

IBM est à l’aube d’une percée en informatique quantique : un « superordinateur quantique » de plus de 4 000 qubits d’ici 2025. Le plan ambitieux du géant technologique – qui s’inscrit dans une stratégie quantique plus large – promet de révolutionner l’informatique en s’attaquant à des problèmes que les superordinateurs les plus rapides d’aujourd’hui ne peuvent pas résoudre. Dans ce rapport, nous allons détailler le parcours quantique d’IBM, la conception de son système de plus de 4 000 qubits, les avis d’experts (et le battage médiatique), la comparaison avec des rivaux comme Google et IonQ, et ce que pourrait signifier une machine de 4 000 qubits pour le monde.

Contexte : la quête d’IBM en informatique quantique

IBM a été un pionnier de l’informatique quantique, menant la charge tant dans le développement matériel que logiciel. Dès 2020, IBM a présenté une feuille de route quantique et a atteint chaque étape depuis. Ils ont démontré le processeur Eagle de 127 qubits en 2021 – une puce si complexe que ses circuits « ne peuvent pas être simulés exactement de manière fiable sur un ordinateur classique » [1]. En 2022, IBM a présenté la puce Osprey de 433 qubits, une avancée majeure par rapport à Eagle en nombre de qubits [2]. Plus récemment, fin 2023, IBM a atteint le cap des 1 121 qubits avec son processeur Condor – le premier processeur quantique à franchir la barre du millier de qubits [3]. Chacune de ces avancées a posé des bases cruciales pour passer à des milliers de qubits.

Mais la stratégie d’IBM ne consiste pas seulement à ajouter plus de qubits. L’entreprise met en avant une approche full-stack : un matériel quantique robuste, un logiciel quantique intelligent, et un large écosystème d’utilisateurs et de partenaires [4], [5]. En 2016, IBM a mis le premier ordinateur quantique sur le cloud à disposition du public, et aujourd’hui, plus de 200 organisations et 450 000 utilisateurs sont connectés aux services quantiques d’IBM via le cloud [6]. Le cadre logiciel d’IBM (Qiskit) et l’environnement Qiskit Runtime permettent aux développeurs d’exécuter efficacement des programmes quantiques, avec des outils intégrés pour atténuer les erreurs et orchestrer des charges de travail hybrides quantique-classique [7], [8]. Cette intégration étroite du matériel et du logiciel – ainsi qu’un réseau de collaborateurs académiques et industriels – est au cœur de l’objectif plus large d’IBM : apporter l’informatique quantique utile au monde, et pas seulement des démonstrations en laboratoire.IBM aime appeler cette vision « supercalculateur centré sur le quantique ». L’idée est d’entrelacer à terme les processeurs quantiques (QPU) avec les CPU et GPU classiques dans une structure informatique homogène [9]. Tout comme les supercalculateurs récents combinent CPU et accélérateurs IA pour gérer les charges de travail d’IA, IBM imagine les supercalculateurs du futur combinant moteurs quantiques et classiques pour s’attaquer à des problèmes qu’aucun ne pourrait résoudre seul [10]. Selon les mots du Dr Jay Gambetta, vice-président quantique d’IBM, « Désormais, IBM inaugure l’ère du supercalculateur centré sur le quantique, où les ressources quantiques – les QPU – seront tissées avec les CPU et GPU dans une structure de calcul », visant à résoudre « les problèmes les plus difficiles » en science et dans l’industrie [11]. C’est une vision audacieuse qui va au-delà de la simple création d’un ordinateur plus rapide ; il s’agit de changer la nature même de l’informatique.

Concevoir un superordinateur quantique de plus de 4 000 qubits

Comment construit-on un ordinateur quantique avec plus de 4 000 qubits ? La réponse d’IBM : la modularité. Au lieu d’une seule puce géante, IBM connecte plusieurs puces quantiques plus petites dans un même système – un peu comme relier des nœuds dans un superordinateur. La prochaine plateforme de la société, appelée IBM Quantum System Two, est spécialement conçue pour cela. Lancé en 2023, System Two est le premier système informatique quantique modulaire d’IBM, doté d’un réfrigérateur cryogénique de pointe et d’électroniques de contrôle capables de prendre en charge plusieurs processeurs quantiques simultanément [12], [13]. C’est la « maison » physique qui accueillera la future flotte de puces connectées d’IBM, toutes refroidies à proximité du zéro absolu. En combinant les puces, IBM peut augmenter rapidement le nombre de qubits sans avoir à fabriquer des puces uniques d’une taille impossible – une approche cruciale pour passer de centaines à des milliers de qubits.

Figure : La vision d’IBM pour un superordinateur quantique est de relier plusieurs puces quantiques dans un même système. En 2025, IBM prévoit d’introduire « Kookaburra », un processeur de 1 386 qubits doté de liens de communication quantique ; trois puces Kookaburra peuvent être connectées en un système unique de 4 158 qubits [14]. Cette architecture modulaire permet à IBM de passer à des milliers de qubits en mettant en réseau de plus petits processeurs plutôt qu’en s’appuyant sur une seule puce massive.

Le cœur du plan d’IBM pour atteindre 4 000 qubits réside dans sa prochaine famille de processeurs aux noms de code aviaires. En 2024, IBM devrait lancer « Flamingo », une puce de 462 qubits conçue pour tester la communication quantique entre puces [15]. IBM prévoit de démontrer la conception de Flamingo en reliant trois processeurs Flamingo en un seul système de 1 386 qubits – montrant essentiellement que plusieurs puces peuvent fonctionner ensemble comme si elles n’en formaient qu’une seule [16]. Ensuite vient la grande étape : en 2025, IBM dévoilera « Kookaburra », un processeur de 1 386 qubits conçu pour l’extension modulaire [17]. Grâce à des liens de communication intégrés, trois puces Kookaburra peuvent s’interconnecter pour former une seule machine avec 4 158 qubits [18]. Selon IBM, ce sera le premier superordinateur centré sur le quantique, franchissant le cap des 4 000 qubits.

À quoi ressemble donc cette architecture ? Essentiellement, IBM utilise des coupleurs à courte portée entre puces et des liaisons cryogéniques pour relier des qubits sur différentes puces [19]. Imaginez chaque puce comme une « tuile » de qubits ; les coupleurs permettent aux tuiles adjacentes de partager l’information quantique, et des câbles micro-ondes spéciaux peuvent connecter des puces un peu plus éloignées [20]. Le défi consiste à faire en sorte que les qubits sur des puces séparées se comportent presque comme s’ils étaient sur la même puce – ce qui n’est pas simple, car les états quantiques sont fragiles. IBM a développé une nouvelle technologie de coupleur pour maintenir la cohérence des qubits intriqués entre les puces [21]. System Two fournit l’environnement ultra-froid et sans vibrations ainsi qu’une configuration de câblage flexible pour accueillir ces réseaux multi-puces [22]. L’ensemble est orchestré par une couche de contrôle « intelligente » (logiciel et calcul classique) qui dirige les opérations quantiques à travers les différentes puces, les faisant fonctionner de concert [23].

Le calendrier d’IBM prévoit que le système de plus de 4 000 qubits soit opérationnel d’ici 2025 [24]. En fait, les premiers éléments sont déjà en place. Fin 2023, lors du Sommet IBM Quantum, IBM a mis en service le premier Quantum System Two, faisant fonctionner en parallèle trois petits processeurs “Heron” de 133 qubits [25]. Cela a servi de prototype : Heron est une puce à relativement faible nombre de qubits mais avec des taux d’erreur nettement améliorés, et IBM a utilisé System Two pour montrer qu’il est possible de faire fonctionner plusieurs processeurs ensemble comme un seul système [26]. Au cours de l’année ou des deux années à venir, IBM va faire évoluer ce système – en remplaçant les puces par des modèles plus grands (comme Flamingo puis Kookaburra) et en en reliant davantage. L’objectif est qu’à la fin de 2025, IBM Quantum System Two héberge trois puces Kookaburra et donc plus de 4 000 qubits connectés dans une seule machine [27]. En regardant plus loin, IBM envisage même de relier plusieurs System Two : par exemple, connecter trois de ces systèmes pourrait donner un cluster de plus de 16 000 qubits à l’avenir [28]. En d’autres termes, 4 000 qubits n’est pas une finalité – c’est une étape vers des machines quantiques encore plus grandes construites en mettant en réseau des modules, un peu comme les superordinateurs classiques qui s’étendent avec plusieurs nœuds.

La vision d’IBM : perspectives des leaders du quantique

L’équipe quantique d’IBM est, à juste titre, enthousiaste – et optimiste – quant à ce que signifie ce bond à 4 000 qubits. Le Directeur de la Recherche d’IBM, Dr. Darío Gil, a souvent évoqué l’avènement d’une nouvelle ère de l’informatique quantique pratique. « La mise en œuvre de notre vision nous a donné une visibilité claire sur l’avenir du quantique et sur ce qu’il faudra pour nous amener à l’ère de l’informatique quantique pratique », a déclaré Gil, alors qu’IBM élargissait sa feuille de route [29]. Avec l’objectif de plus de 4 000 qubits en ligne de mire, il a présenté cela comme l’avènement « d’une ère de superordinateurs centrés sur le quantique qui ouvriront de vastes et puissants espaces de calcul » pour les développeurs, partenaires et clients [30]. En d’autres termes, IBM considère cela comme l’aube d’ordinateurs quantiques qui ne sont plus de simples expériences de laboratoire, mais des outils puissants pour des applications concrètes.

Jay Gambetta, IBM Fellow et vice-président du Quantique, a qualifié 2023 de point d’inflexion majeur – le moment où le concept de superordinateur centré sur le quantique est devenu réalité sous forme de prototype [31]. Selon Gambetta, il ne suffit pas d’avoir plus de qubits ; « le supercalcul quantique centré sur le quantique nécessitera plus que simplement beaucoup de qubits », a-t-il expliqué – il faut aussi une plus grande profondeur de circuit et une intégration étroite avec les systèmes classiques [32]. Cela reflète l’accent mis par IBM sur la qualité des qubits et la fusion transparente de l’informatique quantique et classique. « Notre mission est d’apporter l’informatique quantique utile au monde, » a déclaré Gambetta. « Nous allons continuer à offrir la meilleure solution quantique complète de l’industrie — et c’est à l’industrie de mettre ces systèmes à profit » [33]. Le message : IBM fournira le matériel et les logiciels, et ils s’attendent à ce que les entreprises et les chercheurs commencent à en faire un usage concret et impactant.

Lors du Quantum Summit 2023, l’équipe d’IBM a adopté un ton optimiste quant à la maturité de la technologie. « Nous sommes fermement entrés dans l’ère où les ordinateurs quantiques sont utilisés comme un outil pour explorer de nouveaux horizons scientifiques », a déclaré le Dr Darío Gil, notant que les machines quantiques ne sont plus de simples curiosités [34]. Il a souligné les progrès d’IBM dans la mise à l’échelle de ces systèmes grâce à une conception modulaire et a promis de « continuer à améliorer la qualité d’une pile technologique quantique à l’échelle utilitaire – et la mettre entre les mains de nos utilisateurs et partenaires qui repousseront les limites de problèmes plus complexes » [35]. En somme, à mesure qu’IBM augmente le nombre de qubits, ils travaillent aussi à améliorer la fidélité des qubits et l’“intelligence” logicielle, afin que ces milliers de qubits puissent réellement accomplir un travail utile sur des problèmes complexes.

IBM utilise même une métaphore saisissante pour illustrer le changement à venir. L’entreprise compare le passage des ordinateurs quantiques naissants d’aujourd’hui au superordinateur quantique de 2025 à « remplacer les cartes papier par des satellites GPS » pour la navigation [36]. C’est une image évocatrice : les superordinateurs quantiques pourraient nous guider à travers des problèmes de calcul d’une manière fondamentalement nouvelle, tout comme le GPS a révolutionné notre façon de nous orienter. Reste à voir si la réalité sera à la hauteur de l’optimisme d’IBM, mais il ne fait aucun doute que les meilleurs esprits d’IBM pensent être à l’aube de quelque chose de grand.

Ce que disent les experts : entre engouement et réalité

L’annonce d’IBM concernant les 4 000 qubits a suscité beaucoup d’enthousiasme, mais des experts extérieurs rappellent souvent qu’il faut garder des attentes réalistes. Un point clé qu’ils soulignent : plus de qubits ne garantit pas à lui seul des résultats utiles. Les bits quantiques actuels sont « bruyants » – ils sont sujets aux erreurs – donc connecter simplement des milliers de qubits imparfaits ne résout pas magiquement les problèmes si ces qubits ne peuvent pas maintenir leur cohérence. IEEE Spectrum a noté que le plan d’IBM devra être accompagné d’une « couche logicielle intelligente » pour gérer les erreurs et orchestrer la charge de travail hybride quantique-classique [37]. En fait, une nouvelle pile logicielle puissante pourrait être « la clé pour faire quelque chose d’utile » avec un processeur de 4 000 qubits, en gérant l’atténuation des erreurs et en répartissant les tâches entre le matériel quantique et les coprocesseurs classiques [38]. En résumé, le nombre brut de qubits n’est pas tout – la façon dont vous utilisez et contrôlez ces qubits est tout aussi cruciale.

Certains observateurs de l’industrie soulignent également l’écart entre les qubits physiques et les qubits logiques. Un qubit logique est un qubit corrigé des erreurs, en pratique un ensemble de nombreux qubits physiques travaillant ensemble pour agir comme un seul qubit très fiable. Les experts estiment que casser le chiffrement moderne (comme les clés RSA 2048 bits protégeant la sécurité en ligne) nécessiterait environ 4 000 qubits logiques corrigés des erreurs – ce qui, en pratique, pourrait signifier des millions de qubits physiques compte tenu des frais généraux actuels de correction d’erreurs [39]. Comme l’a dit un analyste en sécurité, « 4 000 qubits logiques, ce n’est pas la même chose que 4 000 qubits réels » – un ordinateur quantique entièrement corrigé des erreurs avec des milliers de qubits logiques reste un rêve lointain [40]. La machine d’IBM à plus de 4 000 qubits sera loin de cet idéal tolérant aux fautes ; elle sera composée de qubits physiques nécessitant des techniques astucieuses d’atténuation des erreurs pour être utile. Les chercheurs tiennent à préciser qu’il ne faut pas s’attendre à ce que cette machine, par exemple, casse le chiffrement d’internet ou résolve tous les problèmes insolubles du jour au lendemain.

Cela dit, la feuille de route ambitieuse d’IBM la place devant de nombreux concurrents dans la course au nombre brut de qubits, et certains experts saluent l’approche modulaire comme une manière pragmatique de passer à l’échelle. « Nous pensons que les ressources classiques peuvent vraiment améliorer ce que vous pouvez faire avec le quantique et tirer le meilleur parti de cette ressource quantique », a noté Blake Johnson, responsable de la plateforme quantique d’IBM, soulignant la nécessité d’une orchestration entre l’informatique quantique et classique pour exploiter ces grands systèmes [41]. Ce sentiment est largement partagé : l’avenir est « quantique-plus-classique » travaillant main dans la main.

Visions concurrentes : IBM vs. Google, IonQ et autres

IBM n’est pas seul dans la course quantique, mais sa stratégie contraste avec celle d’autres grands acteurs. Google, par exemple, s’est moins concentré sur le nombre de qubits à court terme et davantage sur la réalisation d’un ordinateur quantique entièrement corrigé des erreurs. La feuille de route de Google vise à réaliser une machine quantique utile et corrigée des erreurs d’ici 2029, et l’entreprise travaille régulièrement à la démonstration de qubits logiques et à la réduction des erreurs plutôt qu’à battre des records de nombre de qubits [42]. (Les appareils actuels de Google, comme le Bristlecone à 72 qubits ou les itérations plus récentes de son Sycamore à 53 qubits, ont bien moins de qubits que ceux d’IBM, mais Google a récemment montré qu’augmenter le nombre de qubits physiques dans un qubit logique peut réduire le taux d’erreur, une étape prometteuse vers l’évolutivité [43].) Dans ses déclarations publiques, la direction de Google prévoit un horizon de 5 à 10 ans pour que l’informatique quantique commence à avoir un réel impact [44]. Ainsi, tandis qu’IBM fonce vers un prototype à 4 000 qubits, Google joue sur le long terme pour atteindre un ordinateur quantique entièrement tolérant aux pannes, même s’il ne dispose que de quelques dizaines de qubits à court terme.

Quantinuum (l’entreprise issue de la fusion de Honeywell et Cambridge Quantum) est un autre poids lourd, mais elle suit une voie technologique différente : les qubits à ions piégés. Quantinuum ne cherche pas à atteindre immédiatement des milliers de qubits physiques – leur dernier système à piège à ions compte de l’ordre de 50 à 100 qubits de haute fidélité – mais ils ont démontré un volume quantique record (une mesure de la capacité globale) et ont même créé 12 qubits « logiques » via la correction d’erreurs en 2024 [45]. La feuille de route de Quantinuum vise l’informatique quantique entièrement tolérante aux pannes d’ici 2030, et l’entreprise met l’accent sur l’atteinte d’une fidélité « trois 9 » (99,9 % de fiabilité) et sur les avancées en matière de qubits logiques comme étapes clés [46]. Leur PDG, Rajeeb Hazra, affirme que la qualité et les progrès en correction d’erreurs ouvriront un « marché du billion de dollars » pour le quantique, et prétend que Quantinuum dispose de « la feuille de route la plus crédible de l’industrie vers… l’informatique quantique tolérante aux pannes » [47]. En résumé, l’objectif de Quantinuum est de perfectionner les qubits et la correction d’erreurs, même si cela signifie moins de qubits pour l’instant – un contraste avec le pari d’IBM sur la montée en échelle et la gestion du bruit par la mitigation.

Un autre concurrent clé, IonQ, utilise également la technologie des ions piégés et met lui aussi l’accent sur la qualité des qubits. La direction d’IonQ met souvent en avant les « qubits algorithmiques » – une mesure interne qui prend en compte les taux d’erreur et la connectivité – plutôt que le simple nombre de qubits physiques [48]. La feuille de route d’IonQ vise une « large supériorité quantique d’ici 2025 », mais en améliorant progressivement la performance de ses qubits et en construisant des systèmes modulaires à pièges à ions montés en rack, et non en atteignant un nombre élevé de qubits précis [49]. En fait, IonQ prévoit qu’il ne faudra qu’une poignée de qubits de haute qualité pour surpasser des ordinateurs quantiques beaucoup plus grands mais bruyants sur certaines tâches. L’ancien PDG Peter Chapman a prédit que la technologie d’IonQ « sera déterminante pour l’avantage quantique commercial », en mettant spécifiquement l’accent sur les qubits algorithmiques plutôt que sur le nombre physique comme clé pour des applications utiles [50]. Cette philosophie met en lumière un débat dans le domaine : l’informatique quantique est-elle un « jeu de chiffres » (plus de qubits plus vite) ou un « jeu de qualité » (de meilleurs qubits même si la montée en échelle est plus lente) ? IBM mise sur les chiffres (tout en gardant un œil sur la qualité), tandis qu’IonQ est résolument dans le camp de la qualité d’abord.

Il y a aussi Rigetti Computing, un acteur plus petit utilisant des qubits supraconducteurs. La feuille de route de Rigetti a connu des retards – ils espéraient atteindre 1 000 qubits grâce à des modules multi-puces d’ici 2024, mais en pratique, leurs systèmes sont encore à quelques dizaines de qubits. À la mi-2025, Rigetti vise un système plus modeste de plus de 100 qubits d’ici la fin 2025 [51], en se concentrant sur l’amélioration de la fidélité et des performances des portes à deux qubits en cours de route. L’entreprise a eu du mal à suivre le rythme de la montée en puissance rapide d’IBM, illustrant la difficulté pour les nouveaux venus d’égaler les ressources et l’expertise d’IBM dans ce domaine. Néanmoins, Rigetti et d’autres contribuent à l’innovation (par exemple, Rigetti a été pionnier dans certaines techniques d’intégration multi-puces), et ils soulignent que l’avance d’IBM n’est pas inattaquable si des percées fondamentales (comme de meilleurs designs de qubits ou de nouveaux matériaux) émergent.

Il convient également de mentionner D-Wave Systems dans ce contexte. D-Wave, une entreprise canadienne, possède aujourd’hui des machines d’recuit quantique (un modèle différent d’informatique quantique) avec plus de 5 000 qubits [52]. Cependant, les qubits de D-Wave sont conçus pour résoudre des problèmes d’optimisation via le recuit, et non pour des algorithmes quantiques généraux. Ils atteignent un nombre élevé de qubits grâce à une architecture spécialisée, mais ces qubits ne peuvent pas exécuter des circuits quantiques arbitraires comme les appareils d’IBM ou de Google. Le PDG de D-Wave, Alan Baratz, a noté que leur technologie apporte déjà de la valeur dans certaines applications (comme l’optimisation des plannings de vente au détail ou du routage des télécommunications) [53]. L’existence d’un système D-Wave à 5 000 qubits rappelle que tous les qubits ne se valent pas – les qubits de D-Wave sont utiles pour des tâches spécifiques mais ne sont pas directement comparables aux qubits des ordinateurs quantiques à portes logiques. L’objectif d’IBM de dépasser les 4 000 qubits fait référence à des qubits universels à portes logiques, ce qui est bien plus complexe et ambitieux.En résumé, IBM se distingue par une montée en puissance agressive du matériel à qubits supraconducteurs et vise à l’intégrer à l’informatique classique dans un délai court. Google se concentre sur les étapes de correction d’erreurs, Quantinuum et IonQ privilégient la fidélité des qubits (avec moins de qubits à court terme), et des entreprises comme Rigetti sont à la traîne avec des dispositifs plus petits. Chaque approche a ses mérites. Si IBM réussit, cela fixera un niveau élevé en nombre de qubits et pourrait permettre d’atteindre plus tôt un avantage quantique sur des tâches utiles. Mais si les qubits sont trop bruyants, ces 4 000 qubits pourraient ne pas surpasser les 100 excellents qubits d’un concurrent. Les prochaines années seront une course fascinante entre différentes philosophies de l’informatique quantique – et il n’est pas acquis que le plus grand nombre de qubits l’emporte toujours, sauf s’il est associé à la qualité et à des logiciels ingénieux.

Pourquoi 4 000 qubits ? Applications potentielles et défis

Que pourrait réellement faire un ordinateur quantique à 4 000 qubits, s’il fonctionne comme prévu ? Pour situer, les ordinateurs quantiques actuels (avec quelques dizaines ou centaines de qubits) n’ont pas encore clairement surpassé les ordinateurs classiques sur un problème pratique. IBM et d’autres pensent qu’en atteignant les milliers de qubits, nous entrerons dans la zone où un avantage quantique utile devient possible pour certaines classes de problèmes [54]. Voici quelques applications et impacts qu’un système à 4 000 qubits pourrait permettre :

- Chimie et science des matériaux : Les ordinateurs quantiques sont particulièrement adaptés à la simulation de systèmes moléculaires et atomiques. Même les plus grands superordinateurs classiques peinent à modéliser avec précision le comportement de molécules complexes et de réactions chimiques. Les chercheurs d’IBM soulignent que « peu de domaines tireront profit de l’informatique quantique aussi rapidement que la chimie », car les machines quantiques peuvent gérer de manière native la nature quantique des interactions chimiques [55]. Un système de 4 000 qubits pourrait potentiellement simuler des molécules de taille moyenne ou des matériaux nouveaux avec une grande précision – facilitant la découverte de médicaments, le développement de nouveaux matériaux (pour les batteries, engrais, supraconducteurs, etc.), et la compréhension de processus chimiques complexes. Ce sont des problèmes où les méthodes classiques atteignent leurs limites en raison de la complexité exponentielle. D’ici 2025, IBM prévoit que les ordinateurs quantiques commenceront à explorer des applications utiles dans les sciences naturelles comme la chimie [56].

- Optimisation et finance : De nombreux problèmes du monde réel – de la logistique de la chaîne d’approvisionnement à l’optimisation de portefeuille – consistent à trouver la meilleure solution parmi un nombre astronomique de possibilités. Les ordinateurs quantiques, avec des algorithmes comme QAOA ou des techniques de recuit quantique, offrent de nouvelles façons d’aborder certains problèmes d’optimisation. Une machine dotée de milliers de qubits pourrait traiter des instances de problèmes plus vastes ou fournir des solutions plus précises que les dispositifs actuels. Le PDG d’IBM, Arvind Krishna, a suggéré que l’informatique quantique permettra de nouveaux algorithmes pour l’optimisation dont les entreprises pourront tirer parti, devenant potentiellement un facteur clé de différenciation pour des secteurs comme la finance, l’énergie et l’industrie [57]. Un système de 4 000 qubits pourrait, par exemple, s’attaquer à des analyses de risque complexes ou à des problèmes d’optimisation de trajets que les algorithmes classiques ne peuvent résoudre dans un délai raisonnable.

- Apprentissage automatique et IA : Les recherches se multiplient sur le quantum machine learning, où les ordinateurs quantiques pourraient accélérer certains types de tâches d’apprentissage automatique ou offrir de nouvelles capacités de modélisation. Avec des milliers de qubits, les ordinateurs quantiques pourraient commencer à mettre en œuvre des modèles de réseaux neuronaux quantiques ou effectuer plus rapidement des sous-programmes d’algèbre linéaire qui sous-tendent les algorithmes de ML. IBM considère spécifiquement l’apprentissage automatique comme un cas test pour les applications quantiques – s’attendant à ce que d’ici 2025, les ordinateurs quantiques soient utilisés pour explorer des cas d’usage en apprentissage automatique aux côtés du ML classique, améliorant possiblement la façon dont nous reconnaissons les motifs dans les données ou optimisons les modèles de ML [58]. Un exemple concret pourrait être la sélection de caractéristiques ou le clustering améliorés par le quantique sur des ensembles de données complexes, qui pourraient être accélérés par des sous-programmes quantiques.

- Recherche scientifique et « Grands Défis » : Au-delà des industries ciblées, un superordinateur quantique de 4 000 qubits serait une aubaine pour la science fondamentale. Il pourrait être utilisé pour simuler des scénarios de physique des hautes énergies, optimiser la conception de matériaux quantiques, ou même explorer des questions en cryptographie et en mathématiques. IBM a mentionné les sciences naturelles de manière générale – par exemple, des problèmes en physique ou biologie qui sont actuellement insolubles pourraient céder à une approche quantique hybride [59]. Pensez à la conception de catalyseurs pour la capture du carbone, ou à l’analyse de systèmes quantiques en physique nucléaire – ce sont des calculs extrêmement complexes où un ordinateur quantique pourrait apporter de nouvelles perspectives. Les propres chercheurs d’IBM ont évoqué des applications en chimie, optimisation et apprentissage automatique comme premières cibles pour l’avantage quantique [60].

C’est la promesse brillante – mais qu’en est-il des défis ? Un ordinateur quantique de 4 000 qubits devra relever de sérieux obstacles :

- Bruit et taux d’erreur : Les qubits actuels sont sujets aux erreurs ; ils se décohérent (perdent leur état quantique) en quelques microsecondes et les opérations (« portes ») entre qubits sont imparfaites. Avec seulement 50 à 100 qubits, les algorithmes quantiques ne peuvent exécuter qu’une très courte séquence d’opérations avant que les erreurs ne submergent le résultat. Si vous avez des milliers de qubits, le défi du bruit se multiplie. En fait, connecter trois puces (comme le prévoit IBM) pourrait introduire encore plus d’erreurs en raison d’opérations légèrement plus lentes et de moindre fidélité entre les puces [61]. IBM en est conscient et conçoit le logiciel du System Two pour qu’il soit « conscient » de l’architecture – par exemple, pour planifier les opérations critiques sur la même puce et gérer soigneusement les opérations inter-puces plus lentes [62]. Sans correction d’erreur (qui ne sera pas pleinement en place d’ici 2025), IBM s’appuiera sur l’atténuation des erreurs : des astuces ingénieuses pour réduire l’impact des erreurs. Cela inclut des techniques comme l’annulation probabiliste des erreurs, où l’on introduit intentionnellement du bruit supplémentaire pour en apprendre davantage sur le bruit, puis on post-traite classiquement les résultats pour annuler les erreurs [63]. Ces méthodes sont coûteuses en calcul et imparfaites, mais les recherches d’IBM suggèrent que certaines peuvent passer à l’échelle pour des dispositifs de cette taille [64]. Pourtant, la gestion du bruit reste le problème central – c’est la raison pour laquelle les ordinateurs quantiques n’ont pas encore résolu de problèmes concrets, et une machine de 4 000 qubits ne réussira que si IBM parvient à maîtriser suffisamment les erreurs pour effectuer des calculs profonds.

- Correction d’erreurs et Qubits logiques : La solution à long terme au bruit est la correction d’erreurs quantiques (QEC), qui regroupera de nombreux qubits physiques en un seul qubit logique capable de survivre aux erreurs. Le système IBM à 4 000 qubits fonctionnera probablement encore dans le régime « NISQ » (Noisy Intermediate-Scale Quantum), ce qui signifie qu’il n’y aura pas encore de correction d’erreurs à grande échelle – il n’y aura tout simplement pas assez de qubits pour corriger complètement les erreurs sur les 4 000. (Pour donner une idée, transformer même quelques milliers de qubits physiques en une poignée de qubits logiques pourrait consommer toute la machine.) Cependant, IBM prépare le terrain pour la correction d’erreurs. L’entreprise mène activement des recherches sur de nouveaux codes QEC (par exemple, un code LDPC quantique plus efficace en qubits que les codes de surface traditionnels) et des décodeurs d’erreurs rapides [65]. En fait, IBM a récemment étendu sa feuille de route jusqu’en 2033, en donnant explicitement la priorité à l’amélioration de la qualité des portes et au développement de modules corrigés d’erreurs après 2025 [66]. Le superordinateur à 4 000 qubits peut être vu comme un pont : il est censé être suffisamment grand pour réaliser certaines tâches utiles avec atténuation des erreurs, tout en apprenant à IBM comment mettre en œuvre une correction partielle des erreurs à grande échelle. IBM a même annoncé un plan pour un prototype d’ordinateur quantique tolérant aux pannes d’ici 2029 [67], indiquant que la correction d’erreurs est bel et bien à l’ordre du jour une fois l’étape des 4 000 qubits atteinte. Cependant, obtenir des qubits (logiques) entièrement corrigés d’erreurs nécessitera des ordres de grandeur supplémentaires en nombre de qubits ou une bien meilleure fidélité des qubits – probablement une combinaison des deux.

- Logiciels et outils pour développeurs : Même si vous disposez d’une machine quantique à 4 000 qubits, il vous faut un logiciel capable de l’exploiter efficacement. Les algorithmes quantiques doivent être adaptés à ce matériel complexe composé de plusieurs puces. IBM répond à ce besoin avec des outils comme Qiskit Runtime et l’architecture Quantum Serverless. Ceux-ci permettent à un utilisateur de diviser un problème en circuits quantiques plus petits, de les exécuter en parallèle sur différentes puces quantiques, puis de rassembler les résultats grâce à un traitement classique [68]. Par exemple, le “circuit knitting” est une technique mise en avant par IBM – il s’agit de découper un grand circuit en morceaux adaptés à de plus petits processeurs, puis de recombiner les résultats de façon classique [69]. D’ici 2025, IBM prévoit d’intégrer des fonctionnalités comme les circuits dynamiques (où les résultats de mesure peuvent influencer les opérations futures en temps réel) et la suppression d’erreurs intégrée sur leur plateforme cloud [70]. Le défi sera de rendre tout cela convivial pour les développeurs. IBM souhaite que l’informatique quantique soit accessible afin que les data scientists et les experts métier (et pas seulement les docteurs en physique quantique) puissent exploiter ces 4 000 qubits [71]. Obtenir une bonne abstraction – où un utilisateur peut, par exemple, appeler une fonction de haut niveau pour simuler une molécule et laisser le système déterminer comment utiliser les 4 000 qubits – sera crucial pour l’utilité pratique. L’approche d’IBM ici repose sur le concept de middleware quantique et d’une “app store” de primitives quantiques : des fonctions préconstruites pour des tâches courantes comme l’échantillonnage de distributions de probabilités ou l’estimation de propriétés de systèmes [72]. Si cela fonctionne, un chimiste en 2025 n’aura peut-être pas besoin de connaître les détails du matériel ; il pourra simplement utiliser le logiciel d’IBM pour exploiter la puissance des 4 000 qubits pour sa simulation.

- Infrastructure physique : Passer à des milliers de qubits n’est pas seulement un défi computationnel, mais un marathon d’ingénierie. Les processeurs quantiques doivent être refroidis à des températures de l’ordre du millikelvin – plus froides que l’espace. IBM a dû concevoir un nouveau réfrigérateur à dilution (IBM Quantum System Two) plus grand et plus modulaire que les précédents pour accueillir plusieurs puces et tout leur câblage de contrôle [73]. Le réfrigérateur, l’électronique et le câblage deviennent de plus en plus complexes à mesure que l’on ajoute des qubits. Des milliers de qubits signifient des milliers de lignes de contrôle micro-ondes, un filtrage sophistiqué pour empêcher la chaleur et le bruit d’atteindre les qubits, et d’énormes flux de données issus des lectures de qubits. Les ingénieurs d’IBM ont comparé la complexité de la montée en échelle des systèmes quantiques à celle des premiers superordinateurs ou des missions spatiales. D’ici 2025, IBM prévoit d’avoir « supprimé les principaux obstacles à la montée en échelle » grâce à du matériel modulaire et à l’électronique de contrôle associée [74] – mais il convient de noter qu’IBM ne fait qu’atteindre ces limites aujourd’hui. Le System Two à New York est essentiellement un prototype pour gérer une telle complexité [75]. IBM installe également un System Two en Europe (en partenariat avec le gouvernement basque en Espagne) d’ici 2025 [76], ce qui permettra de tester comment cette infrastructure de pointe peut être reproduite en dehors du propre laboratoire d’IBM. Le succès de ces déploiements sera une preuve importante que la plomberie et le câblage d’un superordinateur quantique peuvent être rendus fiables et maintenables.

Compte tenu de ces défis, les experts tempèrent l’engouement en notant qu’une machine IBM de 4 000 qubits sera probablement un outil hautement spécialisé. Elle pourrait surpasser les superordinateurs classiques sur des problèmes spécifiques (simulations de chimie quantique, certaines optimisations ou tâches d’apprentissage automatique comme mentionné), atteignant l’avantage quantique ou même des aperçus de suprématie quantique dans des contextes utiles. Cependant, cela ne rendra pas instantanément les ordinateurs classiques obsolètes. En fait, pour de nombreuses tâches, les superordinateurs classiques et les GPU resteront plus rapides ou plus pratiques. La feuille de route d’IBM elle-même reconnaît cette synergie : le superordinateur quantique est conçu pour fonctionner avec le calcul haute performance classique, chacun faisant ce qu’il fait de mieux [77]. Nous devrions donc considérer le système à 4 000 qubits comme l’un des premiers véritables « accélérateurs quantiques » – un outil à utiliser aux côtés du calcul classique pour s’attaquer à ces problèmes vraiment difficiles que les machines classiques seules ne peuvent pas résoudre. C’est une étape significative vers le rêve ultime de l’informatique quantique tolérante aux pannes, mais ce n’est pas la destination finale.

La suite : la feuille de route quantique d’IBM au-delà de 2025

Le superordinateur de plus de 4 000 qubits d’IBM représente une étape majeure, mais il fait partie d’une feuille de route plus longue qui s’étend jusque dans les années 2030. IBM a déclaré publiquement qu’en 2025, avec ce superordinateur centré sur le quantique en place, ils auront « éliminé certains des plus grands obstacles à la montée en échelle du matériel quantique » [78]. Mais le développement ne s’arrêtera pas là. En 2025 et au-delà, l’accent d’IBM se portera de plus en plus sur l’augmentation de l’échelle avec qualité – améliorer la fidélité des qubits, la correction d’erreurs et la complexité des circuits pouvant être exécutés.

En fait, fin 2023, IBM a mis à jour sa feuille de route de développement quantique jusqu’en 2033. Un objectif clé : vers 2026–2027, introduire des opérations quantiques corrigées des erreurs sur leurs systèmes, en avançant vers « des systèmes avancés corrigés des erreurs » plus tard dans la décennie [79]. IBM donne la priorité aux améliorations de la fidélité des portes logiques (réduction des taux d’erreur) afin que des circuits quantiques plus grands (avec des milliers d’opérations) deviennent réalisables [80]. Cela suggère qu’après avoir atteint le seuil du nombre de qubits, IBM va redoubler d’efforts pour améliorer chaque qubit et intégrer progressivement la correction d’erreurs. Un exemple concret est le travail d’IBM sur de nouveaux codes correcteurs d’erreurs comme les codes LDPC quantiques et des algorithmes de décodage plus rapides, qui visent à gérer les erreurs plus efficacement que les codes de surface actuels [81]. On parle aussi d’un processeur IBM nommé « Loon » autour de 2025, destiné à tester des composants d’une architecture corrigée des erreurs (comme des modules pour connecter des qubits pour un code QEC spécifique) [82]. D’ici 2029, IBM aspire à construire un prototype quantique tolérant aux pannes démontrable, s’alignant ainsi sur des concurrents comme Google pour cet objectif ultime [83].

Sur le plan matériel, IBM continuera probablement sa gamme de processeurs à thème d’oiseaux au-delà de Kookaburra. La feuille de route au-delà de 2025 n’est pas entièrement publique, mais IBM a laissé entendre qu’il explorait des systèmes multi-puces encore plus grands et peut-être des technologies hybrides. Par exemple, la vision d’IBM d’un superordinateur centré sur le quantique implique finalement des liens de communication quantique capables de connecter des grappes de puces à distance, et pas seulement dans le même réfrigérateur [84]. Nous pourrions voir IBM intégrer des interconnexions par fibre optique ou d’autres méthodes pour relier des processeurs quantiques dans différents cryostats – à l’image d’un réseau local quantique. Cela permettrait d’atteindre des dizaines de milliers, voire des millions de qubits à long terme, ce qu’IBM reconnaît comme nécessaire pour résoudre les problèmes les plus complexes (et effectuer une correction complète des erreurs) [85], [86]. Selon IBM, leur approche modulaire et en réseau devrait permettre de passer à « des centaines de milliers de qubits » au fil du temps [87]. Le système à 4 000 qubits est essentiellement la première incarnation d’une architecture de superordinateur quantique qui peut évoluer en reliant davantage de modules.La feuille de route plus large d’IBM vise également à développer l’écosystème quantique. L’entreprise investit dans l’éducation, les partenariats et l’accessibilité via le cloud afin que, lorsque le matériel sera prêt, une communauté soit prête à l’utiliser. Par exemple, IBM s’est associé à des laboratoires nationaux, des universités et même des gouvernements régionaux (comme au Japon, en Corée, en Allemagne et en Espagne) pour héberger des systèmes quantiques et stimuler le développement local. Le projet de déployer le premier IBM Quantum System Two d’Europe en Espagne d’ici 2025 [88] s’inscrit dans cette stratégie : permettre à plus de personnes de manipuler du matériel quantique avancé. La direction d’IBM prédit que l’informatique quantique deviendra un facteur clé de différenciation pour les entreprises dans les années à venir [89], et ils veulent être au centre de cette économie quantique émergente.

En conclusion, le projet d’ordinateur quantique d’IBM à plus de 4 000 qubits représente un bond historique en termes d’échelle pour l’informatique quantique. S’il réussit, il marquera la transition des processeurs quantiques isolés et expérimentaux vers des systèmes quantiques en réseau approchant le seuil de l’utilité pratique. Cette entreprise se situe à l’intersection de la physique de pointe, de l’ingénierie et de l’informatique. C’est autant un exploit logiciel qu’un exploit matériel, nécessitant de nouvelles façons de gérer et de programmer un tout nouveau type de superordinateur. Le monde observe de près – non seulement pour le nombre de qubits record, mais aussi pour voir si IBM peut démontrer des résultats utiles avec cette machine qui surpassent ce que les ordinateurs classiques peuvent faire.À la mi-2025, IBM est au seuil de cette réussite : la conception matérielle est en grande partie finalisée, les premiers prototypes fonctionnent, et l’entreprise s’efforce d’intégrer le tout dans un superordinateur opérationnel. Le succès n’est pas garanti, mais la dynamique et les progrès réalisés jusqu’à présent sont indéniables. Même les concurrents et les sceptiques reconnaissent qu’IBM a fait avancer le domaine de façon spectaculaire. Alors que nous attendons la présentation complète du superordinateur quantique d’IBM, une chose est claire : nous entrons dans un nouveau chapitre de la saga informatique. Comme l’a proclamé IBM, le futur superordinateur centré sur le quantique est prêt à devenir « une technologie essentielle pour ceux qui résolvent les problèmes les plus difficiles, ceux qui mènent les recherches les plus révolutionnaires et ceux qui développent la technologie la plus avancée » [90].

Les prochaines années diront si cette promesse est tenue, mais si le pari d’IBM s’avère payant, 4 000 qubits pourraient véritablement changer l’informatique à jamais – ouvrant la porte à des solutions pour des problèmes que l’on pensait autrefois impossibles, et annonçant l’aube de l’ère de l’informatique quantique.

Sources :

- IBM Newsroom : Feuille de route quantique d’IBM et plans pour un système à plus de 4 000 qubits [91]

- Blog IBM Research : Mise à jour de la feuille de route pour le supercalcul quantique centré sur le quantique (2024) [92]

- Communiqué de presse du IBM Quantum Summit 2023 [93]

- TechMonitor : IBM dévoile un superordinateur quantique qui pourrait atteindre 4 000 qubits d’ici 2025 [94]

- IEEE Spectrum : Objectif d’IBM : un processeur de 4 000 qubits d’ici 2025 (analyse de la feuille de route et des défis) [95]

- InsideHPC : IBM à Think 2022 – vision de l’informatique quantique-centrée [96]

- The Quantum Insider : Feuilles de route de l’informatique quantique des principaux acteurs (IBM, Google, IonQ, etc.) [97]

- TomorrowDesk : Aperçu de l’objectif d’IBM pour le superordinateur quantique 2025 et du design modulaire [98]

- Post-Quantum (blog industriel) : Sur le nombre de qubits nécessaires pour casser le chiffrement RSA-2048 [99]

- TechMonitor : Citations du Dr Darío Gil d’IBM et statistiques du réseau IBM Quantum [100]

References

1. insidehpc.com, 2. www.techmonitor.ai, 3. tomorrowdesk.com, 4. newsroom.ibm.com, 5. insidehpc.com, 6. www.techmonitor.ai, 7. newsroom.ibm.com, 8. insidehpc.com, 9. insidehpc.com, 10. insidehpc.com, 11. insidehpc.com, 12. www.techmonitor.ai, 13. newsroom.ibm.com, 14. www.ibm.com, 15. www.ibm.com, 16. www.ibm.com, 17. www.ibm.com, 18. www.ibm.com, 19. spectrum.ieee.org, 20. spectrum.ieee.org, 21. tomorrowdesk.com, 22. www.techmonitor.ai, 23. insidehpc.com, 24. www.techmonitor.ai, 25. newsroom.ibm.com, 26. newsroom.ibm.com, 27. www.techmonitor.ai, 28. www.techmonitor.ai, 29. newsroom.ibm.com, 30. newsroom.ibm.com, 31. www.techmonitor.ai, 32. www.techmonitor.ai, 33. www.techmonitor.ai, 34. newsroom.ibm.com, 35. newsroom.ibm.com, 36. www.ibm.com, 37. spectrum.ieee.org, 38. spectrum.ieee.org, 39. postquantum.com, 40. postquantum.com, 41. spectrum.ieee.org, 42. thequantuminsider.com, 43. thequantuminsider.com, 44. thequantuminsider.com, 45. thequantuminsider.com, 46. thequantuminsider.com, 47. thequantuminsider.com, 48. thequantuminsider.com, 49. thequantuminsider.com, 50. thequantuminsider.com, 51. thequantuminsider.com, 52. thequantuminsider.com, 53. thequantuminsider.com, 54. tomorrowdesk.com, 55. www.ibm.com, 56. www.ibm.com, 57. thequantuminsider.com, 58. www.ibm.com, 59. www.ibm.com, 60. www.ibm.com, 61. www.ibm.com, 62. www.ibm.com, 63. spectrum.ieee.org, 64. spectrum.ieee.org, 65. thequantuminsider.com, 66. newsroom.ibm.com, 67. www.hpcwire.com, 68. www.ibm.com, 69. www.ibm.com, 70. www.ibm.com, 71. www.ibm.com, 72. www.ibm.com, 73. www.techmonitor.ai, 74. www.ibm.com, 75. newsroom.ibm.com, 76. tomorrowdesk.com, 77. tomorrowdesk.com, 78. www.ibm.com, 79. newsroom.ibm.com, 80. newsroom.ibm.com, 81. thequantuminsider.com, 82. www.hpcwire.com, 83. www.hpcwire.com, 84. newsroom.ibm.com, 85. newsroom.ibm.com, 86. insidehpc.com, 87. newsroom.ibm.com, 88. tomorrowdesk.com, 89. thequantuminsider.com, 90. insidehpc.com, 91. newsroom.ibm.com, 92. www.ibm.com, 93. newsroom.ibm.com, 94. www.techmonitor.ai, 95. spectrum.ieee.org, 96. insidehpc.com, 97. thequantuminsider.com, 98. tomorrowdesk.com, 99. postquantum.com, 100. www.techmonitor.ai