- Apple zahájil éru AI přímo na zařízení v roce 2017 s Neural Engine v iPhonu A11, který umožnil Face ID a Animoji až do 600 miliard operací za sekundu.

- V roce 2023 přinesl 16jádrový Neural Engine v iPhonu A17 Pro přibližně 35 TOPS, což pohání funkce rozpoznávání řeči, fotografování a překladů přímo na zařízení.

- Google Pixel 8 (2023) využívá Tensor G3 NPU k provozu AI modelů přímo na zařízení, například Palm 2 pro offline překlad a sumarizaci.

- Google Edge TPU na Coral Dev Board poskytuje 4 TOPS zpracování obrazu při několika wattech.

- Tesla Full Self-Driving hardware má dvě NPU: HW3 (2019) nabízel asi 144 TOPS a HW4 (2023) kolem 200–250 TOPS.

- NVIDIA Drive Thor (představeno 2024) může dosáhnout až 2000 TOPS, když jsou propojeny dva čipy pro automobilové AI úlohy.

- Qualcomm Snapdragon 8 Gen 3 (2023) Hexagon NPU je o 98 % rychlejší než Gen 2, zvládne provozovat LLMs až do 10 miliard parametrů přímo na zařízení a v demonstracích dosáhl nejrychlejší mobilní Stable Diffusion na světě.

- MediaTek Dimensity 9400 (2024) se šestou generací APU pohání AI úpravy fotografií v Oppo Find X8 a naznačuje rozšíření NPU do televizí, IoT a automobilů do roku 2025.

- Intel Meteor Lake, 14. generace Core (uvedena 2023; přejmenována na Core Ultra v roce 2024), obsahuje integrovanou NPU s výkonem asi 8–12 TOPS, Arrow Lake má ~13 TOPS a Lunar Lake má údajně kolem 45 TOPS.

- AMD Ryzen 7040 Phoenix (2023) představil Ryzen AI Engine s výkonem až 10 TOPS, zatímco Ryzen 8000 desktop (začátek 2024) nabídl 39 TOPS, než AMD v této generaci NPU pozastavil.

Stručně řečeno: Váš chytrý telefon, fotoaparát a dokonce i auto dostávají vestavěné AI mozky – bez nutnosti cloudu. Speciální čipy zvané NPU (Neural Processing Units) a TPU (Tensor Processing Units) mění běžná zařízení v inteligentní asistenty schopné rozpoznávání obličeje, hlasových příkazů, překladů v reálném čase, autonomního řízení a dalších funkcí. Tato AI revoluce přímo na zařízení slibuje bleskově rychlé reakce, lepší soukromí a nové funkce, které jsme dříve považovali za možné jen na superpočítačích. V této zprávě demystifikujeme NPU a TPU, ukážeme, jak se liší od CPU/GPU, a prozkoumáme, proč technologičtí giganti jako Apple, Google, Qualcomm a Intel závodí, aby tyto „AI mozky“ dostali do všeho od telefonů po auta. Také zdůrazníme nejnovější průlomy 2024–2025, odborné postřehy, průmyslové standardy a co čeká AI přímo na zařízení v budoucnu.

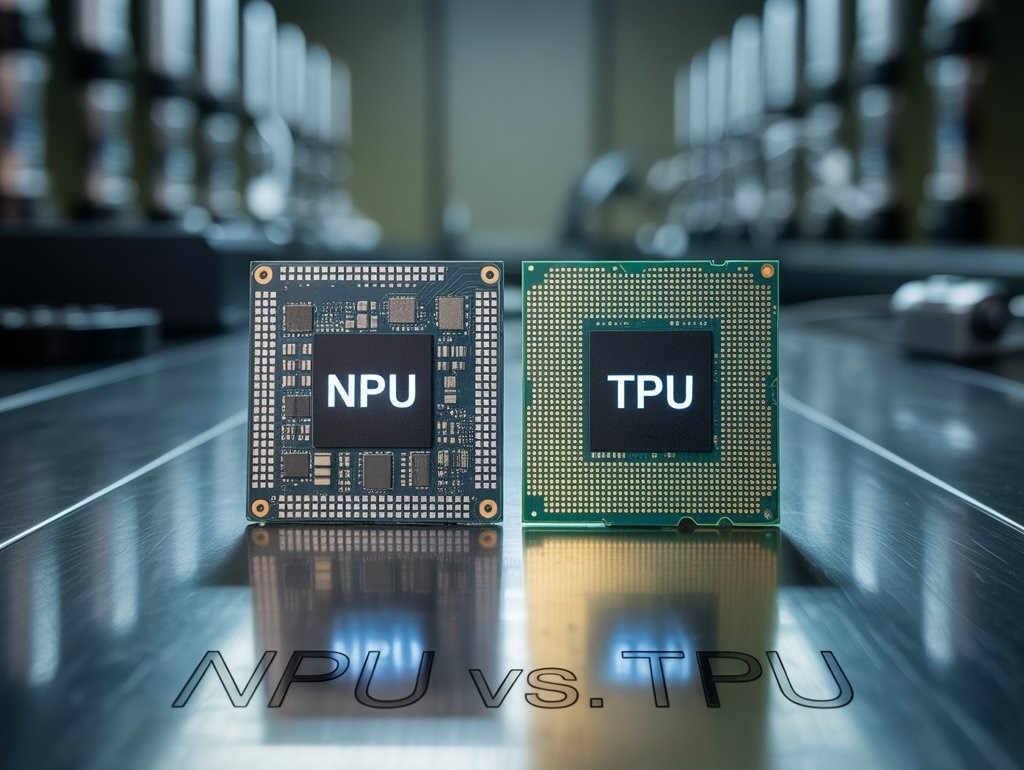

Co jsou NPU a TPU? (Seznamte se s AI mozkem vašeho zařízení)

Neural Processing Units (NPUs) jsou specializované procesory navržené k urychlení umělých neuronových sítí – algoritmů, které pohánějí moderní AI úlohy, jako je rozpoznávání obrazu, zpracování řeči a další. Na rozdíl od univerzálních CPU jsou NPUs application-specific integrated circuits (ASICs) optimalizované pro maticovou matematiku a náročné paralelní úlohy neuronových sítí Techtarget. NPU „napodobuje neuronové sítě lidského mozku, aby urychlila AI úlohy,“ v podstatě funguje jako silicon brain uvnitř vašeho zařízení Techtarget. NPUs vynikají v provádění inference (dělání předpovědí) pro AI modely efektivně přímo na zařízení, často s využitím nižší číselné přesnosti (např. 8bitová celá čísla), aby šetřily energii a přitom stále poskytovaly vysoký výkon Backblaze. Termín „NPU“ je někdy používán obecně pro jakýkoli AI akcelerátor, ale častěji označuje ty v mobilních a edge zařízeních Backblaze. Například „Neural Engine“ od Apple v iPhonech a mobilní AI engine od Samsungu jsou NPUs integrované do jejich systémů na čipu (SoC).

Tensor Processing Units (TPUs) na druhé straně vznikly ve společnosti Google jako vlastní čipy pro akceleraci strojového učení, zejména pro framework TensorFlow. TPU je typ ASIC optimalizovaný pro tensorové operace (maticové násobení atd.), které jsou jádrem trénování a inferencí neuronových sítí Backblaze. Google poprvé nasadil TPU ve svých datových centrech v roce 2015, aby urychlil výpočty neuronových sítí, a později je zpřístupnil prostřednictvím Google Cloud Backblaze. TPU používají odlišnou architekturu zvanou systolické pole, která propojuje mnoho malých výpočetních jednotek do mřížky, jež pumpuje data skrz řetězec jednotek pro maticové násobení Backblaze. Tento návrh dosahuje extrémní propustnosti při úlohách hlubokého učení. TPU od Googlu záměrně obětují část přesnosti (používají 8bitovou nebo 16bitovou aritmetiku místo 32bitových plovoucích čárek) výměnou za obrovské zisky v rychlosti a efektivitě Backblaze, protože mnoho AI úloh nevyžaduje vysokou přesnost pro dosažení přesných výsledků. Ačkoliv „TPU“ technicky označuje čipy Googlu, termín se někdy používá obecněji pro jakýkoli „tensorový“ akcelerátor. Za zmínku stojí, že Google také vyrábí Edge TPU koprocesory pro AI přímo na zařízení v produktech jako Coral Dev Board, které poskytují 4 biliony operací za sekundu při několika wattech 1 .

Stručně řečeno: NPU a TPU jsou oba křemíkové akcelerátory pro AI, ale NPU jsou běžně zabudovány do mobilních/edge zařízení pro efektivní inference přímo na zařízení, zatímco TPU (v užším smyslu) byly vysoce výkonné čipy (a nyní moduly) primárně od Googlu, původně určené pro úlohy trénování a inference v cloudu/datových centrech. Oba se odklánějí od tradičních návrhů CPU/GPU a upřednostňují paralelní matematické operace pro neuronové sítě. Jak to vyjádřil jeden technologický redaktor, „TPU jdou ve specializaci ještě dál, zaměřují se na tensorové operace, aby dosáhly vyšších rychlostí a energetické efektivity… NPU jsou rozšířené v zařízeních s AI, jako jsou chytré telefony a IoT zařízení“ 2 .

Jak se NPU a TPU liší od CPU a GPU?

Tradiční CPU (centrální procesorové jednotky) jsou „mozkem“ běžného výpočetního prostředí – jsou optimalizované pro flexibilitu, aby zvládly nejrůznější úkoly, od provozu operačního systému až po prohlížení webu. Mají několik výkonných jader, která vynikají v sekvenční logice a různorodých instrukcích, ale nejsou příliš vhodné pro vysoce paralelní matematické výpočty potřebné pro hluboké učení Techtarget. Když je CPU požádáno o zpracování velké neuronové sítě, často se stává úzkým hrdlem, protože se snaží provádět miliony násobení a sčítání postupně nebo v omezených paralelních dávkách. To vede k vysoké latenci a spotřebě energie (tzv. Von Neumannovo úzké hrdlo, kdy se mezi CPU a pamětí přenáší velké množství dat) Backblaze. CPU zvládnou nějakou AI práci (zejména jednodušší nebo menší modely, nebo řídicí logiku pro AI programy Techtarget), ale obecně mají problém efektivně škálovat na požadavky moderní AI na masivní paralelní lineární algebru.

GPU (grafické procesorové jednotky) přinesly paralelní výpočty do popředí. Původně byly určeny pro vykreslování obrazů prováděním mnoha jednoduchých operací paralelně na pixelech a vrcholech, ale ukázalo se, že jsou velmi vhodné i pro trénování neuronových sítí, které také zahrnují aplikaci stejných matematických operací (skalární součiny atd.) na velké množství dat současně Techtarget. GPU obsahuje stovky nebo tisíce malých jader, která mohou provádět matematické operace paralelně. Díky tomu jsou GPU vynikající pro velké AI úlohy a v průběhu 10. let 21. století se GPU (zejména NVIDIA s CUDA softwarem) staly tahounem výzkumu hlubokého učení. GPU jsou však stále do určité míry univerzální – musí zvládat různé grafické úlohy a zachovat si flexibilitu, takže nejsou na 100 % optimalizované pro neuronové sítě. Také spotřebovávají hodně energie a vyžadují pečlivé programování pro plné využití (nemají rády složité větvení kódu a nejlépe fungují u úloh s jednoduchým, datově paralelním zpracováním) 3 .

NPU a TPU posouvají specializaci ještě dále. Jsou navrženy speciálně pro pouze zátěž neuronových sítí. To znamená, že jejich architektura může odstranit vše, co není potřeba pro AI matematiku, a věnovat více křemíku věcem jako jednotky pro maticové násobení, akumulační sčítače a paměť na čipu pro rychlý přesun dat dovnitř a ven z těchto matematických jednotek. Například Google Cloud TPU je v podstatě obrovské 2D pole MAC (multiply-accumulate) jednotek s chytrou architekturou datového toku (systolické pole), která je zásobuje operandy vysokou rychlostí Backblaze. Nezabývá se cachemi, spekulativním vykonáváním ani jinými funkcemi CPU – je optimalizován pro maticovou matematiku. NPU v mobilních čipech podobně integrují dedikované jádra neuronového enginu vedle CPU/GPU. Tato jádra často používají aritmetiku s nízkou přesností (např. 8bitová celá čísla jako TPU) a provádějí vysoce paralelní výpočty „vrstvu po vrstvě“ pro věci jako konvoluční neuronové sítě. NPU může používat „fúzovanou“ architekturu kombinující skalární, vektorové a tensorové jednotky (Qualcomm Hexagon NPU to dělá), aby efektivně zvládal různé operace neuronových sítí 4 .

Klíčové rozdíly spočívají v:

- Instrukční sada a flexibilita: CPU mají širokou, obecnou instrukční sadu (umí mnoho věcí, ale ne všechny najednou). GPU mají omezenější, ale stále flexibilní instrukční sadu optimalizovanou pro propustnost v matematice. NPU/TPU mají velmi úzkou instrukční sadu – v podstatě jen operace potřebné pro neuronové sítě (maticové násobení, konvoluce, aktivační funkce), často implementované jako pevné pipeline nebo pole Wikichip. Například NPU pro autonomní řízení Tesly má ve své ISA pouze 8 instrukcí, zaměřených na DMA čtení/zápisy a skalární součiny 5 .

- Paralelismus a jádra: CPU = několik výkonných jader; GPU = tisíce jednoduchých jader; NPU/TPU = v jistém smyslu desítky tisíc velmi jednoduchých ALU (MAC jednotky) uspořádaných do matice nebo ve stylu neuronové sítě. Jeden čip NPU může provádět desítky bilionů operací za sekundu – NPU v Tesle běží na 2 GHz s 9 216 MAC, dosahuje ~37 teraoperací za sekundu (TOPS) na jádro a každý FSD čip má dvě NPU pro ~74 TOPS Wikichip, ts2.tech. Naproti tomu špičkové CPU může dosáhnout jen několika stovek miliard operací za sekundu při AI úlohách a GPU možná několik TOPS, pokud nepoužívá speciální tensor jádra.

- Paměťová architektura: NPU/TPU spoléhají na rychlou paměť na čipu a streamování dat. TPU se vyhýbají klasickému úzkému hrdlu paměti použitím systolického datového toku – každá malá jednotka předává data další v přesném taktu, čímž minimalizuje čtení/zápisy do hlavní paměti Backblaze. Mnoho NPU obsahuje blok SRAM na čipu pro váhy/aktivace (např. NPU jádra Tesly mají každé 32 MB SRAM pro lokální uložení dat neuronové sítě) Semianalysis. To je v kontrastu s GPU/CPU, které silně využívají externí DRAM.

- Přesnost: CPU/GPU obvykle počítají s 32bitovými nebo 64bitovými hodnotami v plovoucí čárce. AI akcelerátory často používají 16bitová nebo 8bitová celá čísla (a některé nyní zkoumají i 4bitová nebo dokonce 2bitová), protože neuronové sítě snesou nižší přesnost. Návrháři TPU od Googlu výslovně uvedli, že pro inference nepotřebujete plnou přesnost v plovoucí čárce, podobně jako „nemusíte vědět přesně, kolik kapek deště padá, abyste poznali, že silně prší“ Backblaze. To umožňuje NPU/TPU provádět více operací paralelně a spotřebovat méně energie na operaci.

- Využití: GPU se stále široce používají pro trénování velkých modelů a pro flexibilní výpočty (a jsou běžné v datových centrech a výkonných PC). TPU (cloud) cílí na rozsáhlé trénování a inference v ekosystému Googlu. NPU se častěji nacházejí v edge zařízeních – smartphonech, kamerách, spotřebičích – kde provádějí inference na již natrénovaných modelech. Vynikají v úlohách jako je aplikace vizuálního modelu na snímek z kamery v reálném čase nebo nepřetržité rozpoznávání klíčového slova hlasového asistenta při nízké spotřebě. Jak poznamenal TechTarget: „GPU jsou voleny pro dostupnost a nákladovou efektivitu v mnoha ML projektech; TPU jsou obvykle rychlejší a méně přesné, používají je firmy na Google Cloudu; NPU se běžně nacházejí v edge/mobilních zařízeních pro výrazně rychlejší lokální zpracování“ 6 .

Shrnuto, CPU = univerzální organizátoři, GPU = paralelní tahouni, TPU/NPU = specialisté na neuronové sítě. Všechny mohou spolupracovat – ve skutečnosti v moderním zařízení s podporou AI CPU často koordinuje úkoly a podle potřeby předává výpočetně náročné části NPU/GPU Techtarget. Tento trend specializace existuje, protože univerzální řešení už v informatice nestačí: jak poznamenal jeden editor, „přidávání milionů dalších tranzistorů pro každou potřebu nebylo efektivní… návrháři přijali procesory stavěné na míru“ Techtarget. Specializované NPU a TPU dramaticky urychlují AI výpočty a zároveň udržují nízkou spotřebu – což je zásadní rovnováha jak pro zařízení na baterii, tak pro vysoce husté servery.

Proč AI přímo na zařízení? (Edge vs. Cloud)

Proč vůbec provozovat AI na vašem telefonu nebo v autě – proč prostě neposlat vše do cloudu, kde to zvládnou obří servery (s GPU/TPU)? Existuje několik přesvědčivých důvodů, proč se přechází na AI přímo na zařízení, a jde především o rychlost, soukromí, náklady a spolehlivost 7 :

- Okamžitá odezva (nízká latence): NPU přímo v zařízení může zpracovávat data v reálném čase bez zpoždění způsobeného odesíláním dat na cloudový server. To je zásadní pro interaktivní nebo bezpečnostně kritické AI úlohy. Například autonomní řídicí systém auta s vestavěnými NPU dokáže rozpoznat chodce a okamžitě zabrzdit, během milisekund, místo čekání na výpočet v cloudu. Chytrá kamera s NPU odhalí narušitele v momentě, kdy se objeví v záběru. Na vašem telefonu znamená AI přímo na zařízení, že váš hlasový asistent reaguje rychleji a přirozeněji, protože nemusí neustále „volat domů“. Snížená latence umožňuje skutečné rozhodování v reálném čase a plynulejší uživatelský zážitek 7 .

- Soukromí a bezpečnost dat: AI na zařízení uchovává vaše data lokálně. Místo toho, aby byl zvuk z mikrofonu nebo obraz z kamery odesílán do cloudu k analýze, probíhá zpracování přímo v zařízení. Tím se výrazně snižuje riziko úniku citlivých dat. Například moderní chytré telefony provádějí rozpoznávání obličeje (Face ID atd.) zcela na zařízení – biometrická mapa vašeho obličeje nikdy neopustí zabezpečenou oblast telefonu. Podobně může AI naslouchátko nebo zdravotní nositelný přístroj analyzovat biometrická data bez nahrávání na jakýkoli server, což zachovává soukromí. Vzhledem k rostoucím obavám uživatelů a regulacím ohledně suverenity dat je to velká výhoda. Jak uvedl jeden blog o edge AI, zpracování na zařízení znamená, že „uživatelská data není třeba přenášet do cloudu,“ což poskytuje základní výhodu v oblasti soukromí Nimbleedge. (Samozřejmě, soukromí není automatické – vývojáři musí stále pečlivě nakládat s uloženými daty – ale je snazší důvěřovat zařízením, která neodesílají vaše informace neustále pryč.) Technologičtí ředitelé často zdůrazňují tento aspekt. Generální ředitel Qualcommu Cristiano Amon poznamenal, že kombinace cloudové a lokální inteligence může zlepšit personalizaci při zachování bezpečnosti dat v zařízení – nazývá to „hybridní budoucnost“, kde AI na zařízení spolupracuje s cloudovou AI pro to nejlepší z obou světů 8 .

- Dostupnost a spolehlivost offline: Zařízení s NPU/TPU nejsou závislá na připojení. Mohou fungovat v tunelu metra, v letadle, v odlehlých venkovských oblastech nebo během výpadků sítě. To je zásadní pro spolehlivost. Funkce hlasového diktování na zařízení bude fungovat i bez signálu. Dron s palubní vizuální AI se vyhne překážkám i mimo síť. Tato nezávislost je také klíčová pro kritické systémy: např. záchranné roboty nebo zdravotnická zařízení, která nemohou předpokládat živé internetové připojení. „Offline funkčnost“ je hlavní výhodou AI na zařízení Nimbleedge – zajišťuje, že AI funkce je dostupná kdykoli a kdekoli je potřeba.

- Nákladová efektivita v měřítku: Neustálé odesílání surových dat do cloudu ke zpracování AI může být velmi nákladné (výpočetní výkon v cloudu není zdarma) a náročné na šířku pásma. Jak se AI funkce rozšiřují, firmy by musely platit obrovské účty za cloudové zpracování, pokud by každý malý úkol běžel na serveru. Díky většímu využití edge zařízení snižují zátěž cloudových serverů a síťový provoz. Často je efektivnější investovat pár dolarů navíc do lepšího čipu v zařízení, než platit za gigabajty cloudového výpočtu po celou dobu životnosti zařízení. Analýza od Futurum poznamenala, že zpracování na zařízení pomáhá řešit problémy generativní AI s rozšiřováním a náklady – „rozkládá“ zátěž, takže datová centra nejsou přetížena (a uživatelé/vývojáři neplatí horentní sumy za cloudový čas GPU) 9 .

- Personalizace a kontext: Nově se objevující důvod: AI přímo na zařízení se může učit z místního kontextu a přizpůsobovat se mu způsobem, jakým to cloudová AI nemusí zvládnout. Váš chytrý telefon může udržovat malý lokální model, který se učí váš styl psaní pro lepší automatické opravy, aniž by tento osobní jazykový model sdílel do cloudu. Zařízení mohou v reálném čase slučovat data z více senzorů (což je jednodušší provádět lokálně než streamovat spoustu senzorových dat do cloudu). To může umožnit více personalizovaný a kontextově uvědomělý zážitek. Některé funkce jako federované učení dokonce umožňují zařízením zlepšovat AI modely společně bez nahrávání surových dat (odesílají se pouze malé aktualizace vah).

- Regulace a datová suverenita: Zákony jako evropské GDPR a různé požadavky na lokalizaci dat stále častěji nařizují, že určitá data (zejména osobní nebo citlivá) nesmí být bez souhlasu odesílána do zahraničí nebo třetím stranám. AI přímo na zařízení nabízí způsob, jak vyhovět tím, že zpracovává data přímo u zdroje. Například AI nástroje pro lékařské zobrazování mohou běžet na nemocničním hardwaru (edge servery s NPU), takže data pacientů nikdy neopustí prostory nemocnice, což řeší požadavky na ochranu soukromí. Zpráva společnosti NimbleEdge z roku 2025 poukazuje na to, že vlády prosazují více lokálního inferencování z důvodů suverenity a souladu s předpisy 10 .

Všechny tyto faktory pohánějí paradigmatický posun: místo přístupu „cloud-first“ pro AI nyní firmy navrhují AI funkce „device-first“, kdykoli je to možné. Jak to shrnul viceprezident AI společnosti Qualcomm, Durga Malladi: „Aby bylo možné efektivně rozšířit generativní AI do hlavního proudu, AI bude muset běžet jak v cloudu, tak na zařízeních na okraji… jako jsou chytré telefony, notebooky, vozidla a IoT zařízení“ Iconnect007. Přecházíme do hybridního AI světa, kde těžký trénink a velké modely mohou být v cloudu, ale mnoho inferenčních úloh a osobních AI zážitků běží lokálně na NPU/TPU ve vašich rukou a domovech. Amon to dokonce nazývá „zlomovým bodem v AI“ – inference přímo na zařízení bez latence, kde „budoucnost AI je osobní“, protože běží přímo tam, kde jste vy 11 .

AI na zařízení v praxi: Od chytrých telefonů po autonomní auta

Specializované AI čipy jsou již zabudovány v široké škále zařízení kolem vás a často je neviditelně dělají chytřejšími. Zde jsou hlavní oblasti, kde jsou NPU a edge TPU nasazeny:

- Smartphony a tablety: Téměř všechny moderní vlajkové telefony (a dokonce i mnoho střední třídy) nyní obsahují NPU nebo dedikovaný AI engine. Apple odstartoval tento trend v roce 2017 s Apple Neural Engine v čipu iPhonu A11, což umožnilo rozpoznávání obličeje Face ID a Animoji přímo v zařízení díky výkonu až 600 miliard operací za sekundu Fandom. Dnes má čip Apple A17 Pro (2023) 16jádrový Neural Engine schopný 35 bilionů operací za sekundu Fandom. To pohání funkce jako pokročilá detekce scén fotoaparátem, fotografické styly, hlasové příkazy Siri zpracovávané offline, automatické opravy, živý přepis a dokonce i běh transformer modelů pro překlad přímo v zařízení. Také telefony Google Pixel mají vlastní čipy (“Google Tensor” SoC) s NPU: nejnovější Tensor G3 v Pixelu 8 byl „navržen na míru pro běh AI modelů Google“, přičemž vylepšuje každou část čipu (CPU, GPU, ISP), aby umožnil generativní AI přímo v zařízení Blog. Pixel 8 dokáže spouštět špičkové modely Google pro převod textu na řeč a překlad lokálně, tedy ty, které byly dříve omezeny na datová centra Blog. Také provádí složité triky s fotoaparátem, jako je „Best Take“ pro slučování skupinových fotek a Audio Magic Eraser pomocí sady AI modelů přímo v zařízení Blog. Samsung a další výrobci Androidu používají čipsety Qualcomm Snapdragon, jejichž nejnovější NPU (Hexagon AI engine) dokáže dokonce spouštět velké jazykové modely na telefonu – Qualcomm předvedl běh LLM s 10 miliardami parametrů a dokonce i generování obrázků pomocí Stable Diffusion na telefonu se Snapdragonem 8 Gen 3 Futurumgroup. AI engine tohoto čipu je o 98 % rychlejší než předchozí generace a podporuje přesnost INT4 pro vyšší efektivitu Futurumgroup. Praktický výsledek: váš telefon z roku 2024 zvládne například shrnout články, odpovídat na otázky nebo upravovat fotky pomocí AI bez potřeby cloudu. Dokonce i funkce přístupnosti z toho těží: např. telefony Pixel nyní mají hlasové psaní, živé titulky a chystanou funkci pro popis obrázků nevidomým uživatelům pomocí lokálního modelu.

- Chytré kamery a bezpečnostní systémy: Kamery s podporou AI využívají vestavěné NPU k okamžité detekci osob, obličejů, zvířat nebo podezřelého chování. Například nejnovější bezpečnostní kamery EnGenius obsahují vestavěné NPU, které zajišťuje detekci objektů a převádí video na metadata přímo v kameře, čímž odpadá potřeba samostatného videorekordéru a zvyšuje se bezpečnost (protože video lze analyzovat a ukládat lokálně) Engeniustech. To znamená, že vaše bezpečnostní kamera může rozhodnout „osoba přítomna“ nebo „balíček doručen“ a poslat pouze toto upozornění, místo aby streamovala hodiny záznamu do cloudové služby. Podobně spotřebitelská zařízení jako Google Nest Cam IQ měla čip pro zpracování obrazu přímo v zařízení (Google Edge TPU), který rozpoznával známé tváře a rozlišoval lidi od domácích mazlíčků ve svém zorném poli. DSLR a bezzrcadlovky také přidávají AI procesory pro funkce jako sledování objektu, automatické zaostřování na oko a optimalizaci scény v reálném čase. U dronů pomáhají vestavěné AI čipy s vyhýbáním se překážkám a vizuální navigací bez nutnosti dálkového ovládání. Významně, Google’s Edge TPU (malý ASIC modul) se stal oblíbeným doplňkem pro DIY a průmyslové IoT kamery – poskytuje 4 TOPS výkonu pro zpracování obrazu pro úkoly jako detekce osob nebo čtení SPZ, přičemž spotřebuje jen ~2 watty 1 .

- Chytrá domácnost a IoT zařízení: Kromě telefonů má mnoho chytrých domácích zařízení mini NPU. Hlasově ovládané reproduktory (Amazon Echo, Google Nest Hub atd.) nyní často obsahují čipy pro lokální rozpoznávání řeči. Amazon vyvinul AZ1 Neural Edge procesor pro zařízení Echo, aby urychlil detekci aktivačního slova Alexa a odpovědi na zařízení, čímž snížil latenci na polovinu Embedl. AZ1 (vytvořený s MediaTek) provozuje neuronovou síť, která rozpoznává „Alexa“ a zpracovává jednoduché příkazy bez nutnosti připojení ke cloudu Embedl. To nejen zrychluje odezvu Alexy, ale také uchovává více hlasových dat v soukromí. Podobně mnoho nových televizí, spotřebičů a dokonce i hraček má nějakou AI na okraji sítě – např. kamera chytré lednice může lokálně identifikovat potraviny a data spotřeby. Wearables si také zaslouží zmínku: čip S9 v Apple Watch přidal 4jádrový Neural Engine pro lepší zpracování zdravotních AI algoritmů a požadavků na Siri přímo na hodinkách Fandom. A v průmyslu mohou IoT senzory s NPU provádět detekci anomálií v datech zařízení přímo na okraji sítě, přičemž nahoru posílají pouze relevantní události (šetří šířku pásma a rychleji reagují na problémy).

- Automobily (ADAS a autonomie): Auta se stala AI centry na kolech. Pokročilé asistenční systémy řidiče (ADAS) a funkce samořízení spoléhají na sadu palubních AI akcelerátorů, které interpretují obraz z kamer, LiDARu, radaru a činí rozhodnutí během zlomku sekundy. Tesla je známá tím, že navrhla svůj vlastní FSD (Full Self-Driving) Computer se dvěma NPU čipy. Tesla FSD čip (HW3, představený v roce 2019) poskytoval 144 TOPS (dvě NPU po 72 TOPS); novější HW4 (2023) zvyšuje tento výkon na přibližně 200–250 TOPS celkem (dvě 7nm NPU kolem 100+ TOPS každé) ts2.tech. To umožňuje vozu zpracovávat plné rozlišení videa z 8 kamer, sonar atd. současně pomocí neuronových sítí pro vnímání a dokonce spouštět některé jazykové modely pro hlasové povely – vše lokálně uvnitř modulu vozu. Konkurenční platformy jako NVIDIA Drive a Qualcomm Snapdragon Ride také integrují NPU. Nejnovější automobilový superpočítačový čip od NVIDIA, Drive Thor, určený pro auta v roce 2025, se chlubí až 1 000 TOPS na jednom čipu (a 2 000 TOPS při spárování dvou čipů) pro podporu autonomie úrovně 4 ts2.tech. Kombinuje GPU, CPU a dedikované akcelerátory hlubokého učení, takže zvládne vše od rozpoznávání dopravních značek po AI pro monitorování řidiče přímo na čipu ts2.tech. Tyto NPU doslova zachraňují životy: autonomní auto nemůže čekat na cloudové servery, pokud dítě vběhne do silnice. Palubní AI musí vidět a reagovat během desítek milisekund. Mimo osobní automobily najdete rozsáhlé využití edge AI také v autonomních dronech, doručovacích robotech a průmyslových vozidlech, které se orientují a rozhodují pomocí palubních NPU/TPU (například doručovací roboti Nuro a mnoho systémů samořiditelných kamionů používá na zařízení AI čipy NVIDIA nebo Huawei).

- Edge computing a průmysl: Ve výrobních a podnikových prostředích má AI na zařízení často podobu edge serverů nebo bran s AI akcelerátory. Místo odesílání kamerových záznamů nebo dat ze senzorů do centrálního cloudu instalují firmy edge boxy (někdy založené na GPU, jindy na NPU/FPGA) přímo na místě. Tyto zařízení zajišťují úkoly jako analýza videa v reálném čase pro kontrolu kvality na výrobní lince, detekci vad pomocí AI vize během mikrosekund. Dalším příkladem jsou zdravotnická zařízení: přenosný ultrazvuk nebo MRI může mít NPU pro AI analýzu obrazu přímo na zařízení, takže lékaři získají okamžitou diagnostickou pomoc bez nutnosti připojení k internetu (což je také lepší pro ochranu soukromí pacientských dat). Maloobchod a města také nasazují AI na okraji sítě – např. chytré dopravní kamery s NPU pro analýzu dopravní zácpy a úpravu světel, nebo kamery na regálech v obchodech, které sledují zásoby. Mnohé z nich využívají specializované NPU jako Intel Movidius Myriad čipy, Google Edge TPU nebo nové hráče jako Hailo-8 (izraelské NPU, které poskytuje 26 TOPS při několika wattech pro kamery). Společným jmenovatelem je, že tyto akcelerátory umožňují analýzu lokálně, dosahují výsledků v reálném čase a přes síť posílají pouze vysoce zpracované informace (namísto surových dat).

Všestrannost NPU/TPU napříč typy zařízení je působivá. Jednou umožňují vašemu telefonu rozmazat pozadí na fotografii pomocí AI, a vzápětí řídí dron nebo analyzují lékařské snímky. Fotoaparáty chytrých telefonů nyní využívají NPU pro funkce jako Noční režim (inteligentní skládání více snímků), bokeh v portrétním režimu, rozpoznávání scény (telefon pozná, že fotíte „západ slunce“ a optimalizuje barvy pomocí AI), a dokonce i pro zábavné AR efekty (Animoji mapující váš obličej, nebo Snapchat filtry sledující vaše pohyby – to vše díky neuronovým sítím přímo v zařízení). Biometrie využívá NPU: snímače otisků prstů vylepšené AI pro detekci živosti, odemykání obličejem s hloubkovými senzory a AI. Audio je také využívá: potlačení šumu ve sluchátkách a telefonech je nyní často řízeno AI, přičemž NPU v reálném čase odděluje hlas od okolního hluku.

Konkrétní příklad inovace roku 2024: Oppo (výrobce chytrých telefonů) ve spolupráci s MediaTek oznámil, že v roce 2024 implementoval Mixture-of-Experts (MoE) AI model přímo na zařízení – údajně jako první v telefonu Grandviewresearch. Tato pokročilá architektura neuronové sítě (MoE) může zvýšit výkon tím, že pro každý úkol aktivuje pouze relevantní „expertní“ podsítě, a provádění tohoto procesu přímo na zařízení znamená, že telefony Oppo dosahují rychlejšího AI zpracování a lepší energetické účinnosti u složitých úloh bez potřeby cloudu Grandviewresearch. To ukazuje, jak se i špičkový AI výzkum rychle dostává do našich kapesních zařízení díky vylepšeným NPU.

Uvnitř AI čipů 2025: Nejnovější vývoj od Apple, Google, Qualcomm a dalších

Závod o vývoj lepšího AI hardwaru na zařízení se rychle zintenzivnil. Zde je přehled toho, co hlavní společnosti nedávno (2024–2025) představily v oblasti NPU/TPU a AI čipů:

- Apple: Apple dlouhodobě klade důraz na strojové učení přímo v zařízení díky vlastní strategii vývoje čipů. Každý rok roste výkon Apple Neural Engine. V iPhonu 15 Pro z roku 2023 dosáhl Neural Engine čipu A17 Pro hodnoty 35 TOPS (bilionů operací za sekundu) se svými 16 jádry Fandom. To bylo dvojnásobné surové propustnosti oproti NPU v A16 a Apple toho využil například pro rozpoznávání řeči Siri přímo v zařízení (konečně zpracovává mnoho požadavků Siri bez internetu) a nové možnosti fotoaparátu (například automatické pořizování portrétů a živý překlad textu přes fotoaparát). Čipy Apple z roku 2024 v tomto trendu pokračovaly: rodina M3 pro Macy (konec 2023) dostala vylepšený Neural Engine (zajímavě vyladěný na 18 TOPS u základního čipu M3, s důrazem na efektivitu) Fandom. V roce 2024 Apple představil čip M4 (pro špičkové iPady/Macy, polovina 2024), který údajně zvýšil výkon Neural Engine na 38 TOPS díky vylepšenému 3nm procesu Fandom. Nejde ale jen o čísla – Apple využívá tento NPU: funkce jako Personal Voice (vytvoří klon hlasu uživatele po 15 minutách tréninku) běží soukromě na Neural Engine v iPhonech a přepisy Live Voicemail probíhají lokálně. Apple také integroval NPU do všech svých zařízení – dokonce i AirPods Pro mají malý neural čip pro Adaptive Audio. Vedoucí pracovníci Applu často zdůrazňují aspekt soukromí: „strojové učení na vašem zařízení“ znamená, že vaše data zůstávají u vás. Do roku 2025 očekáváme, že Apple Neural Engine se možná ještě rozšíří nebo bude nově zpřístupněn aplikacím třetích stran (již nyní mohou vývojáři využívat Core ML, ale Apple by mohl otevřít více neural API). Objevují se také spekulace, že Apple navrhuje samostatný AI akcelerátor pro budoucí brýle nebo auta, ale současné produkty ukazují, že dávají přednost integrovaným NPU v řadách SoC A a M.

- Google: Google nejenže byla průkopníkem cloudového TPU, ale také zdvojnásobila své úsilí v oblasti AI na zařízení pro telefony Pixel a spotřebitelská zařízení. Google Tensor SoC (poprvé představený v roce 2021 v Pixel 6) byl unikátní tím, že Google, známý svým cloudem, vytvořil čip do telefonu, který umožňuje provozovat AI přímo v zařízení. S Tensor G3 (v Pixel 8 z roku 2023) Google zdůraznil vylepšení umožňující generativní AI na zařízení. Google výslovně uvedl, že čip v Pixel 8 přináší „výzkum Google AI přímo do našich nejnovějších telefonů“ Blog. Nová generace TPU v Tensor G3 (Google stále interně nazývá AI jádro „TPU“) umožňuje Pixelu provozovat pokročilé modely jako Palm 2 nebo Gemini Nano (odlehčené verze velkých jazykových modelů Google) přímo v zařízení pro funkce jako shrnutí webových stránek nebo vylepšené hlasové psaní Reddit. Jedna z hlavních funkcí: Pixel 8 dokáže lokálně spustit nejlepší model převodu textu na řeč od Googlu (ten, který se používá v datových centrech), což umožňuje telefonu číst webové stránky nahlas přirozenými hlasy a dokonce je v reálném čase překládat, a to vše offline Blog. Google také využívá TPU v Pixelu pro fotografii („HDR+“ snímání z více snímků, odstranění objektů pomocí AI inpaintingu Blog), pro bezpečnost (odemykání obličejem na zařízení pomocí AI, které je nyní považováno za dostatečně silné i pro platby Blog) a pro řeč (Asistent, kterému nevadí, když řeknete „ehm“). Mimo telefony nabízí Google Coral Dev Board a USB klíč pro nadšence a firmy, kteří chtějí přidat Edge TPU do svých projektů, přičemž každý obsahuje Edge TPU od Googlu, který poskytuje 4 TOPS pro vizuální úlohy při velmi nízké spotřebě Coral. Používá se i v některých vlastních produktech Googlu, například v Nest Hub Max pro rozpoznávání gest. Pro Google je integrace TPU na okraji součástí širší strategie: Sundar Pichai (CEO Googlu) řekl, že budoucnost AI je o rozšíření každé zkušenosti, a je zřejmé, že Google vidí, že „abyste přinesli transformační sílu AI do každodenního života, musíte k ní mít přístup ze zařízení, které používáte každý den“ Blog – proto čipy Tensor. Můžeme očekávat Tensor G4 v pozdních telefonech Pixel 2024, možná postavený na novějším procesu Samsungu nebo TSMC, což dále zlepší výkon a efektivitu AI, možná dokonce umožní multimodální AI na zařízení (kombinace vizuálních a jazykových modelů).

- Qualcomm: Přední dodavatel mobilních čipů pro telefony s Androidem agresivně prosazuje svůj AI Engine v sérii Snapdragon. Snapdragon 8 Gen 2 (konec roku 2022) představil dedikovanou podporu INT4 a ukázal generování obrázků pomocí stable diffusion v reálném čase na telefonu. Snapdragon 8 Gen 3 (oznámený na konci roku 2023, ve vlajkových telefonech roku 2024) je zásadní skok: Qualcomm uvádí, že jeho Hexagon NPU je o 98 % rychlejší než u Gen 2 a o 40 % úspornější Futurumgroup. Tento čip dokáže spouštět velké jazykové modely až s 10 miliardami parametrů zcela na zařízení, zpracovává asi 20 tokenů za sekundu – což stačí pro jednoduché konverzace s AI asistentem bez cloudu Futurumgroup. V demoverzích také dosáhl „nejrychlejšího generování obrázků Stable Diffusion na mobilním zařízení na světě“ Futurumgroup. Qualcomm otevřeně tvrdí, že generativní AI přímo na zařízení je klíčovým prodejním argumentem nových telefonů. Například navázali partnerství s Meta za účelem optimalizace open-source Llama 2 LLM pro Snapdragon, s cílem umožnit spuštění AI chatbota na vašem telefonu do roku 2024 Iconnect007. (Jeden z vedoucích pracovníků Qualcommu řekl: „oceňujeme otevřený přístup společnosti Meta… aby bylo možné generativní AI škálovat, musí běžet jak v cloudu, tak na okraji sítě“, což posiluje filozofii edge AI Iconnect007.) Mimo telefony Qualcomm nasazuje NPU i do čipů pro notebooky (platformy Snapdragon compute pro Windows na ARM) – a jejich automobilová platforma Snapdragon Ride využívá stejné AI jádro a nabízí až 30 TOPS pro ADAS, s plánem do budoucna dosáhnout stovek TOPS. V roce 2025 Qualcomm dokonce oznámil nový Snapdragon X Elite CPU pro PC, který obsahuje výkonné NPU, což signalizuje snahu konkurovat Applu a Intelu v AI výkonu v osobních počítačích. S nástupem AI přímo na zařízení Qualcomm dokonce některé telefony označuje jako „AI telefony“. Očekávají, že mnoho aplikací (od fotografování přes zasílání zpráv až po produktivitu) využije NPU. Na softwarové straně Qualcomm vydal Qualcomm AI Stack pro sjednocení podpory populárních frameworků (TensorFlow Lite, PyTorch, ONNX) na svých NPU Iconnect007 – snaží se tak vývojářům usnadnit využití AI hardwaru bez hlubokých znalostí čipů.

- MediaTek: Druhý největší výrobce mobilních čipů (známý sérií Dimensity) také vylepšil své NPU. MediaTek nazývá své AI enginy „APU“ (AI Processing Unit). Například Dimensity 9200+ (2023) má šestou generaci APU s výrazným nárůstem výkonu oproti předchozímu čipu, což umožňuje funkce jako stabilní difuzi přímo v zařízení a AI redukci šumu ve videích. V roce 2024 MediaTek oznámil Dimensity 9400 a ve spolupráci s Oppo využili jeho pokročilou architekturu NPU k zavedení nových AI funkcí (jak bylo zmíněno, AI přepracování fotografií s odstraněním odrazů a zaostřením rozmazaných snímků v Oppo Find X8 je poháněno NPU od MediaTeku) Mediatek. Vedoucí pracovníci MediaTeku se výslovně staví do čela AI přímo v zařízeních. Jak řekl Will Chen z MediaTeku, „budoucnost AI přesahuje cloud; je poháněna edge computingem přímo z vaší dlaně.“ Podle nich musí být AI v telefonech rychlá, soukromá, bezpečná a neustále dostupná Mediatek. MediaTek dokonce vytvořil „APU-centrickou“ spolupráci s Meta na podporu frameworků Llama a se značkami jako Oppo a Xiaomi se zaměřením na AI funkce fotoaparátu a hlasu. Do roku 2025 plánuje MediaTek nasadit tyto NPU nejen do telefonů, ale také do chytrých televizí (pro AI upscaling a vylepšení obrazu), IoT zařízení a dokonce i do automobilů (MediaTek má automobilovou AI platformu a spolupracuje s Nvidií na integraci Nvidia GPU IP do aut, přičemž pravděpodobně poskytuje své vlastní NPU pro AI senzory).

- Intel: Rok 2024 znamenal vstup Intelu do oblasti AI akcelerátorů na běžných PC. 14. generace procesorů Intel Core (Meteor Lake, uvedená na trh v prosinci 2023 a v roce 2024 přejmenovaná na Core Ultra) je prvním x86 PC procesorem s vestavěnou neuronovou procesorovou jednotkou (NPU). NPU v Meteor Lake (někdy označovaná jako VPU – Vision Processing Unit – založená na technologii Intel Movidius) poskytuje přibližně 8–12 TOPS AI výkonu Pcworld. Toto se využívá k urychlení AI funkcí Windows 11, jako je rozostření pozadí, oční kontakt při videohovorech, a mohlo by být využito aplikacemi například pro lokální přepis, potlačení šumu nebo i malé AI asistenty. Microsoft a Intel společně prosazují koncept „AI PC“. Intel tvrdí, že tyto NPU budou v roce 2024 dodány v desítkách milionů notebooků Pcworld. Po Meteor Lake roadmapa Intelu zmiňuje Arrow Lake (pro desktopy v roce 2024), který také obsahuje NPU (kolem 13 TOPS, mírně vylepšené) Pcworld. Zajímavé je, že první pokus Intelu o desktopové NPU byl ve skutečnosti překonán AMD (viz níže) a Intel se rozhodl pro skromnější návrh NPU, aby neobětoval plochu GPU/CPU v čipech pro nadšence Pcworld. Ale koncem roku 2024 Intel naznačil, že budoucí čipy Lunar Lake budou mít mnohem výkonnější NPU (~45 TOPS), aby splnily požadavky Microsoftu na „Copilot“ Pcworld. To vše naznačuje, že Intel vnímá AI jako nezbytnou součást PC do budoucna – ne pro trénování obřích modelů, ale pro urychlení každodenních AI zážitků (od vylepšení kancelářských balíků po kreativní nástroje využívající lokální AI). Intel také prodává edge AI akcelerátory jako Intel Movidius Myriad čipy (používané v některých dronech, kamerách) a Habana akcelerátory pro servery, ale integrované NPU v Meteor Lake je milníkem, který přináší AI do běžných spotřebitelských zařízení.

- AMD: AMD se do AI přímo na zařízení zapojilo přibližně ve stejnou dobu. Jeho procesory pro notebooky Ryzen 7040 (Phoenix) uvedené na trh v roce 2023 obsahovaly první Ryzen AI Engine – v podstatě integrované XDNA NPU (technologie z akvizice Xilinx společností AMD). Toto NPU poskytovalo až 10 TOPS na mobilním čipu Wikipedia. AMD propagovalo využití například pro AI-vylepšené videohovory, produktivní aplikace a podobně, podobně jako cíle Intelu. Poté AMD krátce uvedlo desktopovou řadu Ryzen 8000 (začátek roku 2024) s NPU dosahujícím 39 TOPS – což je velmi vysoké číslo pro AI jednotku univerzálního CPU, dokonce překonávající plány Intelu Pcworld. Nicméně AMD rychle změnilo směr a jednu generaci přeskočilo, zaměřilo se na další architekturu (následující Ryzen 9000 na konci roku 2024 NPU vynechal, aby upřednostnil vylepšení jader) Pcworld. Přesto se očekává, že AMD NPUs do budoucích PC čipů vrátí (pravděpodobně jde o dočasný ústup, zatímco pracují na integraci silného AI enginu bez kompromisů v jiných oblastech výkonu). Na produktové straně by NPUs od AMD mohly umožnit zajímavé věci, protože AMD má také silné GPU – tato kombinace by mohla zvládat AI úlohy společně (některé části na NPU, některé na GPU). AMD také vkládá AI jádra do svých adaptivních (na FPGA založených) SoC a automobilových čipů. Shrnutí: do roku 2025 všichni výrobci x86 PC čipů přijali NPUs, což odpovídá tomu, co udělaly smartphony před několika lety, což naznačuje, že AI akcelerace se stává standardní funkcí napříč celým trhem.

- Ostatní: Řada specializovaných firem na čipy a dalších technologických společností také inovuje v oblasti NPU. NVIDIA, známá svými GPU, nyní zahrnuje dedikované Tensor Cores ve svých GPU a nabízí otevřený NVDLA (deep learning accelerator) design pro integraci do produktů typu System-on-Chip. V edge zařízeních jako je řada NVIDIA Jetson (používaná v robotech, dronech, embedded systémech) jsou jak GPU, tak i pevně dané „DLA“ – v podstatě NPU – které odlehčují GPU při inferenci neuronových sítí. Například NVIDIA Orin modul má 2 DLA kromě svého GPU, což přispívá k jeho 254 TOPS AI výkonu pro automobily ts2.tech. Apple má podle pověstí ve vývoji ještě pokročilejší AI koprocesory nebo větší neural engine pro své AR brýle či budoucí projekty, ačkoliv detaily jsou tajné. Huawei (navzdory geopolitickým výzvám) pokračuje ve vývoji mobilních čipů Kirin s NPU (jejich architektura „DaVinci“ NPU) a také serverových NPU v jejich AI čipech Ascend – jejich čip Kirin 9000S z roku 2023 údajně stále obsahuje silné NPU pro obrazové a jazykové úlohy v jejich telefonech. Vidíme také startupy jako Hailo, Mythic, Graphcore a další, kteří nabízejí své vlastní edge AI čipy: např. Hailo-8 jak bylo zmíněno (26 TOPS v mini PCIe kartě pro AI kamery), Graphcore’s IPU pro datacentra (není to přímo on-device, ale nová architektura pro neuronové sítě), Mythic pracuje na analogových NPU atd. ARM, jehož návrhy tvoří základ většiny mobilních čipů, nabízí sérii Ethos NPU (například Ethos-U, Ethos-N78), kterou mohou výrobci čipů integrovat a získat tak hotový AI akcelerátor do IoT nebo střední třídy SoC. To umožnilo i relativně menším hráčům zahrnout NPU do svých čipů licencováním návrhu ARM.

Hlavní závěr je, že od velkých technologických firem po startupy všichni investují do AI čipů přímo v zařízeních. Díky tomu vidíme rychlý pokrok: nové čipy se chlubí vyšším TOPS, lepší efektivitou (TOPS na watt) a podporou nových datových typů (například 4bitová kvantizace pro větší modely). Například nejnovější čipy Qualcomm a MediaTek zvládají INT4 přesnost, což je skvělé pro generativní AI modely, kde je limitujícím faktorem paměťová propustnost Androidauthority. Tyto inovace se přímo promítají do výhod pro uživatele – např. mobilní AI úpravy videa v reálném čase (odstraňování objektů z 4K videa za běhu, jak to umí Snapdragon 8 Gen 3 s funkcí „Video Object Eraser“ Futurumgroup), nebo AI koprocesory v autech umožňující hlasové asistenty, kteří fungují bez sítě a reagují stejně rychle jako lidská konverzace.

Klíčové novinky 2024–2025: Nové produkty, benchmarky a partnerství

Abychom ukázali, jak rychle se věci vyvíjejí, zde jsou některé hlavní události ve světě NPU/TPU a AI přímo v zařízeních od konce roku 2024 do roku 2025:

- Představení Apple M3 a M4 (říjen 2023 a květen 2024): Přinesly nové generace Neural Engine. Neural Engine v M3 zvládá 18 TOPS (16 jader), zatímco M4 poskočil na 38 TOPS (stále 16 jader, ale vyšší takt/efektivita) Fandom. Apple předvedl, jak tyto čipy zvládají náročné úlohy, například generování obrázků pomocí stable diffusion přímo v macOS (s Core ML Stable Diffusion, vývojáři ukázali ~15 sekund na vygenerování obrázku na M2 – na M3/M4 ještě rychleji).

- Uvedení Google Pixel 8 (říjen 2023): Zdůrazněna AI „všude“ v zařízení. Google na akci předvedl sumarizaci webových stránek a živý překlad článků přímo v zařízení pomocí Tensor G3 NPU. Představil také „Assistant with Bard“, který bude některé interakce časem zpracovávat přímo v zařízení. Google zdůraznil, že Pixel 8 zvládne 2× více modelů přímo v zařízení než Pixel 6, a to modely mnohem sofistikovanější Blog. Jinými slovy, obrovský skok za pouhé dva roky vývoje čipů Tensor.

- Partnerství Qualcomm–Meta (červenec 2023): Qualcomm a Meta oznámili, že optimalizují velký jazykový model Meta Llama 2 pro běh zcela na Snapdragon NPUs do roku 2024 Iconnect007. Cílem je umožnit vývojářům nasazovat chatboty a generativní AI aplikace na telefonech, VR headsetech, PC atd., bez cloudu. Šlo o významné potvrzení on-device AI ze strany hlavního vlastníka AI modelu (Meta) a hlavního výrobce čipů. Koncem roku 2024 navázali plány na optimalizaci Llama 3 12 .

- Microsoft Windows 11 „Copilot“ PC (2024): Microsoft stanovil měřítko, kdy PC s >40 TOPS lokální AI akcelerace označil za „AI PC“ způsobilé pro rozšířené AI funkce (například integraci digitálního asistenta Copilot). To přimělo výrobce – Lenovo, Dell atd. – nasazovat čipy s NPU (ať už Intel, AMD, nebo Qualcomm), aby splnili specifikaci. Výsledkem je očekávaná vlna notebooků s AI v roce 2024, přičemž Microsoft tvrdí, že je na cestě desítky modelů a předpovídá přes 40 milionů dodaných AI PC v roce 2024 13 .

- Stručné NPU Ryzen 8000 od AMD (leden 2024): AMD oznámilo desktopový procesor s ohromujícím NPU o výkonu 39 TOPS (překvapení, protože desktopové čipy obvykle takové akcelerátory nemají) Pcworld. Ačkoli byl tento konkrétní produkt rychle nahrazen, ukázal, že i desktopové CPU mohou mít AI čipy, které v TOPS konkurují mobilním čipům. Šlo také o první desktopový x86 procesor s NPU (těsně předstihl Intel Arrow Lake).

- Ukázky Tesla FSD Beta v12 (konec 2023): Elon Musk předvedl end-to-end AI řízení (bez radaru, pouze vision nets) běžící na NPU Tesla HW3/HW4. Pozoruhodné bylo, že neuronová síť řídila auto pomocí video vstupů zpracovávaných v reálném čase přímo v počítači vozu. Pozorovatelé uvedli, že FSD v12 plně využíval 2× 100 TOPS NPU pro zpracování obrazu a Tesla naznačila, že budoucí upgrady (HW5) s cílem dosáhnout 2000 TOPS mohou být ve vývoji pro ještě větší modely (objevily se zvěsti, že HW5 by mohl mířit na 2 petaFLOPS = 2000 TOPS) 14 .

- Představení NVIDIA Drive Thor (GTC 2024): NVIDIA odhalila detaily svého dalšího automobilového čipu Drive Thor, který nabízí ekvivalent 2× AI výkonu svého předchůdce Orin – až 2000 TOPS při propojení dvou čipů ts2.tech. Významné je, že Thor je určen nejen pro řízení, ale i pro palubní AI (například hlasové ovládání a monitoring posádky) na jedné platformě, což ukazuje, jak NPU a GPU mohou společně konsolidovat mnoho AI funkcí v autech ts2.tech. Několik výrobců aut (Xpeng, BYD, Volvo) oznámilo, že Thor začnou používat od roku 2025 15 .

- Oppo a on-device MoE AI (říjen 2024): Jak již bylo zmíněno, Oppo implementovalo Mixture-of-Experts model v telefonu Find X8 Grandviewresearch. To je zajímavé, protože MoE modely jsou obvykle velké a byly považovány za serverové kvůli své složitosti. Běh MoE přímo na zařízení naznačuje nové techniky komprese modelů a velmi schopné NPU (pravděpodobně MediaTek Dimensity 9400 v tomto zařízení).

- Meta Ray-Ban AI brýle (2025): (Očekávané) Meta předvedla prototypy chytrých brýlí, které dokážou rozpoznat, co vidíte, a mluvit s vámi o tom – pravděpodobně s využitím vlastního akcelerátoru na palubě (Meta vyvíjí vlastní čipy pro AR). I když jsou detaily skromné, ukazuje to na snahu dostat AI do velmi omezených zařízení (brýle, bezdrátová sluchátka), což by vyžadovalo ultra-efektivní NPU.

- MLPerf Mobile Inference Benchmarks (2023–24): MLCommons zveřejnil výsledky ukazující schopnosti AI v nejnovějších smartphonech. Například v MLPerf Inference v3.0 (říjen 2023) byly Apple A16, Google Tensor G2 a Qualcomm Gen 2 testovány na úlohách jako klasifikace obrázků a detekce objektů. Výsledky ukázaly, že Apple a Qualcomm si navzájem přebírají vítězství, ale obecně se mobilní NPU přibližují některým akcelerátorům třídy notebooků/stolních počítačů pro tyto úlohy – a to vše na baterii. Také to zdůraznilo softwarové rozdíly (např. Qualcomm AI SDK vs. Apple Core ML). Průběžná zlepšení každý rok (dvouciferné % nárůsty) v těchto benchmarcích ukazují zdravou konkurenci a rychlý pokrok v AI na zařízení.

- Strategická partnerství: Vzniklo mnoho mezisektorových partnerství. Např. NVIDIA a MediaTek (květen 2023) oznámily spolupráci na integraci Nvidia GPU IP a softwarového ekosystému do budoucích čipů MediaTek pro smartphony a automobily, což v podstatě spojuje AI sílu Nvidie s odborností MediaTeku na mobilní SoC. Také společnosti jako Qualcomm spolupracují s automobilkami (Mercedes, BMW) na integraci platforem Snapdragon Cockpit a Ride (s NPU) do nových vozidel pro AI funkce. Arm spolupracuje s Fujitsu a dalšími na nových návrzích AI čipů (například AI část superpočítače Fugaku, i když to je high-end). Dokonce i IBM a Samsung představily nové čipové technologie (například neuromorfní výpočty a AI paměť), které by jednoho dne mohly revolucionalizovat NPU – zatím tu nejsou, ale ukazují, že výzkumné pipeline jsou plné.

Celkově byl uplynulý rok nabytý novinkami, což podtrhuje, že AI na zařízení je jednou z nejžhavějších oblastí v technologiích. Jak poznamenal jeden analytik, „tyto schopnosti na zařízení otevírají zcela nové obzory… provozování LLM na mobilu pomáhá řešit škálování a náklady, udržuje data v soukromí a zajišťuje, že AI funguje i při omezeném připojení“ Futurumgroup. To v podstatě shrnuje, proč zde investuje každá velká technologická firma.

Názory expertů: Co říkají technologičtí lídři o AI na zařízení

Dynamika kolem NPU a TPU je patrná nejen v produktech, ale i ve slovech lídrů v oboru. Zde je několik vybraných citací a pohledů, které objasňují význam AI na zařízení:

- Cristiano Amon (CEO společnosti Qualcomm): „Pokud má mít AI skutečný dosah, uvidíte ji běžet na zařízeních… Toto je zlomový bod v AI: žádné problémy s latencí – jen plynulé, bezpečné, cloudem doplněné inferování přímo na zařízení. Budoucnost AI je osobní a začíná na vašem zařízení.“ (rozhovor pro Bloomberg a příspěvek na X, 2023) X. Amon si představuje hybridní AI svět, kde váš telefon/PC zvládne mnoho úloh na vlastních NPU a spolupracuje s cloudem, když je to potřeba. Zdůrazňuje, že lokální provoz AI je klíčem k její všudypřítomnosti (nemůžete mít vše závislé na cloudových GPU – těch na světě není dost pro miliardy zařízení).

- Durga Malladi (SVP, Qualcomm): „Oceňujeme přístup společnosti Meta k otevřené a odpovědné AI… Aby bylo možné generativní AI efektivně rozšířit do hlavního proudu, bude muset běžet jak v cloudu, tak na zařízeních na okraji sítě.“ Iconnect007 Malladi to řekl v kontextu partnerství s Meta. Zdůrazňuje to běžný pohled: škálování AI = cloud + edge spolupracují. Nyní je jasné, že čistě cloudová AI nebude stačit (z důvodů nákladů, soukromí a latence), takže edge AI musí sdílet zátěž.

- Will Chen (zástupce ředitele, MediaTek): „Budoucnost AI přesahuje cloud; je poháněna edge computingem přímo z vaší ruky… OPPO a MediaTek jsou průkopníky AI na zařízení, zajišťují, že inteligentní schopnosti jsou výkonné, rychlé, soukromé, bezpečné a neustále dostupné.“ (MediaTek Exec Talk, 2025) Mediatek. Tento citát výstižně shrnuje hodnotu AI na zařízení – získáváte výkon a dostupnost plus soukromí a bezpečnost. Ukazuje také, že i firmy tradičně méně viditelné na Západě (jako MediaTek) přemýšlejí na špici nasazení AI.

- Dr. Norman Wang (expert na AI hardware, CEO startupu s čipy): „V AI hardwaru platí, že čím blíže můžete umístit výpočetní jednotku ke zdroji dat, tím lépe. Jde o minimalizaci pohybu dat. NPU vedle vašeho obrazového senzoru znamená, že neposíláte megapixely do cloudu – získáváte poznatky přímo na okraji. To je zásadní změna pro latenci a spotřebu energie.“ (Panel na HotChips 2024 – parafrázováno). Tento technický postřeh vysvětluje, proč NPU často sedí na stejném čipu jako ostatní komponenty: např. v SoC telefonu může NPU přímo získávat data z kamery od ISP. Minimalizace pohybu dat je zásadní pro efektivní AI a edge AI toho dosahuje zpracováním u zdroje dat.

- Xinzhou Wu (VP pro automobilový průmysl, NVIDIA): „Zrychlené výpočty vedly k transformačním průlomům, včetně generativní AI, která předefinovává autonomii a automobilový průmysl.“ (GTC 2024 Keynote) ts2.tech. Hovořil o tom, jak výkonné palubní počítače (s NPU/GPU) umožňují autům nejen řídit, ale potenciálně také začlenit pokročilou AI, jako jsou generativní modely pro věci jako rozhraní v přirozeném jazyce v autě nebo lepší porozumění situacím. Zdůrazňuje to, že i odvětví jako automobilový průmysl vnímají AI na zařízení nejen jako klíčovou funkci, ale také jako prostředek ke zlepšení uživatelského zážitku (např. hlasoví asistenti v autech, kteří díky palubním LLM dokážou vést konverzace).

- Sundar Pichai (CEO Google): „Budoucnost AI je o tom, aby byla užitečná pro každého. To znamená přinést AI do všech zařízení, která používáme – telefonů, spotřebičů, aut – aby byla k dispozici, když ji potřebujete. Chceme oslovit uživatele tam, kde jsou, s AI, která funguje v reálném čase, na místě a zachovává soukromí.“ (Parafrázováno z několika rozhovorů/klíčových projevů). Pichai často mluví o „ambientní AI“ – myšlence, že AI bude všude kolem nás, zabudovaná ve věcech. Snahy Googlu s čipy Tensor v telefonech Pixel jsou přímým naplněním této filozofie.

- Průmyslové statistiky: Analytici tento trend pozorují v číslech. Zpráva Grand View Research z roku 2024 uvádí: „Nedávné pokroky ve specializovaných AI čipech a NPU umožnily spouštět složité AI algoritmy přímo na zařízeních, což výrazně zvyšuje výkon a energetickou účinnost… blížíme se k zásadnímu přechodu směrem k AI na zařízení.“ Grandviewresearch. Stejná zpráva předpovídá, že trh s AI na zařízení v příštích letech exploduje, přičemž hardwarový segment (NPU atd.) bude v roce 2024 tvořit více než 60 % podílu na tržbách a dále poroste, protože téměř každé nové IoT nebo mobilní zařízení přijme AI schopnosti Grandviewresearch. Další prognóza od IDC a dalších naznačuje, že v polovině 20. let téměř všechny špičkové smartphony a většina střední třídy budou mít AI akcelerátory, a že do roku 2030 bude v provozu miliardy edge AI čipů od spotřební elektroniky po chytrou infrastrukturu.

Shoda mezi odborníky je, že AI na zařízení není jen příjemný bonus – je nezbytná pro další vlnu technologií. Průkopník AI Andrew Ng často zmiňuje, že „malá AI“ a edge AI umožní inteligenci proniknout do každého objektu, podobně jako dříve elektřina nebo internet. Překonáním omezení pouze cloudové AI umožňují NPU a TPU tento průnik.

Výzva mnoha standardů (a snahy o zjednodušení)

Zatímco hardware se rychle vyvíjí, ekosystém softwaru a standardů pro AI přímo na zařízení stále dohání. Vývojáři čelí džungli nástrojů a SDK při snaze využít NPU napříč různými zařízeními Nimbleedge. Klíčové body:- Každá platforma má své vlastní API nebo SDK: Apple má Core ML (s API pro cílení na Neural Engine), Android má Neural Networks API (NNAPI) (i když Google oznámil plány na jeho rozšíření za hranice Androidu 14) Threads, Qualcomm nabízí SNPE (Snapdragon Neural Processing Engine) nebo obecněji Qualcomm AI Stack, NVIDIA má TensorRT a CUDA pro svá zařízení a tak dále. Dále existuje ONNX Runtime, TensorFlow Lite, PyTorch Mobile, MediaTek NeuroPilot, Huawei HiAI a další. Tyto různé SDK často mají odlišné schopnosti a vyžadují úpravy modelu pro optimální běh na každém cílovém zařízení. Jak uvádí zpráva o AI na zařízeních z roku 2025, „Více nekompatibilních SDK (např. Core ML, LiteRT, ONNX Runtime) s různou podporou operátorů a výkonem“ nutí vývojáře k dodatečné práci 16 .

- Problémy s fragmentací: Model, který běží perfektně na desktopové GPU, nemusí snadno běžet na NPU telefonu – operátory (matematické funkce) nemusí být podporovány nebo je třeba je kvantizovat jinak. Vývojáři někdy musí udržovat samostatné buildy nebo ručně optimalizovat modely pro každý hardware. Toto je „nízkoúrovňový, fragmentovaný ekosystém“ stížnost Nimbleedge. Nástroje pro ladění jsou také vzácné – profilování NPU, abyste zjistili, proč je model pomalý, může být obtížné, zvláště ve srovnání s bohatými nástroji pro CPU/GPU 17 .

- Standardizační úsilí: Aby se toto vyřešilo, děje se několik věcí. ONNX (Open Neural Network Exchange) se objevil jako společný formát, takže můžete model natrénovat v PyTorch nebo TensorFlow a poté jej exportovat do ONNX pro nasazení. Mnoho runtime prostředí (včetně těch na zařízeních, jako jsou Qualcomm a MediaTek) podporuje načítání ONNX modelů a pokusí se je zkompilovat pro daný hardware. To pomáhá vyhnout se uzamčení na jeden framework. Android NNAPI byl pokus Googlu poskytnout univerzální rozhraní – aplikace může požádat „spusť tento neuronový síťový model“ přes NNAPI a operační systém použije jakýkoli dostupný akcelerátor (GPU, DSP nebo NPU) k jeho provedení. NNAPI byl přijat na mnoha Android zařízeních, ale měl omezení a ne všichni výrobci poskytli robustní ovladače, což vedlo Google k naznačení nové strategie (možná spoléhající na WebNN nebo přímé integrace výrobců) po roce 2024 Threads. Na PC Microsoft představil DirectML a Windows ML API, které podobně abstrahují rozdíly v hardwaru (umožňují vývojáři použít stejné API pro NVIDIA, Intel, AMD NPU).

- Sjednocené nástroje: Firmy také budují nástroje pro zjednodušení nasazení. Viděli jsme Qualcommův AI Stack, který kombinuje jejich kompilátor (AI Model Efficiency Toolkit) a runtime prostředí, takže vývojáři mohou snadněji cílit na jejich Hexagon NPU Iconnect007. NVIDIA TensorRT a související SDK dělají něco podobného pro zařízení Jetson, optimalizují modely pro GPU+NVDLA. Intel OpenVINO je další – umožňuje vzít model a optimalizovat jej pro Intel CPU, iGPU a VPU (NPU) pro edge nasazení. Tyto frameworky často zahrnují optimalizátory modelů, které převádějí modely (prořezávání, kvantizace), aby se vešly na menší zařízení.

- Interoperabilita: Dochází k posunu směrem k tomu, aby různé NPU fungovaly s běžnými frameworky. Například TensorFlow Lite od Googlu má hardwarové delegáty – jeden pro NNAPI (pokrývá obecně Android zařízení), jeden pro Core ML (iOS zařízení), jeden pro Edge TPU atd. Myšlenka je, že napíšete svůj TFLite model a ten se provede pomocí nejlepšího dostupného akcelerátoru přes delegáta. Podobně PyTorch přidává podporu pro mobilní backendy a dokonce i věci jako Apple’s Metal Performance Shaders (pro využití GPU/NPU na iOS). ONNX Runtime také může cílit na různé akcelerátory pomocí pluginů (například lze zapojit NVIDIA TensorRT nebo ARM Compute Library či jiné pod kapotou).

- Nově vznikající standardy:Khronos Group (za OpenGL/Vulkan) pracovala na NNEF (Neural Network Exchange Format) a diskutuje se o WebNN API pro prohlížeče, aby měly přístup k lokální AI akceleraci. Žádný z nich zatím není univerzálně přijat. Ale jeden zajímavý vývoj: na konci roku 2024 několik firem vytvořilo alianci na podporu standardů „AI Hardware Common Layer“ – v podstatě zkoumají, zda by bylo možné vytvořit společné nízkoúrovňové rozhraní pro NPU (podobně jako to udělal OpenCL pro výpočty na GPU). Je to ale zatím v počátcích.

- Zkušenost vývojářů: Je to uznávaná mezera. Jak uvedl blog NimbleEdge, „vývoj pro AI na zařízení v současnosti vyžaduje orientaci v roztříštěném a nízkoúrovňovém ekosystému… což nutí vývojáře přizpůsobovat implementace pro každý hardwarový cíl zvlášť“ Nimbleedge. Průmysl ví, že toto se musí zlepšit, aby se AI na zařízení skutečně stala mainstreamem. Můžeme očekávat konsolidaci – například pokud by se Google, Apple a Qualcomm dokázali dohodnout na nějaké základní sadě operací a API (možná zbožné přání). Pravděpodobnější ale je, že frameworky jako PyTorch a TensorFlow skryjí tuto složitost tím, že integrují všechny tyto knihovny od různých výrobců a vyberou tu správnou za běhu.

V podstatě, zatímco NPU/TPU poskytují „svaly“, komunita pracuje na nástrojích přívětivých pro mozek, jak tyto svaly využít. Dobrou zprávou je, že ve srovnání například s obdobím před pěti lety je dnes mnohem více možností, jak nasadit model na zařízení, aniž byste museli být odborníkem na čipy. Ale stále je prostor pro zlepšení – zejména v oblasti ladění, profilování a podpory více hardwarových platforem.

Trendy na trhu a výhled do budoucna

Rozmach NPU a TPU v zařízeních pohání větší trend: AI všude. Zde jsou některé hlavní trendy a co očekávat do budoucna:

- Růst trhu Edge AI: Průzkumy trhu ukazují na explozivní růst hardwaru pro edge AI. Trh s AI na zařízení (včetně čipů a softwaru) má podle projekcí růst tempem ~29 % CAGR v průběhu tohoto desetiletí Nimbleedge. Jedna zpráva jej v roce 2024 ocenila na přibližně 233 miliard dolarů, přičemž do roku 2032 má přesáhnout 1,7 bilionu dolarů Nimbleedge – velká část tohoto růstu bude tažena nasazením na okraji sítě. Další analýza od IDTechEx předpovídá, že trh s AI čipy pro edge zařízení dosáhne do roku 2034 hodnoty 22 miliard dolarů, přičemž největšími segmenty budou spotřební elektronika, automobilový průmysl a průmyslové aplikace Idtechex. To znamená, že stovky milionů zařízení ročně budou dodávány s NPU jako standardní součástí.

- Všudypřítomné přijetí: Podobně jako má dnes každý chytrý telefon GPU (i když malou), blížíme se bodu, kdy každý nový chytrý telefon bude mít AI akcelerátor. Špičkové telefony je mají už nyní; střední třída je na řadě. Opravdu, čipy střední třídy od Qualcommu (např. Snapdragon 7 série) a MediaTeku (Dimensity 700/800 série) nyní obsahují zmenšené NPU, takže funkce jako AI vylepšení fotoaparátu a hlasový asistent mohou fungovat i na levnějších zařízeních. Kromě telefonů se NPU rozšiřují do PC (standard v nových Windows noteboocích od více výrobců), aut (téměř všechna nová auta s ADAS Level 2+ mají nějaký AI čip) a IoT. Dokonce i spotřebiče jako ledničky a pračky začínají propagovat „AI“ funkce (některé jsou cloudové, ale některé lokální, například adaptivní cykly na základě senzorů). Trend je jasný: pokud má zařízení výpočetní čip, bude mít nějakou akceleraci ML na tomto čipu.

- Výkonnostní trajektorie: Výkon AI na zařízení se zdvojnásobuje zhruba každých 1–2 roky (kombinace lepší architektury a přechodu na pokročilé polovodičové technologie jako 5nm, 4nm, 3nm). Apple Neural Engine se posunul z 600 miliard operací/s v roce 2017 na 35 bilionů v roce 2023 – téměř 60× nárůst za šest let Fandom. Vlajkové lodě Qualcommu podobně poskočily z několika TOPS v roce 2018 na více než 27 TOPS v roce 2023 (celkový AI výkon SD 8 Gen 3, počítaje všechny jádra). Můžeme očekávat, že v letech 2025–2026 budou mobilní NPU dosahovat 100+ TOPS a PC akcelerátory ještě více, přičemž tyto hodnoty mohou být méně relevantní, protože se pozornost přesouvá na použitelný výkon pro konkrétní AI úlohy (například jak velký LLM můžete plynule spustit, nebo zda lze provádět 4K AI video v reálném čase). Rozdíl mezi cloudem a edge se pravděpodobně zúží pro inference úlohy. Nicméně edge bude stále zaostávat za cloudem u absolutně největších modelů kvůli omezením výkonu a paměti.

- Zisky v energetické efektivitě: Jedním z podceňovaných aspektů je, jak efektivní se NPU stávají. Tesla NPU v autě dosahuje ~4,9 TOPS/Watt Wikichip, což bylo před pár lety špičkové; nyní některé mobilní NPU tvrdí podobné nebo lepší hodnoty. Efektivní NPU znamenají delší výdrž baterie, i když používáme AI funkce více. Znamená to také, že je možné dát AI do malých zařízení na baterie (např. AI naslouchátka, chytré senzory na knoflíkovou baterii provádějící detekci anomálií). Koncept TinyML – extrémně malého strojového učení na mikrokontrolérech – je rozšířením tohoto, využívající zjednodušené „NPU“ nebo optimalizované instrukce na mikrokontrolérech pro AI v senzorech. ARM Ethos-U NPU je zaměřen na tento segment (např. always-on rozpoznávání klíčových slov běžící na pár miliwattech). Očekávejte více AI-specifických malých čipů, které lze zabudovat do senzorů, nositelné elektroniky a běžných předmětů (chytrý kartáček na zuby? AI detektor kouře? Blíží se to).

- Hybridní cloud-edge řešení: Místo toho, aby edge zcela nahradil cloud, budoucnost je v jejich spolupráci. Zařízení budou zpracovávat, co zvládnou lokálně, a na cloud se obrátí jen v případě, že něco nezvládnou. Například vaše AR brýle mohou lokálně rozpoznávat scénu, abyste věděli, na co se díváte, ale pokud položíte velmi složitou otázku (například podrobný výklad), mohou se dotázat cloudové AI na výkonnější analýzu a pak ji zobrazit. Tento hybridní přístup nabízí nejlepší rovnováhu mezi rychlostí odezvy a schopnostmi. Firmy aktivně navrhují zážitky kolem tohoto modelu: Copilot od Microsoftu ve Windows může využívat lokální NPU pro rychlý převod hlasu na text a rozpoznání příkazů, ale pro náročnější úlohy použije cloud (pokud tedy nemáte výkonné PC NPU, které to zvládne samo). Uživatel by ideálně neměl poznat ani řešit, co se používá – jen že je vše rychlejší a respektuje soukromí. Také uvidíme, jak se federované učení stává běžnějším – modely se trénují v cloudu, ale s pomocí dat šifrovaných nebo zpracovaných na zařízeních, a naopak.

- Nové případy použití: Jak budou NPUs výkonnější, otevřou se nové aplikace. Generativní AI přímo na zařízení je velké téma – představte si tvorbu obrázků AI, úpravy videa pomocí AI a osobní chatboty přímo ve vašem telefonu nebo notebooku. Do roku 2025 bychom mohli vidět první verze offline osobních asistentů, kteří dokážou shrnout vaše e-maily nebo napsat zprávy bez cloudu. Překlad řeči v reálném čase při konverzaci (dva lidé mluvící různými jazyky, telefony nebo sluchátka překládají téměř okamžitě) bude díky zpracování na zařízení výrazně lepší (bez zpoždění a funguje kdekoliv). Zdravotní AI může běžet na nositelných zařízeních – vaše chytré hodinky detekují fibrilaci síní nebo analyzují vzorce spánkové apnoe pomocí svého NPU. Bezpečnost: zařízení mohou lokálně spouštět AI pro detekci malwaru nebo phishingu v reálném čase (například antivir používající AI model přímo na zařízení místo cloudových skenů). A ve vozidlech, kromě řízení, může AI personalizovat zážitek v autě (například upravit klimatizaci podle vaší nálady rozpoznané kamerou zaměřenou na řidiče atd.). Mnoho těchto případů použití vyžaduje rychlou iteraci a soukromí, což vyhovuje zpracování na zařízení.

- Konkurenční boj a demokratizace: Velcí hráči budou dál soutěžit, což je pro spotřebitele dobré – očekávejte marketing typu „náš AI čip zvládne X TOPS nebo umožní Y funkci, kterou ostatní neumí“. Ale technologie se také demokratizuje – NPU nejsou jen v telefonech za 1000 dolarů; přicházejí do telefonů za 300 dolarů, na IoT desky za 50 dolarů (Coral, Arduino Portenta atd.) a open-source komunity vytvářejí malé AI modely, které si nadšenci spustí na Raspberry Pi nebo mikrokontroléru se základním akcelerátorem. Tato široká dostupnost znamená, že inovace může přijít odkudkoliv. Jediný vývojář nyní může vytvořit aplikaci, která využívá AI na zařízení k něčemu chytrému, aniž by potřeboval serverovnu – snižuje se tak vstupní bariéra pro software poháněný AI.

- Budoucí technologie: Při pohledu dále do budoucnosti by výzkum v oblasti neuromorfního výpočetnictví (čipy inspirované mozkem, jako je Intel Loihi) a analogových AI čipů mohl jednoho dne zcela změnit NPUs a nabídnout mnohonásobné zvýšení efektivity. Společnosti jako IBM a BrainChip na tom pracují. Pokud budou úspěšné, neuromorfní čip by mohl umožnit běh složité AI na malých bateriových zařízeních nepřetržitě. Můžeme také očekávat 3D stohování a nové paměťové technologie integrované do NPU, aby se překonaly paměťové limity (některé čipy po roce 2025 mohou používat HBM paměť nebo novou nevolatilní paměť přímo na čipu pro rychlejší zásobování AI jader). Také očekávejte větší specializaci uvnitř AI čipů: např. samostatné akcelerátory pro vidění, pro řeč, pro doporučovací modely atd., každý optimalizovaný pro svou oblast. Některé SoC už mají dvojité NPU (jedno „velké“ NPU pro náročné úlohy, jedno mikro NPU v senzorovém hubu pro stále zapnuté lehké úlohy).

Závěrem je směr jasný: NPU a TPU se stávají stejně standardními a nepostradatelnými jako CPU v moderním výpočetnictví. Umožňují zařízením být chytřejší, pohotovější a více dbát na naše soukromí. Jak uvádí jedna zpráva, „vysoce výkonné procesorové jednotky v zařízeních jsou z velké části zodpovědné za provádění složitých AI funkcí, jako je rozpoznávání obrazu, NLP a rozhodování v reálném čase“, a to pohání chytřejší a pohotovější technologie napříč sektory 18 .

Vstupujeme do éry, kdy budete jednoduše očekávat, že vaše zařízení pochopí a předvídá vaše potřeby – váš telefon upravuje fotky a píše zprávy ve vašem stylu, vaše auto se vyhýbá nehodám a baví vás pomocí AI, vaše domácí zařízení se učí vaše preference – to vše umožňují tiché neuronové procesory uvnitř nich. AI přímo na zařízení není sci-fi; je tu už teď a rychle se zlepšuje. Spojení NPU a TPU s našimi každodenními zařízeními dělá AI osobní, všudypřítomnou a soukromou – skutečně přináší sílu cloudové inteligence na zem (nebo alespoň do vaší kapsy).

Zdroje:

- Bigelow, Stephen. „GPUs vs. TPUs vs. NPUs: Porovnání hardwarových možností pro AI.“ TechTarget, 27. srpna 2024 Techtarget. Popisuje role a rozdíly CPU, GPU, TPU a NPU v AI úlohách.

- Backblaze Blog. „AI 101: GPU vs. TPU vs. NPU.“ Backblaze, 2023 Backblaze. Vysvětlení návrhu TPU od Googlu (systolická pole, nízká přesnost) a využití NPU v mobilních zařízeních.

- TechTarget WhatIs. „Tensor processing unit (TPU).“ whatis.techtarget.com, 2023 Techtarget. Uvádí, že TPU se specializují na úlohy maticové matematiky a NPU napodobují mozkové neuronové sítě pro akceleraci 19 .

- NimbleEdge Blog (Neeraj Poddar). „Stav AI na zařízení: Co v dnešní krajině chybí.“ 26. června 2025 Nimbleedge. Popisuje výhody AI na zařízení (latence, offline, soukromí, náklady) a výzvy jako roztříštěné SDK.

- Qualcomm (OnQ Blog). „Bloomberg a Cristiano Amon o AI na zařízení.“ červenec 2023 X. CEO Qualcommu o důležitosti inference na zařízení pro budoucnost AI (citace tweetu o zlomovém bodu v AI).

- MediaTek Blog (Exec Talk by Will Chen). „Formování budoucnosti AI mobilních zážitků.“ 3. března 2025 Mediatek. Spolupráce MediaTek a Oppo na NPU; citace o edge computingu ve vaší ruce a příklad AI remasteringu fotografií pomocí NPU.

- I-Connect007 / Qualcomm Press. „Qualcomm spolupracuje s Meta na umožnění AI na zařízení (Llama 2).“ 24. července 2023 Iconnect007. Tisková zpráva s citací SVP Qualcommu Durgy Malladiho o škálování generativní AI prostřednictvím edge zařízení a cloudu.

- PCWorld (Mark Hachman). „Intelovy procesory Core Ultra udržují AI jednoduchou….“ 24. října 2024 Pcworld. Diskutuje Intel Arrow Lake využívající NPU z Meteor Lake (13 TOPS) a zmiňuje AMD Ryzen 8000 s 39 TOPS NPU a požadavek Microsoftu na 40 TOPS pro „Copilot“.

- Ts2 (Tech Empowerment). „Souboj superpočítačů pro autonomní řízení: NVIDIA Thor vs Tesla HW4 vs Qualcomm Ride.“ září 2023 ts2.tech. Uvádí odhady TOPS: Tesla HW3 vs HW4 (72→100 TOPS na čip) ts2.tech, NVIDIA Thor ~1000 TOPS (nebo 2000 s duálním) ts2.tech a cituje viceprezidenta NVIDIA ohledně generativní AI ve vozidlech 20 .

- Grand View Research. „Zpráva o trhu s AI na zařízeních, 2030.“ 2024 Grandviewresearch. Zmiňuje nárůst specializovaných AI čipů (NPU), které umožňují komplexní AI na zařízeních, a že hardware tvořil v roce 2024 60,4 % trhu s AI na zařízeních, poháněného smartphony, IoT, NPU atd.

- Google Blog. „Google Tensor G3: AI-první procesor Pixelu 8.“ říjen 2023 Blog. Popisuje vylepšení Tensor G3 pro generativní AI na zařízení, nový design TPU a model TTS na zařízení s kvalitou datového centra.

- Techspot. „Snapdragon 8 Gen 3 přináší generativní AI do smartphonů.“ říjen 2023 Futurumgroup. Analýza Futurum Group podrobně popisuje AI engine SD8Gen3: 10B parametrů LLM na zařízení, o 98 % rychlejší NPU, nejrychlejší Stable Diffusion na telefonu na světě atd., plus výhody LLM na zařízení pro náklady/soukromí/offline 21 .

- Apple Wiki (Fandom). „Neural Engine.“ Aktualizováno 2025 Fandom. Historie verzí Neural Engine s A17 Pro 35 TOPS v roce 2023 atd. Ukazuje vývoj od 0,6 TOPS (A11) po 35 TOPS (A17) Fandom a M4 s 38 TOPS 22 .

- EnGenius Tech. „Cloud Edge Camera AI Surveillance.“ 2023 Engeniustech. Příklad bezpečnostní kamery s vestavěným NPU umožňujícím AI zpracování přímo v kameře a lokální ukládání (není potřeba NVR).

- EmbedL. „Amazon uvádí AZ1 Neural Edge Processor.“ Říjen 2020 Embedl. Diskutuje o edge NPU AZ1 od Amazonu pro zařízení Echo, vyvinutém s MediaTek, určeném pro inference řeči přímo na zařízení ke snížení latence a závislosti na cloudu 23 .