- Apple startede med on-device AI i 2017 med iPhone A11’s Neural Engine, som muliggjorde Face ID og Animoji med op til 600 milliarder operationer/sek.

- I 2023 leverede iPhone A17 Pro’s 16-core Neural Engine omkring 35 TOPS, hvilket driver on-device tale-, foto- og oversættelsesfunktioner.

- Google Pixel 8 (2023) bruger Tensor G3 NPU til at køre on-device AI-modeller som Palm 2 til offline oversættelse og opsummering.

- Googles Edge TPU på Coral Dev Board leverer 4 TOPS billedbehandling ved få watt.

- Teslas Full Self-Driving hardware har to NPU’er: HW3 (2019) tilbød omkring 144 TOPS, og HW4 (2023) omkring 200–250 TOPS.

- NVIDIA Drive Thor (præsenteret 2024) kan nå op til 2000 TOPS, når to chips forbindes til AI-opgaver i biler.

- Qualcomm’s Snapdragon 8 Gen 3 (2023) Hexagon NPU er 98% hurtigere end Gen 2, kan køre LLM’er op til 10 milliarder parametre on-device, og opnåede verdens hurtigste mobile Stable Diffusion i demonstrationer.

- MediaTeks Dimensity 9400 (2024) med sjette-generations APU driver Oppo Find X8 AI-fotoforbedring og signalerer, at NPU’er udvides til tv, IoT og biler inden 2025.

- Intels Meteor Lake, 14. generations Core (lanceret 2023; omdøbt til Core Ultra i 2024), inkluderer en integreret NPU, der leverer omkring 8–12 TOPS, med Arrow Lake på ~13 TOPS og Lunar Lake rygtes til omkring 45 TOPS.

- AMD’s Ryzen 7040 Phoenix (2023) introducerede Ryzen AI Engine med op til 10 TOPS, mens Ryzen 8000 desktop (tidlig 2024) tilbød 39 TOPS, før AMD satte NPU’er på pause i den generation.

Kort fortalt: Din smartphone, dit kamera og endda din bil får indbyggede AI-hjerner – ingen cloud nødvendig. Særlige chips kaldet NPU’er (Neural Processing Units) og TPU’er (Tensor Processing Units) forvandler hverdagens enheder til intelligente assistenter, der kan ansigtsgenkende, forstå stemmekommandoer, oversætte i realtid, muliggøre selvkørende funktioner og meget mere. Denne on-device AI-revolution lover lynhurtige svar, bedre privatliv og nye funktioner, vi før kun troede var mulige med supercomputere. I denne rapport vil vi afmystificere NPU’er og TPU’er, se hvordan de adskiller sig fra CPU’er/GPU’er, og undersøge hvorfor teknologigiganter som Apple, Google, Qualcomm og Intel kæmper for at putte disse “AI-hjerner” i alt fra telefoner til biler. Vi fremhæver også de nyeste gennembrud 2024–2025, ekspertindsigter, industristandarder og hvad fremtiden bringer for on-device AI.

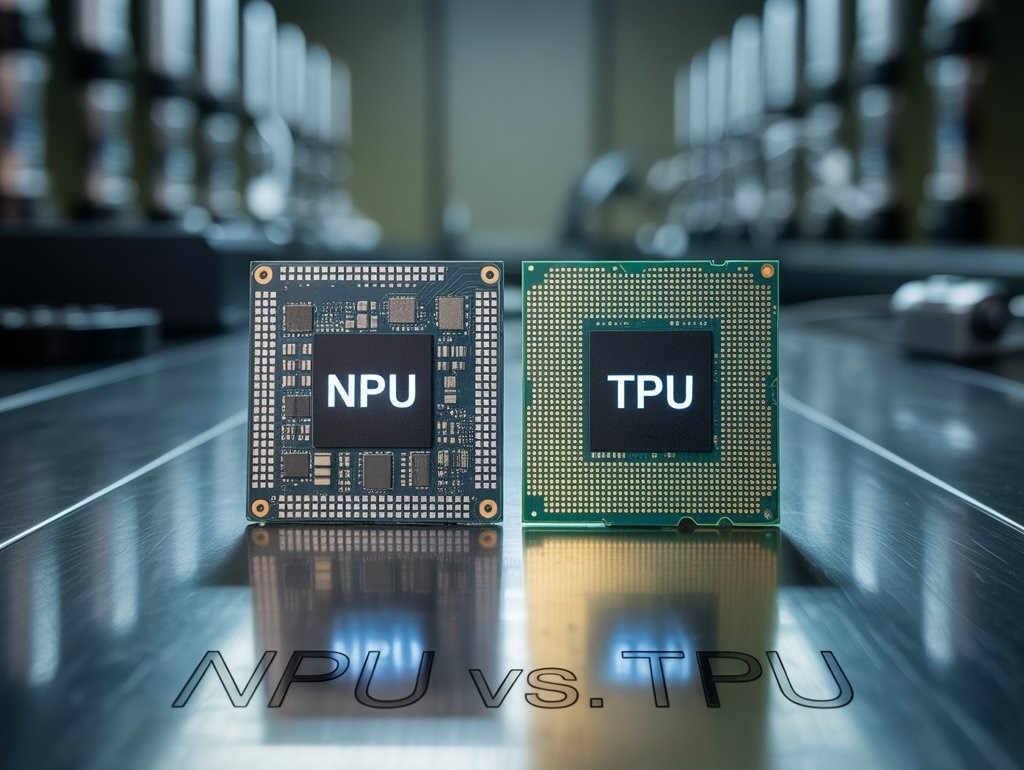

Hvad er NPU’er og TPU’er? (Mød din enheds AI-hjerne)

Neurale behandlingsenheder (NPUs) er specialiserede processorer designet til at accelerere kunstige neurale netværk – de algoritmer, der driver moderne AI-opgaver som billedgenkendelse, talebehandling og mere. I modsætning til generelle CPU’er er NPUs application-specific integrated circuits (ASICs), der er optimeret til matrixberegninger og de tunge parallelle arbejdsbyrder i neurale netværk Techtarget. En NPU “imiterer de neurale netværk i en menneskelig hjerne for at accelerere AI-opgaver” og fungerer i bund og grund som en silicon brain inde i din enhed Techtarget. NPUs er særligt gode til at køre inferens (at lave forudsigelser) for AI-modeller effektivt på enheden, ofte ved at bruge lavere numerisk præcision (f.eks. 8-bit heltal) for at spare strøm, mens de stadig leverer høj ydeevne Backblaze. Udtrykket “NPU” bruges nogle gange bredt om enhver AI-accelerator, men det refererer oftere til dem i mobile og edge-enheder Backblaze. For eksempel er Apples “Neural Engine” i iPhones og Samsungs mobile AI-motor NPUs, der er integreret i deres system-on-chip (SoC) designs.

Tensor Processing Units (TPU’er), på den anden side, blev udviklet af Google som specialdesignede chips til at accelerere maskinlæring, især til TensorFlow-rammeværket. En TPU er en type ASIC, der er optimeret til tensoroperationer (matrixmultiplikationer osv.), som er kernen i træning og inferens af neurale netværk Backblaze. Google implementerede først TPU’er i sine datacentre i 2015 for at fremskynde beregninger med neurale netværk, og gjorde dem senere tilgængelige via Google Cloud Backblaze. TPU’er bruger en særlig arkitektur kaldet en systolisk array, som forbinder mange små behandlingsenheder i et gitter, der pumper data gennem en kæde af matrix-multiplikationsenheder Backblaze. Dette design opnår ekstrem gennemstrømning på deep learning-opgaver. Googles TPU’er ofrer bevidst noget præcision (ved at bruge 8-bit eller 16-bit matematik i stedet for 32-bit floats) for enorme hastigheds- og effektivitetsgevinster Backblaze, da mange AI-opgaver ikke kræver høj præcision for at give nøjagtige resultater. Selvom “TPU” teknisk set refererer til Googles chips, bruges udtrykket nogle gange mere generisk om enhver “tensor”-accelerator. Bemærk, at Google også producerer Edge TPU co-processorer til AI direkte på enheden i produkter som Coral Dev Board, der leverer 4 billioner operationer pr. sekund på få watt 1 .

Kort sagt: NPU’er og TPU’er er begge siliciumacceleratorer til AI, men NPU’er er ofte indbygget i mobile/enhedsnære apparater for effektiv inference direkte på enheden, mens TPU’er (i snæver forstand) har været højtydende chips (og nu moduler) primært fra Google, oprindeligt til cloud/datacenter-træning og -inference opgaver. Begge adskiller sig fra traditionelle CPU/GPU-designs for at prioritere parallelle matematiske operationer til neurale netværk. Som en teknologiredaktør udtrykte det, “TPU’er tager specialiseringen endnu længere og fokuserer på tensoroperationer for at opnå højere hastigheder og energieffektivitet… NPU’er er udbredte i AI-aktiverede enheder som smartphones og IoT-gadgets” 2 .

Hvordan adskiller NPU’er og TPU’er sig fra CPU’er og GPU’er?

Traditionelle CPU’er (centralenheder) er “hjernen” i generel databehandling – optimeret til fleksibilitet, så de kan håndtere alle slags opgaver, fra at køre dit operativsystem til at surfe på nettet. De har nogle få kraftfulde kerner, der er fremragende til sekventiel logik og varierede instruktioner, men de er ikke gode til den stærkt parallelle matematiske behandling, der kræves til deep learning Techtarget. Når en CPU bliver bedt om at behandle et stort neuralt netværk, bliver den ofte en flaskehals, da den forsøger at udføre millioner af multiplikationer og additioner i rækkefølge eller i begrænsede parallelle batches. Dette fører til høj latenstid og strømforbrug (den såkaldte Von Neumann-flaskehals ved at flytte store mængder data mellem CPU og hukommelse) Backblaze. CPU’er kan udføre noget AI-arbejde (især enklere eller mindre modeller, eller kontrol-logik for AI-programmer Techtarget), men som hovedregel har de svært ved effektivt at skalere til moderne AI’s krav om massiv parallel lineær algebra.

GPU’er (grafikprocessorer) bragte parallel databehandling i front. Oprindeligt lavet til at gengive billeder ved at udføre mange simple operationer parallelt på pixels og hjørner, viste GPU’er sig at være velegnede til at træne neurale netværk, som også involverer at anvende de samme matematiske operationer (prikprodukter osv.) på store mængder data samtidigt Techtarget. En GPU indeholder hundredvis eller tusindvis af små kerner, der kan udføre matematik parallelt. Dette gør GPU’er fremragende til storskala AI, og gennem 2010’erne blev GPU’er (især NVIDIA’s med CUDA-software) arbejdshesten i deep learning-forskning. Dog er GPU’er stadig forholdsvis generelle – de skal håndtere forskellige grafikopgaver og bevare fleksibilitet, så de er ikke 100% optimeret til neurale netværk. De bruger også meget strøm og kræver omhyggelig programmering for at blive udnyttet fuldt ud (de bryder sig ikke om kompleks forgrenet kode og trives bedst med strømlinede, dataparellelle opgaver) 3 .

NPU’er og TPU’er tager specialiseringen endnu længere. De er specialbygget til kun neurale netværks arbejdsbyrder. Det betyder, at deres arkitektur kan fjerne alt, der ikke er nødvendigt for AI-matematik, og dedikere mere silicium til ting som matrix-multiplikationsenheder, akkumuleringsaddere og on-chip hukommelse til hurtigt at flytte data ind og ud af disse matematiske enheder. En Google Cloud TPU er for eksempel i bund og grund et kæmpe 2D-array af MAC (multiply-accumulate) enheder med en smart dataflow-arkitektur (det systoliske array), der fodrer dem med operander i høj hastighed Backblaze. Den beskæftiger sig ikke med caches, spekulativ eksekvering eller andre CPU-funktioner – den er optimeret til matrix-matematik. NPU’er i mobile chips integrerer på lignende vis dedikerede neural engine cores ved siden af CPU/GPU. Disse kerner bruger ofte lavpræcisionsaritmetik (f.eks. 8-bit heltal som TPU’er) og udfører meget parallelle “lag for lag”-beregninger til ting som konvolutionsneuronale netværk. En NPU kan bruge en “fusioneret” arkitektur, der kombinerer skalar-, vektor- og tensorenheder (Qualcomms Hexagon NPU gør dette) for effektivt at håndtere forskellige neurale netværksoperationer 4 .

De vigtigste forskelle handler om:

- Instruktionssæt og fleksibilitet: CPU’er har et bredt, generelt instruktionssæt (kan gøre mange ting, men ikke alle på én gang). GPU’er har et mere begrænset, men stadig fleksibelt instruktionssæt optimeret til gennemløb på matematik. NPU’er/TPU’er har et meget snævert instruktionssæt – i bund og grund kun de operationer, der er nødvendige for neurale netværk (matrix-multiplikation, konvolution, aktiveringsfunktioner), ofte implementeret som faste pipelines eller arrays Wikichip. For eksempel har Teslas selvkørende NPU kun 8 instruktioner i sin ISA, fokuseret på DMA-læsninger/-skrivninger og prikprodukt 5 .

- Parallelisme og kerner: CPU’er = nogle få kraftfulde kerner; GPU’er = tusindvis af simple kerner; NPU’er/TPU’er = på en måde, tititusinder af meget simple ALU’er (MAC-enhederne) struktureret i en matrix- eller neuralt netværksmønster. En enkelt NPU-chip kan udføre tititusinder af milliarder operationer per sekund – Teslas bil-NPU kører ved 2 GHz med 9.216 MACs og opnår ~37 tera-operationer per sekund (TOPS) per kerne, og hver FSD-chip har to NPU’er for ~74 TOPS Wikichip, ts2.tech. Til sammenligning kan en high-end CPU kun nå et par hundrede milliarder operationer/sek. på AI-opgaver, og en GPU måske et par TOPS hvis ikke der bruges specielle tensor-kerner.

- Hukommelsesarkitektur: NPU’er/TPU’er er afhængige af hurtig on-chip hukommelse og streaming af data. TPU’er undgår den klassiske hukommelsesflaskehals ved at bruge systolisk dataflow – hver lille enhed sender data videre til den næste i takt, hvilket minimerer læsninger/skrivninger til hovedhukommelsen Backblaze. Mange NPU’er inkluderer stykker af SRAM on-chip til vægte/aktiveringer (f.eks. har Teslas NPU-kerner 32 MB SRAM hver til at holde neurale netværksdata lokalt) Semianalysis. Dette står i kontrast til GPU’er/CPU’er, som bruger ekstern DRAM i stor stil.

- Præcision: CPU’er/GPU’er bruger normalt 32-bit eller 64-bit floats til beregninger. AI-acceleratorer bruger ofte 16-bit eller 8-bit heltal (og nogle undersøger nu 4-bit eller endda 2-bit), fordi neurale netværk tåler lavere præcision. Googles TPU-designere bemærkede eksplicit, at man ikke behøver fuld float-præcision til inferens, analogt med “du behøver ikke vide præcis hvor mange regndråber der falder for at vide, at det regner kraftigt” Backblaze. Dette gør det muligt for NPU’er/TPU’er at udføre flere operationer parallelt og bruge mindre energi per operation.

- Anvendelsesområder: GPU’er bruges stadig bredt til træning af store modeller og til fleksibel databehandling (og de er almindelige i datacentre og high-end PC’er). TPU’er (cloud) sigter mod storskala træning og inferens i Googles økosystem. NPU’er findes oftere i edge-enheder – smartphones, kameraer, apparater – der udfører inferens på allerede trænede modeller. De udmærker sig i opgaver som at anvende en visionsmodel på et kamerabillede i realtid eller køre stemmeassistentens wake-word-detektion kontinuerligt ved lavt strømforbrug. Som TechTarget bemærkede: “GPU’er vælges for tilgængelighed og omkostningseffektivitet i mange ML-projekter; TPU’er er normalt hurtigere og mindre præcise, bruges af virksomheder på Google Cloud; NPU’er findes ofte i edge/mobile enheder for markant hurtigere lokal behandling” 6 .

Sammenfattende: CPU’er = alsidige organisatorer, GPU’er = parallelle arbejdsheste, TPU’er/NPU’er = neurale netværksspecialister. Alle kan samarbejde – faktisk koordinerer CPU’en ofte opgaverne i en moderne AI-aktiveret enhed og sender de tunge beregninger videre til NPU/GPU efter behov Techtarget. Denne specialiseringstendens eksisterer, fordi én løsning ikke længere passer til alle i databehandling: som en redaktør bemærkede, “at tilføje millioner flere transistorer til ethvert behov var ikke godt for effektiviteten… designerne tog specialbyggede processorer til sig” Techtarget. Specialbyggede NPU’er og TPU’er fremskynder AI-beregninger drastisk, mens strømforbruget holdes lavt – en kritisk balance for både batteridrevne enheder og høj-densitets servere.

Hvorfor On-Device AI? (Edge vs. Cloud)

Hvorfor overhovedet køre AI på din telefon eller bil – hvorfor ikke bare sende det hele til skyen, hvor kæmpe servere (med GPU’er/TPU’er) kan klare det tunge arbejde? Der er flere overbevisende grunde til skiftet til on-device AI, og de handler om hastighed, privatliv, omkostninger og pålidelighed 7 :

- Øjeblikkelig respons (lav latenstid): En NPU i enheden kan behandle data i realtid uden den forsinkelse, det giver at sende data til en cloud-server. Dette er afgørende for interaktive eller sikkerhedskritiske AI-opgaver. For eksempel kan et bils autonome køresystem med indbyggede NPU’er identificere en fodgænger og bremse øjeblikkeligt, inden for millisekunder, i stedet for at vente på cloud-beregning. Et smart kamera med en NPU kan opdage en indtrænger i det øjeblik, de dukker op i billedet. På din telefon betyder on-device AI, at din stemmeassistent kan svare hurtigere og mere naturligt, fordi den ikke konstant “ringer hjem.” Reduceret latenstid muliggør ægte realtidsbeslutninger og en mere gnidningsfri brugeroplevelse 7 .

- Privatliv og datasikkerhed: AI på enheden holder dine data lokale. I stedet for at streame din mikrofonlyd eller kamerafeed til skyen for analyse, foregår behandlingen på selve enheden. Dette mindsker i høj grad eksponeringen af følsomme data. For eksempel udfører moderne smartphones ansigtsgenkendelse (Face ID osv.) udelukkende på enheden – dit ansigts biometriske kort forlader aldrig telefonens sikre område. På samme måde kan et AI-høreapparat eller et sundhedswearable analysere biometriske data uden at uploade dem til nogen server, hvilket bevarer privatlivet. I betragtning af voksende brugerbekymringer og reguleringer om datasuverænitet er dette en stor fordel. Som en edge AI-blog formulerede det, betyder behandling på enheden, at “brugerdata ikke behøver at blive overført til skyen,” hvilket giver en grundlæggende privatlivsfordel Nimbleedge. (Selvfølgelig er privatliv ikke automatisk – udviklere skal stadig håndtere lagrede data omhyggeligt – men det er nemmere at stole på enheder, der ikke konstant sender dine oplysninger ud.) Tech-CEO’er fremhæver ofte denne vinkel. Qualcomms CEO Cristiano Amon bemærkede, at kombinationen af cloud og intelligens på enheden kan forbedre personalisering samtidig med at data holdes sikre på enheden – han kalder det en “hybrid fremtid”, hvor AI på enheden samarbejder med cloud-AI for det bedste fra begge verdener 8 .

- Offline tilgængelighed & pålidelighed: Enheder med NPU’er/TPU’er er ikke afhængige af forbindelse. De kan fungere i en metrotunnel, i et fly, i fjerntliggende landområder eller under netværksudfald. Dette er afgørende for pålidelighed. En stemmediktatfunktion på enheden vil stadig virke uden signal. En drone med ombord vision-AI kan undgå forhindringer selv uden forbindelse. Denne uafhængighed er også kritisk for missionkritiske systemer: f.eks. katastrofehjælpsrobotter eller medicinsk udstyr, der ikke kan forudsætte en aktiv internetforbindelse. “Offline-funktionalitet” er en kernefordel ved AI på enheden Nimbleedge – det sikrer, at AI-funktionen er tilgængelig, når og hvor der er brug for den.

- Omkostningseffektivitet i stor skala: Konstant at sende rådata til skyen for AI-behandling kan være meget dyrt (cloud-computing er ikke gratis) og båndbreddekrævende. Efterhånden som AI-funktioner udbredes, ville virksomheder skulle betale enorme cloud-behandlingsregninger, hvis hver lille opgave ramte en server. Ved at gøre mere på kanten reducerer de belastningen på cloud-servere og netværksforbruget. Det er ofte mere effektivt at bruge et par ekstra dollars på en bedre chip i enheden end at betale for gigabyte af cloud-computing over enhedens levetid. En Futurum-brancheanalyse bemærkede, at behandling på enheden hjælper med at løse generativ AI’s skalerings- og omkostningsproblemer – det “fordeler” belastningen, så datacentre ikke overvældes (og brugere/udviklere ikke betaler i dyre domme for cloud-GPU-tid) 9 .

- Personalisering & kontekst: En ny fremvoksende grund: AI på enheden kan lære af og tilpasse sig lokal kontekst på en måde, som cloud-AI måske ikke kan. Din smartphone kan vedligeholde en lille lokal model, der lærer din sms-stil for bedre autokorrektur, uden at dele den personlige sprogmodel med skyen. Enheder kan sammenflette data fra flere sensorer i realtid (noget, der er lettere at gøre lokalt end at streame en masse sensorfeeds til skyen). Dette kan muliggøre en mere personlig og kontekstbevidst oplevelse. Nogle funktioner som federated learning gør det endda muligt for enheder at forbedre AI-modeller i fællesskab uden at uploade rådata (kun sende små vægtopdateringer tilbage).

- Regulering og datasuverænitet: Love som Europas GDPR og forskellige krav om datalokalisering kræver i stigende grad, at visse data (især personlige eller følsomme data) ikke sendes ud af landet eller til tredjepart uden samtykke. AI på enheden tilbyder en måde at overholde dette ved at behandle data ved kilden. For eksempel kan AI-værktøjer til medicinsk billedbehandling køre på hospitalets hardware (edge-servere med NPU’er), så patientdata aldrig forlader matriklen, hvilket imødekommer privatlivsregler. NimbleEdge’s rapport fra 2025 påpeger, at regeringer presser på for mere lokal inferens af hensyn til suverænitet og overholdelse 10 .

Alle disse faktorer driver et paradigmeskifte: I stedet for at tænke “cloud-first” for AI, designer virksomheder nu AI-funktioner “device-first”, når det er muligt. Som Qualcomms AI VP, Durga Malladi, opsummerede: “For effektivt at skalere generativ AI til mainstream, skal AI køre både i skyen og på enheder i kanten… såsom smartphones, laptops, køretøjer og IoT-enheder” Iconnect007. Vi bevæger os mod en hybrid AI-verden, hvor tung træning og store modeller måske lever i skyen, men mange inferensopgaver og personlige AI-oplevelser kører lokalt på NPU’er/TPU’er i dine hænder og hjem. Faktisk kalder Amon det et “vendepunkt for AI” – on-device inferens uden latenstid, hvor “fremtiden for AI er personlig”, fordi den kører lige der, hvor du er 11 .

AI på enheden i praksis: Fra smartphones til selvkørende biler

Specialiserede AI-chips er allerede indlejret i en lang række enheder omkring dig og gør dem ofte usynligt smartere. Her er nogle af de vigtigste områder, hvor NPU’er og edge-TPU’er er i brug:

- Smartphones & Tablets: Næsten alle moderne flagskibstelefoner (og endda mange mellemklassemodeller) har nu en NPU eller dedikeret AI-motor. Apple startede trenden i 2017 med Apple Neural Engine i iPhones A11-chip, hvilket muliggjorde Face ID og Animoji direkte på enheden ved at udføre op til 600 milliarder operationer/sek Fandom. I dag har Apples A17 Pro-chip (2023) en 16-kernet Neural Engine, der kan udføre 35 billioner operationer pr. sekund Fandom. Dette driver funktioner som avanceret kamerascenedetektion, fotostile, Siri-stemmestyring behandlet offline, autokorrektur, live transskription og endda kørsel af transformer-modeller til oversættelse direkte på enheden. Googles Pixel-telefoner har ligeledes specialudviklet hardware (“Google Tensor” SoC’er) med NPUs: den nyeste Tensor G3 i Pixel 8 blev “specialdesignet til at køre Googles AI-modeller”, hvor alle chipdelene (CPU, GPU, ISP) er opgraderet for at bane vejen for generativ AI på enheden Blog. Pixel 8 kan køre Googles avancerede tekst-til-tale- og oversættelsesmodeller lokalt, de samme som tidligere kun fandtes i datacentre Blog. Den udfører også komplekse kamerafunktioner som “Best Take” gruppefotofletning og Audio Magic Eraser ved hjælp af en række AI-modeller direkte på enheden Blog. Samsung og andre Android-producenter bruger Qualcomms Snapdragon-chipsæt, hvis nyeste NPUs (Hexagon AI-motor) endda kan køre store sprogmodeller på telefonen – Qualcomm har demonstreret kørsel af en 10 milliarder-parameter LLM og endda Stable Diffusion-billedgenerering på en telefon med Snapdragon 8 Gen 3 Futurumgroup. Denne chips AI-motor er 98% hurtigere end forrige generation og understøtter INT4-præcision for effektivitet Futurumgroup. Den praktiske konsekvens: din 2024-telefon kan gøre ting som at opsummere artikler, besvare spørgsmål eller redigere fotos med AI uden at skulle bruge skyen. Selv tilgængelighedsfunktioner får fordele: f.eks. har Pixel-telefoner nu stemmetastatur, live-undertekster og en kommende funktion til at beskrive billeder for blinde brugere ved hjælp af en lokal model.

- Smarthkameraer & sikkerhedssystemer: AI-aktiverede kameraer bruger indbyggede NPU’er til øjeblikkeligt at registrere personer, ansigter, dyr eller mistænkelig adfærd. For eksempel inkluderer EnGenius’ nyeste sikkerhedskameraer en indbygget NPU, der håndterer objektdetektion og konverterer video til metadata direkte på kameraet, hvilket eliminerer behovet for en separat videooptager og øger sikkerheden (da video kan analyseres og lagres lokalt) Engeniustech. Det betyder, at dit sikkerhedskamera kan afgøre “person til stede” eller “pakke leveret” og kun sende den pågældende alarm, i stedet for at streame timers optagelser til en cloud-tjeneste. Ligeledes havde forbrugerenheder som Google Nest Cam IQ en visionschip på enheden (Google Edge TPU) til at genkende kendte ansigter og skelne mellem mennesker og kæledyr i synsfeltet. DSLR- og spejlløse kameraer tilføjer også AI-processorer til ting som motivsporing, øje-autofokus og sceneoptimering i realtid. I droner hjælper indbyggede AI-chips med forhindringsundgåelse og visuel navigation uden behov for fjernstyring. Bemærkelsesværdigt er Googles Edge TPU (et lille ASIC-modul) blevet et populært tilføjelsesmodul til gør-det-selv- og industrielle IoT-kameraer – det leverer 4 TOPS af visionsbehandlingskraft til opgaver som at detektere personer eller aflæse nummerplader, mens det kun bruger ~2 watt 1 .

- Smarthjem & IoT-enheder: Ud over telefoner har mange smarthjemsapparater små NPU’er. Stemmeaktiverede højttalere (Amazon Echo, Google Nest Hub osv.) inkluderer nu ofte lokale talegenkendelseschips. Amazon udviklede AZ1 Neural Edge-processor til Echo-enhederne for at fremskynde Alexas aktiveringsord-genkendelse og svar på enheden, hvilket halverer svartiden Embedl. AZ1 (bygget med MediaTek) kører et neuralt netværk, der genkender “Alexa” og behandler simple kommandoer uden at kontakte skyen Embedl. Dette gør ikke kun Alexa hurtigere, men holder også flere stemmedata private. Ligeledes har mange nye tv, apparater og endda legetøj noget AI ved kanten – f.eks. kan et smart køleskabs kamera identificere madvarer og udløbsdatoer lokalt. Wearables fortjener også omtale: Apple Watch’s S9-chip tilføjede en 4-core Neural Engine for bedre at håndtere sundheds-AI-algoritmer og Siri-forespørgsler direkte på uret Fandom. Og på den industrielle side kan IoT-sensorer med NPU’er udføre anomali-detektion på udstyrsdata direkte ved kanten og kun markere relevante hændelser opstrøms (hvilket sparer båndbredde og reagerer hurtigere på problemer).

- Automobiler (ADAS og autonomi): Biler er blevet AI-hubs på hjul. Avancerede førerassistentsystemer (ADAS) og selvkørende funktioner er afhængige af en række indbyggede AI-acceleratorer til at fortolke kamerafeeds, LiDAR, radar og træffe kørselsbeslutninger på et splitsekund. Tesla designede berømt sin egen FSD (Full Self-Driving) Computer med to NPU-chips. Teslas FSD-chip (HW3, introduceret i 2019) leverede 144 TOPS (to NPU’er på 72 TOPS hver); den nyere HW4 (2023) øger det til cirka 200–250 TOPS i alt (to 7nm NPU’er på omkring 100+ TOPS hver) ts2.tech. Dette gør det muligt for bilen at behandle video i fuld opløsning fra 8 kameraer, sonar osv. samtidigt gennem neurale netværk til perception og endda køre nogle sprogmodeller til stemmekommandoer – alt sammen lokalt i bilens modul. Konkurrerende platforme som NVIDIA Drive og Qualcomm Snapdragon Ride integrerer også NPU’er. NVIDIAs nyeste supercomputer-chip til biler, Drive Thor, planlagt til biler i 2025, kan prale af op til 1.000 TOPS på en enkelt chip (og 2.000 TOPS når to parres) for at understøtte Level 4 autonomi ts2.tech. Den kombinerer en GPU, CPU og dedikerede deep learning accelerators så den kan håndtere alt fra vejskiltegenkendelse til førerovervågnings-AI på chippen ts2.tech. Disse NPU’er er bogstaveligt talt livreddende: en autonom bil kan ikke vente på cloud-servere, hvis et barn løber ud på vejen. Indbygget AI skal se og reagere inden for få tiendedel af et sekund. Uden for personbiler finder du også stor brug af edge AI i autonome droner, leveringsrobotter og industrielle køretøjer, som navigerer og træffer beslutninger med indbyggede NPU’er/TPU’er (for eksempel bruger Nuros leveringsrobotter og mange selvkørende lastbilsystemer NVIDIA- eller Huawei-AI-chips på enheden).

- Edge Computing & Industri: I fabrikker og virksomhedsmiljøer tager on-device AI ofte form af edge-servere eller gateways med AI-acceleratorer. I stedet for at sende kamerafeeds eller sensordata til en central cloud, installerer virksomheder edge-bokse (nogle gange GPU-baserede, nogle gange NPU/FPGA-baserede) på stedet. Disse håndterer opgaver som realtids videoanalyse til kvalitetskontrol på en produktionslinje, hvor defekter opdages med AI-vision på få mikrosekunder. Sundhedsudstyr er et andet eksempel: et bærbart ultralyds- eller MRI-apparat kan have en NPU til at udføre AI-billedanalyse direkte på enheden, så læger får øjeblikkelig diagnostisk hjælp uden behov for internetforbindelse (hvilket også er bedre for patientdatas privatliv). Detailhandel og byer anvender også AI på kanten – f.eks. smarte trafikkameraer med NPU’er til at analysere trængsel og justere lys, eller detailhyldekameraer der overvåger lagerbeholdning. Mange af disse bruger specialiserede NPU’er som Intel Movidius Myriad chips eller Googles Edge TPU eller nye aktører som Hailo-8 (en israelsk NPU, der leverer 26 TOPS på få watt til kameraer). Den røde tråd er, at disse acceleratorer muliggør analyse lokalt, hvilket giver realtidsresultater og kun sender overordnede indsigter (i stedet for rådata) over netværkene.

Alsidigheden af NPU’er/TPU’er på tværs af enhedstyper er imponerende. Det ene øjeblik muliggør de, at din telefon kan sløre baggrunden i et foto med AI, og det næste guider de en drone eller scanner medicinske billeder. Smartphone-kameraer bruger nu NPU’er til funktioner som Night Mode (intelligent sammensætning af flere billeder), portrættilstand bokeh, scenegenkendelse (din telefon ved, at du tager et “solnedgangs”-billede og optimerer farver via AI), og endda til sjove AR-effekter (Animoji, der kortlægger dit ansigt, eller Snapchat-filtre, der følger dine bevægelser – alt sammen takket være neurale netværk på enheden). Biometri bruger NPU’er: fingeraftryksscannere forbedret med AI til liveness-detektion, ansigtsoplåsning med dybdesensorer plus AI. Lyd bruger dem også: støjreduktion i øretelefoner og telefoner er nu ofte AI-drevet, hvor NPU’er adskiller stemme fra baggrundsstøj i realtid.

Et konkret eksempel på innovation i 2024: Oppo (smartphone-producenten) annoncerede i samarbejde med MediaTek, at de implementerede en Mixture-of-Experts (MoE) AI-model direkte på enheden i slutningen af 2024 – angiveligt de første til at gøre det i en telefon Grandviewresearch. Denne avancerede neurale netværksarkitektur (MoE) kan øge ydeevnen ved kun at aktivere relevante “ekspert”-delnetværk pr. opgave, og at gøre dette på enheden betyder, at Oppo-telefoner kan opnå hurtigere AI-behandling og bedre energieffektivitet for komplekse opgaver uden behov for cloud-assistance Grandviewresearch. Det understreger, hvordan selv banebrydende AI-forskning hurtigt finder vej til vores håndholdte enheder via forbedrede NPU’er.

Inde i 2025’s AI-chips: Seneste udvikling fra Apple, Google, Qualcomm og flere

Kapløbet om at bygge bedre on-device AI-hardware er hurtigt blevet intensiveret. Her er et kig på, hvad store virksomheder for nylig har lanceret (2024–2025) inden for NPU’er/TPU’er og AI-silicium:

- Apple: Apples strategi med specialudviklet silikone har længe lagt vægt på maskinlæring direkte på enheden. Hvert år er Apples Neural Engine blevet mere kraftfuld. I 2023’s iPhone 15 Pro nåede A17 Pro-chipens Neural Engine op på 35 TOPS (billioner operationer per sekund) med sine 16 kerner Fandom. Dette var dobbelt så meget rå gennemstrømning som A16’s NPU, og Apple brugte det til at muliggøre ting som talegenkendelse på enheden for Siri (endelig behandling af mange Siri-forespørgsler uden internet) og nye kamerafunktioner (som automatisk optagelse af Portræt-tilstand og live-oversættelse af tekst via kameraet). Apples chips fra 2024 fortsatte denne tendens: M3-familien til Macs (sidst i 2023) fik en opdateret Neural Engine (dog interessant nok indstillet til 18 TOPS for M3-basischippen, med fokus på effektivitet) Fandom. I 2024 introducerede Apple M4-chippen (til high-end iPads/Macs, midt 2024), som angiveligt hævede Neural Engine til 38 TOPS på en forbedret 3nm-proces Fandom. Ud over blot tal har Apple brugt denne NPU: funktioner som Personal Voice (som skaber en klon af brugerens stemme efter 15 minutters træning) kører privat på Neural Engine i iPhones, og Live Voicemail-transskriberinger sker lokalt. Apple har også integreret NPU’er i alle deres enhedsklasser – selv AirPods Pro har en lille neural chip til Adaptive Audio. Apples ledere fremhæver ofte privatlivsaspektet: “maskinlæring på din enhed” betyder, at dine data forbliver hos dig. I 2025 forventer vi, at Apples Neural Engine muligvis udvides yderligere eller bliver tilgængelig for tredjepartsapps på nye måder (allerede nu kan udviklere bruge den via Core ML, men Apple kunne åbne for mere neural API-adgang). Der går også rygter om, at Apple designer en selvstændig AI-accelerator til fremtidige briller eller biler, men nuværende produkter viser, at de foretrækker integrerede NPU’er i deres A-serie og M-serie SoC’er.

- Google: Google var ikke kun pioner inden for cloud TPU, men satsede også stort på on-device AI til Pixel-telefoner og forbrugerenheder. Google Tensor SoC (først introduceret i 2021 i Pixel 6) var unik, fordi Google, der er kendt for cloud, lavede en telefonchip til at køre AI på selve enheden. Med Tensor G3 (i 2023’s Pixel 8) fremhævede Google opgraderinger, der muliggør generativ AI på enheden. Google sagde eksplicit, at Pixel 8’s chip bringer “Google AI-forskning direkte til vores nyeste telefoner” Blog. Tensor G3’s næste generations TPU (Google kalder stadig AI-kernen for en “TPU” internt) gør det muligt for Pixel at køre avancerede modeller som Palm 2 eller Gemini Nano (slankede versioner af Googles store sprogmodeller) på enheden til funktioner som opsummering af hjemmesider eller forbedret stemmetastatur Reddit. En af de vigtigste funktioner: Pixel 8 kan køre Googles bedste tekst-til-tale-model (den, der bruges i datacenteret) lokalt, hvilket gør det muligt for telefonen at læse websider op med naturlige stemmer og endda oversætte dem i realtid, alt sammen offline Blog. Google bruger også TPU’en i Pixel til fotografering (“HDR+” billedbehandling med flere billeder, Magic Eraser objektfjernelse ved hjælp af AI inpainting Blog), til sikkerhed (ansigtsoplåsning på enheden via AI, nu vurderet stærk nok til betalinger Blog), og til tale (Assistenten, der ikke har noget imod, at du siger “øhm”). Ud over telefoner tilbyder Google Coral Dev Board og USB-stick til hobbyfolk og virksomheder, så de kan tilføje Edge TPU’er til deres projekter, hver med Googles Edge TPU, der leverer 4 TOPS til vision-opgaver ved meget lavt strømforbrug Coral. Den bruges i nogle af Googles egne produkter som Nest Hub Max til gestusgenkendelse. For Google er integration af TPU’er på kanten en del af en bredere strategi: Sundar Pichai (Googles CEO) har sagt, at AI’s fremtid handler om at forstærke enhver oplevelse, og det er tydeligt, at Google mener, at “for at bringe AI’s transformerende kraft til hverdagen, skal du kunne tilgå den fra den enhed, du bruger hver dag” Blog – deraf Tensor-chips. Vi kan forvente en Tensor G4 i Pixel-telefoner sidst i 2024, muligvis bygget på Samsungs eller TSMC’s nyere proces, hvilket yderligere forbedrer AI-ydelse og effektivitet, måske endda muliggør multimodal AI på enheden (kombinerer vision+sprogsmodeller).

- Qualcomm: Den førende leverandør af mobilchips til Android-telefoner har aggressivt promoveret sin AI Engine i Snapdragon-serien. Snapdragon 8 Gen 2 (sidst i 2022) introducerede dedikeret INT4-understøttelse og demonstrerede realtids billedgenerering med stable diffusion på en telefon. Snapdragon 8 Gen 3 (annonceret sidst i 2023, i 2024’s flagskibstelefoner) er et stort spring: Qualcomm siger, at deres Hexagon NPU er 98% hurtigere end Gen 2’s og 40% mere energieffektiv Futurumgroup. Denne chip kan køre store sprogmodeller med op til 10 milliarder parametre helt på enheden og behandle omkring 20 tokens per sekund – nok til simple samtaler med en AI-assistent uden brug af skyen Futurumgroup. Den opnåede også “verdens hurtigste Stable Diffusion” billedgenerering på en mobil enhed i demonstrationer Futurumgroup. Qualcomm har været tydelige om, at generativ AI på enheden er et vigtigt salgsargument for nye telefoner. For eksempel har de indgået partnerskab med Meta for at optimere den open source Llama 2 LLM til Snapdragon, med det mål at lade dig køre en chatbot-AI på din telefon i 2024 Iconnect007. (En Qualcomm-chef sagde: “vi bifalder Metas åbne tilgang… for at skalere generativ AI, skal det køre både i skyen og på kanten”, hvilket understreger edge AI-filosofien Iconnect007.) Ud over telefoner sætter Qualcomm NPUs i laptop-chips (Snapdragon compute-platformene til Windows på ARM) – og deres automotive platform Snapdragon Ride bruger de samme AI-kerner til at tilbyde op til 30 TOPS til ADAS, med en køreplan mod hundredvis af TOPS. I 2025 annoncerede Qualcomm endda en ny Snapdragon X Elite CPU til PC’er, der inkluderer en kraftig NPU, hvilket signalerer et mål om at udfordre Apple og Intel på AI-ydelse i personlige computere. Med fremkomsten af AI på enheden brander Qualcomm faktisk nogle telefoner som “AI-telefoner.” De forventer, at mange apps (fra fotografering til beskeder til produktivitet) vil udnytte NPU’en. På softwaresiden har Qualcomm udgivet Qualcomm AI Stack for at samle understøttelsen af populære frameworks (TensorFlow Lite, PyTorch, ONNX) på deres NPUs Iconnect007 – for at gøre det nemmere for udviklere at bruge AI-hardwaren uden dyb chip-viden.

- MediaTek: Den næststørste producent af mobilchips (kendt for Dimensity-serien) har også opgraderet sine NPU’er. MediaTek kalder sine AI-motorer for “APU” (AI Processing Unit). For eksempel har Dimensity 9200+ (2023) en sjette-generations APU med markant bedre ydeevne end den forrige chip, hvilket muliggør funktioner som on-device stable diffusion og AI-støjreduktion i videoer. I 2024 annoncerede MediaTek Dimensity 9400, og i et partnerskab med Oppo udnyttede de den avancerede NPU-arkitektur til at introducere nye AI-funktioner (som nævnt er Oppo Find X8’s AI-fotoforbedring med fjernelse af refleksioner og opskarpning drevet af MediaTeks NPU) Mediatek. MediaTeks ledelse har eksplicit positioneret sig i fronten for on-device AI. Som Will Chen fra MediaTek udtrykte det, “fremtiden for AI rækker ud over skyen; den drives af edge computing direkte fra din håndflade.” Ifølge dem skal AI på telefoner være hurtig, privat, sikker og altid tilgængelig Mediatek. MediaTek har endda dannet et “APU-centreret” samarbejde med Meta for at understøtte Llama-frameworks og med producenter som Oppo og Xiaomi med fokus på AI-kamera og AI-stemmefunktioner. I 2025 planlægger MediaTek at udrulle disse NPU’er ikke kun i telefoner, men også i smarte TV’er (til AI-opskalering og billedforbedring), IoT-enheder, og endda biler (MediaTek har en AI-platform til biler og har indgået partnerskab med Nvidia om at integrere Nvidia GPU IP til biler, mens de formodentlig leverer deres egen NPU til sensor-AI).

- Intel: 2024 markerede Intels indtræden på markedet for AI-acceleratorer på almindelige PC’er. Intels 14. generations Core (Meteor Lake, lanceret december 2023 og omdøbt til Core Ultra i 2024) er den første x86 PC-processor med en indbygget neural processor-enhed (NPU). Meteor Lakes NPU (nogle gange kaldet VPU – Vision Processing Unit – baseret på Intels Movidius-teknologi) leverer omkring 8–12 TOPS AI-ydeevne Pcworld. Dette bruges til at accelerere Windows 11’s AI-funktioner som baggrundssløring, øjenkontakt i videosamtaler, og kan bruges af apps til ting som lokal transskription, støjreduktion eller endda små AI-assistenter. Microsoft og Intel har sammen promoveret konceptet om “AI PC.” Intel hævder, at disse NPU’er vil blive leveret i titusindvis af bærbare computere i 2024 Pcworld. Efter Meteor Lake nævner Intels køreplan Arrow Lake (til desktops i 2024), som også inkluderede en NPU (omkring 13 TOPS, en smule forbedret) Pcworld. Interessant nok blev Intels første forsøg på en desktop-NPU faktisk overgået af AMD (se nedenfor), og Intel valgte at gå med et beskedent NPU-design for at undgå at ofre GPU/CPU-areal i entusiast-chips Pcworld. Men i slutningen af 2024 signalerede Intel, at fremtidige Lunar Lake chips vil have en langt kraftigere NPU (~45 TOPS) for at opfylde Microsofts “Copilot”-krav Pcworld. Alt dette indikerer, at Intel ser AI som et must-have for PC’er fremover – ikke til at træne enorme modeller, men til at accelerere dagligdags AI-drevne oplevelser (fra forbedringer i kontorpakker til kreative værktøjer, der bruger lokal AI). Intel sælger også edge AI-acceleratorer som Intel Movidius Myriad chips (brugt i nogle droner, kameraer) og Habana acceleratorer til servere, men Meteor Lakes integrerede NPU er en milepæl, der bringer AI til den gennemsnitlige forbrugerenhed.

- AMD: AMD sprang ind i on-device AI omtrent på samme tid. Deres Ryzen 7040-serie laptop-processorer (Phoenix), udgivet i 2023, havde den første Ryzen AI Engine – i bund og grund en integreret XDNA NPU (teknologi fra AMD’s opkøb af Xilinx). Denne NPU leverede op til 10 TOPS på mobilchippen Wikipedia. AMD fremhævede brugsscenarier som AI-forbedrede videoopkald, produktivitetsapps osv., svarende til Intels mål. Derefter lancerede AMD kortvarigt en Ryzen 8000 desktop-serie (tidligt 2024) med en NPU, der nåede 39 TOPS – et meget højt tal for en AI-enhed i en generel CPU, endda højere end Intels planer Pcworld. Dog ændrede AMD hurtigt kurs og sprang en generation over, for at fokusere på deres næste arkitektur (den efterfølgende Ryzen 9000 i slutningen af 2024 droppede NPU’en for at prioritere kerneopgraderinger) Pcworld. Ikke desto mindre forventes det, at AMD bringer NPU’er tilbage i fremtidige PC-chips (det er sandsynligvis et midlertidigt tilbagetog, mens de arbejder på at integrere en stærk AI-motor uden at gå på kompromis med anden ydeevne). På produktsiden kan AMD’s NPU’er muliggøre interessante ting, da AMD også har stærke GPU’er – en kombination, der kan håndtere AI-arbejdsbyrder i fællesskab (nogle dele på NPU, nogle på GPU). AMD har også sat AI-kerner ind i deres adaptive (FPGA-baserede) SoC’er og automotive chips. Sammenfattende har alle x86 PC-chipproducenter i 2025 taget NPU’er til sig, i tråd med hvad smartphones gjorde for nogle år siden, hvilket indikerer at AI-acceleration er ved at blive en standardfunktion over hele linjen.

- Andre: En række specialiserede chipfirmaer og andre teknologivirksomheder innoverer også inden for NPU’er. NVIDIA, kendt for GPU’er, inkluderer nu dedikerede Tensor Cores i deres GPU’er og tilbyder et åbent NVDLA (deep learning accelerator) design til integration i System-on-Chip produkter. I edge-enheder som NVIDIA Jetson-serien (brugt i robotter, droner, indlejrede systemer) findes både GPU’en og faste “DLA’er” – i bund og grund NPU’er – der aflaster noget af den neurale netværksinference fra GPU’en. For eksempel har NVIDIAs Orin-modul 2 DLA’er ud over sin GPU, hvilket bidrager til dens 254 TOPS AI-ydelse til biler ts2.tech. Apple rygtes at arbejde på endnu mere avancerede AI-coprocessorer eller større neurale motorer til deres AR-briller eller fremtidige projekter, selvom detaljerne er hemmelige. Huawei (på trods af geopolitiske udfordringer) fortsætter med at designe Kirin-mobilchips med NPU’er (deres “DaVinci” NPU-arkitektur) og også server-klasse NPU’er i deres Ascend AI-chips – deres Kirin 9000S-chip fra 2023 siges at bevare en stærk NPU til billed- og sprogtasks på deres telefoner. Vi ser også startups som Hailo, Mythic, Graphcore og andre tilbyde deres egne edge AI-chips: f.eks. Hailo-8 som nævnt (26 TOPS i et mini PCIe-kort til AI-kameraer), Graphcores IPU til datacentre (ikke præcis on-device, men en ny arkitektur til neurale netværk), Mythic arbejder på analoge NPU’er osv. ARM, hvis designs ligger til grund for de fleste mobilchips, tilbyder Ethos NPU-serien (såsom Ethos-U, Ethos-N78), som chipproducenter kan integrere for at få en færdiglavet AI-accelerator i IoT- eller mellemklasse-SoC’er. Dette har gjort det muligt selv for relativt mindre aktører at inkludere NPU’er i deres chips ved at licensere ARMs design.

Bundlinjen er, at fra big tech til startups, alle investerer i on-device AI-silicium. Som resultat ser vi hurtige forbedringer: nye chips med højere TOPS, bedre effektivitet (TOPS per watt) og understøttelse af nye datatyper (som 4-bit kvantisering til større modeller). For eksempel kan Qualcomms og MediaTeks nyeste køre INT4-præcision, hvilket er godt til generative AI-modeller, hvor hukommelsesbåndbredde er en begrænsning Androidauthority. Disse innovationer giver direkte brugerfordele – f.eks. real-time mobil AI-video-redigering (fjerne objekter fra 4K-video i realtid, som Snapdragon 8 Gen 3 kan med sin “Video Object Eraser” AI-funktion Futurumgroup), eller AI-coprocessorer i biler, der muliggør stemmeassistenter, som fungerer uden netværk og svarer lige så hurtigt som en menneskelig samtale.

Vigtige nyheder fra 2024–2025: Lanceringer, benchmarks og partnerskaber

For at illustrere hvor hurtigt tingene bevæger sig, er her nogle overskriftsbegivenheder i NPU/TPU- og on-device AI-verdenen fra slutningen af 2024 og ind i 2025:

- Apple M3 og M4 lanceringer (okt 2023 & maj 2024): Bragte næste generations Neural Engines. M3’s Neural Engine klarer 18 TOPS (16-core), og M4 sprang til 38 TOPS (stadig 16-core, men med højere clock/effektivitet) Fandom. Apple demonstrerede disse chips håndtere krævende opgaver som on-device stable diffusion billedgenerering i macOS (med Core ML Stable Diffusion, viste udviklere ~15 sekunder for at generere et billede på en M2 – endnu hurtigere på M3/M4).

- Google Pixel 8 lancering (okt 2023): Fremhævede AI “overalt” i enheden. Googles event demonstrerede Pixel 8’s on-device opsummering af websider og live oversættelse af artikler ved hjælp af dens Tensor G3 NPU. Den introducerede også “Assistant with Bard”, som til sidst vil køre nogle interaktioner på enheden. Google fremhævede, at Pixel 8 kan køre 2× så mange modeller på enheden som Pixel 6 kunne, og modeller der er langt mere sofistikerede Blog. Med andre ord, et kæmpe spring på bare to år med Tensor chip udvikling.

- Qualcomm–Meta partnerskab (juli 2023): Qualcomm og Meta annoncerede, at de optimerer Metas Llama 2 large language model til at køre fuldt ud på Snapdragon NPUs inden 2024 Iconnect007. Målet er at gøre det muligt for udviklere at implementere chatbots og generative AI-apps på telefoner, VR-headsets, pc’er osv., uden cloud. Dette var en væsentlig opbakning til on-device AI fra en stor AI-model ejer (Meta) og en stor chipproducent. I slutningen af 2024 fulgte de op med planer om Llama 3 optimering også 12 .

- Microsoft Windows 11 “Copilot” pc’er (2024): Microsoft satte en standard ved at kalde pc’er med >40 TOPS lokal AI-acceleration for “AI-pc’er”, der er berettiget til forbedrede AI-funktioner (som Copilot digital assistent integration). Dette pressede OEM’er – Lenovo, Dell osv. – til at tage chips med NPUs i brug (uanset om det er Intel, AMD eller Qualcomm) for at opfylde specifikationen. Resultatet er en forventet bølge af AI-kompatible laptops i 2024, hvor Microsoft hævder, at snesevis af modeller er på vej og forudser over 40 millioner AI-pc-leverancer i 2024 13 .

- AMDs korte Ryzen 8000 NPU (jan 2024): AMD annoncerede en desktop-CPU med hele 39 TOPS NPU (en overraskelse, da desktop-chips normalt mangler sådanne acceleratorer) Pcworld. Selvom netop dette produkt hurtigt blev overhalet, viste det, at selv desktop-CPU’er kan have AI-silicium, der matcher mobile chips i TOPS. Dette var også den første desktop x86 CPU med en NPU (lige før Intel Arrow Lake nåede det samme).

- Tesla FSD Beta v12 (slutningen af 2023) demoer: Elon Musk fremviste end-to-end AI-kørsel (ingen radar, kun visionsnetværk) kørende på Teslas HW3/HW4 NPU’er. Bemærkelsesværdigt var det neurale netværk, der styrede bilen ved hjælp af videofeeds, som blev behandlet udelukkende på bilens computer i realtid. Observatører bemærkede, at FSD v12 udnyttede de 2× 100 TOPS NPU’er fuldt ud til vision, og Tesla antydede, at fremtidige opgraderinger (HW5) med op til 2000 TOPS kan være under udvikling for at håndtere endnu større modeller (der gik rygter om, at Teslas HW5 kunne sigte mod 2 petaFLOPS = 2000 TOPS) 14 .

- NVIDIA Drive Thor afsløret (2024 GTC): NVIDIA afslørede detaljer om deres næste automotive-chip, Drive Thor, der har tilsvarende 2× AI-beregningen af forgængeren Orin – op til 2000 TOPS når to chips forbindes ts2.tech. Væsentligt er det, at Thor er designet til ikke kun at håndtere køreopgaver, men også in-cabin AI (som stemme- og passagerovervågning) på én platform, hvilket viser, hvordan NPU’er og GPU’er sammen kan samle mange AI-funktioner i biler ts2.tech. Flere bilproducenter (Xpeng, BYD, Volvo) annoncerede, at de vil bruge Thor fra 2025 15 .

- Oppos on-device MoE AI (okt 2024): Som nævnt implementerede Oppo en Mixture-of-Experts-model på Find X8-telefonen Grandviewresearch. Dette er bemærkelsesværdigt, fordi MoE-modeller normalt er store og tidligere blev betragtet som server-side på grund af deres kompleksitet. At køre MoE on-device antyder nye teknikker i modelkomprimering og en meget kapabel NPU (sandsynligvis MediaTek Dimensity 9400 i den enhed).

- Metas Ray-Ban AI-briller (2025): (Forventet) Meta fremviste prototyper af smarte briller, der kan identificere det, du ser, og tale til dig om det – sandsynligvis ved hjælp af en indbygget specialaccelerator (Meta har eksperimenteret med specialudviklet silicium til AR). Selvom detaljerne er sparsomme, understreger det ønsket om at integrere AI i meget begrænsede enheder (briller, batteridrevne øretelefoner), hvilket nødvendiggør ultraeffektive NPU’er.

- MLPerf Mobile Inference Benchmarks (2023–24): MLCommons offentliggjorde resultater, der viser de nyeste smartphones’ AI-evner. For eksempel blev Apples A16, Google Tensor G2 og Qualcomm Gen 2 alle testet i MLPerf Inference v3.0 (oktober 2023) på opgaver som billedklassificering og objektdetektion. Tallene viste, at Apple og Qualcomm skiftedes til at vinde, men generelt at mobile NPU’er indhenter nogle laptop/desktop-klasse acceleratorer til disse opgaver – alt sammen på batteri. Det fremhævede også forskelle i software (f.eks. Qualcomms AI SDK vs. Apple Core ML). De fortsatte forbedringer hvert år (cifrede procentvise stigninger) i disse benchmarks demonstrerer den sunde konkurrence og hurtige fremgang inden for AI på enheden.

- Strategiske partnerskaber: Mange tværindustrielle partnerskaber er blevet dannet. F.eks. annoncerede NVIDIA og MediaTek (maj 2023) et samarbejde om at integrere Nvidia GPU IP og softwareøkosystem i MediaTeks fremtidige smartphone- og bilchips, hvilket reelt kombinerer Nvidias AI-styrker med MediaTeks ekspertise inden for mobile SoC’er. Derudover samarbejder virksomheder som Qualcomm med bilproducenter (Mercedes, BMW) om at integrere Snapdragon Cockpit og Ride-platforme (med NPU’er) i nye køretøjer for AI-funktioner. Arm har samarbejdet med Fujitsu og andre om nye AI-chipdesigns (som Fugaku-supercomputerens AI-partition, selvom det er high-end). Selv IBM og Samsung har teaset nye chipteknologier (som neuromorfisk computing og AI-hukommelse), der en dag kan revolutionere NPU’er – ikke klar endnu, men det viser, at forskningsrørledningen er fuld.

Alt i alt har det seneste år været fyldt med udvikling, hvilket understreger, at AI på enheden er et af de hotteste områder inden for teknologi. Som en brancheanalytiker bemærkede, “disse on-device-funktioner åbner helt nye horisonter… at køre LLM’er på mobilen hjælper med at håndtere skala og omkostninger, holder data private og sikrer, at AI fungerer selv med begrænset forbindelse” Futurumgroup. Det opsummerer ret godt, hvorfor alle store teknologivirksomheder investerer her.

Ekspertindsigt: Hvad teknologiledere siger om AI på enheden

Fremdriften bag NPU’er og TPU’er er ikke kun tydelig i produkterne, men også i udtalelser fra brancheledere. Her er nogle udvalgte citater og perspektiver, der belyser betydningen af AI på enheden:

- Cristiano Amon (CEO for Qualcomm): “Hvis AI skal opnå skala, vil du se det køre på enheder… Dette markerer et vendepunkt for AI: ingen latenstid — bare problemfri, sikker, cloud‐komplementær on-device inferens. Fremtiden for AI er personlig, og den starter på din enhed.” (Bloomberg-interview og X-opslag, 2023) X. Amon forestiller sig en hybrid AI-verden, hvor din telefon/PC klarer meget på sine egne NPU’er og arbejder sammen med skyen, når det er nødvendigt. Han understreger, at det er afgørende for udbredelsen af AI, at det kører lokalt (man kan ikke lade alt afhænge af cloud-GPU’er – der er ikke nok af dem i verden til milliarder af enheder).

- Durga Malladi (SVP, Qualcomm): “Vi bifalder Metas tilgang til åben og ansvarlig AI… For effektivt at skalere generativ AI til mainstream, skal AI køre både i skyen og på enheder i kanten.” Iconnect007 Malladi sagde dette i forbindelse med Meta-partnerskabet. Det fremhæver en fælles opfattelse: skalering af AI = sky + edge arbejder sammen. Der er nu en forståelse af, at ren cloud-AI ikke er tilstrækkelig (af hensyn til omkostninger, privatliv og latenstid), så edge AI skal dele byrden.

- Will Chen (Vicegeneraldirektør, MediaTek): “Fremtiden for AI rækker ud over skyen; den drives af edge computing direkte fra din håndflade… OPPO og MediaTek er pionerer inden for on-device AI og sikrer, at intelligente funktioner er kraftfulde, hurtige, private, sikre og altid tilgængelige.” (MediaTek Exec Talk, 2025) Mediatek. Dette citat opsummerer værdien af on-device AI – du får ydeevne og tilgængelighed plus privatliv og sikkerhed. Det viser også, at selv virksomheder, der traditionelt er mindre synlige i Vesten (som MediaTek), tænker på forkant med AI-udrulning.

- Dr. Norman Wang (AI-hardwareekspert, CEO for en chip-startup): “Inden for AI-hardware gælder det, at jo tættere du kan placere beregningen på datakilden, jo bedre. Det handler om at reducere databevægelse. En NPU ved siden af din billedsensor betyder, at du ikke sender megapixels til skyen – du udleder indsigter direkte ved kanten. Det er en game changer for latenstid og strømforbrug.” (Panel ved HotChips 2024 – parafraseret). Denne tekniske indsigt forklarer, hvorfor NPU’er ofte sidder på samme silicium som andre komponenter: f.eks. på en telefons SoC kan NPU’en hente kameradata direkte fra ISP’en. Minimering af databevægelse er en stor del af effektiv AI, og edge AI opnår dette ved at udføre behandling ved kilden til dataene.

- Xinzhou Wu (VP for Automotive, NVIDIA): “Accelereret databehandling har ført til transformative gennembrud, herunder generativ AI, som er ved at omdefinere autonomi og transportindustrien.” (GTC 2024 Keynote) ts2.tech. Han diskuterede, hvordan kraftfulde on-board computere (med NPU’er/GPU’er) gør det muligt for biler ikke kun at køre, men potentielt at inkorporere avanceret AI som generative modeller til f.eks. naturlige sproggrænseflader i bilen eller bedre situationsforståelse. Det understreger, at selv brancher som bilindustrien ser on-device AI ikke kun som kernefunktionalitet, men også som en måde at forbedre brugeroplevelsen på (f.eks. stemmeassistenter i biler, der kan føre samtaler takket være on-board LLM’er).

- Sundar Pichai (CEO for Google): “Fremtiden for AI handler om at gøre det nyttigt for alle. Det betyder at bringe AI ind i alle de enheder, vi bruger – telefoner, apparater, biler – så det er der, når du har brug for det. Vi vil møde brugerne, hvor de er, med AI, der fungerer i realtid, lokalt og bevarer privatlivet.” (Parafraseret fra flere interviews/keynotes). Pichai taler ofte om “ambient AI” – idéen om, at AI vil være overalt omkring os, indlejret i ting. Googles satsning med Tensor-chips i Pixels er en direkte udførelse af den filosofi.

- Branchetal: Analytikere har observeret tendensen i tal. En rapport fra Grand View Research i 2024 bemærkede: “Nye fremskridt inden for specialiserede AI-chips og NPU’er har gjort det muligt at køre komplekse AI-algoritmer direkte på enheder, hvilket markant forbedrer ydeevne og energieffektivitet… vi nærmer os en afgørende overgang mod on-device AI.” Grandviewresearch. Den samme rapport forudser, at on-device AI-markedet vil eksplodere i de kommende år, hvor hardwaresegmentet (NPU’er osv.) vil udgøre over 60% af omsætningen i 2024 og vokse, efterhånden som næsten alle nye IoT- eller mobile enheder får AI-funktioner Grandviewresearch. En anden prognose fra IDC og andre antyder, at i midten af 2020’erne vil næsten alle high-end smartphones og størstedelen af mellemklassemodellerne have AI-acceleratorer, og at der i 2030 vil være milliarder af edge AI-chips i brug fra forbrugerelektronik til smart infrastruktur.

Konsensus blandt eksperter er, at on-device AI ikke bare er rart at have – det er essentielt for den næste teknologibølge. AI-pioneren Andrew Ng har ofte nævnt, at “tiny AI” og edge AI vil gøre det muligt for intelligens at trænge ind i alle objekter, analogt med hvordan elektricitet eller internettet gjorde det i tidligere tider. Ved at overvinde begrænsningerne ved cloud-only AI muliggør NPU’er og TPU’er denne udbredelse.

Udfordringen med mange standarder (og bestræbelser på at forenkle)

Mens hardwaren har udviklet sig hurtigt, halter økosystemet af software og standarder til AI på enheden stadig bagefter. Udviklere står over for en jungle af værktøjer og SDK’er, når de forsøger at udnytte NPU’er på tværs af forskellige enheder Nimbleedge. Centrale pointer:- Hver platform har sin egen API eller SDK: Apple har Core ML (med API’er til at målrette Neural Engine), Android har Neural Networks API (NNAPI) (selvom Google har annonceret planer om at udvikle den ud over Android 14) Threads, Qualcomm tilbyder SNPE (Snapdragon Neural Processing Engine) eller bredere Qualcomm AI Stack, NVIDIA har TensorRT og CUDA til deres enheder, og så videre. Der er også ONNX Runtime, TensorFlow Lite, PyTorch Mobile, MediaTek NeuroPilot, Huawei HiAI og andre. Disse forskellige SDK’er har ofte forskellige funktioner og kræver modeltilpasning for at køre optimalt på hver platform. Som en rapport om AI på enheden fra 2025 bemærkede, “Flere, inkompatible SDK’er (f.eks. Core ML, LiteRT, ONNX Runtime) med varierende operator-understøttelse og ydeevne” tvinger udviklere til at lave ekstra arbejde 16 .

- Fragmenteringsproblemer: En model, der kører perfekt på et desktop-GPU, kører måske ikke umiddelbart på en telefons NPU – operatorer (de matematiske funktioner) understøttes måske ikke eller skal kvantiseres anderledes. Udviklere må nogle gange vedligeholde separate builds eller manuelt optimere modeller til hvert hardware. Dette er “det lav-niveau, fragmenterede økosystem”-klagen Nimbleedge. Debugging-værktøjer er også sparsomme – at profilere en NPU for at se, hvorfor en model er langsom, kan være svært, især sammenlignet med de rige værktøjer til CPU’er/GPU’er 17 .

- Standardiseringsindsats: For at tackle dette sker der flere ting. ONNX (Open Neural Network Exchange) er opstået som et fælles format, så du kan træne en model i PyTorch eller TensorFlow og derefter eksportere til ONNX til deployment. Mange runtimes (inklusive on-device som Qualcomms og MediaTeks) understøtter at indlæse ONNX-modeller og vil forsøge at kompilere dem til hardwaren. Dette hjælper med at undgå lock-in til et enkelt framework. Android NNAPI var et forsøg fra Google på at levere et universelt interface – en app kan anmode om “kør dette neurale netværk” via NNAPI, og operativsystemet vil bruge den accelerator, der er til stede (GPU, DSP eller NPU) til at udføre det. NNAPI blev taget i brug på mange Android-enheder, men det havde begrænsninger, og ikke alle leverandører leverede robuste drivere, hvilket fik Google til at indikere en ny strategi (muligvis med fokus på WebNN eller direkte leverandørintegrationer) efter 2024 Threads. På pc’er introducerede Microsoft DirectML og Windows ML API’er for på lignende vis at abstrahere hardwareforskelle (så en udvikler kan bruge samme API til NVIDIA, Intel, AMD NPUs).

- Forenede værktøjskæder: Virksomheder bygger også værktøjskæder for at strømline deployment. Vi så Qualcomms AI Stack, som kombinerer deres compiler (AI Model Efficiency Toolkit) og runtimes, så udviklere lettere kan målrette deres Hexagon NPU Iconnect007. NVIDIAs TensorRT og relaterede SDK’er gør noget lignende for Jetson-enheder, hvor de optimerer modeller til GPU+NVDLA. Intel OpenVINO er et andet eksempel – det lader dig tage en model og optimere den til Intel CPU’er, iGPU’er og VPU’er (NPU’er) til edge-deployment. Disse frameworks inkluderer ofte modeloptimeringsværktøjer, der konverterer modeller (beskæring, kvantisering) så de passer på mindre enheder.

- Interoperabilitet: Der er bevægelse mod at få forskellige NPU’er til at fungere med fælles frameworks. For eksempel har Googles TensorFlow Lite hardware-delegater – én til NNAPI (dækker Android-enheder generelt), én til Core ML (iOS-enheder), én til Edge TPU osv. Ideen er, at du skriver din TFLite-model, og den vil blive udført med den bedste accelerator tilgængelig via delegaten. Tilsvarende har PyTorch tilføjet understøttelse af mobile backends og endda ting som Apples Metal Performance Shaders (for at bruge GPU/NPU på iOS). ONNX Runtime kan også målrette forskellige acceleratorer via plugins (f.eks. kan man tilslutte NVIDIAs TensorRT eller ARMs Compute Library eller andre under motorhjelmen).

- Fremvoksende standarder:Khronos Group (bag OpenGL/Vulkan) arbejdede på NNEF (Neural Network Exchange Format), og der er WebNN API under diskussion, så browsere kan få adgang til lokal AI-acceleration. Ingen af dem er universelt adopteret endnu. Men en interessant udvikling: I slutningen af 2024 dannede flere virksomheder en alliance for at fremme “AI Hardware Common Layer”-standarder – grundlæggende for at undersøge, om et fælles lavniveau-interface til NPU’er kunne laves (analogt med hvordan OpenCL gjorde for compute på GPU’er). Det er dog tidligt endnu.

- Udvikleroplevelse: Det er et anerkendt hul. Som NimbleEdge’s blog sagde, “udvikling til AI på enheden kræver i øjeblikket, at man navigerer i et fragmenteret og lavt-niveau økosystem… hvilket tvinger udviklere til at tilpasse implementeringer til hver hardwareplatform” Nimbleedge. Branchen ved, at dette skal forbedres, for at AI på enheden for alvor kan blive mainstream. Vi kan måske se konsolidering – for eksempel, hvis Google, Apple og Qualcomm alle kunne blive enige om et kerne-sæt af operationer og API (måske ønsketænkning). Eller mere sandsynligt vil frameworks som PyTorch og TensorFlow skjule kompleksiteten ved at integrere alle disse leverandørbiblioteker og vælge det rigtige ved kørselstidspunktet.

I bund og grund, mens NPU’er/TPU’er leverer musklerne, arbejder fællesskabet på hjernevenlige værktøjer til at bruge de muskler. Den gode nyhed er, at der sammenlignet med for eksempel for fem år siden, er langt flere muligheder for at implementere en model på enheden uden at være chip-ekspert. Men der er plads til forbedring – især inden for fejlfinding, profilering og understøttelse af flere hardwaretyper.

Markedstendenser og fremtidsudsigter

Udbredelsen af NPU’er og TPU’er i enheder driver en større tendens: AI overalt. Her er nogle overordnede tendenser og hvad man kan forvente fremadrettet:

- Vækst på Edge AI-markedet: Markedsundersøgelser indikerer eksplosiv vækst i edge AI-hardware. Markedet for AI på enheden (inklusive chips og software) forventes at vokse med ca. 29% CAGR gennem årtiet Nimbleedge. En rapport vurderede det til ca. $233 milliarder i 2024, på vej mod over $1,7 billioner i 2032 Nimbleedge – meget af denne vækst drevet af edge-implementeringer. En anden analyse fra IDTechEx forudsagde, at AI-chipmarkedet for edge-enheder vil nå $22 milliarder i 2034, hvor forbrugerelektronik, bilindustrien og industrien er de største segmenter Idtechex. Dette indebærer hundredvis af millioner af enheder om året, der sendes med NPU’er som standardkomponent.

- Udbredt anvendelse: Ligesom alle smartphones i dag har en GPU (selv hvis den er lille), nærmer vi os det punkt, hvor hver ny smartphone vil have en AI-accelerator. High-end telefoner har dem allerede; mellemklasse-telefoner er de næste. Faktisk inkluderer mellemklasse-chips fra Qualcomm (f.eks. Snapdragon 7-serien) og MediaTek (Dimensity 700/800-serien) nu nedskalerede NPU’er, så funktioner som AI-kameraforbedringer og stemmeassistenter også kan fungere på billigere enheder. Ud over telefoner spreder NPU’er sig til PC’er (standard i nye Windows-laptops fra flere producenter), biler (næsten alle nye biler med ADAS Level 2+ har en form for AI-chip), og IoT. Selv apparater som køleskabe og vaskemaskiner begynder at markedsføre “AI”-funktioner (nogle af dem er cloud-baserede, men nogle lokale, som adaptive cyklusser baseret på sensorer). Tendensen er tydelig: hvis en enhed har en beregningschip, vil den have en eller anden form for ML-acceleration på den chip.

- Ydelsesudvikling: AI-ydelsen på enheder fordobles omtrent hver 1–2 år (en kombination af bedre arkitektur og overgang til avancerede halvlederteknologier som 5nm, 4nm, 3nm). Apples Neural Engine gik fra 600 milliarder operationer/sekund i 2017 til 35 billioner i 2023 – næsten en 60× stigning på seks år Fandom. Qualcomms flagskibe sprang tilsvarende fra et par TOPS i 2018 til over 27 TOPS i 2023 (SD 8 Gen 3’s samlede AI-beregning, alle kerner talt med). Vi kan forvente, at mobile NPU’er leverer 100+ TOPS i 2025–2026, og PC-acceleratorer endnu mere, og disse tal kan blive mindre relevante, efterhånden som fokus skifter til brugbar ydelse på specifikke AI-opgaver (for eksempel, hvor stor en LLM kan du køre problemfrit, eller kan du lave 4K AI-video i realtid). Forskellen mellem cloud og edge vil sandsynligvis blive mindre for inferensopgaver. Dog vil edge stadig halte efter cloud for de absolut nyeste store modeller på grund af strøm- og hukommelsesbegrænsninger.

- Energieffektivitetsgevinster: En undervurderet faktor er, hvor effektive disse NPU’er er ved at blive. Teslas bil-NPU opnår ~4,9 TOPS/Watt Wikichip, hvilket var state-of-the-art for et par år siden; nu hævder nogle mobile NPU’er lignende eller bedre. Effektive NPU’er betyder længere batterilevetid, selv når vi bruger AI-funktioner mere. Det betyder også, at det bliver muligt at putte AI i små batteridrevne enheder (f.eks. AI-høreapparater, smarte sensorer, der kører på knapcellebatterier og udfører anomali-detektion). Konceptet TinyML – ekstremt småskala maskinlæring på mikrocontrollere – er en forlængelse af dette, hvor man bruger forenklede “NPU’er” eller optimerede instruktioner på mikrocontrollere til at lave AI i sensorer. ARMs Ethos-U NPU er rettet mod det segment (f.eks. always-on nøgleordsgenkendelse, der kører på få milliwatt). Forvent flere AI-specifikke små chips, der kan indlejres i sensorer, wearables og hverdagsobjekter (Smart tandbørste? AI-drevet røgdetektor? Det kommer).

- Hybrid Cloud-Edge-løsninger: I stedet for at edge fuldstændigt erstatter cloud, er fremtiden samarbejde. Enheder vil gøre, hvad de kan lokalt, og kun række ud efter det, de ikke kan klare selv. For eksempel kan dine AR-briller køre lokal scenegenkendelse for at vide, hvad du kigger på, men hvis du stiller et meget komplekst spørgsmål (som en grundig forklaring), kan de forespørge en cloud-AI for en mere avanceret analyse og derefter præsentere den. Denne hybride tilgang giver den bedste balance mellem reaktionsevne og kapacitet. Virksomheder designer aktivt oplevelser omkring dette: Microsofts Copilot på Windows kan bruge den lokale NPU til hurtig tale-til-tekst og kommando-fortolkning, men derefter bruge cloud til de tunge opgaver (medmindre du måske har en kraftig PC-NPU, der kan klare det). Brugeren bør ideelt set ikke vide eller bekymre sig om, hvilken der bruges, udover at tingene bliver hurtigere og mere privatlivsvenlige. Vi vil også se, at federated learning bliver mere almindeligt – modeller trænes i skyen, men med hjælp fra data, der er krypteret eller behandlet på enhederne, og omvendt.

- Nye anvendelsestilfælde: Efterhånden som NPUs bliver mere kraftfulde, åbner der sig nye applikationer. Generativ AI på enheden er en stor ting – forestil dig AI-billedskabelse, AI-video-redigering og personlige chatbots direkte på din telefon eller laptop. Allerede i 2025 kan vi se tidlige versioner af offline personlige assistenter, der kan opsummere dine e-mails eller skrive udkast til beskeder uden cloud. Realtime sprogoversættelse i samtaler (to personer taler forskellige sprog, og telefoner eller ørepropper oversætter næsten i realtid) vil blive markant forbedret af lokal behandling (ingen forsinkelse og virker overalt). Sundheds-AI kan bo på wearables – dit smartwatch opdager atrieflimren eller analyserer søvnapnø-mønstre ved hjælp af sin NPU. Sikkerhed: enheder kan lokalt køre AI for at opdage malware eller phishing i realtid (f.eks. antivirus, der bruger en AI-model på din enhed i stedet for cloud-scanninger). Og i køretøjer, udover selve kørslen, kan AI personliggøre oplevelsen i bilen (justere klimaanlæg baseret på dit opfattede humør via førerrettet kamera-AI osv.). Mange af disse anvendelser kræver hurtig iteration og privatliv, hvilket passer til lokal behandling.

- Konkurrence og demokratisering: De store aktører vil fortsætte med at konkurrere, hvilket er godt for forbrugerne – forvent markedsføring som “vores AI-chip klarer X TOPS eller muliggør Y-funktion, som andre ikke kan.” Men teknologien er også ved at blive demokratiseret – NPUs er ikke kun i $1000-telefoner; de kommer til $300-telefoner, $50 IoT-boards (Coral, Arduino Portenta osv.), og open source-fællesskaber skaber små AI-modeller, som hobbyfolk kan køre på en Raspberry Pi eller mikrocontroller med en basal accelerator. Denne udbredte tilgængelighed betyder, at innovation kan komme hvor som helst fra. En enkelt udvikler kan nu bygge en app, der bruger lokal AI til at gøre noget smart uden at skulle bruge en serverfarm – hvilket sænker barrieren for AI-drevet software.

- Fremtidens teknologi: Ser vi længere frem, forskes der i neuromorfisk computing (hjerne-inspirerede chips som Intel Loihi) og analoge AI-chips, som en dag kan revolutionere NPU’er og give effektivitetsgevinster i helt nye størrelsesordener. Virksomheder som IBM og BrainChip arbejder på dette. Hvis det lykkes, kan en neuromorfisk chip gøre det muligt at køre kompleks AI kontinuerligt på små batteridrevne enheder. Vi kan også komme til at se 3D-stabling og ny hukommelsesteknologi integreret i NPU’er for at overvinde hukommelsesflaskehalse (nogle chips fra 2025 og frem kan bruge HBM-hukommelse eller ny on-chip ikke-flygtig hukommelse for at fodre AI-kerner hurtigere). Forvent også mere specialisering inden for AI-chips: f.eks. separate acceleratorer til vision, tale, anbefalingsmodeller osv., hver optimeret til deres domæne. Nogle SoC’er har allerede to NPU’er (en “stor” NPU til tunge opgaver, en mikro-NPU i sensorhub til altid-aktive lette opgaver).

Afslutningsvis er udviklingen tydelig: NPU’er og TPU’er er ved at blive lige så standard og uundværlige som CPU’er i moderne computere. De gør enheder klogere, mere reaktive og mere hensynsfulde over for vores privatliv. Som én rapport udtalte, “high-performance processing units on devices are largely responsible for executing complex AI functions like image recognition, NLP, and real-time decision-making”, og dette driver mere intelligent og reaktiv teknologi på tværs af sektorer 18 .

Vi går ind i en æra, hvor du bare vil forvente, at din enhed forstår og forudser dine behov – din telefon redigerer billeder og skriver beskeder i din stil, din bil undgår ulykker og underholder dig med AI, dine hjemmegadgets lærer dine præferencer – alt sammen gjort muligt af de stille neurale processorer indeni dem. On-device AI er ikke science fiction; det er her nu og forbedres hurtigt. Samspillet mellem NPU’er og TPU’er og vores hverdagsteknologi gør AI personlig, allestedsnærværende og privat – og bringer virkelig skyens intelligens ned på jorden (eller i det mindste ned i din lomme).

Kilder:

- Bigelow, Stephen. “GPUs vs. TPUs vs. NPUs: Comparing AI hardware options.” TechTarget, 27. aug. 2024 Techtarget. Beskriver roller og forskelle mellem CPU’er, GPU’er, TPU’er og NPU’er i AI-arbejdsbelastninger.

- Backblaze Blog. “AI 101: GPU vs. TPU vs. NPU.” Backblaze, 2023 Backblaze. Forklaring af Googles TPU-design (systoliske arrays, lav præcision) og NPU-brug i mobile enheder.

- TechTarget WhatIs. “Tensor processing unit (TPU).” whatis.techtarget.com, 2023 Techtarget. Bemærker, at TPU’er specialiserer sig i matrixmatematikopgaver, og at NPU’er efterligner hjernens neurale netværk for acceleration 19 .

- NimbleEdge Blog (Neeraj Poddar). “The State of On-Device AI: What’s Missing in Today’s Landscape.” 26. juni 2025 Nimbleedge. Opridser fordele ved on-device AI (latens, offline, privatliv, omkostninger) og udfordringer som fragmenterede SDK’er.

- Qualcomm (OnQ Blog). “Bloomberg and Cristiano Amon talk on-device AI.” juli 2023 X. CEO for Qualcomm om vigtigheden af on-device inferens for fremtidens AI (tweet-citat om vendepunkt i AI).

- MediaTek Blog (Exec Talk af Will Chen). “Shaping the future of AI mobile experiences.” 3. marts 2025 Mediatek. MediaTek og Oppos samarbejde om NPU’er; citat om edge computing i din hånd og eksempel på AI-fotoforbedring ved brug af NPU.

- I-Connect007 / Qualcomm Press. “Qualcomm works with Meta to enable on-device AI (Llama 2).” 24. juli 2023 Iconnect007. Pressemeddelelse med citat fra Qualcomms SVP Durga Malladi om at skalere generativ AI via edge-enheder og cloud.

- PCWorld (Mark Hachman). “Intel’s Core Ultra CPUs keep AI simple….” 24. oktober 2024 Pcworld. Diskuterer Intel Arrow Lake, der bruger Meteor Lakes NPU (13 TOPS), og nævner AMD’s Ryzen 8000 39 TOPS NPU og Microsofts 40 TOPS “Copilot”-krav.

- Ts2 (Tech Empowerment). “Self-Driving Supercomputer Showdown: NVIDIA Thor vs Tesla HW4 vs Qualcomm Ride.” Sep. 2023 ts2.tech. Giver TOPS-estimater: Tesla HW3 vs HW4 (72→100 TOPS per chip) ts2.tech, NVIDIA Thor ~1000 TOPS (eller 2000 med dual) ts2.tech og citerer NVIDIA VP om generativ AI i køretøjer 20 .

- Grand View Research. “On-Device AI Market Report, 2030.” 2024 Grandviewresearch. Noterer stigningen i specialiserede AI-chips (NPU’er), der muliggør kompleks AI på enheder, og at hardware udgjorde 60,4% af on-device AI-markedet i 2024, drevet af smartphones, IoT, NPU’er osv.

- Google Blog. “Google Tensor G3: Pixel 8’s AI-first processor.” Okt. 2023 Blog. Beskriver Tensor G3’s opgraderinger til generativ AI på enheden, nyt TPU-design og on-device TTS-model på datacenter-niveau.

- Techspot. “Snapdragon 8 Gen 3 brings generative AI to smartphones.” Okt. 2023 Futurumgroup. Futurum Group-analyse, der detaljerer SD8Gen3’s AI-motor: 10B param LLM på enheden, 98% hurtigere NPU, verdens hurtigste Stable Diffusion på telefon, osv., plus fordele ved on-device LLM’er for omkostninger/privatliv/offline 21 .

- Apple Wiki (Fandom). “Neural Engine.” Opdateret 2025 Fandom. Neural Engine versionshistorik med A17 Pro 35 TOPS i 2023, osv. Viser udviklingen fra 0,6 TOPS (A11) til 35 TOPS (A17) Fandom og M4 på 38 TOPS 22 .

- EnGenius Tech. “Cloud Edge Camera AI Surveillance.” 2023 Engeniustech. Eksempel på sikkerhedskamera med indbygget NPU, der muliggør AI-behandling på kameraet og lokal lagring (intet NVR nødvendigt).

- EmbedL. “Amazon udgiver AZ1 Neural Edge Processor.” Okt. 2020 Embedl. Diskuterer Amazons AZ1 edge NPU til Echo-enheder, bygget med MediaTek, designet til talegenkendelse på enheden for at reducere latenstid og afhængighed af cloud 23 .