- IBM plant bis 2025 einen Quanten-Supercomputer mit über 4.000 Qubits, indem drei 1.386-Qubit-Kookaburra-Chips zu einem 4.158-Qubit-System zusammengeschaltet werden.

- Die modulare Plattform Quantum System Two, die 2023 vorgestellt wurde, ist darauf ausgelegt, mehrere Chips aufzunehmen und verfügt über einen kryogenen Kühlschrank sowie fortschrittliche Steuerelektronik.

- Ende 2023 nahm IBM das erste Quantum System Two in Betrieb, das drei 133-Qubit-Heron-Prozessoren parallel laufen lässt.

- Bis Ende 2025 beabsichtigt IBM, drei Kookaburra-Chips auf System Two zu betreiben und so eine einzelne Maschine mit 4.158 Qubits zu schaffen.

- IBM verwendet Kurzstrecken-Chip-zu-Chip-Koppler und kryogene Verbindungen, um Chips zu einem einzigen Rechenverbund zu verbinden.

- Das Unternehmen nennt diesen Ansatz quantum-zentrisches Supercomputing, bei dem QPUs mit CPUs und GPUs zu einem einheitlichen Rechenverbund verwoben werden.

- Qiskit Runtime und Circuit Knitting ermöglichen es Entwicklern, große Quanten-Workloads über mehrere Chips hinweg mit integrierter Fehlerkorrektur auszuführen.

- Das 4.000+ Qubit-System wird 2025 im NISQ-Regime betrieben und setzt auf Fehlerabschätzung statt vollständiger Quanten-Fehlerkorrektur.

- Experten schätzen, dass das Knacken von RSA-2048 etwa 4.000 fehlerkorrigierte logische Qubits erfordern würde, was wahrscheinlich Millionen physischer Qubits entspricht.

- Zu den Wettbewerbern zählen Google, das bis 2029 fehlertolerantes Quantencomputing anstrebt, IonQ mit dem Fokus auf algorithmische Qubits, Quantinuum mit Schwerpunkt auf hoher Genauigkeit und Fehlertoleranz sowie D-Wave mit einem Annealing-System mit über 5.000 Qubits.

IBM steht an der Schwelle zu einem Durchbruch im Quantencomputing: ein „Quanten-Supercomputer“ mit über 4.000 Qubits bis 2025. Der ambitionierte Plan des Technologieriesen – Teil einer größeren Quantenstrategie – verspricht, das Computing zu revolutionieren, indem Probleme gelöst werden, die selbst die schnellsten heutigen Supercomputer nicht bewältigen können. In diesem Bericht beleuchten wir IBMs Quantenreise, das Design des 4.000+ Qubit-Systems, Expertenmeinungen (und Hype), den Vergleich mit Rivalen wie Google und IonQ und was eine 4.000-Qubit-Maschine für die Welt bedeuten könnte.

Hintergrund: IBMs Quantencomputing-Quest

IBM war ein Pionier im Quantencomputing und führte sowohl bei der Hardware- als auch bei der Softwareentwicklung. Bereits 2020 stellte IBM eine Quanten-Roadmap vor und hat seither jeden Meilenstein erreicht. 2021 demonstrierte das Unternehmen den 127-Qubit-Eagle-Prozessor – ein Chip, dessen Schaltkreise „nicht mehr zuverlässig exakt auf einem klassischen Computer simuliert werden können“ [1]. 2022 stellte IBM den 433-Qubit-Osprey-Chip vor, ein großer Sprung gegenüber Eagle in der Qubit-Anzahl [2]. Zuletzt erreichte IBM Ende 2023 die 1.121-Qubit-Marke mit seinem Condor-Prozessor – dem ersten Quantenprozessor, der die Tausend-Qubit-Grenze überschritt [3]. Jeder dieser Fortschritte legte entscheidende Grundlagen für die Skalierung auf Tausende von Qubits.

Aber die Strategie von IBM besteht nicht nur darin, immer mehr Qubits hinzuzufügen. Das Unternehmen betont einen Full-Stack-Ansatz: robuste Quanten-Hardware, intelligente Quanten-Software und ein breites Ökosystem von Nutzern und Partnern [4], [5]. Im Jahr 2016 stellte IBM den ersten Quantencomputer für die öffentliche Nutzung in die Cloud, und heute sind über 200 Organisationen und 450.000 Nutzer über die Cloud mit den Quantenservices von IBM verbunden [6]. Das Software-Framework von IBM (Qiskit) und die Qiskit Runtime-Umgebung ermöglichen es Entwicklern, Quantenprogramme effizient auszuführen, mit integrierten Tools zur Fehlerkorrektur und zur Orchestrierung hybrider Quanten-Klassik-Workloads [7], [8]. Diese enge Integration von Hardware und Software – zusammen mit einem Netzwerk aus akademischen und industriellen Partnern – ist zentral für das übergeordnete Ziel von IBM: nützliche Quantencomputer in die Welt zu bringen, nicht nur Labordemos.

IBM nennt diese Vision gerne „quantenzentriertes Supercomputing“. Die Idee ist, schließlich Quantenprozessoren (QPUs) mit klassischen CPUs und GPUs in einem nahtlosen Computing-Gewebe zu [9] verflechten. So wie moderne Supercomputer CPUs und KI-Beschleuniger kombinieren, um KI-Workloads zu bewältigen, sieht IBM zukünftige Supercomputer, die Quanten- und klassische Engines kombinieren, um Probleme zu lösen, die keiner allein bewältigen könnte [10]. In den Worten von Dr. Jay Gambetta, Vizepräsident für Quanten bei IBM: „Jetzt läutet IBM das Zeitalter des quantenzentrierten Supercomputers ein, in dem Quantenressourcen – QPUs – mit CPUs und GPUs zu einem Compute-Fabric verwoben werden“, mit dem Ziel, „die schwierigsten Probleme“ in Wissenschaft und Industrie zu lösen [11]. Es ist eine kühne Vision, die über die bloße Entwicklung eines schnelleren Computers hinausgeht; es geht darum, die Form des Computings grundlegend zu verändern.

Entwurf eines Quanten-Supercomputers mit über 4.000 Qubits

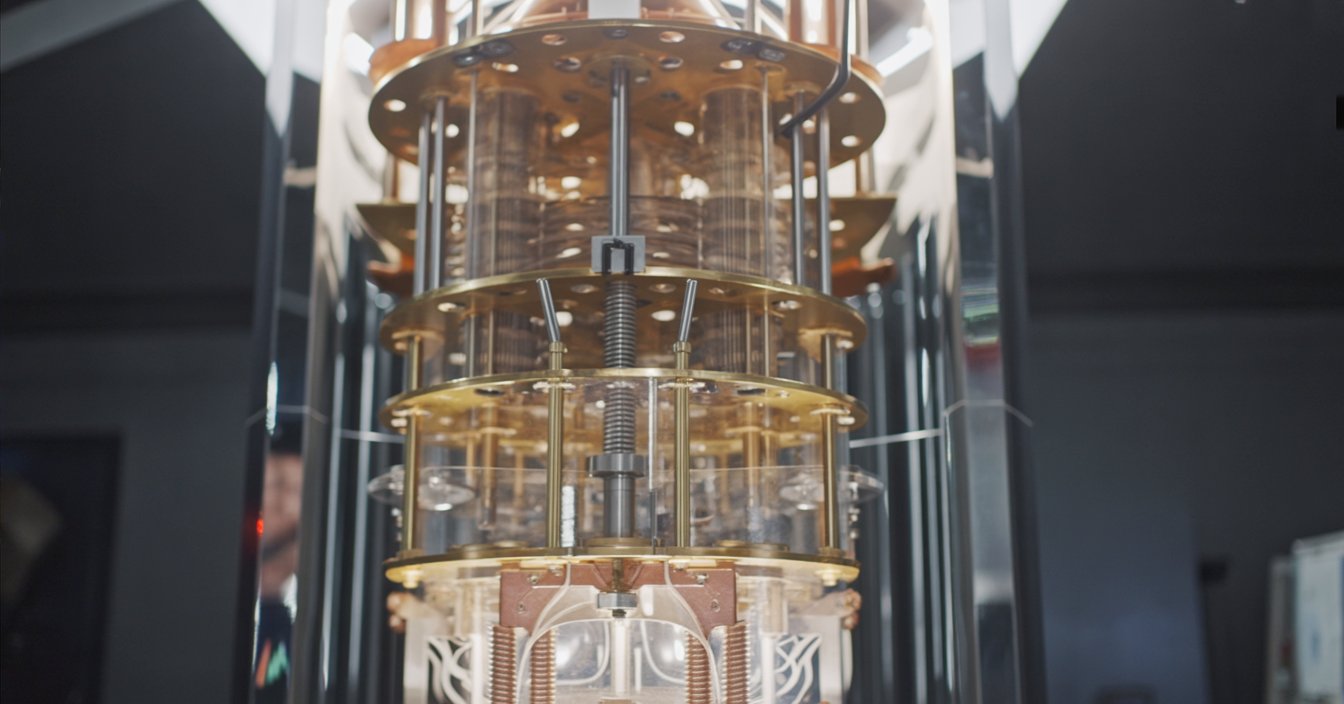

Wie baut man einen Quantencomputer mit über 4.000 Qubits? IBMs Antwort: Modularität. Anstatt eines riesigen Chips verbindet IBM mehrere kleinere Quantenchips zu einem System – ähnlich wie das Verknüpfen von Knotenpunkten in einem Supercomputer. Die nächste Plattform des Unternehmens, genannt IBM Quantum System Two, ist speziell dafür entwickelt. System Two, das 2023 vorgestellt wurde, ist IBMs erstes modulares Quantencomputersystem, ausgestattet mit einem hochmodernen kryogenen Kühlschrank und Steuerelektronik, die mehrere Quantenprozessoren gleichzeitig unterstützen kann [12], [13]. Es ist das physische „Zuhause“, das IBMs kommende Flotte verbundener Chips beherbergen wird, alle auf nahezu den absoluten Nullpunkt gekühlt. Durch das Kombinieren von Chips kann IBM die Anzahl der Qubits schnell erhöhen, ohne einzelne, riesige Chips fertigen zu müssen – ein Ansatz, der entscheidend ist, um von Hunderten auf Tausende von Qubits zu springen.

Abbildung: IBMs Vision für einen Quanten-Supercomputer ist es, mehrere Quantenchips zu einem System zu verbinden. 2025 plant IBM die Einführung von „Kookaburra“, einem 1.386-Qubit-Prozessor mit Quantenkommunikationsverbindungen; drei Kookaburra-Chips können zu einem einzigen 4.158-Qubit-System verbunden werden [14]. Diese modulare Architektur ermöglicht es IBM, auf Tausende von Qubits zu skalieren, indem kleinere Prozessoren vernetzt werden, anstatt sich auf einen riesigen Chip zu verlassen.

Das Herzstück von IBMs 4.000-Qubit-Plan ist die kommende Prozessorfamilie mit vogelbezogenen Codenamen. Im Jahr 2024 wird IBM voraussichtlich „Flamingo“, einen 462-Qubit-Chip, vorstellen, der dazu dient, die Quantenkommunikation zwischen Chips zu testen [15]. IBM plant, das Flamingo-Design zu demonstrieren, indem drei Flamingo-Prozessoren zu einem 1.386-Qubit-System verbunden werden – im Wesentlichen wird damit gezeigt, dass mehrere Chips zusammenarbeiten können, als wären sie ein einziger [16]. Dann folgt das große Highlight: 2025 wird IBM „Kookaburra“ vorstellen, einen 1.386-Qubit-Prozessor, der für modulare Skalierung entwickelt wurde [17]. Dank integrierter Kommunikationsverbindungen können drei Kookaburra-Chips zu einer einzigen Maschine mit 4.158 Qubits verbunden werden [18]. Nach IBMs Worten wird dies der erste quantenzentrierte Supercomputer sein und die 4.000-Qubit-Grenze durchbrechen.Wie sieht diese Architektur also aus? Im Wesentlichen verwendet IBM Kurzstrecken-Chip-zu-Chip-Koppler und kryogene Verbindungen, um Qubits über verschiedene Chips hinweg zu verbinden [19]. Man kann sich jeden Chip als ein „Kachel“ aus Qubits vorstellen; Koppler ermöglichen es benachbarten Kacheln, Quanteninformationen zu teilen, und spezielle Mikrowellenkabel können Chips verbinden, die etwas weiter auseinander liegen [20]. Die Herausforderung besteht darin, Qubits auf separaten Chips so verhalten zu lassen, als wären sie auf demselben Chip – keine leichte Aufgabe, da Quantenzustände sehr fragil sind. IBM entwickelt neue Koppler-Technologien, um verschränkte Qubits zwischen Chips kohärent zu halten [21]. System Two bietet die ultrakalte, vibrationsfreie Umgebung und eine flexible Verkabelung, um diese Multi-Chip-Netzwerke zu ermöglichen [22]. All dies wird von einer „intelligenten“ Steuerungsschicht (Software und klassische Recheneinheit) orchestriert, die Quantenoperationen über die verschiedenen Chips hinweg steuert und sie im Zusammenspiel arbeiten lässt [23].

IBMs Zeitplan sieht vor, dass das 4.000+ Qubit-System irgendwann im Jahr 2025 in Betrieb genommen wird [24]. Tatsächlich sind die ersten Komponenten bereits vorhanden. Ende 2023, auf dem IBM Quantum Summit, nahm IBM das erste Quantum System Two in Betrieb, das drei kleinere 133-Qubit-„Heron“-Prozessoren parallel laufen ließ [25]. Dies diente als Prototyp: Heron ist ein relativ Chip mit niedriger Qubit-Anzahl, aber mit deutlich verbesserten Fehlerraten, und IBM nutzte System Two, um zu zeigen, dass mehrere Prozessoren gemeinsam als ein einziges System betrieben werden können [26]. Im Laufe des nächsten Jahres oder der nächsten zwei Jahre wird IBM dies ausbauen – größere Chips (wie Flamingo und dann Kookaburra) einsetzen und mehr davon verknüpfen. Das Ziel ist, dass bis Ende 2025 das IBM Quantum System Two drei Kookaburra-Chips beherbergen wird und somit >4.000 verbundene Qubits in einer Maschine [27]. Mit Blick in die Zukunft stellt sich IBM sogar vor, mehrere System Twos zu verbinden: Zum Beispiel könnte das Verbinden von drei solcher Systeme in Zukunft einen Cluster mit über 16.000 Qubits ergeben [28]. Mit anderen Worten: 4.000 Qubits sind nicht das Endziel – es ist ein Zwischenschritt zu noch größeren Quantenmaschinen, die durch die Vernetzung von Modulen entstehen, ähnlich wie klassische Supercomputer durch mehrere Knoten skalieren.

IBMs Vision: Einblicke von Quantum-Führungskräften

Das Quanten-Team von IBM ist verständlicherweise begeistert – und optimistisch – darüber, was dieser Sprung auf 4.000 Qubits bedeutet. Der Forschungsdirektor von IBM, Dr. Darío Gil, hat oft darüber gesprochen, eine neue Ära des praktischen Quantencomputings zu erreichen. „Die Umsetzung unserer Vision hat uns einen klaren Einblick in die Zukunft des Quantencomputings und in das, was nötig ist, um uns in die Ära des praktischen Quantencomputings zu führen, verschafft“, sagte Gil, als IBM seine Roadmap erweiterte [29]. Mit dem Ziel von über 4.000 Qubits in Sicht, bezeichnete er dies als den Beginn „einer Ära quantenzentrierter Supercomputer, die große und leistungsstarke Rechenräume eröffnen werden“ für Entwickler, Partner und Kunden [30]. Mit anderen Worten: IBM sieht dies als den Beginn von Quantencomputern, die nicht mehr nur Laborexperimente sind, sondern leistungsstarke Werkzeuge für den praktischen Einsatz.

Jay Gambetta, IBM Fellow und VP of Quantum, hat 2023 als einen wichtigen Wendepunkt bezeichnet – den Moment, in dem das Konzept des quantenzentrierten Supercomputers als Prototyp Realität wurde [31]. Laut Gambetta reicht es nicht aus, einfach mehr Qubits zu haben; „quantenzentriertes Supercomputing wird mehr erfordern als nur viele Qubits“, erklärte er – es braucht auch größere Schaltkreistiefe und eine enge Integration mit klassischen Systemen [32]. Das spiegelt IBMs Betonung der Qualität der Qubits und der nahtlosen Verbindung von Quanten- und klassischem Computing wider. „Unsere Mission ist es, nützliches Quantencomputing in die Welt zu bringen“, sagte Gambetta. „Wir werden weiterhin das beste Full-Stack-Quantenangebot der Branche bereitstellen – und es liegt an der Branche, diese Systeme zu nutzen“ [33]. Die Botschaft: IBM liefert die Hardware und Software, und sie erwarten, dass Unternehmen und Forscher damit wirkungsvolle Dinge tun.

Auf dem Quantum Summit 2023 schlug das IBM-Team einen optimistischen Ton hinsichtlich der Reife der Technologie an. „Wir befinden uns fest in einer Ära, in der Quantencomputer als Werkzeug zur Erforschung neuer wissenschaftlicher Grenzen eingesetzt werden“, bemerkte Dr. Darío Gil und stellte fest, dass Quantenmaschinen nicht mehr nur Kuriositäten sind [34]. Er hob IBMs Fortschritte bei der Skalierung dieser Systeme durch modulare Designs hervor und versprach, „die Qualität eines Quantum-Technology-Stacks im Nutzungsmaßstab weiter zu erhöhen – und ihn unseren Nutzern und Partnern zur Verfügung zu stellen, die die Grenzen noch komplexerer Probleme verschieben werden“ [35]. Im Wesentlichen arbeitet IBM beim Hochskalieren der Qubits auch daran, die Qubit-Fidelität und die „Intelligenz“ der Software zu verbessern, damit diese Tausenden von Qubits tatsächlich nützliche Arbeit an komplexen Problemen leisten können.

IBM verwendet sogar eine anschauliche Metapher für den bevorstehenden Wandel. Das Unternehmen vergleicht den Übergang von den heutigen noch jungen Quantencomputern zum Quanten-Supercomputer 2025 mit „dem Ersetzen von Papierkarten durch GPS-Satelliten“ in der Navigation [36]. Es ist ein eindrucksvolles Bild: Quanten-Supercomputer könnten uns auf völlig neue Weise durch Rechenprobleme führen, so wie GPS revolutioniert hat, wie wir unseren Weg finden. Ob die Realität IBMs Optimismus gerecht wird, bleibt abzuwarten, aber es besteht kein Zweifel, dass IBMs klügste Köpfe glauben, an der Schwelle zu etwas Großem zu stehen.

Was die Experten sagen: Hype und Realitätscheck

Die Ankündigung von IBMs 4.000-Qubit-Computer hat für viel Aufsehen gesorgt, aber externe Experten erinnern uns oft daran, unsere Erwartungen realistisch zu halten. Ein wichtiger Punkt, den sie anführen: Mehr Qubits allein garantieren noch keine nützlichen Ergebnisse. Die heutigen Quantenbits sind „rauschbehaftet“ – sie sind fehleranfällig – daher löst das bloße Zusammenschalten von Tausenden unvollkommener Qubits nicht magisch Probleme, wenn diese Qubits keine Kohärenz aufrechterhalten können. IEEE Spectrum stellte fest, dass IBMs Plan von einer „intelligenten Software-Schicht“ begleitet werden muss, um Fehler zu verwalten und die hybride Quanten-Klassik-Arbeitslast zu orchestrieren [37]. Tatsächlich könnte ein leistungsstarker neuer Software-Stack „der Schlüssel zu allem Nützlichen“ mit einem 4.000-Qubit-Prozessor sein, indem er Fehler abmildert und Aufgaben zwischen der Quantenhardware und klassischen Co-Prozessoren aufteilt [38]. Kurz gesagt: Die reine Qubit-Anzahl ist nicht alles – wie man diese Qubits nutzt und steuert, ist mindestens genauso entscheidend.

Einige Branchenbeobachter heben auch die Lücke zwischen physischen Qubits und logischen Qubits hervor. Ein logisches Qubit ist ein fehlerkorrigiertes Qubit, im Wesentlichen ein Verbund aus vielen physischen Qubits, die zusammenarbeiten, um wie ein sehr zuverlässiges Qubit zu agieren. Experten schätzen, dass das Knacken moderner Verschlüsselung (wie der 2048-Bit-RSA-Schlüssel, die die Online-Sicherheit schützen) etwa 4.000 fehlerkorrigierte logische Qubits erfordern würde – was in der Praxis angesichts des aktuellen Fehlerkorrekturaufwands Millionen physischer Qubits bedeuten könnte [39]. Wie ein Sicherheitsanalyst es ausdrückte: „4.000 logische Qubits sind nicht dasselbe wie 4.000 tatsächliche Qubits“ – ein vollständig fehlerkorrigierter Quantencomputer mit Tausenden logischer Qubits ist immer noch ein ferner Traum [40]. IBMs 4.000+ Qubit-Maschine wird weit von diesem fehlertoleranten Ideal entfernt sein; sie wird aus physischen Qubits bestehen, die clevere Fehlerabmilderungstechniken benötigen, um nützlich zu sein. Forscher warnen ausdrücklich davor, zu erwarten, dass diese Maschine etwa die Internetverschlüsselung knackt oder über Nacht jedes unlösbare Problem löst.Das gesagt, verschafft IBMs ehrgeizige Roadmap dem Unternehmen im reinen Qubit-Wettlauf einen Vorsprung vor vielen Konkurrenten, und einige Experten loben den modularen Ansatz als pragmatischen Weg zur Skalierung. „Wir glauben, dass klassische Ressourcen wirklich verbessern können, was man mit Quanten machen kann, und das Beste aus dieser Quantenressource herausholen“, bemerkte Blake Johnson, Leiter der IBM Quantum Platform, und betonte die Notwendigkeit der Orchestrierung zwischen Quanten- und klassischem Computing, um diese großen Systeme zu nutzen [41]. Diese Ansicht wird weithin geteilt: Die Zukunft ist „Quanten-plus-Klassik“, die im Tandem arbeiten.

Konkurrenzierende Visionen: IBM vs. Google, IonQ und andere

IBM ist im Quantenrennen nicht allein, aber seine Strategie unterscheidet sich von anderen großen Akteuren. Google zum Beispiel konzentriert sich weniger auf kurzfristige Qubit-Zahlen und mehr darauf, einen vollständig fehlerkorrigierten Quantencomputer zu erreichen. Googles Fahrplan zielt darauf ab, bis 2029 eine nützliche, fehlerkorrigierte Quantenmaschine zu realisieren, und das Unternehmen arbeitet stetig daran, logische Qubits und Fehlerreduktion zu demonstrieren, anstatt zu versuchen, Qubit-Rekorde zu brechen [42]. (Googles aktuelle Geräte, wie der 72-Qubit-Bristlecone oder neuere Versionen des 53-Qubit-Sycamore, haben weit weniger Qubits als die von IBM, aber Google hat kürzlich gezeigt, dass die Erhöhung der Anzahl physischer Qubits in einem logischen Qubit die Fehlerrate senken kann – ein vielversprechender Schritt in Richtung Skalierbarkeit [43].) In öffentlichen Stellungnahmen prognostiziert die Google-Führung einen Zeitraum von 5–10 Jahren, bis Quantencomputing echte Auswirkungen haben wird [44]. Während IBM also auf einen 4.000-Qubit-Prototypen zusteuert, setzt Google auf eine langfristige Strategie, um einen vollständig fehlertoleranten Quantencomputer zu erreichen, selbst wenn es kurzfristig nur Dutzende von Qubits sind.

Quantinuum (das von Honeywell und Cambridge Quantum gegründete Unternehmen) ist ein weiteres Schwergewicht, verfolgt aber einen anderen Technologiepfad: Ionenfallen-Qubits. Quantinuum jagt nicht sofort Tausenden von physischen Qubits hinterher – ihr neuestes Ionenfallen-System verfügt über etwa 50–100 hochfidele Qubits –, aber sie haben rekordverdächtiges Quantum Volume (ein Maß für die Gesamtfähigkeit) demonstriert und 2024 sogar 12 „logische“ Qubits durch Fehlerkorrektur geschaffen [45]. Quantinuums Fahrplan zielt auf vollständig fehlertolerantes Quantencomputing bis 2030 ab, und das Unternehmen legt Wert darauf, eine „Dreifach-Neun“-Fidelity (99,9 % Zuverlässigkeit) und Durchbrüche bei logischen Qubits als Meilensteine zu erreichen [46]. Ihr CEO, Rajeeb Hazra, argumentiert, dass Qualität und Fortschritte bei der Fehlerkorrektur einen „Billionen-Dollar-Markt“ für Quanten freisetzen werden, und behauptet, Quantinuum habe „die glaubwürdigste Roadmap der Branche für… fehlertolerantes Quantencomputing“ [47]. Zusammengefasst liegt Quantinuums Fokus darauf, die Qubits und die Fehlerkorrektur zu perfektionieren, auch wenn das vorerst weniger Qubits bedeutet – ein Gegensatz zu IBMs großem Wagnis, durch Skalierung und Rauschminderung voranzukommen.

Ein weiterer wichtiger Konkurrent, IonQ, setzt ebenfalls auf Ionenfallen-Technologie und betont ebenso die Qubit-Qualität. Die Führung von IonQ hebt häufig „algorithmische Qubits“ hervor – eine interne Kennzahl, die Fehlerraten und Konnektivität berücksichtigt – anstatt nur die reine Anzahl physischer Qubits [48]. Der Fahrplan von IonQ zielt auf einen „breiten Quanten-Vorteil bis 2025“ ab, jedoch durch die stetige Verbesserung der Qubit-Leistung und den Bau modularer, rackmontierter Ionenfallen-Systeme, nicht durch das Erreichen einer bestimmten hohen Qubit-Anzahl [49]. Tatsächlich rechnet IonQ damit, dass nur einige Dutzend hochwertige Qubits benötigt werden, um bei bestimmten Aufgaben deutlich größere, verrauschte Quantencomputer zu übertreffen. Der ehemalige CEO Peter Chapman sagte voraus, dass die Technologie von IonQ „entscheidend für den kommerziellen Quanten-Vorteil sein wird“, wobei er speziell algorithmische Qubits gegenüber physischen Zählungen als Schlüssel für nützliche Anwendungen hervorhob [50]. Diese Philosophie unterstreicht eine Debatte im Feld: Ist Quantencomputing ein „Zahlenspiel“ (mehr Qubits, schneller) oder ein „Qualitätsspiel“ (bessere Qubits, auch wenn das Hochskalieren langsamer geht)? IBM setzt auf Zahlen (mit Blick auf Qualität), während IonQ klar auf Qualität zuerst setzt.

Dann gibt es noch Rigetti Computing, einen kleineren Anbieter mit supraleitenden Qubits. Der Fahrplan von Rigetti hat Verzögerungen erfahren – sie hatten gehofft, bis 2024 durch Multi-Chip-Module 1.000 Qubits zu erreichen, aber in der Praxis liegen ihre Systeme immer noch im zweistelligen Qubit-Bereich. Mitte 2025 strebt Rigetti nun ein bescheideneres 100+ Qubit-System bis Ende 2025 [51] an und konzentriert sich dabei auf die Verbesserung der Fehlertoleranz und der Zwei-Qubit-Gate-Leistung. Das Unternehmen hat Mühe, mit IBMs schnellem Wachstum Schritt zu halten, was zeigt, wie schwierig es für Neueinsteiger ist, mit IBMs Ressourcen und Fachwissen in diesem Bereich mitzuhalten. Dennoch tragen Rigetti und andere zur Innovation bei (zum Beispiel hat Rigetti einige frühe Multi-Chip-Integrationstechniken entwickelt) und sie machen deutlich, dass IBMs Vorsprung nicht uneinholbar ist, falls grundlegende Durchbrüche (wie bessere Qubit-Designs oder Materialien) gelingen.

Es ist auch erwähnenswert, in diesem Zusammenhang D-Wave Systems zu nennen. D-Wave, ein kanadisches Unternehmen, verfügt heute über Quanten-Annealing-Maschinen (ein anderes Modell des Quantencomputings) mit mehr als 5.000 Qubits [52]. Allerdings sind die Qubits von D-Wave darauf ausgelegt, Optimierungsprobleme mittels Annealing zu lösen, nicht für allgemeine Quantenalgorithmen. Sie erreichen hohe Qubit-Zahlen durch eine spezialisierte Architektur, aber diese Qubits können keine beliebigen Quanten-Schaltkreise ausführen wie die Geräte von IBM oder Google. D-Waves CEO, Alan Baratz, hat darauf hingewiesen, dass ihre Technologie bereits in bestimmten Anwendungen (wie der Optimierung von Einzelhandelsplänen oder Telekommunikations-Routing) einen Mehrwert liefert [53]. Die Existenz eines 5.000-Qubit-D-Wave-Systems erinnert daran, dass nicht alle Qubits gleich sind – D-Waves Qubits sind für spezielle Aufgaben nützlich, aber nicht direkt mit Qubits von gate-basierten Quantencomputern vergleichbar. IBMs Ziel von über 4.000 Qubits bezieht sich auf universelle, gate-basierte Qubits, was in Bezug auf Komplexität und Leistungsfähigkeit eine viel größere Herausforderung darstellt.

Zusammengefasst zeichnet sich IBM dadurch aus, dass sie supraleitende Qubit-Hardware aggressiv skalieren und diese in kurzer Zeit mit klassischem Computing integrieren wollen. Google konzentriert sich auf Meilensteine der Fehlerkorrektur, Quantinuum und IonQ legen den Fokus auf Qubit-Fidelität (mit zunächst weniger Qubits), und Unternehmen wie Rigetti liegen mit kleineren Geräten zurück. Jeder Ansatz hat seine Vorteile. Wenn IBM Erfolg hat, wird das die Messlatte für die Qubit-Anzahl hoch legen und möglicherweise früher einen Quantenvorteil bei nützlichen Aufgaben erreichen. Aber wenn die Qubits zu fehleranfällig sind, könnten diese 4.000 Qubits nicht besser abschneiden als 100 exzellente Qubits eines Konkurrenten. Die nächsten Jahre werden ein faszinierendes Rennen zwischen verschiedenen Philosophien im Quantencomputing – und es ist nicht selbstverständlich, dass mehr Qubits immer gewinnen, es sei denn, sie werden mit Qualität und cleverer Software kombiniert.

Warum 4.000 Qubits? Potenzielle Anwendungen und Herausforderungen

Was könnte ein 4.000-Qubit-Quantencomputer tatsächlich leisten, wenn er wie beabsichtigt funktioniert? Zum Vergleich: Die heutigen Quantencomputer (mit Dutzenden oder wenigen Hunderten Qubits) haben klassische Computer bei keinem praktischen Problem klar übertroffen. IBM und andere glauben, dass wir durch das Erreichen von Tausenden von Qubits in den Bereich kommen, in dem ein nützlicher Quantenvorteil für bestimmte Problemklassen möglich wird [54]. Hier sind einige Anwendungen und Auswirkungen, die ein 4.000-Qubit-System ermöglichen könnte:

- Chemie und Materialwissenschaften: Quantencomputer sind besonders geeignet, molekulare und atomare Systeme zu simulieren. Selbst die größten klassischen Supercomputer haben Schwierigkeiten, das Verhalten komplexer Moleküle und chemischer Reaktionen exakt zu modellieren. IBM-Forscher weisen darauf hin, dass „nur wenige Bereiche werden so schnell vom Quantencomputing profitieren wie die Chemie“, da Quantenmaschinen die Quanten-Natur chemischer Wechselwirkungen nativ verarbeiten können [55]. Ein 4.000-Qubit-System könnte möglicherweise mittelgroße Moleküle oder neuartige Materialien mit hoher Genauigkeit simulieren – was die Wirkstoffforschung, die Entwicklung neuer Materialien (für Batterien, Düngemittel, Supraleiter usw.) und das Verständnis komplexer chemischer Prozesse unterstützt. Dies sind Probleme, bei denen klassische Methoden aufgrund exponentieller Komplexität an ihre Grenzen stoßen. Bis 2025 erwartet IBM, dass Quantencomputer beginnen werden, nützliche Anwendungen in den Naturwissenschaften wie der Chemie zu erforschen [56].

- Optimierung und Finanzen: Viele Probleme aus der realen Welt – von der Logistik in Lieferketten bis zur Portfolio-Optimierung – beinhalten die Suche nach der besten Lösung unter astronomisch vielen Möglichkeiten. Quantencomputer bieten mit Algorithmen wie QAOA oder quantenbasierten Annealing-Techniken neue Ansätze für bestimmte Optimierungsprobleme. Eine Maschine mit Tausenden von Qubits könnte größere Problemstellungen bewältigen oder präzisere Lösungen liefern als heutige Geräte. Der IBM-CEO Arvind Krishna hat angedeutet, dass das Quantencomputing neue Algorithmen für die Optimierung ermöglichen wird, die Unternehmen nutzen können und so möglicherweise zu einem entscheidenden Vorteil für Branchen wie Finanzen, Energie und Fertigung werden [57]. Ein 4.000-Qubit-System könnte zum Beispiel komplexe Risikoanalysen oder Routenoptimierungsprobleme angehen, die klassische Algorithmen nicht in angemessener Zeit lösen können.

- Maschinelles Lernen und KI: Es gibt immer mehr Forschung zu Quantum Machine Learning, bei dem Quantencomputer bestimmte Arten von Machine-Learning-Aufgaben beschleunigen oder neue Modellierungsmöglichkeiten bieten könnten. Mit Tausenden von Qubits könnten Quantencomputer beginnen, Quanten-Neuronale-Netzwerk-Modelle zu implementieren oder schnellere lineare Algebra-Subroutinen auszuführen, die ML-Algorithmen zugrunde liegen. IBM betrachtet maschinelles Lernen gezielt als Testfall für Quantenanwendungen – und erwartet, dass bis 2025 Quantencomputer zur Erforschung von Machine-Learning-Anwendungsfällen neben klassischem ML eingesetzt werden, was möglicherweise die Mustererkennung in Daten oder die Optimierung von ML-Modellen verbessert [58]. Ein praktisches Beispiel könnte die quantenunterstützte Merkmalsauswahl oder das Clustering in komplexen Datensätzen sein, das durch Quantensubroutinen beschleunigt werden könnte.

- Wissenschaftliche Forschung und „Grand Challenges“: Über gezielte Industrien hinaus wäre ein Quanten-Supercomputer mit 4.000 Qubits ein Segen für die Grundlagenforschung. Er könnte verwendet werden, um Hochenergie-Physikszenarien zu simulieren, Designs für Quantenmaterialien zu optimieren oder sogar Fragen in der Kryptographie und Mathematik zu untersuchen. IBM hat die Naturwissenschaften im Allgemeinen erwähnt – zum Beispiel könnten Probleme in Physik oder Biologie, die derzeit unlösbar sind, durch einen hybriden Quantenansatz gelöst werden [59]. Man denke an die Entwicklung von Katalysatoren für die CO₂-Abscheidung oder die Analyse von Quantensystemen in der Kernphysik – dies sind extrem komplexe Berechnungen, bei denen ein Quantencomputer neue Erkenntnisse liefern könnte. Forscher von IBM selbst haben Anwendungen in Chemie, Optimierung und maschinellem Lernen als frühe Ziele für den Quanten-Vorteil genannt [60].

Das ist das glänzende Versprechen – aber wie sieht es mit den Herausforderungen aus? Ein Quantencomputer mit 4.000 Qubits wird vor ernsthaften Hürden stehen:

- Rauschen und Fehlerraten: Die heutigen Qubits sind fehleranfällig; sie dekoherieren (verlieren ihren Quantenzustand) innerhalb von Mikrosekunden und die Operationen („Gates“) zwischen Qubits sind unvollkommen. Mit nur 50–100 Qubits können Quantenalgorithmen nur eine sehr kurze Abfolge von Operationen ausführen, bevor Fehler das Ergebnis überlagern. Wenn man Tausende von Qubits hat, multipliziert sich die Herausforderung des Rauschens. Tatsächlich könnte das Verbinden von drei Chips (wie von IBM geplant) noch mehr Fehler einführen, da die Operationen zwischen den Chips etwas langsamer und weniger zuverlässig sind [61]. IBM erkennt dies an und entwickelt die Software von System Two so, dass sie „architektur-bewusst“ ist – zum Beispiel, um kritische Operationen auf demselben Chip zu planen und die langsameren Operationen zwischen den Chips sorgfältig zu steuern [62]. Ohne Fehlerkorrektur (die bis 2025 nicht vollständig implementiert sein wird) wird sich IBM auf Fehlermitigation verlassen: clevere Tricks, um die Auswirkungen von Fehlern zu verringern. Dazu gehören Techniken wie probabilistische Fehlerunterdrückung, bei der absichtlich zusätzliches Rauschen eingeführt wird, um mehr über das Rauschen zu lernen, und die Ergebnisse dann klassisch nachbearbeitet werden, um Fehler herauszurechnen [63]. Diese Methoden sind rechnerisch aufwendig und nicht perfekt, aber die Forschung von IBM legt nahe, dass einige davon auf Geräte dieser Größe skalieren können [64]. Dennoch bleibt das Rauschmanagement das zentrale Problem – es ist der Grund, warum Quantencomputer bisher noch keine realen Probleme gelöst haben, und eine 4.000-Qubit-Maschine wird nur dann erfolgreich sein, wenn es IBM gelingt, die Fehler ausreichend zu kontrollieren, um tiefe Berechnungen durchzuführen.

- Fehlerkorrektur & Logische Qubits: Die langfristige Lösung für Rauschen ist Quanten-Fehlerkorrektur (QEC), bei der viele physikalische Qubits zu einem logischen Qubit zusammengefasst werden, das Fehler überstehen kann. Das 4.000-Qubit-System von IBM wird sich wahrscheinlich noch im „NISQ“-Regime (Noisy Intermediate-Scale Quantum) befinden, was bedeutet, dass es noch keine groß angelegte Fehlerkorrektur gibt – es wird einfach nicht genug Qubits geben, um alle 4.000 vollständig fehlerkorrigieren zu können. (Zum Vergleich: Schon die Umwandlung von ein paar tausend physikalischen Qubits in eine Handvoll logischer Qubits könnte die gesamte Maschine beanspruchen.) Allerdings bereitet IBM die Fehlerkorrektur bereits vor. Das Unternehmen forscht aktiv an neuen QEC-Codes (zum Beispiel einem quantum LDPC code, der qubit-effizienter ist als herkömmliche Surface Codes) und schnellen Fehler-Decodern [65]. Tatsächlich hat IBM seine Roadmap kürzlich bis 2033 verlängert und dabei explizit Verbesserungen der Gatterqualität und die Entwicklung fehlerkorrigierter Module nach 2025 priorisiert [66]. Der 4.000-Qubit-Supercomputer kann als Brücke gesehen werden: Er soll groß genug sein, um einige nützliche Dinge mit Fehler-minderung zu tun, während IBM lernt, wie man partielle Fehlerkorrektur im großen Maßstab umsetzt. IBM hat sogar einen Plan für einen Prototyp eines fehlertoleranten Quantencomputers bis 2029 angekündigt [67], was darauf hindeutet, dass Fehlerkorrektur sehr wohl auf ihrer Agenda steht, sobald der 4.000-Qubit-Meilenstein erreicht ist. Dennoch wird das Erreichen vollständig fehlerkorrigierter (logischer) Qubits eine Größenordnung mehr Qubits oder eine viel bessere Qubit-Fidelity erfordern – wahrscheinlich eine Kombination aus beidem.

- Software und Entwickler-Tools: Selbst wenn Sie eine Quantenmaschine mit 4.000 Qubits haben, benötigen Sie Software, die diese effektiv nutzen kann. Quantenalgorithmen müssen auf diese komplexe Multi-Chip-Hardware abgebildet werden. IBM begegnet dieser Herausforderung mit Tools wie Qiskit Runtime und Quantum Serverless-Architektur. Diese ermöglichen es einem Nutzer, ein Problem in kleinere Quantenschaltkreise zu zerlegen, sie parallel auf verschiedenen Quantenchips auszuführen und die Ergebnisse mit klassischer Verarbeitung zusammenzuführen [68]. Zum Beispiel ist „circuit knitting“ eine von IBM hervorgehobene Technik – dabei wird ein großer Schaltkreis in Stücke aufgeteilt, die auf kleinere Prozessoren passen, und die Ergebnisse anschließend klassisch wieder zusammengeführt [69]. Bis 2025 plant IBM, Funktionen wie dynamische Schaltkreise (bei denen Messergebnisse zukünftige Operationen in Echtzeit beeinflussen können) und integrierte Fehlerunterdrückung auf ihrer Cloud-Plattform laufen zu lassen [70]. Die Herausforderung wird sein, all dies entwicklerfreundlich zu gestalten. IBM möchte Quantencomputing zugänglich machen, damit Datenwissenschaftler und Fachexperten (nicht nur Quanten-PhDs) diese 4.000 Qubits nutzen können [71]. Eine gute Abstraktion zu erreichen – bei der ein Nutzer beispielsweise eine High-Level-Funktion aufruft, um ein Molekül zu simulieren, und das System herausfindet, wie es dafür 4.000 Qubits einsetzt – wird entscheidend für den praktischen Nutzen sein. IBMs Ansatz ist hier das Konzept von Quantum Middleware und einem „App Store“ für Quantenprimitiven: Vorgefertigte Funktionen für gängige Aufgaben wie das Sampling von Wahrscheinlichkeitsverteilungen oder das Schätzen von Eigenschaften von Systemen [72]. Wenn dies gelingt, muss ein Chemiker im Jahr 2025 die Hardware-Details vielleicht gar nicht mehr kennen; er könnte einfach IBMs Software nutzen, um die 4.000-Qubit-Leistung für seine Simulation zu nutzen.

- Physische Infrastruktur: Die Skalierung auf Tausende von Qubits ist nicht nur eine rechnerische Herausforderung, sondern ein technisches Marathon. Quantenprozessoren müssen auf Millikelvin-Temperaturen gekühlt werden – kälter als der Weltraum. IBM musste einen neuen Verdünnungskühlschrank (IBM Quantum System Two) entwerfen, der größer und modularer ist als die bisherigen, um mehrere Chips und deren gesamte Steuerverkabelung aufzunehmen [73]. Der Kühlschrank, die Elektronik und die Verkabelung werden immer komplexer, je mehr Qubits hinzugefügt werden. Tausende von Qubits bedeuten tausende von Mikrowellen-Steuerleitungen, ausgeklügelte Filterung, um zu verhindern, dass Wärme und Störungen zu den Qubits gelangen, und riesige Datenströme aus den Qubit-Auslesungen. Die IBM-Ingenieure haben die Komplexität der Skalierung von Quantensystemen mit der von frühen Supercomputern oder Weltraummissionen verglichen. Bis 2025 erwartet IBM, „die wichtigsten Grenzen für die Skalierung beseitigt zu haben“ durch modulare Hardware und dazugehörige Steuerelektronik [74] – aber es ist erwähnenswert, dass IBM diese Grenzen gerade erst erreicht. Das System Two in New York ist im Wesentlichen ein Prototyp, um diese Komplexität zu bewältigen [75]. IBM installiert bis 2025 auch ein System Two in Europa (in Partnerschaft mit der baskischen Regierung in Spanien) [76], das testen wird, wie diese hochmoderne Infrastruktur außerhalb des eigenen IBM-Labors repliziert werden kann. Der Erfolg dieser Implementierungen wird ein wichtiger Beweis dafür sein, dass die Rohrleitungen und Verkabelungen eines Quanten-Supercomputers zuverlässig und wartbar gemacht werden können.

Angesichts dieser Herausforderungen dämpfen Experten den Hype, indem sie darauf hinweisen, dass eine 4.000-Qubit-IBM-Maschine wahrscheinlich ein hochgradig spezialisiertes Werkzeug sein wird. Sie könnte klassische Supercomputer bei bestimmten Problemen (Quantenchemie-Simulationen, bestimmte Optimierungen oder maschinelle Lernaufgaben, wie erwähnt) übertreffen und dabei einen quantum advantage oder sogar Einblicke in die quantum supremacy in nützlichen Kontexten erreichen. Sie wird jedoch klassische Computer nicht sofort obsolet machen. Tatsächlich werden für viele Aufgaben klassische Supercomputer und GPUs immer noch schneller oder praktischer sein. IBMs eigene Roadmap erkennt diese Synergie an: Der Quanten-Supercomputer soll mit klassischem HPC zusammenarbeiten, wobei jeder das tut, was er am besten kann [77]. Wir sollten das 4.000-Qubit-System also als einen der ersten echten „Quantenbeschleuniger“ betrachten – etwas, das man zusammen mit klassischem Computing einsetzt, um jene wirklich schwierigen Probleme anzugehen, die klassische Maschinen allein nicht lösen können. Es ist ein bedeutender Schritt in Richtung des ultimativen Traums des fehlertoleranten Quantencomputings, aber es ist nicht das Endziel.

Der Weg voraus: IBMs Quantum Roadmap über 2025 hinaus

IBMs Supercomputer mit über 4.000 Qubits ist ein bedeutender Meilenstein, aber er ist Teil einer längeren Roadmap, die sich bis in die 2030er Jahre erstreckt. IBM hat öffentlich erklärt, dass sie bis 2025, mit diesem quantenzentrierten Supercomputer, „einige der größten Hürden beim Skalieren von Quantenhardware beseitigt haben werden“ [78]. Aber die Entwicklung wird dort nicht enden. Ab 2025 und darüber hinaus wird sich IBMs Fokus zunehmend auf das Skalieren mit Qualität verlagern – die Verbesserung der Qubit-Fidelität, Fehlerkorrektur und der Komplexität der ausführbaren Schaltkreise.

Tatsächlich hat IBM Ende 2023 seine Quantum Development Roadmap bis 2033 aktualisiert. Ein zentrales Ziel: Bis etwa 2026–2027 fehlerkorrigierte Quantenoperationen auf ihren Systemen einzuführen und später im Jahrzehnt auf „fortschrittliche fehlerkorrigierte Systeme“ hinzuarbeiten [79]. IBM priorisiert Verbesserungen der Gate-Fidelität (Reduzierung der Fehlerraten), sodass größere Quantenschaltkreise (mit Tausenden von Operationen) möglich werden [80]. Das deutet darauf hin, dass IBM nach Erreichen des Qubit-Benchmarks verstärkt daran arbeiten wird, jedes Qubit zu verbessern und Fehlerkorrektur schrittweise zu integrieren. Ein konkretes Beispiel ist IBMs Arbeit an neuen fehlerkorrigierenden Codes wie Quantum-LDPC-Codes und schnelleren Dekodieralgorithmen, die Fehler effizienter als heutige Surface Codes behandeln sollen [81]. Es gibt auch Gespräche über einen IBM-Prozessor mit dem Codenamen „Loon“ um 2025, der Komponenten einer fehlerkorrigierten Architektur testen soll (wie Module zum Verbinden von Qubits für einen bestimmten QEC-Code) [82]. Bis 2029 strebt IBM an, einen vorzeigbaren fehlertoleranten Quantenprototyp zu bauen, was mit Konkurrenten wie Google auf dieses ultimative Ziel ausgerichtet ist [83].

Am Hardware-Front wird IBM seine vogelthematische Prozessorreihe wahrscheinlich auch nach Kookaburra fortsetzen. Die Roadmap über 2025 hinaus ist noch nicht vollständig öffentlich, aber IBM deutete an, noch größere Multi-Chip-Systeme und vielleicht hybride Technologien zu erforschen. Zum Beispiel beinhaltet IBMs Vision eines quantenzentrierten Supercomputers schließlich Quanten-Kommunikationsverbindungen, die Chip-Cluster über Entfernungen hinweg verbinden können, nicht nur im selben Kühlschrank [84]. Wir könnten sehen, dass IBM Glasfaser-Interconnects oder andere Methoden einsetzt, um Quantenprozessoren in verschiedenen Kryostaten zu verbinden – ähnlich wie ein Quanten-LAN. Dies würde langfristig zu Zehntausenden oder sogar Millionen von Qubits führen, was laut IBM notwendig sein wird, um die schwierigsten Probleme zu lösen (und vollständige Fehlerkorrektur durchzuführen) [85], [86]. Nach IBMs eigenen Worten sollte ihr modularer und vernetzter Ansatz eine Skalierung auf „Hunderttausende von Qubits“ im Laufe der Zeit ermöglichen [87]. Das 4.000-Qubit-System ist im Wesentlichen die erste Ausprägung einer Quanten-Supercomputer-Architektur, die durch das Verbinden weiterer Module wachsen kann.IBMs umfassendere Roadmap beinhaltet auch den Ausbau des Quanten-Ökosystems. Das Unternehmen investiert in Bildung, Partnerschaften und Cloud-Zugänglichkeit, damit eine Community bereitsteht, sobald die Hardware einsatzbereit ist. Beispielsweise hat IBM mit nationalen Laboren, Universitäten und sogar regionalen Regierungen (wie in Japan, Korea, Deutschland und Spanien) zusammengearbeitet, um Quantensysteme zu hosten und die lokale Entwicklung zu fördern. Der Plan, Europas erstes IBM Quantum System Two bis 2025 in Spanien zu installieren [88], ist Teil dieser Strategie – mehr Menschen sollen praktische Erfahrungen mit fortschrittlicher Quantenhardware sammeln. Die IBM-Führung sagt voraus, dass Quantencomputing in den kommenden Jahren ein entscheidendes Unterscheidungsmerkmal für Unternehmen sein wird [89], und sie wollen im Zentrum dieser entstehenden Quantenwirtschaft stehen.

Abschließend stellt IBMs Quanten-Supercomputer-Projekt mit über 4.000 Qubits einen historischen Sprung im Maßstab des Quantencomputings dar. Falls es gelingt, wird es den Übergang von isolierten, experimentellen Quantenprozessoren zu vernetzten Quantensystemen markieren, die an die Schwelle praktischer Nutzbarkeit heranreichen. Dieses Unterfangen befindet sich an der Schnittstelle von modernster Physik, Ingenieurwesen und Informatik. Es ist ebenso sehr eine Softwareleistung wie eine Hardwareleistung, da völlig neue Wege erforderlich sind, um eine völlig neue Art von Supercomputer zu steuern und zu programmieren. Die Welt schaut genau hin – nicht nur wegen der rekordverdächtigen Qubit-Anzahl, sondern auch, ob IBM mit dieser Maschine nützliche Ergebnisse demonstrieren kann, die das übertreffen, was klassische Computer leisten können.

Mitte 2025 steht IBM an der Schwelle zu diesem Erfolg: Das Hardware-Design ist weitgehend abgeschlossen, erste Prototypen laufen, und das Unternehmen arbeitet mit Hochdruck daran, alles zu einem funktionalen Supercomputer zu integrieren. Der Erfolg ist nicht garantiert, aber das Momentum und der bisherige Fortschritt sind unbestreitbar. Selbst Konkurrenten und Skeptiker würden zustimmen, dass IBM das Feld dramatisch vorangebracht hat. Während wir auf das vollständige Debüt von IBMs Quanten-Supercomputer warten, ist eines klar – wir treten in ein neues Kapitel der Computergeschichte ein. Wie IBM selbst verkündete, ist der kommende quantenzentrierte Supercomputer bereit, „eine unverzichtbare Technologie für diejenigen zu werden, die die schwierigsten Probleme lösen, die bahnbrechendste Forschung betreiben und die modernste Technologie entwickeln“ [90].

Die nächsten Jahre werden zeigen, ob dieses Versprechen eingelöst wird, aber wenn IBMs Wette aufgeht, könnten 4.000 Qubits tatsächlich das Computing für immer verändern – und die Tür zu Lösungen für Probleme öffnen, die wir einst für unlösbar hielten, sowie den Beginn des Zeitalters des Quantencomputings einläuten.

Quellen:

- IBM Newsroom: IBM Quantum roadmap and 4,000+ qubit system plans [91]

- IBM Research Blog: Quantum roadmap update for quantum-centric supercomputing (2024) [92]

- IBM Quantum Summit 2023 Pressemitteilung [93]

- TechMonitor: IBM stellt Quanten-Supercomputer vor, der bis 2025 4.000 Qubits erreichen könnte [94]

- IEEE Spectrum: IBMs Ziel: ein 4.000-Qubit-Prozessor bis 2025 (Analyse der Roadmap und Herausforderungen) [95]

- InsideHPC: IBM auf der Think 2022 – Vision des quantenzentrierten Supercomputings [96]

- The Quantum Insider: Roadmaps für Quantencomputing der wichtigsten Akteure (IBM, Google, IonQ, usw.) [97]

- TomorrowDesk: Überblick über IBMs Ziel eines Quanten-Supercomputers 2025 und modulares Design [98]

- Post-Quantum (Industrie-Blog): Über die benötigten Qubits zum Knacken der RSA-2048-Verschlüsselung [99]

- TechMonitor: Zitate von Dr. Darío Gil (IBM) und Statistiken zum IBM Quantum Network [100]

References

1. insidehpc.com, 2. www.techmonitor.ai, 3. tomorrowdesk.com, 4. newsroom.ibm.com, 5. insidehpc.com, 6. www.techmonitor.ai, 7. newsroom.ibm.com, 8. insidehpc.com, 9. insidehpc.com, 10. insidehpc.com, 11. insidehpc.com, 12. www.techmonitor.ai, 13. newsroom.ibm.com, 14. www.ibm.com, 15. www.ibm.com, 16. www.ibm.com, 17. www.ibm.com, 18. www.ibm.com, 19. spectrum.ieee.org, 20. spectrum.ieee.org, 21. tomorrowdesk.com, 22. www.techmonitor.ai, 23. insidehpc.com, 24. www.techmonitor.ai, 25. newsroom.ibm.com, 26. newsroom.ibm.com, 27. www.techmonitor.ai, 28. www.techmonitor.ai, 29. newsroom.ibm.com, 30. newsroom.ibm.com, 31. www.techmonitor.ai, 32. www.techmonitor.ai, 33. www.techmonitor.ai, 34. newsroom.ibm.com, 35. newsroom.ibm.com, 36. www.ibm.com, 37. spectrum.ieee.org, 38. spectrum.ieee.org, 39. postquantum.com, 40. postquantum.com, 41. spectrum.ieee.org, 42. thequantuminsider.com, 43. thequantuminsider.com, 44. thequantuminsider.com, 45. thequantuminsider.com, 46. thequantuminsider.com, 47. thequantuminsider.com, 48. thequantuminsider.com, 49. thequantuminsider.com, 50. thequantuminsider.com, 51. thequantuminsider.com, 52. thequantuminsider.com, 53. thequantuminsider.com, 54. tomorrowdesk.com, 55. www.ibm.com, 56. www.ibm.com, 57. thequantuminsider.com, 58. www.ibm.com, 59. www.ibm.com, 60. www.ibm.com, 61. www.ibm.com, 62. www.ibm.com, 63. spectrum.ieee.org, 64. spectrum.ieee.org, 65. thequantuminsider.com, 66. newsroom.ibm.com, 67. www.hpcwire.com, 68. www.ibm.com, 69. www.ibm.com, 70. www.ibm.com, 71. www.ibm.com, 72. www.ibm.com, 73. www.techmonitor.ai, 74. www.ibm.com, 75. newsroom.ibm.com, 76. tomorrowdesk.com, 77. tomorrowdesk.com, 78. www.ibm.com, 79. newsroom.ibm.com, 80. newsroom.ibm.com, 81. thequantuminsider.com, 82. www.hpcwire.com, 83. www.hpcwire.com, 84. newsroom.ibm.com, 85. newsroom.ibm.com, 86. insidehpc.com, 87. newsroom.ibm.com, 88. tomorrowdesk.com, 89. thequantuminsider.com, 90. insidehpc.com, 91. newsroom.ibm.com, 92. www.ibm.com, 93. newsroom.ibm.com, 94. www.techmonitor.ai, 95. spectrum.ieee.org, 96. insidehpc.com, 97. thequantuminsider.com, 98. tomorrowdesk.com, 99. postquantum.com, 100. www.techmonitor.ai