- IBM prevede un supercomputer quantistico con oltre 4.000 qubit entro il 2025, ottenuto interconnettendo tre chip Kookaburra da 1.386 qubit per formare un sistema da 4.158 qubit.

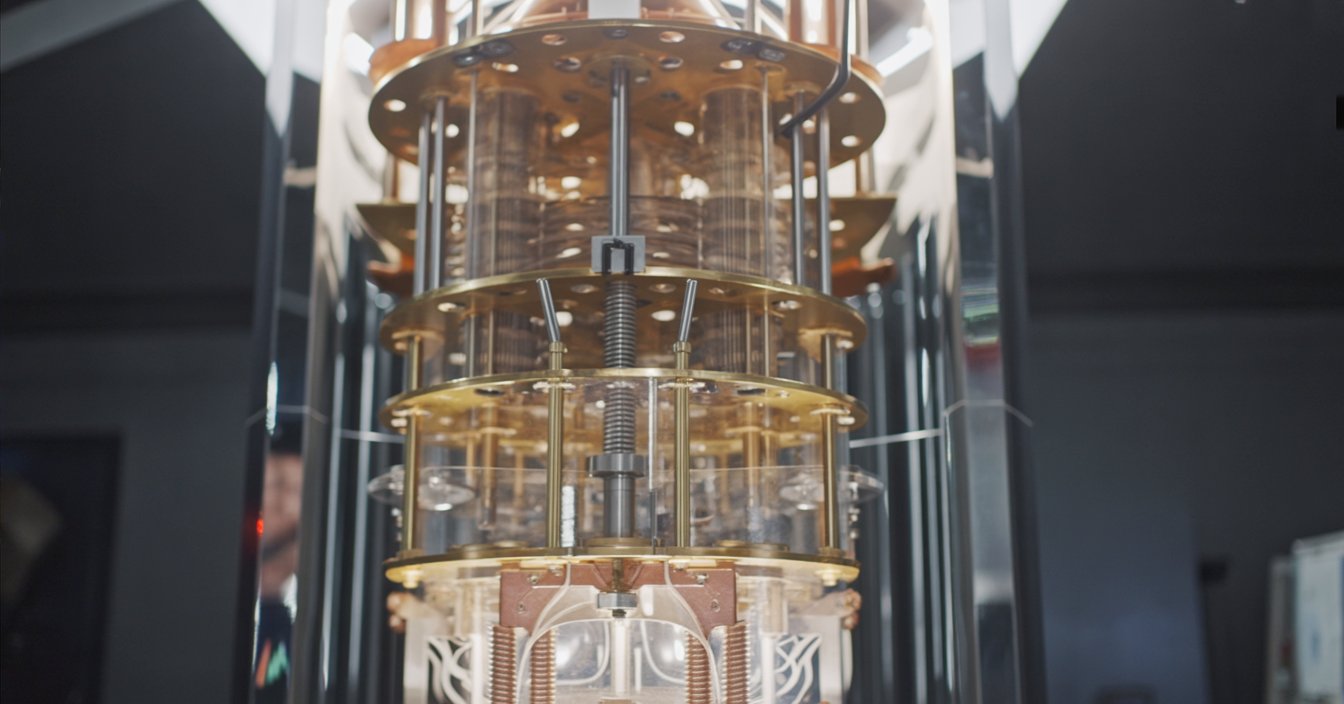

- La piattaforma modulare Quantum System Two, presentata nel 2023, è progettata per ospitare più chip e dispone di un frigorifero criogenico e di elettronica di controllo avanzata.

- Alla fine del 2023 IBM ha acceso il primo Quantum System Two, facendo funzionare in parallelo tre processori Heron da 133 qubit.

- Entro la fine del 2025 IBM intende ospitare tre chip Kookaburra su System Two, creando una singola macchina con 4.158 qubit.

- IBM utilizza accoppiatori chip-to-chip a corto raggio e collegamenti criogenici per connettere i chip in un unico tessuto di calcolo.

- L’azienda definisce questo approccio quantum-centric supercomputing, intrecciando QPU con CPU e GPU in un tessuto di calcolo unificato.

- Qiskit Runtime e circuit knitting permettono agli sviluppatori di eseguire grandi carichi di lavoro quantistici su più chip con mitigazione degli errori integrata.

- Il sistema da oltre 4.000 qubit opererà nel regime NISQ nel 2025, affidandosi alla mitigazione degli errori piuttosto che alla correzione completa degli errori quantistici.

- Gli esperti stimano che per violare RSA-2048 sarebbero necessari circa 4.000 qubit logici corretti dagli errori, probabilmente milioni di qubit fisici.

- I concorrenti includono Google, che punta al quantum computing fault-tolerant entro il 2029, IonQ che persegue i qubit algoritmici, Quantinuum focalizzata su alta fedeltà e tolleranza agli errori, e D-Wave che offre un sistema di annealing con oltre 5.000 qubit.

IBM è sull’orlo di una svolta nel calcolo quantistico: un “supercomputer quantistico” con oltre 4.000 qubit entro il 2025. L’ambizioso piano del colosso tecnologico – parte di una più ampia strategia quantistica – promette di rivoluzionare il calcolo affrontando problemi che i supercomputer più veloci di oggi non riescono a gestire. In questo report analizzeremo il percorso quantistico di IBM, il design del suo sistema da oltre 4.000 qubit, le opinioni degli esperti (e l’hype), il confronto con rivali come Google e IonQ, e cosa potrebbe significare una macchina da 4.000 qubit per il mondo.

Contesto: la corsa di IBM al calcolo quantistico

IBM è stata una pioniera nel calcolo quantistico, guidando lo sviluppo sia dell’hardware che del software. Già nel 2020, IBM ha presentato una roadmap quantistica e ha raggiunto ogni traguardo da allora. Nel 2021 ha dimostrato il processore Eagle da 127 qubit – un chip così complesso che i suoi circuiti “non possono essere simulati esattamente in modo affidabile su un computer classico” [1]. Nel 2022, IBM ha introdotto il chip Osprey da 433 qubit, un grande passo avanti rispetto a Eagle per numero di qubit [2]. Più recentemente, alla fine del 2023, IBM ha raggiunto la soglia dei 1.121 qubit con il suo processore Condor – il primo processore quantistico a superare la barriera dei mille qubit [3]. Ognuno di questi progressi ha posto le basi cruciali per scalare fino a migliaia di qubit.

Ma la strategia di IBM non consiste solo nell’aumentare il numero di qubit. L’azienda enfatizza un approccio full-stack: hardware quantistico robusto, software quantistico intelligente e un ampio ecosistema di utenti e partner [4], [5]. Nel 2016, IBM ha messo il primo computer quantistico sul cloud per l’uso pubblico e oggi oltre 200 organizzazioni e 450.000 utenti sono collegati ai servizi quantistici di IBM tramite il cloud [6]. Il framework software di IBM (Qiskit) e l’ambiente Qiskit Runtime permettono agli sviluppatori di eseguire programmi quantistici in modo efficiente, con strumenti integrati per mitigare gli errori e orchestrare carichi di lavoro ibridi quantistico-classici [7], [8]. Questa stretta integrazione tra hardware e software – insieme a una rete di collaboratori accademici e industriali – è centrale per l’obiettivo più ampio di IBM: portare il calcolo quantistico utile nel mondo, non solo nelle dimostrazioni di laboratorio.IBM ama chiamare questa visione “quantum-centric supercomputing.” L’idea è quella di intrecciare i processori quantistici (QPU) con CPU e GPU classiche in un tessuto di calcolo senza soluzione di continuità [9]. Proprio come i recenti supercomputer combinano CPU e acceleratori AI per gestire i carichi di lavoro di intelligenza artificiale, IBM vede i futuri supercomputer combinare motori quantistici e classici per affrontare problemi che nessuno dei due potrebbe risolvere da solo [10]. Nelle parole del Dr. Jay Gambetta, vicepresidente di IBM per il quantistico, “Ora, IBM sta inaugurando l’era del supercomputer quantum-centric, dove le risorse quantistiche – QPU – saranno intrecciate con CPU e GPU in un tessuto di calcolo”, con l’obiettivo di risolvere “i problemi più difficili” nella scienza e nell’industria [11]. È una visione ambiziosa che va oltre il semplice realizzare un computer più veloce; si tratta di cambiare la stessa natura del calcolo.

Progettare un supercomputer quantistico con oltre 4.000 qubit

Come si costruisce un computer quantistico con oltre 4.000 qubit? La risposta di IBM: modularità. Invece di un unico chip gigante, IBM sta collegando più chip quantistici più piccoli in un unico sistema – un po’ come collegare nodi in un supercomputer. La piattaforma di nuova generazione dell’azienda, chiamata IBM Quantum System Two, è stata progettata appositamente per questo. Presentato nel 2023, System Two è il primo sistema di calcolo quantistico modulare di IBM, dotato di un frigorifero criogenico all’avanguardia e di elettronica di controllo in grado di supportare più processori quantistici contemporaneamente [12], [13]. È la “casa” fisica che ospiterà la futura flotta di chip collegati di IBM, tutti raffreddati a temperature prossime allo zero assoluto. Combinando i chip, IBM può aumentare rapidamente il numero di qubit senza dover fabbricare chip singoli di dimensioni impossibili – un approccio cruciale per passare da centinaia a migliaia di qubit.

Figura: la visione di IBM per un supercomputer quantistico è collegare più chip quantistici in un unico sistema. Nel 2025, IBM prevede di introdurre “Kookaburra”, un processore da 1.386 qubit con collegamenti di comunicazione quantistica; tre chip Kookaburra possono essere collegati in un unico sistema da 4.158 qubit [14]. Questa architettura modulare consente a IBM di scalare fino a migliaia di qubit mettendo in rete processori più piccoli invece di affidarsi a un unico chip di grandi dimensioni.

Il cuore del piano di IBM per raggiungere 4.000 qubit è la sua prossima famiglia di processori con nomi in codice aviari. Nel 2024, IBM dovrebbe lanciare “Flamingo,” un chip da 462 qubit progettato per testare la comunicazione quantistica tra chip [15]. IBM prevede di dimostrare il design di Flamingo collegando tre processori Flamingo in un unico sistema da 1.386 qubit – dimostrando essenzialmente che più chip possono lavorare insieme come se fossero uno solo [16]. Poi arriva il grande passo: nel 2025, IBM presenterà “Kookaburra”, un processore da 1.386 qubit progettato per la scalabilità modulare [17]. Grazie ai collegamenti di comunicazione integrati, tre chip Kookaburra possono interconnettersi per formare una singola macchina con 4.158 qubit [18]. Secondo IBM, questo sarà il primo supercomputer quantum-centric, superando la soglia dei 4.000 qubit.Com’è fatta questa architettura? In sostanza, IBM utilizza accoppiatori chip-to-chip a corto raggio e collegamenti criogenici per unire i qubit su chip diversi [19]. Si può pensare a ciascun chip come a una “piastrella” di qubit; gli accoppiatori permettono alle piastrelle adiacenti di condividere informazioni quantistiche, e speciali cavi a microonde possono collegare chip un po’ più distanti [20]. La sfida è far sì che i qubit su chip separati si comportino quasi come se fossero sullo stesso chip – non è facile, poiché gli stati quantistici sono fragili. IBM ha sviluppato nuove tecnologie di accoppiamento per mantenere coerenti i qubit entangled tra chip diversi [21]. System Two fornisce l’ambiente ultra-freddo e privo di vibrazioni e una configurazione di cablaggio flessibile per ospitare queste reti multi-chip [22]. Tutto questo è orchestrato da uno strato di controllo “intelligente” (software e calcolo classico) che dirige le operazioni quantistiche tra i diversi chip, facendoli lavorare in sincronia [23].

La timeline diIBM prevede che il sistema da oltre 4.000 qubit sia operativo entro il 2025 [24]. In realtà, i primi componenti sono già stati installati. Alla fine del 2023, durante l’IBM Quantum Summit, IBM ha attivato il primo Quantum System Two, facendo funzionare in parallelo tre processori “Heron” più piccoli da 133 qubit ciascuno [25]. Questo è servito come prototipo: Heron è un chip con un numero relativamente basso di qubit ma con tassi di errore notevolmente migliorati, e IBM ha utilizzato System Two per dimostrare che è possibile far funzionare più processori insieme come un unico sistema [26]. Nel prossimo anno o due, IBM aumenterà la scala – sostituendo i chip con altri più grandi (come Flamingo e poi Kookaburra) e collegandone un numero maggiore. L’obiettivo è che entro la fine del 2025, IBM Quantum System Two ospiti tre chip Kookaburra e quindi oltre 4.000 qubit collegati in un’unica macchina [27]. Guardando ancora più avanti, IBM prevede persino di collegare più System Two: ad esempio, collegando tre di questi sistemi si potrebbe ottenere un cluster da oltre 16.000 qubit in futuro [28]. In altre parole, 4.000 qubit non sono il traguardo finale – sono una pietra miliare verso macchine quantistiche ancora più grandi costruite collegando tra loro moduli, proprio come i supercomputer classici si espandono con più nodi.

La Visione di IBM: Approfondimenti dai Leader del Quantum

Il team quantistico di IBM è comprensibilmente entusiasta – e ottimista – riguardo a ciò che significa questo salto a 4.000 qubit. Il Direttore della Ricerca di IBM, il Dr. Darío Gil, ha spesso parlato del raggiungimento di una nuova era dell’informatica quantistica pratica. “Mettere in atto la nostra visione ci ha dato una chiara visibilità sul futuro del quantum e su ciò che servirà per portarci nell’era dell’informatica quantistica pratica”, ha detto Gil, mentre IBM ampliava la sua roadmap [29]. Con l’obiettivo di oltre 4.000 qubit all’orizzonte, lo ha descritto come l’inizio di “un’era di supercomputer quantum-centrici che apriranno spazi computazionali ampi e potenti” per sviluppatori, partner e clienti [30]. In altre parole, IBM vede questo come l’alba di computer quantistici che non sono più solo esperimenti da laboratorio, ma strumenti potenti per l’uso nel mondo reale.

Jay Gambetta, IBM Fellow e VP di Quantum, ha definito il 2023 un punto di svolta importante – il momento in cui il concetto di supercomputer quantum-centrico è diventato realtà in forma di prototipo [31]. Secondo Gambetta, avere semplicemente più qubit non basta; “il supercalcolo quantum-centrico richiederà più che solo tanti qubit”, ha spiegato – serve anche una maggiore profondità dei circuiti e una stretta integrazione con i sistemi classici [32]. Questo riflette l’enfasi di IBM sulla qualità dei qubit e sulla fusione senza soluzione di continuità tra informatica quantistica e classica. “La nostra missione è portare l’informatica quantistica utile nel mondo,” ha detto Gambetta. “Continueremo a offrire la migliore soluzione quantistica full-stack del settore — e spetterà al settore mettere questi … sistemi in uso” [33]. Il messaggio: IBM fornirà l’hardware e il software, e si aspetta che aziende e ricercatori inizino a farne qualcosa di impattante.

Al Quantum Summit del 2023, il team di IBM ha adottato un tono ottimista riguardo alla maturità della tecnologia. “Siamo pienamente nell’era in cui i computer quantistici vengono utilizzati come strumento per esplorare nuove frontiere della scienza,” ha osservato il Dr. Darío Gil, sottolineando che le macchine quantistiche non sono più solo delle curiosità [34]. Ha evidenziato i progressi di IBM nella scalabilità di questi sistemi tramite il design modulare e ha promesso di “aumentare ulteriormente la qualità di uno stack tecnologico quantistico su scala utile – e metterlo nelle mani dei nostri utenti e partner che spingeranno i confini di problemi più complessi” [35]. In sostanza, mentre IBM aumenta il numero di qubit, sta anche lavorando per migliorare la fedeltà dei qubit e l’intelligenza del software, affinché quei migliaia di qubit possano effettivamente svolgere lavori utili su problemi complessi.

IBM utilizza persino una metafora vivida per il cambiamento imminente. L’azienda paragona il passaggio dagli attuali computer quantistici ancora agli inizi al supercomputer quantistico del 2025 a “sostituire le mappe cartacee con i satelliti GPS” nella navigazione [36]. È un’immagine evocativa: i supercomputer quantistici potrebbero guidarci attraverso problemi computazionali in un modo fondamentalmente nuovo, proprio come il GPS ha rivoluzionato il nostro modo di orientarci. Se la realtà corrisponderà all’ottimismo di IBM resta da vedere, ma non c’è dubbio che le menti migliori di IBM credano di essere sull’orlo di qualcosa di grande.

Cosa dicono gli esperti: tra entusiasmo e realtà

L’annuncio di IBM sui 4.000 qubit ha generato molto clamore, ma gli esperti esterni spesso ci ricordano di mantenere le aspettative realistiche. Un punto chiave che sottolineano: avere più qubit da soli non garantisce risultati utili. I qubit attuali sono “rumorosi” – soggetti a errori – quindi collegare semplicemente migliaia di qubit imperfetti non risolve magicamente i problemi se quei qubit non riescono a mantenere la coerenza. IEEE Spectrum ha osservato che il piano di IBM dovrà essere accompagnato da un “livello software intelligente” per gestire gli errori e orchestrare il carico di lavoro ibrido quantistico-classico [37]. In effetti, un nuovo potente stack software potrebbe essere “la chiave per fare qualcosa di utile” con un processore da 4.000 qubit, gestendo la mitigazione degli errori e suddividendo i compiti tra l’hardware quantistico e i co-processori classici [38]. In breve, il numero grezzo di qubit non è tutto – il modo in cui si usano e si controllano quei qubit è altrettanto cruciale.

Alcuni osservatori del settore sottolineano anche il divario tra qubit fisici e qubit logici. Un qubit logico è un qubit corretto dagli errori, in pratica un insieme di molti qubit fisici che lavorano insieme per agire come un unico qubit molto affidabile. Gli esperti stimano che per violare la crittografia moderna (come le chiavi RSA a 2048 bit che proteggono la sicurezza online) sarebbero necessari circa 4.000 qubit logici corretti dagli errori – che in pratica potrebbero significare milioni di qubit fisici, dato l’attuale sovraccarico della correzione degli errori [39]. Come ha detto un analista della sicurezza, “4.000 qubit logici non sono la stessa cosa di 4.000 qubit reali” – un computer quantistico completamente corretto dagli errori con migliaia di qubit logici è ancora un sogno lontano [40]. La macchina IBM da oltre 4.000 qubit sarà ben lontana da quell’ideale di tolleranza agli errori; sarà composta da qubit fisici che richiedono tecniche intelligenti di mitigazione degli errori per essere utili. I ricercatori sono rapidi nel mettere in guardia dal pensare che questa macchina possa, ad esempio, violare la crittografia di internet o risolvere ogni problema irrisolvibile dall’oggi al domani.

Detto ciò, la roadmap aggressiva di IBM la pone comunque davanti a molti concorrenti nella corsa al numero grezzo di qubit, e alcuni esperti elogiano l’approccio modulare come un modo pragmatico per scalare. “Crediamo che le risorse classiche possano davvero potenziare ciò che si può fare con il quantistico e ottenere il massimo da quella risorsa quantistica,” ha osservato Blake Johnson, responsabile della Quantum Platform di IBM, sottolineando la necessità di un’orchestrazione tra il calcolo quantistico e quello classico per sfruttare questi grandi sistemi [41]. Questo sentimento è ampiamente condiviso: il futuro è “quantistico-più-classico” che lavorano in tandem.

Visioni a confronto: IBM vs. Google, IonQ e altri

IBM non è sola nella corsa quantistica, ma la sua strategia si contrappone a quella di altri grandi attori. Google, ad esempio, si è concentrata meno sul numero di qubit a breve termine e più sul raggiungimento di un vero computer quantistico a correzione d’errore. La roadmap di Google punta a realizzare una macchina quantistica utile e a correzione d’errore entro il 2029, e l’azienda ha lavorato costantemente per dimostrare qubit logici e riduzione degli errori invece di cercare di battere i record di numero di qubit [42]. (I dispositivi attuali di Google, come il Bristlecone da 72 qubit o le versioni più recenti del Sycamore da 53 qubit, hanno molti meno qubit rispetto a quelli di IBM, ma Google ha recentemente dimostrato che aumentare il numero di qubit fisici in un qubit logico può ridurre il tasso di errore, un passo promettente verso la scalabilità [43].) In dichiarazioni pubbliche, la leadership di Google prevede un orizzonte temporale di 5–10 anni perché il calcolo quantistico inizi ad avere impatti reali [44]. Quindi, mentre IBM si lancia verso un prototipo da 4.000 qubit, Google gioca sul lungo periodo per raggiungere un vero computer quantistico tollerante agli errori, anche se nel breve termine dispone solo di alcune decine di qubit.Quantinuum (l’azienda nata dalla fusione tra Honeywell e Cambridge Quantum) è un altro peso massimo, ma segue una strada tecnologica diversa: i qubit a ioni intrappolati. Quantinuum non sta inseguendo subito migliaia di qubit fisici – il loro ultimo sistema a trappola di ioni ha dell’ordine di 50–100 qubit ad alta fedeltà – ma hanno dimostrato un quantum volume da record (una misura della capacità complessiva) e hanno persino creato 12 qubit “logici” tramite correzione d’errore nel 2024 [45]. La roadmap di Quantinuum punta al calcolo quantistico completamente tollerante agli errori entro il 2030, e l’azienda pone l’accento sul raggiungimento della fedeltà “tre 9” (99,9% di affidabilità) e sui progressi nei qubit logici come tappe fondamentali [46]. Il loro CEO, Rajeeb Hazra, sostiene che la qualità e i progressi nella correzione degli errori sbloccheranno un “mercato da mille miliardi di dollari” per il quantistico, e afferma che Quantinuum ha “la roadmap più credibile del settore verso… il calcolo quantistico tollerante agli errori” [47]. In sintesi, l’obiettivo di Quantinuum è perfezionare i qubit e la correzione degli errori, anche se ciò significa avere per ora meno qubit – in contrasto con la grande scommessa di IBM sull’aumento di scala e la gestione del rumore tramite mitigazione.

Un altro importante concorrente, IonQ, utilizza anch’esso la tecnologia a ioni intrappolati e sottolinea allo stesso modo la qualità dei qubit. La leadership di IonQ spesso mette in evidenza i “qubit algoritmici” – una metrica interna che tiene conto dei tassi di errore e della connettività – piuttosto che il semplice numero di qubit fisici [48]. La roadmap di IonQ punta a un “ampio vantaggio quantistico entro il 2025”, ma attraverso un costante miglioramento delle prestazioni dei suoi qubit e la costruzione di sistemi modulari a trappola di ioni montati su rack, non raggiungendo semplicemente un numero elevato di qubit [49]. In effetti, IonQ prevede di aver bisogno solo di alcune decine di qubit di alta qualità per superare computer quantistici molto più grandi ma rumorosi in determinati compiti. L’ex CEO Peter Chapman ha previsto che la tecnologia di IonQ “sarà fondamentale per il vantaggio quantistico commerciale,” sottolineando in particolare l’importanza dei qubit algoritmici rispetto al conteggio fisico come chiave per applicazioni utili [50]. Questa filosofia evidenzia un dibattito nel settore: il calcolo quantistico è un “gioco di numeri” (più qubit più velocemente) o un “gioco di qualità” (qubit migliori anche se più lenti da scalare)? IBM punta sui numeri (con attenzione anche alla qualità), mentre IonQ si schiera decisamente per la qualità prima di tutto.

Poi c’è Rigetti Computing, un attore più piccolo nel campo dei qubit superconduttori. La roadmap di Rigetti ha subito dei ritardi – speravano di raggiungere 1.000 qubit tramite moduli multi-chip entro il 2024, ma in pratica i loro sistemi sono ancora nell’ordine delle decine di qubit. A metà 2025, Rigetti punta a un più modesto sistema da oltre 100 qubit entro la fine del 2025 [51], concentrandosi nel frattempo sul miglioramento della fedeltà e delle prestazioni delle porte a due qubit. L’azienda ha faticato a tenere il passo con la rapida crescita di IBM, illustrando quanto sia difficile per i nuovi arrivati eguagliare le risorse e le competenze di IBM in questo settore. Tuttavia, Rigetti e altri contribuiscono all’innovazione (ad esempio, Rigetti ha introdotto alcune delle prime tecniche di integrazione multi-chip), e sottolineano che la leadership di IBM non è inattaccabile se dovessero emergere scoperte fondamentali (come migliori design di qubit o nuovi materiali).

Vale anche la pena menzionare D-Wave Systems in questo contesto. D-Wave, un’azienda canadese, dispone oggi di macchine di annealing quantistico (un modello diverso di calcolo quantistico) con oltre 5.000 qubit [52]. Tuttavia, i qubit di D-Wave sono progettati per risolvere problemi di ottimizzazione tramite annealing, non per algoritmi quantistici generali. Raggiungono un alto numero di qubit grazie a un’architettura specializzata, ma quei qubit non possono eseguire circuiti quantistici arbitrari come possono fare i dispositivi di IBM o Google. Il CEO di D-Wave, Alan Baratz, ha osservato che la loro tecnologia sta già offrendo valore in alcune applicazioni (come l’ottimizzazione dei turni nel retail o l’instradamento nelle telecomunicazioni) [53]. L’esistenza di un sistema D-Wave da 5.000 qubit è un promemoria che non tutti i qubit sono uguali – i qubit di D-Wave sono utili per compiti specifici ma non sono direttamente paragonabili ai qubit dei computer quantistici gate-based. L’obiettivo di IBM di oltre 4.000 qubit si riferisce a qubit universali, gate-based, che rappresentano una sfida molto più complessa in termini di complessità e capacità.

In sintesi, IBM si distingue per la rapida espansione dell’hardware a qubit superconduttori e per l’obiettivo di integrarlo con il calcolo classico in tempi brevi. Google si concentra sui traguardi della correzione degli errori, Quantinuum e IonQ puntano sulla fedeltà dei qubit (con meno qubit nel breve termine), e aziende come Rigetti restano indietro con dispositivi più piccoli. Ogni approccio ha i suoi meriti. Se IBM avrà successo, stabilirà uno standard elevato nel numero di qubit e potrebbe raggiungere prima il vantaggio quantistico in compiti utili. Ma se i qubit sono troppo rumorosi, quei 4.000 qubit potrebbero non superare i 100 qubit eccellenti di un concorrente. I prossimi anni saranno una corsa affascinante tra diverse filosofie nel calcolo quantistico – e non è detto che più qubit significhi sempre vincere, a meno che non siano accompagnati da qualità e software intelligente.

Perché 4.000 qubit? Potenziali applicazioni e sfide

Cosa potrebbe effettivamente fare un computer quantistico da 4.000 qubit, se funzionasse come previsto? Per contestualizzare, i computer quantistici di oggi (con decine o poche centinaia di qubit) non hanno ancora chiaramente superato i computer classici in nessun problema pratico. IBM e altri credono che, spingendosi verso le migliaia di qubit, entreremo nella zona in cui il vantaggio quantistico utile diventa possibile per alcune classi di problemi [54]. Ecco alcune applicazioni e impatti che un sistema da 4.000 qubit potrebbe sbloccare:

- Chimica e Scienza dei Materiali: I computer quantistici sono particolarmente adatti a simulare sistemi molecolari e atomici. Anche i più grandi supercomputer classici faticano a modellare esattamente il comportamento di molecole complesse e reazioni chimiche. I ricercatori IBM sottolineano che “pochi settori trarranno valore dal calcolo quantistico tanto rapidamente quanto la chimica,” perché le macchine quantistiche possono gestire nativamente la natura quantistica delle interazioni chimiche [55]. Un sistema da 4.000 qubit potrebbe potenzialmente simulare molecole di medie dimensioni o nuovi materiali con elevata accuratezza – aiutando la scoperta di farmaci, lo sviluppo di nuovi materiali (per batterie, fertilizzanti, superconduttori, ecc.) e la comprensione di processi chimici complessi. Questi sono problemi in cui i metodi classici si scontrano con un muro a causa della complessità esponenziale. Entro il 2025, IBM prevede che i computer quantistici inizieranno a esplorare applicazioni utili nelle scienze naturali come la chimica [56].

- Ottimizzazione e Finanza: Molti problemi del mondo reale – dalla logistica della catena di approvvigionamento all’ottimizzazione di portafoglio – implicano la ricerca della soluzione migliore tra possibilità astronomicamente numerose. I computer quantistici, con algoritmi come QAOA o tecniche di quantum annealing, offrono nuovi modi per affrontare certi problemi di ottimizzazione. Una macchina con migliaia di qubit potrebbe gestire istanze di problemi più grandi o fornire soluzioni più precise rispetto ai dispositivi attuali. L’amministratore delegato di IBM, Arvind Krishna, ha suggerito che il calcolo quantistico consentirà nuovi algoritmi per l’ottimizzazione di cui le aziende potranno avvalersi, diventando potenzialmente un elemento chiave di differenziazione per settori come finanza, energia e manifattura [57]. Un sistema da 4.000 qubit potrebbe, ad esempio, affrontare analisi di rischio complesse o problemi di ottimizzazione dei percorsi che gli algoritmi classici non riescono a risolvere in tempi ragionevoli.

- Apprendimento Automatico e IA: C’è una crescente ricerca su apprendimento automatico quantistico, dove i computer quantistici potrebbero accelerare certi tipi di compiti di machine learning o offrire nuove capacità di modellazione. Con migliaia di qubit, i computer quantistici potrebbero iniziare a implementare modelli di reti neurali quantistiche o eseguire più velocemente sottoprocedure di algebra lineare che sono alla base degli algoritmi di ML. IBM in particolare sta considerando il machine learning come caso di test per le applicazioni quantistiche – prevedendo che entro il 2025 i computer quantistici saranno utilizzati per esplorare casi d’uso di machine learning insieme al ML classico, migliorando forse il modo in cui riconosciamo pattern nei dati o ottimizziamo i modelli di ML [58]. Un esempio pratico potrebbe essere la selezione di feature o il clustering potenziati dal quantistico su dataset complessi, che potrebbero essere accelerati da sottoprocedure quantistiche.

- Ricerca scientifica e “Grandi Sfide”: Oltre alle industrie mirate, un supercomputer quantistico da 4.000 qubit sarebbe una manna per la scienza fondamentale. Potrebbe essere utilizzato per simulare scenari di fisica ad alta energia, ottimizzare progetti per materiali quantistici, o persino indagare questioni in crittografia e matematica. IBM ha menzionato le scienze naturali in senso ampio – ad esempio, problemi in fisica o biologia che attualmente sono intrattabili potrebbero cedere a un approccio quantistico ibrido [59]. Si pensi alla progettazione di catalizzatori per la cattura del carbonio, o all’analisi di sistemi quantistici in fisica nucleare – questi sono calcoli estremamente complessi in cui un computer quantistico potrebbe fornire nuove intuizioni. Gli stessi ricercatori IBM hanno indicato applicazioni in chimica, ottimizzazione e apprendimento automatico come primi obiettivi per il vantaggio quantistico [60].

Questa è la promessa scintillante – ma che dire delle sfide? Un computer quantistico da 4.000 qubit dovrà affrontare ostacoli seri:

- Rumore e tassi di errore: I qubit attuali sono soggetti a errori; decadono (perdono il loro stato quantistico) in pochi microsecondi e le operazioni (“gate”) tra i qubit sono imperfette. Con solo 50-100 qubit, gli algoritmi quantistici possono eseguire solo una sequenza molto breve di operazioni prima che gli errori prevalgano sul risultato. Se si hanno migliaia di qubit, la sfida del rumore si moltiplica. In effetti, collegare tre chip (come prevede IBM) potrebbe introdurre ancora più errori a causa di operazioni tra chip leggermente più lente e di minore fedeltà [61]. IBM ne è consapevole e sta progettando il software di System Two per essere “consapevole” dell’architettura – ad esempio, per programmare le operazioni critiche sullo stesso chip e gestire con attenzione le operazioni inter-chip più lente [62]. Senza la correzione degli errori (che non sarà pienamente implementata entro il 2025), IBM farà affidamento su mitigazione degli errori: trucchi ingegnosi per ridurre l’impatto degli errori. Questo include tecniche come la cancellazione probabilistica degli errori, in cui si introduce intenzionalmente rumore extra per apprendere sul rumore e poi si post-elaborano i risultati in modo classico per annullare gli errori [63]. Questi metodi sono computazionalmente costosi e non perfetti, ma la ricerca IBM suggerisce che alcuni possono essere scalati su dispositivi di queste dimensioni [64]. Tuttavia, la gestione del rumore è la questione centrale – è il motivo per cui i computer quantistici non hanno ancora risolto problemi del mondo reale, e una macchina da 4.000 qubit avrà successo solo se IBM riuscirà a tenere sotto controllo gli errori abbastanza da eseguire calcoli profondi.

- Correzione degli errori e Qubit logici: La soluzione a lungo termine al rumore è la correzione degli errori quantistici (QEC), che raggrupperà molti qubit fisici in un unico qubit logico in grado di sopravvivere agli errori. Il sistema IBM da 4.000 qubit probabilmente opererà ancora nel regime “NISQ” (Noisy Intermediate-Scale Quantum), il che significa che non ci sarà ancora una correzione degli errori su larga scala – semplicemente non ci saranno abbastanza qubit per correggere completamente tutti i 4.000. (Per dare un’idea, trasformare anche solo qualche migliaio di qubit fisici in una manciata di qubit logici potrebbe consumare l’intera macchina.) Tuttavia, IBM sta gettando le basi per la correzione degli errori. L’azienda sta attivamente ricercando nuovi codici QEC (ad esempio, un codice LDPC quantistico che è più efficiente in termini di qubit rispetto ai tradizionali codici di superficie) e decodificatori di errori rapidi [65]. Infatti, IBM ha recentemente esteso la sua roadmap fino al 2033, dando esplicita priorità ai miglioramenti nella qualità delle porte logiche e allo sviluppo di moduli con correzione degli errori dopo il 2025 [66]. Il supercomputer da 4.000 qubit può essere visto come un ponte: dovrebbe essere abbastanza grande da permettere alcune operazioni utili con la mitigazione degli errori, insegnando a IBM come implementare la correzione parziale degli errori su larga scala. IBM ha persino annunciato un piano per un prototipo di computer quantistico fault-tolerant entro il 2029 [67], indicando che la correzione degli errori è davvero una priorità per loro una volta raggiunto il traguardo dei 4.000 qubit. Tuttavia, ottenere qubit (logici) completamente corretti richiederà ordini di grandezza in più di qubit o una fedeltà dei qubit molto migliore – probabilmente una combinazione di entrambe le cose.

- Software e strumenti per sviluppatori: Anche se possiedi una macchina quantistica da 4.000 qubit, hai bisogno di software che possa utilizzarla efficacemente. Gli algoritmi quantistici devono essere mappati su questo complesso hardware multi-chip. IBM sta affrontando questa sfida con strumenti come Qiskit Runtime e l’architettura Quantum Serverless. Questi permettono all’utente di suddividere un problema in circuiti quantistici più piccoli, eseguirli in parallelo su diversi chip quantistici e unire i risultati tramite elaborazione classica [68]. Ad esempio, “circuit knitting” è una delle tecniche evidenziate da IBM – suddividere un circuito grande in parti che possano essere eseguite su processori più piccoli, per poi ricombinare i risultati in modo classico [69]. Entro il 2025, IBM prevede di avere funzionalità come circuiti dinamici (dove i risultati delle misurazioni possono influenzare le operazioni future in tempo reale) e la soppressione degli errori integrata sulla loro piattaforma cloud [70]. La sfida sarà rendere tutto questo a misura di sviluppatore. IBM vuole che il calcolo quantistico sia accessibile affinché data scientist e esperti di dominio (non solo dottorandi in quantistica) possano sfruttare quei 4.000 qubit [71]. Raggiungere una buona astrazione – dove un utente può, ad esempio, chiamare una funzione di alto livello per simulare una molecola e il sistema capisce come utilizzare 4.000 qubit per farlo – sarà cruciale per l’utilità pratica. L’approccio di IBM qui è il concetto di quantum middleware e un “app store” di primitive quantistiche: funzioni predefinite per compiti comuni come il campionamento di distribuzioni di probabilità o la stima delle proprietà di sistemi [72]. Se avrà successo, un chimico nel 2025 potrebbe non aver bisogno di conoscere i dettagli dell’hardware; potrebbe semplicemente usare il software IBM per sfruttare la potenza dei 4.000 qubit per la propria simulazione.

- Infrastruttura fisica: Scalare fino a migliaia di qubit non è solo una sfida computazionale, ma una maratona ingegneristica. I processori quantistici devono essere raffreddati a temperature di millikelvin – più fredde dello spazio esterno. IBM ha dovuto progettare un nuovo frigorifero a diluizione (IBM Quantum System Two) che è più grande e più modulare rispetto ai precedenti per ospitare più chip e tutti i loro cablaggi di controllo [73]. Il frigorifero, l’elettronica e il cablaggio diventano sempre più complessi man mano che si aggiungono qubit. Migliaia di qubit significano migliaia di linee di controllo a microonde, filtraggi sofisticati per evitare che calore e rumore arrivino ai qubit, e enormi flussi di dati dai readout dei qubit. Gli ingegneri di IBM hanno paragonato la complessità della scalabilità dei sistemi quantistici a quella dei primi supercomputer o delle missioni spaziali. Entro il 2025, IBM prevede di aver “rimosso i principali ostacoli alla scalabilità” tramite hardware modulare e l’elettronica di controllo associata [74] – ma vale la pena notare che IBM sta solo ora raggiungendo questi limiti. Il System Two a New York è essenzialmente un prototipo per gestire tale complessità [75]. IBM sta anche installando un System Two in Europa (in collaborazione con il governo basco in Spagna) entro il 2025 [76], che testerà come questa infrastruttura all’avanguardia possa essere replicata al di fuori del laboratorio IBM. Il successo di queste implementazioni sarà una prova importante che la tubatura e il cablaggio di un supercomputer quantistico possono essere resi affidabili e manutenibili.

Alla luce di queste sfide, gli esperti smorzano l’hype sottolineando che una macchina IBM da 4.000 qubit sarà probabilmente uno strumento altamente specializzato. Potrebbe superare i supercomputer classici su problemi specifici (simulazioni di chimica quantistica, alcune ottimizzazioni o compiti di machine learning come menzionato), raggiungendo la quantum advantage o persino scorci di quantum supremacy in contesti utili. Tuttavia, non renderà immediatamente obsoleti i computer classici. In effetti, per molti compiti, i supercomputer classici e le GPU saranno ancora più veloci o pratici. La stessa roadmap di IBM riconosce questa sinergia: il supercomputer quantistico è pensato per lavorare con l’HPC classico, ognuno facendo ciò che sa fare meglio [77]. Quindi dovremmo vedere il sistema da 4.000 qubit come uno dei primi veri “acceleratori quantistici” – qualcosa da usare insieme al calcolo classico per affrontare quei problemi davvero difficili che le sole macchine classiche non riescono a risolvere. È un passo significativo verso il sogno finale del calcolo quantistico fault-tolerant, ma non è la destinazione finale.

La strada da percorrere: la roadmap quantistica di IBM oltre il 2025

Il supercomputer di IBM con oltre 4.000 qubit rappresenta una pietra miliare importante, ma è parte di una roadmap più lunga che si estende fino agli anni 2030. IBM ha dichiarato pubblicamente che entro il 2025, con questo supercomputer quantistico-centrico operativo, avrà “rimosso alcuni dei maggiori ostacoli alla scalabilità dell’hardware quantistico” [78]. Ma lo sviluppo non si fermerà qui. Nel 2025 e oltre, l’attenzione di IBM si sposterà sempre più su scalare con qualità – migliorando la fedeltà dei qubit, la correzione degli errori e la complessità dei circuiti eseguibili.

Infatti, alla fine del 2023, IBM ha aggiornato la sua Quantum Development Roadmap fino al 2033. Un obiettivo chiave: intorno al 2026–2027, introdurre operazioni quantistiche con correzione degli errori sui propri sistemi, puntando verso “sistemi avanzati con correzione degli errori” più avanti nel decennio [79]. IBM sta dando priorità a miglioramenti nella fedeltà delle porte logiche (riduzione dei tassi di errore) in modo che circuiti quantistici più grandi (con migliaia di operazioni) diventino realizzabili [80]. Questo suggerisce che, dopo aver raggiunto il traguardo del numero di qubit, IBM si concentrerà sul migliorare ogni qubit e integrare gradualmente la correzione degli errori. Un esempio concreto è il lavoro di IBM su nuovi codici di correzione degli errori come i codici Quantum LDPC e algoritmi di decodifica più rapidi, che mirano a gestire gli errori in modo più efficiente rispetto ai codici surface attuali [81]. Si parla anche di un processore IBM con nome in codice “Loon” previsto per il 2025, pensato per testare componenti di un’architettura con correzione degli errori (come moduli per collegare qubit per un determinato codice QEC) [82]. Entro il 2029, IBM aspira a costruire un prototipo quantistico tollerante agli errori dimostrabile, allineandosi con concorrenti come Google su questo obiettivo finale [83].

Sul fronte hardware, IBM probabilmente continuerà la sua linea di processori a tema uccelli anche dopo Kookaburra. La roadmap oltre il 2025 non è completamente pubblica, ma IBM ha lasciato intendere che sta esplorando sistemi multi-chip ancora più grandi e forse tecnologie ibride. Ad esempio, la visione di IBM di un supercomputer quantistico-centrico prevede alla fine collegamenti di comunicazione quantistica che possono connettere cluster di chip a distanza, non solo nello stesso frigorifero [84]. Potremmo vedere IBM integrare interconnessioni in fibra ottica o altri metodi per collegare processori quantistici in diversi criostati – simile a una rete locale quantistica. Questo porterebbe verso decine di migliaia o addirittura milioni di qubit nel lungo periodo, che IBM riconosce saranno necessari per risolvere i problemi più complessi (e per eseguire la correzione completa degli errori) [85], [86]. Nelle stesse parole di IBM, il loro approccio modulare e in rete dovrebbe consentire di scalare fino a “centinaia di migliaia di qubit” nel tempo [87]. Il sistema da 4.000 qubit è essenzialmente la prima realizzazione di una architettura di supercomputer quantistico che può crescere collegando più moduli.La roadmap più ampia di IBM prevede anche la crescita dell’ecosistema quantistico. L’azienda sta investendo in formazione, partnership e accessibilità cloud affinché, quando l’hardware sarà pronto, ci sia già una comunità pronta a utilizzarlo. Ad esempio, IBM ha collaborato con laboratori nazionali, università e persino governi regionali (come in Giappone, Corea, Germania e Spagna) per ospitare sistemi quantistici e stimolare lo sviluppo locale. Il piano di installare il primo IBM Quantum System Two in Europa in Spagna entro il 2025 [88] fa parte di questa strategia: far sì che più persone possano lavorare direttamente con hardware quantistico avanzato. La leadership di IBM prevede che il calcolo quantistico diventerà un fattore chiave di differenziazione aziendale nei prossimi anni [89], e vogliono essere al centro di questa nascente economia quantistica.

In conclusione, il progetto del supercomputer quantistico di IBM con oltre 4.000 qubit rappresenta un salto storico in termini di scala per il calcolo quantistico. Se avrà successo, segnerà il passaggio da processori quantistici isolati ed esperimentali a sistemi quantistici in rete che si avvicinano alla soglia dell’utilità pratica. Questa impresa si trova all’incrocio tra fisica d’avanguardia, ingegneria e informatica. È tanto un’impresa software quanto un’impresa hardware, che richiede nuovi modi per gestire e programmare un tipo completamente nuovo di supercomputer. Il mondo osserva con attenzione – non solo per il numero record di qubit, ma per vedere se IBM riuscirà a dimostrare risultati utili con questa macchina che superino ciò che i computer classici possono fare.A metà 2025 IBM si trova sull’orlo di questo traguardo: il design hardware è in gran parte definito, i primi prototipi sono in funzione e l’azienda sta correndo per integrare tutto in un supercomputer funzionante. Il successo non è garantito, ma la spinta e i progressi finora sono innegabili. Anche concorrenti e scettici concorderebbero che IBM ha spinto il settore in avanti in modo drammatico. In attesa del debutto completo del supercomputer quantistico di IBM, una cosa è chiara: stiamo entrando in un nuovo capitolo della saga del calcolo. Come ha dichiarato la stessa IBM, il prossimo supercomputer quantistico-centrico è destinato a diventare “una tecnologia essenziale per chi risolve i problemi più difficili, per chi fa la ricerca più innovativa e per chi sviluppa la tecnologia più all’avanguardia” [90].

I prossimi anni diranno se questa promessa sarà mantenuta, ma se la scommessa di IBM avrà successo, 4.000 qubit potrebbero davvero cambiare per sempre il calcolo – aprendo la porta a soluzioni per problemi che un tempo pensavamo impossibili, e annunciando l’alba dell’era del calcolo quantistico.

Fonti:

- IBM Newsroom: IBM Quantum roadmap and 4,000+ qubit system plans [91]

- IBM Research Blog: Quantum roadmap update for quantum-centric supercomputing (2024) [92]

- IBM Quantum Summit 2023 Press Release [93]

- TechMonitor: IBM svela un supercomputer quantistico che potrebbe raggiungere 4.000 qubit entro il 2025 [94]

- IEEE Spectrum: Obiettivo di IBM: un processore da 4.000 qubit entro il 2025 (analisi della roadmap e delle sfide) [95]

- InsideHPC: IBM al Think 2022 – visione del supercalcolo quantum-centrico [96]

- The Quantum Insider: Roadmap del calcolo quantistico dei principali attori (IBM, Google, IonQ, ecc.) [97]

- TomorrowDesk: Panoramica sull’obiettivo di IBM per il supercomputer quantistico 2025 e sul design modulare [98]

- Post-Quantum (blog di settore): Sui qubit necessari per violare la crittografia RSA-2048 [99]

- TechMonitor: Citazioni del Dr. Darío Gil di IBM e statistiche dell’IBM Quantum Network [100]

References

1. insidehpc.com, 2. www.techmonitor.ai, 3. tomorrowdesk.com, 4. newsroom.ibm.com, 5. insidehpc.com, 6. www.techmonitor.ai, 7. newsroom.ibm.com, 8. insidehpc.com, 9. insidehpc.com, 10. insidehpc.com, 11. insidehpc.com, 12. www.techmonitor.ai, 13. newsroom.ibm.com, 14. www.ibm.com, 15. www.ibm.com, 16. www.ibm.com, 17. www.ibm.com, 18. www.ibm.com, 19. spectrum.ieee.org, 20. spectrum.ieee.org, 21. tomorrowdesk.com, 22. www.techmonitor.ai, 23. insidehpc.com, 24. www.techmonitor.ai, 25. newsroom.ibm.com, 26. newsroom.ibm.com, 27. www.techmonitor.ai, 28. www.techmonitor.ai, 29. newsroom.ibm.com, 30. newsroom.ibm.com, 31. www.techmonitor.ai, 32. www.techmonitor.ai, 33. www.techmonitor.ai, 34. newsroom.ibm.com, 35. newsroom.ibm.com, 36. www.ibm.com, 37. spectrum.ieee.org, 38. spectrum.ieee.org, 39. postquantum.com, 40. postquantum.com, 41. spectrum.ieee.org, 42. thequantuminsider.com, 43. thequantuminsider.com, 44. thequantuminsider.com, 45. thequantuminsider.com, 46. thequantuminsider.com, 47. thequantuminsider.com, 48. thequantuminsider.com, 49. thequantuminsider.com, 50. thequantuminsider.com, 51. thequantuminsider.com, 52. thequantuminsider.com, 53. thequantuminsider.com, 54. tomorrowdesk.com, 55. www.ibm.com, 56. www.ibm.com, 57. thequantuminsider.com, 58. www.ibm.com, 59. www.ibm.com, 60. www.ibm.com, 61. www.ibm.com, 62. www.ibm.com, 63. spectrum.ieee.org, 64. spectrum.ieee.org, 65. thequantuminsider.com, 66. newsroom.ibm.com, 67. www.hpcwire.com, 68. www.ibm.com, 69. www.ibm.com, 70. www.ibm.com, 71. www.ibm.com, 72. www.ibm.com, 73. www.techmonitor.ai, 74. www.ibm.com, 75. newsroom.ibm.com, 76. tomorrowdesk.com, 77. tomorrowdesk.com, 78. www.ibm.com, 79. newsroom.ibm.com, 80. newsroom.ibm.com, 81. thequantuminsider.com, 82. www.hpcwire.com, 83. www.hpcwire.com, 84. newsroom.ibm.com, 85. newsroom.ibm.com, 86. insidehpc.com, 87. newsroom.ibm.com, 88. tomorrowdesk.com, 89. thequantuminsider.com, 90. insidehpc.com, 91. newsroom.ibm.com, 92. www.ibm.com, 93. newsroom.ibm.com, 94. www.techmonitor.ai, 95. spectrum.ieee.org, 96. insidehpc.com, 97. thequantuminsider.com, 98. tomorrowdesk.com, 99. postquantum.com, 100. www.techmonitor.ai