- Apple ha dato il via all’IA on-device nel 2017 con il Neural Engine dell’iPhone A11, abilitando Face ID e Animoji fino a 600 miliardi di operazioni al secondo.

- Nel 2023, il Neural Engine a 16 core dell’iPhone A17 Pro ha raggiunto circa 35 TOPS, alimentando funzioni di riconoscimento vocale, fotografia e traduzione direttamente sul dispositivo.

- Google Pixel 8 (2023) utilizza la NPU Tensor G3 per eseguire modelli IA on-device come Palm 2 per traduzione e sintesi offline.

- La Edge TPU di Google sulla Coral Dev Board offre 4 TOPS di elaborazione visiva consumando pochi watt.

- L’hardware Full Self-Driving di Tesla ha due NPU: HW3 (2019) offriva circa 144 TOPS, e HW4 (2023) circa 200–250 TOPS.

- NVIDIA Drive Thor (presentato nel 2024) può raggiungere fino a 2000 TOPS quando due chip sono collegati per carichi di lavoro IA automotive.

- La Hexagon NPU di Qualcomm Snapdragon 8 Gen 3 (2023) è il 98% più veloce della Gen 2, può eseguire LLM fino a 10 miliardi di parametri on-device, e ha ottenuto la più veloce Stable Diffusion mobile al mondo nelle dimostrazioni.

- Il Dimensity 9400 di MediaTek (2024) con una APU di sesta generazione alimenta il remastering fotografico AI di Oppo Find X8, segnalando l’espansione delle NPU su TV, IoT e auto entro il 2025.

- Meteor Lake di Intel, la 14a generazione Core (lanciata nel 2023; rinominata Core Ultra nel 2024), include una NPU integrata che offre circa 8–12 TOPS, con Arrow Lake a ~13 TOPS e Lunar Lake che si vocifera arrivi a circa 45 TOPS.

- Ryzen 7040 Phoenix di AMD (2023) ha introdotto il Ryzen AI Engine con fino a 10 TOPS, mentre Ryzen 8000 desktop (inizio 2024) offriva 39 TOPS prima che AMD sospendesse le NPU in quella generazione.

In breve: Il tuo smartphone, la tua fotocamera e persino la tua auto stanno ricevendo cervelli AI integrati – senza bisogno del cloud. Chip speciali chiamati NPU (Neural Processing Units) e TPU (Tensor Processing Units) stanno trasformando i dispositivi di tutti i giorni in assistenti intelligenti capaci di riconoscimento facciale, comandi vocali, traduzione in tempo reale, funzioni di guida autonoma e altro ancora. Questa rivoluzione dell’IA on-device promette risposte fulminee, maggiore privacy e nuove funzionalità che una volta pensavamo possibili solo con i supercomputer. In questo report, demistificheremo NPU e TPU, vedremo come si differenziano da CPU/GPU, ed esploreremo perché giganti tech come Apple, Google, Qualcomm e Intel stanno correndo per inserire questi “cervelli AI” in tutto, dai telefoni alle auto. Metteremo anche in evidenza le ultime innovazioni 2024–2025, le opinioni degli esperti, gli standard di settore e cosa ci riserva il futuro per l’IA on-device.

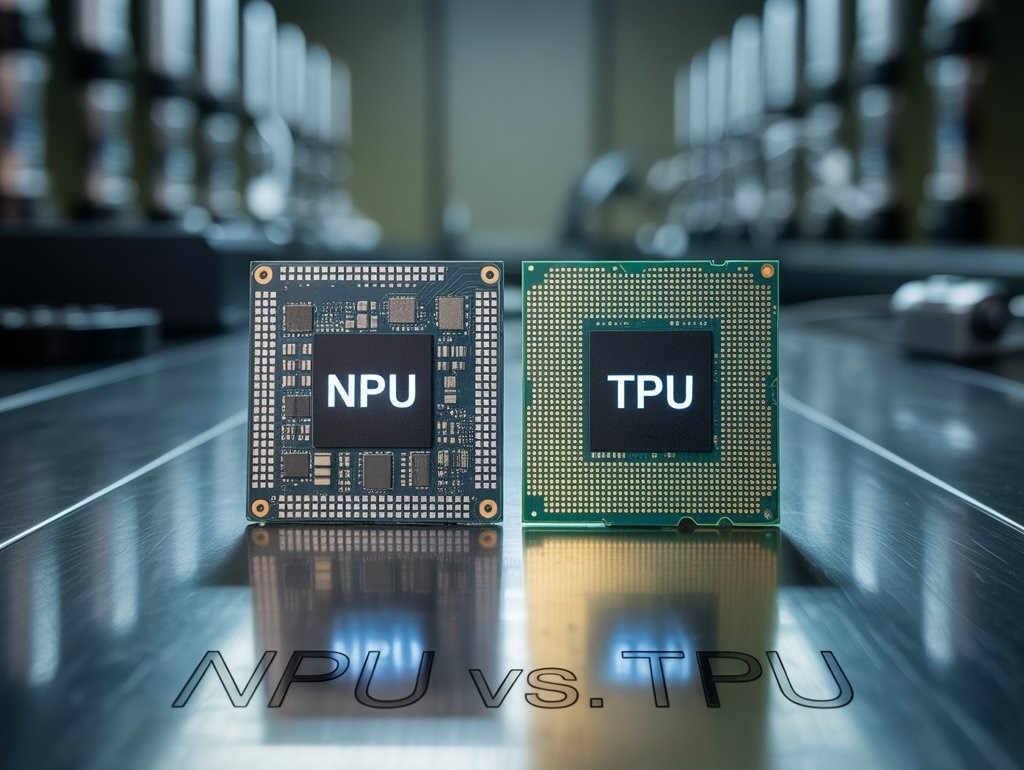

Cosa sono NPU e TPU? (Incontra il cervello AI del tuo dispositivo)

Le Unità di Elaborazione Neurale (NPU) sono processori specializzati progettati per accelerare le reti neurali artificiali – gli algoritmi che alimentano le moderne attività di IA come il riconoscimento delle immagini, l’elaborazione vocale e altro ancora. A differenza delle CPU generiche, le NPU sono circuiti integrati specifici per l’applicazione (ASIC) ottimizzati per la matematica delle matrici e i carichi di lavoro pesantemente paralleli delle reti neurali Techtarget. Una NPU “mima le reti neurali di un cervello umano per accelerare le attività di IA”, agendo essenzialmente come un cervello in silicio all’interno del tuo dispositivo Techtarget. Le NPU eccellono nell’eseguire l’inferenza (fare previsioni) per i modelli di IA in modo efficiente sul dispositivo, spesso utilizzando una precisione numerica inferiore (ad es. interi a 8 bit) per risparmiare energia pur offrendo alte prestazioni Backblaze. Il termine “NPU” viene talvolta usato in senso ampio per qualsiasi acceleratore di IA, ma più comunemente si riferisce a quelli presenti nei dispositivi mobili e edge Backblaze. Ad esempio, il “Neural Engine” di Apple negli iPhone e il motore IA mobile di Samsung sono NPU integrate nei loro design system-on-chip (SoC).

Le Tensor Processing Units (TPU), invece, sono stati originati da Google come chip personalizzati per accelerare il machine learning, in particolare per il framework TensorFlow. Un TPU è un tipo di ASIC ottimizzato per le operazioni sui tensori (moltiplicazioni di matrici, ecc.) che sono al centro dell’addestramento e dell’inferenza delle reti neurali Backblaze. Google ha implementato per la prima volta i TPU nei suoi data center nel 2015 per velocizzare i calcoli delle reti neurali, e successivamente li ha resi disponibili tramite Google Cloud Backblaze. I TPU utilizzano un’architettura distinta chiamata systolic array, che collega molte piccole unità di elaborazione in una griglia che fa fluire i dati attraverso una catena di unità di moltiplicazione di matrici Backblaze. Questo design raggiunge una velocità estrema nei compiti di deep learning. I TPU di Google sacrificano deliberatamente un po’ di precisione (usando calcoli a 8 o 16 bit invece dei float a 32 bit) per ottenere enormi vantaggi in termini di velocità ed efficienza Backblaze, poiché molti compiti di IA non richiedono un’elevata precisione per ottenere risultati accurati. Sebbene “TPU” si riferisca tecnicamente ai chip di Google, il termine viene talvolta usato in modo più generico per qualsiasi acceleratore “tensor”. Da notare che Google produce anche i co-processori Edge TPU per l’IA on-device in prodotti come Coral Dev Board, offrendo 4 trilioni di operazioni al secondo con pochi watt 1 .

In breve: NPU e TPU sono entrambi acceleratori in silicio per l’IA, ma le NPU sono comunemente integrate in dispositivi mobili/edge per un’efficiente inferenza on-device, mentre i TPU (in senso stretto) sono stati chip ad alte prestazioni (e ora moduli) principalmente di Google, originariamente per compiti di addestramento e inferenza cloud/datacenter. Entrambi si discostano dai design tradizionali di CPU/GPU per dare priorità alle operazioni matematiche parallele per le reti neurali. Come ha detto un editor tecnologico, “I TPU portano la specializzazione oltre, concentrandosi sulle operazioni sui tensori per ottenere velocità ed efficienze energetiche superiori… Le NPU sono diffuse nei dispositivi abilitati all’IA come smartphone e gadget IoT” 2 .

In cosa sono diversi NPU e TPU rispetto a CPU e GPU?

Le tradizionali CPU (unità di elaborazione centrale) sono il “cervello” dell’informatica generale – ottimizzate per la flessibilità, in modo da gestire tutti i tipi di compiti, dall’esecuzione del sistema operativo alla navigazione web. Dispongono di pochi core potenti che eccellono nella logica sequenziale e nelle istruzioni variegate, ma non sono adatte ai calcoli matematici altamente paralleli necessari per il deep learning Techtarget. Quando a una CPU viene chiesto di elaborare una grande rete neurale, spesso diventa un collo di bottiglia, cercando di eseguire milioni di moltiplicazioni e addizioni in sequenza o in lotti paralleli limitati. Questo porta ad alta latenza e consumo energetico (il cosiddetto collo di bottiglia di Von Neumann, dovuto al trasferimento di grandi quantità di dati tra CPU e memoria) Backblaze. Le CPU possono svolgere alcuni lavori di IA (soprattutto modelli più semplici o piccoli, o la logica di controllo per programmi di IA Techtarget), ma in generale faticano a scalare in modo efficiente alle richieste dell’IA moderna di algebra lineare massicciamente parallela.

Le GPU (unità di elaborazione grafica) hanno portato il calcolo parallelo in primo piano. Originariamente create per il rendering delle immagini eseguendo molte operazioni semplici in parallelo su pixel e vertici, le GPU si sono rivelate adatte anche all’addestramento delle reti neurali, che prevedono anch’esse l’applicazione simultanea delle stesse operazioni matematiche (prodotti scalari, ecc.) su grandi quantità di dati Techtarget. Una GPU contiene centinaia o migliaia di piccoli core che possono eseguire calcoli in parallelo. Questo rende le GPU eccellenti per l’IA su larga scala, e per tutto il 2010 le GPU (soprattutto quelle NVIDIA con il software CUDA) sono diventate il cavallo di battaglia della ricerca sul deep learning. Tuttavia, le GPU sono ancora in parte generiche – devono gestire vari compiti grafici e mantenere una certa flessibilità, quindi non sono ottimizzate al 100% per le reti neurali. Consumano anche molta energia e richiedono una programmazione attenta per essere sfruttate appieno (non amano il codice con molti rami condizionali e danno il meglio con compiti semplificati e paralleli sui dati) 3 .

Le NPU e le TPU portano la specializzazione ancora oltre. Sono progettate appositamente per solo il carico di lavoro delle reti neurali. Questo significa che la loro architettura può eliminare tutto ciò che non è necessario per la matematica dell’IA e dedicare più silicio a elementi come unità di moltiplicazione di matrici, addizionatori di accumulo e memoria on-chip per trasferire rapidamente i dati dentro e fuori da queste unità matematiche. Una TPU di Google Cloud, ad esempio, è essenzialmente una gigantesca matrice 2D di unità MAC (multiply-accumulate) con un’architettura di flusso dati intelligente (la matrice sistolica) che le alimenta con operandi ad alta velocità Backblaze. Non si preoccupa di cache, esecuzione speculativa o altre funzionalità della CPU – è ottimizzata per la matematica delle matrici. Le NPU nei chip mobili integrano in modo simile core del motore neurale dedicati accanto alla CPU/GPU. Questi core spesso usano aritmetica a bassa precisione (ad es. interi a 8 bit come le TPU) ed eseguono calcoli altamente paralleli “strato per strato” per cose come le reti neurali convoluzionali. Una NPU può utilizzare un’architettura “fusa” che combina unità scalari, vettoriali e tensoriali (la Hexagon NPU di Qualcomm fa questo) per gestire in modo efficiente diverse operazioni di reti neurali 4 .

Le differenze chiave si riducono a:

- Set di istruzioni e flessibilità: le CPU hanno un set di istruzioni ampio e generale (possono fare molte cose, ma non tutte contemporaneamente). Le GPU hanno un set di istruzioni più limitato ma comunque flessibile, ottimizzato per la velocità nei calcoli matematici. Le NPU/TPU hanno un set di istruzioni molto ristretto – essenzialmente solo le operazioni necessarie per le reti neurali (moltiplicazione di matrici, convoluzione, funzioni di attivazione), spesso implementate come pipeline fisse o array Wikichip. Ad esempio, la NPU per la guida autonoma di Tesla ha solo 8 istruzioni nella sua ISA, focalizzate su letture/scritture DMA e prodotti scalari 5 .

- Parallelismo e core: CPU = pochi core potenti; GPU = migliaia di core semplici; NPU/TPU = in un certo senso, decine di migliaia di ALU molto semplici (le unità MAC) strutturate a matrice o in stile rete neurale. Un singolo chip NPU può eseguire decine di trilioni di operazioni al secondo – la NPU dell’auto Tesla funziona a 2 GHz con 9.216 MAC, raggiungendo ~37 tera-operazioni al secondo (TOPS) per core, e ogni chip FSD ha due NPU per ~74 TOPS Wikichip, ts2.tech. Al contrario, una CPU di fascia alta può arrivare solo a poche centinaia di miliardi di operazioni/sec nei compiti di IA, e una GPU forse a pochi TOPS se non usa core tensor speciali.

- Architettura della memoria: NPU/TPU si basano su memoria veloce on-chip e streaming dei dati. Le TPU evitano il classico collo di bottiglia della memoria usando il flusso dati sistolico – ogni piccola unità passa i dati alla successiva in sincronia, minimizzando letture/scritture dalla memoria principale Backblaze. Molte NPU includono blocchi di SRAM on-chip per pesi/attivazioni (ad es. i core NPU di Tesla hanno 32 MB di SRAM ciascuno per mantenere localmente i dati della rete neurale) Semianalysis. Questo contrasta con GPU/CPU che usano pesantemente DRAM esterna.

- Precisione: CPU/GPU di solito lavorano con float a 32 o 64 bit. Gli acceleratori AI spesso usano interi a 16 o 8 bit (e alcuni ora esplorano 4 bit o persino 2 bit) perché le reti neurali tollerano precisione più bassa. I progettisti delle TPU di Google hanno esplicitamente notato che non serve la piena precisione float per l’inferenza, analogo a “non serve sapere esattamente quante gocce di pioggia cadono per capire che sta piovendo forte” Backblaze. Questo permette a NPU/TPU di eseguire più operazioni in parallelo e consumare meno energia per operazione.

- Casi d’uso: Le GPU sono ancora ampiamente usate per il training di grandi modelli e per il calcolo flessibile (e sono comuni nei data center e nei PC di fascia alta). Le TPU (cloud) puntano al training e inferenza su larga scala nell’ecosistema Google. Le NPU si trovano più spesso in edge devices – smartphone, fotocamere, elettrodomestici – che fanno inference su modelli già addestrati. Eccellono in compiti come applicare un modello di visione a un frame di una fotocamera in tempo reale, o eseguire il rilevamento continuo della parola di attivazione di un assistente vocale a basso consumo. Come ha notato TechTarget: “Le GPU sono scelte per disponibilità e rapporto costo-efficacia in molti progetti ML; le TPU sono di solito più veloci e meno precise, usate da aziende su Google Cloud; le NPU si trovano comunemente in dispositivi edge/mobile per un’elaborazione locale significativamente più veloce” 6 .

In sintesi, CPU = organizzatori versatili, GPU = cavalli da tiro paralleli, TPU/NPU = specialisti delle reti neurali. Tutti possono cooperare – infatti, in un dispositivo moderno abilitato all’IA, la CPU spesso coordina i compiti e delega le parti più pesanti dal punto di vista matematico alla NPU/GPU secondo necessità Techtarget. Questa tendenza alla specializzazione esiste perché una soluzione unica non è più adatta a tutti nell’informatica: come ha scherzato un editor, “aggiungere milioni di transistor in più per ogni esigenza non era efficiente… i progettisti hanno adottato processori costruiti su misura” Techtarget. Le NPU e le TPU costruite su misura accelerano drasticamente i calcoli di IA mantenendo basso il consumo energetico – un equilibrio fondamentale sia per i dispositivi a batteria che per i server ad alta densità.

Perché l’IA sul dispositivo? (Edge vs. Cloud)

Perché preoccuparsi di eseguire l’IA sul tuo telefono o sulla tua auto – perché non inviare semplicemente tutto al cloud dove enormi server (con GPU/TPU) possono occuparsi del lavoro pesante? Ci sono diverse ragioni convincenti che guidano il passaggio verso la IA sul dispositivo, e si riducono a velocità, privacy, costo e affidabilità 7 :

- Risposta istantanea (bassa latenza): Una NPU sul dispositivo può elaborare i dati in tempo reale senza il ritardo del viaggio di andata e ritorno verso un server cloud. Questo è cruciale per compiti di IA interattivi o critici per la sicurezza. Ad esempio, un sistema di guida autonoma di un’auto che utilizza NPU a bordo può identificare un pedone e frenare immediatamente, in pochi millisecondi, invece di attendere il calcolo nel cloud. Una telecamera intelligente con una NPU può rilevare un intruso nel momento stesso in cui appare nell’inquadratura. Sul tuo telefono, l’IA sul dispositivo significa che il tuo assistente vocale può rispondere più velocemente e in modo più naturale perché non “chiama casa” continuamente. La latenza ridotta consente un vero processo decisionale in tempo reale e un’esperienza utente più fluida 7 .

- Privacy e sicurezza dei dati: L’IA on-device mantiene i tuoi dati locali. Invece di trasmettere l’audio del microfono o il feed della fotocamera al cloud per l’analisi, l’elaborazione avviene all’interno del dispositivo. Questo riduce notevolmente l’esposizione di dati sensibili. Ad esempio, gli smartphone moderni eseguono il riconoscimento facciale (Face ID, ecc.) interamente sul dispositivo – la mappa biometrica del tuo volto non lascia mai l’area sicura del telefono. Allo stesso modo, un apparecchio acustico AI o un wearable sanitario possono analizzare i dati biometrici senza caricarli su alcun server, preservando la privacy. Considerate le crescenti preoccupazioni degli utenti e le normative sulla sovranità dei dati, questo è un vantaggio importante. Come ha affermato un blog sull’edge AI, l’elaborazione on-device significa che “i dati dell’utente non devono essere trasmessi al cloud,” offrendo un beneficio di privacy di base Nimbleedge. (Ovviamente, la privacy non è automatica – gli sviluppatori devono comunque gestire con attenzione i dati memorizzati – ma è più facile fidarsi di dispositivi che non inviano costantemente le tue informazioni all’esterno.) I CEO tecnologici spesso sottolineano questo aspetto. Il CEO di Qualcomm Cristiano Amon ha osservato che combinare l’intelligenza cloud e quella on-device può migliorare la personalizzazione mantenendo però i dati sicuri sul dispositivo – lui la definisce un “futuro ibrido” in cui l’IA on-device collabora con quella cloud per il meglio di entrambi i mondi 8 .

- Disponibilità offline e affidabilità: I dispositivi con NPU/TPU non dipendono dalla connettività. Possono funzionare in una galleria della metropolitana, su un aereo, in aree rurali remote o durante interruzioni di rete. Questo è fondamentale per l’affidabilità. Una funzione di dettatura vocale on-device funzionerà anche senza segnale. Un drone con visione AI a bordo può evitare ostacoli anche fuori rete. Questa indipendenza è inoltre cruciale per i sistemi mission-critical: ad esempio robot per il recupero in caso di disastri o dispositivi medici che non possono contare su una connessione internet attiva. La “funzionalità offline” è un vantaggio chiave dell’IA on-device Nimbleedge – garantisce che la funzione AI sia disponibile sempre e ovunque serva.

- Efficienza dei costi su larga scala: Inviare costantemente dati grezzi al cloud per l’elaborazione AI può essere molto costoso (l’elaborazione cloud non è gratuita) e richiede molta banda. Con la proliferazione delle funzioni AI, le aziende dovrebbero sostenere enormi costi di elaborazione cloud se ogni piccola attività venisse inviata a un server. Facendo di più sull’edge, si riducono i carichi sui server cloud e l’uso della rete. Spesso è più efficiente spendere qualche euro in più per un chip migliore nel dispositivo che pagare per gigabyte di elaborazione cloud durante la vita del dispositivo. Un’analisi di settore di Futurum ha osservato che l’elaborazione on-device aiuta a risolvere i problemi di scalabilità e costo dell’AI generativa – “distribuisce” il carico così che i data center non vengano sovraccaricati (e utenti/sviluppatori non debbano pagare cifre esorbitanti per il tempo GPU nel cloud) 9 .

- Personalizzazione & Contesto: Un motivo emergente: l’IA on-device può apprendere e adattarsi al contesto locale in un modo che l’IA cloud potrebbe non riuscire a fare. Il tuo smartphone può mantenere un piccolo modello locale che apprende il tuo stile di scrittura per un autocorrezione migliore, senza condividere quel modello linguistico personale nel cloud. I dispositivi possono fondere dati da più sensori in tempo reale (cosa più facile da fare localmente che trasmettere una serie di flussi di sensori al cloud). Questo può abilitare un’esperienza più personalizzata e consapevole del contesto. Alcune funzionalità come il federated learning permettono persino ai dispositivi di migliorare i modelli di IA in modo collaborativo senza caricare dati grezzi (inviando solo piccoli aggiornamenti dei pesi).

- Regolamentazione e Sovranità dei Dati: Leggi come il GDPR europeo e vari requisiti di localizzazione dei dati impongono sempre più spesso che certi dati (soprattutto personali o sensibili) non vengano inviati all’estero o a terze parti senza consenso. L’IA on-device offre un modo per conformarsi elaborando i dati alla fonte. Ad esempio, strumenti di IA per imaging medico possono funzionare su hardware ospedaliero (server edge con NPU) così che i dati dei pazienti non lascino mai la struttura, rispettando le normative sulla privacy. Il rapporto NimbleEdge 2025 evidenzia come i governi stiano spingendo per più inferenza locale per motivi di sovranità e conformità 10 .

Tutti questi fattori stanno guidando un cambio di paradigma: invece di pensare “cloud-first” per l’IA, ora le aziende progettano le funzionalità di IA “device-first” quando possibile. Come ha riassunto Durga Malladi, VP AI di Qualcomm: “Per scalare efficacemente l’IA generativa nel mainstream, l’IA dovrà funzionare sia sul cloud che sui dispositivi edge… come smartphone, laptop, veicoli e dispositivi IoT” Iconnect007. Ci stiamo muovendo verso un mondo ibrido di IA dove l’addestramento pesante e i grandi modelli possono risiedere nel cloud, ma molti compiti di inferenza e le esperienze di IA personale vengono eseguiti localmente sulle NPU/TPU nelle tue mani e nelle tue case. In effetti, Amon lo definisce un “punto di svolta nell’IA” – inferenza on-device senza latenza, dove “il futuro dell’IA è personale” perché gira proprio dove sei tu 11 .

IA On-Device in Azione: dagli Smartphone alle Auto a Guida Autonoma

Chip AI specializzati sono già integrati in una vasta gamma di dispositivi intorno a te, spesso rendendoli più intelligenti in modo invisibile. Ecco alcune delle principali aree in cui NPU e edge TPU sono impiegate:

- Smartphone e tablet: Quasi tutti i telefoni di punta moderni (e persino molti di fascia media) ora includono una NPU o un motore AI dedicato. Apple ha dato il via a questa tendenza nel 2017 con la Apple Neural Engine nel chip A11 dell’iPhone, abilitando Face ID e Animoji direttamente sul dispositivo grazie a una capacità di elaborazione fino a 600 miliardi di operazioni al secondo Fandom. Oggi, il chip A17 Pro di Apple (2023) integra una Neural Engine a 16 core capace di 35 trilioni di operazioni al secondo Fandom. Questo alimenta funzioni come il rilevamento avanzato delle scene della fotocamera, stili fotografici, comandi vocali Siri elaborati offline, correzione automatica, trascrizione in tempo reale e persino l’esecuzione di modelli transformer per la traduzione direttamente sul dispositivo. Anche i telefoni Pixel di Google hanno un silicio personalizzato (“Google Tensor” SoC) con NPU: il più recente Tensor G3 in Pixel 8 è stato “progettato su misura per eseguire i modelli AI di Google”, migliorando ogni parte del chip (CPU, GPU, ISP) per aprire la strada a AI generativa on-device Blog. Pixel 8 può eseguire i più avanzati modelli di sintesi vocale e traduzione di Google localmente, gli stessi che prima erano confinati ai data center Blog. Esegue anche complesse funzioni fotografiche come la fusione di foto di gruppo “Best Take” e Audio Magic Eraser utilizzando una suite di modelli AI direttamente sul dispositivo Blog. Samsung e altri produttori Android utilizzano i chipset Snapdragon di Qualcomm, i cui ultimi NPU (motore Hexagon AI) possono persino eseguire modelli linguistici di grandi dimensioni sul telefono – Qualcomm ha dimostrato l’esecuzione di un LLM da 10 miliardi di parametri e persino la generazione di immagini Stable Diffusion su un telefono con Snapdragon 8 Gen 3 Futurumgroup. Il motore AI di questo chip è il 98% più veloce della generazione precedente e supporta la precisione INT4 per una maggiore efficienza Futurumgroup. Risultato pratico: il tuo telefono del 2024 può fare cose come riassumere articoli, rispondere a domande o modificare foto con l’AI senza bisogno del cloud. Anche le funzioni di accessibilità ne beneficiano: ad esempio, i telefoni Pixel ora dispongono di digitazione vocale sul dispositivo, sottotitoli in tempo reale e una prossima funzione per descrivere le immagini agli utenti non vedenti utilizzando un modello locale.

- Telecamere intelligenti e sistemi di sicurezza: Le telecamere abilitate all’IA utilizzano NPU integrate per rilevare persone, volti, animali o comportamenti sospetti istantaneamente. Ad esempio, le ultime telecamere di sicurezza di EnGenius includono una NPU integrata che gestisce il rilevamento degli oggetti e converte i video in metadati direttamente sulla telecamera, eliminando la necessità di un videoregistratore separato e aumentando la sicurezza (poiché il video può essere analizzato e archiviato localmente) Engeniustech. Questo significa che la tua telecamera di sicurezza può decidere “persona presente” o “pacco consegnato” e inviare solo quell’avviso, invece di trasmettere ore di filmati a un servizio cloud. Allo stesso modo, dispositivi consumer come Google Nest Cam IQ avevano un chip di visione integrato (Google Edge TPU) per riconoscere volti familiari e distinguere tra esseri umani e animali domestici nel suo campo visivo. Anche le fotocamere DSLR e mirrorless stanno aggiungendo processori IA per funzioni come il tracking del soggetto, l’autofocus sugli occhi e l’ottimizzazione della scena in tempo reale. Nei droni, i chip IA a bordo aiutano nell’evitare ostacoli e nella navigazione visiva senza richiedere il controllo remoto. In particolare, Edge TPU di Google (un piccolo modulo ASIC) è diventato un componente aggiuntivo popolare per telecamere IoT industriali e fai-da-te – fornisce 4 TOPS di potenza di elaborazione visiva per compiti come il rilevamento di persone o la lettura di targhe, utilizzando solo ~2 watt 1 .

- Dispositivi smart home e IoT: Oltre agli smartphone, molti dispositivi smart home hanno mini NPU. Gli altoparlanti attivati dalla voce (Amazon Echo, Google Nest Hub, ecc.) ora spesso includono chip di riconoscimento vocale locale. Amazon ha sviluppato il processore AZ1 Neural Edge per i dispositivi Echo per velocizzare il rilevamento della parola di attivazione di Alexa e le risposte sul dispositivo, dimezzando la latenza Embedl. L’AZ1 (realizzato con MediaTek) esegue una rete neurale che riconosce “Alexa” ed elabora comandi semplici senza raggiungere il cloud Embedl. Questo non solo rende Alexa più reattiva, ma mantiene anche più dati vocali privati. Allo stesso modo, molte nuove TV, elettrodomestici e persino giocattoli hanno un po’ di IA all’edge – ad esempio, la telecamera di un frigorifero intelligente può identificare i cibi e le date di scadenza localmente. I dispositivi indossabili meritano anch’essi una menzione: il chip S9 di Apple Watch ha aggiunto un Neural Engine a 4 core per gestire meglio gli algoritmi IA per la salute e le richieste Siri direttamente sull’orologio Fandom. E sul fronte industriale, i sensori IoT con NPU possono eseguire il rilevamento di anomalie sui dati delle apparecchiature direttamente all’edge, segnalando solo gli eventi rilevanti a monte (risparmiando banda e rispondendo più rapidamente ai problemi).

- Automobili (ADAS e Autonomia): Le auto sono diventate dei centri AI su ruote. I sistemi avanzati di assistenza alla guida (ADAS) e le funzionalità di guida autonoma si basano su una serie di acceleratori AI a bordo per interpretare i flussi delle telecamere, LiDAR, radar e prendere decisioni di guida in una frazione di secondo. Tesla ha progettato il proprio FSD (Full Self-Driving) Computer con due chip NPU. Il chip FSD di Tesla (HW3, introdotto nel 2019) offriva 144 TOPS (due NPU da 72 TOPS ciascuna); il più recente HW4 (2023) porta questo valore a circa 200–250 TOPS totali (due NPU a 7nm da oltre 100 TOPS ciascuna) ts2.tech. Questo consente all’auto di elaborare simultaneamente video a piena risoluzione da 8 telecamere, sonar, ecc., tramite reti neurali per la percezione e persino di eseguire alcuni modelli linguistici per i comandi vocali – tutto localmente all’interno del modulo dell’auto. Piattaforme concorrenti come NVIDIA Drive e Qualcomm Snapdragon Ride integrano anch’esse NPU. L’ultimo chip supercomputer per auto di NVIDIA, Drive Thor, previsto per le auto del 2025, vanta fino a 1.000 TOPS su un singolo chip (e 2.000 TOPS quando ne vengono accoppiati due) per supportare l’autonomia di Livello 4 ts2.tech. Combina una GPU, una CPU e acceleratori di deep learning dedicati, così da poter gestire tutto, dal riconoscimento dei segnali stradali al monitoraggio del conducente tramite AI direttamente sul chip ts2.tech. Queste NPU sono letteralmente salva-vita: un’auto autonoma non può aspettare i server cloud se un bambino corre in strada. L’AI a bordo deve vedere e reagire in poche decine di millisecondi. Oltre alle auto passeggeri, si trova anche un ampio utilizzo dell’edge AI in droni autonomi, robot per le consegne e veicoli industriali che navigano e prendono decisioni con NPU/TPU a bordo (ad esempio, i robot per le consegne di Nuro e molti sistemi di camion a guida autonoma utilizzano chip AI NVIDIA o Huawei sul dispositivo).

- Edge Computing e Industria: In contesti industriali e aziendali, l’IA on-device spesso si presenta sotto forma di edge server o gateway con acceleratori AI. Invece di inviare i flussi delle telecamere o i dati dei sensori a un cloud centrale, le aziende installano edge box (a volte basati su GPU, altre su NPU/FPGA) in sede. Questi gestiscono compiti come l’analisi video in tempo reale per il controllo qualità su una linea di produzione, rilevando difetti tramite visione AI in pochi microsecondi. Anche i dispositivi sanitari sono un esempio: un’ecografia portatile o una risonanza magnetica possono avere una NPU per eseguire l’analisi delle immagini AI direttamente sul dispositivo, così i medici ricevono un aiuto diagnostico istantaneo senza bisogno di una connessione internet (il che è anche meglio per la privacy dei dati dei pazienti). Retail e città adottano anch’essi l’IA all’edge – ad esempio telecamere intelligenti per il traffico con NPU per analizzare la congestione e regolare i semafori, oppure telecamere sugli scaffali dei negozi che monitorano l’inventario. Molti di questi usano NPU specializzate come i chip Intel Movidius Myriad, Edge TPU di Google o nuovi arrivati come Hailo-8 (una NPU israeliana che offre 26 TOPS in pochi watt per le telecamere). Il filo conduttore è che questi acceleratori permettono che l’analisi avvenga localmente, ottenendo risultati in tempo reale e facendo transitare sulle reti solo insight di alto livello (anziché dati grezzi).

La versatilità di NPU/TPU tra i diversi tipi di dispositivi è impressionante. Un momento abilitano il tuo telefono a sfocare lo sfondo di una foto con l’IA e quello dopo guidano un drone o analizzano immagini mediche. Le fotocamere degli smartphone ora usano le NPU per funzioni come la modalità Notte (aggregando più fotogrammi in modo intelligente), l’effetto bokeh in modalità Ritratto, il riconoscimento delle scene (il telefono capisce che stai fotografando un “tramonto” e ottimizza i colori tramite IA), e persino per effetti AR divertenti (Animoji che mappano il tuo volto, o filtri Snapchat che seguono i tuoi movimenti – tutto grazie alle reti neurali on-device). La biometria usa le NPU: scanner di impronte digitali migliorati con IA per il rilevamento della vitalità, sblocco facciale con sensori di profondità e IA. L’audio le sfrutta anch’esso: la cancellazione del rumore in auricolari e telefoni è ora spesso guidata dall’IA, con le NPU che separano la voce dal rumore di fondo in tempo reale.

Un esempio concreto di innovazione nel 2024: Oppo (il produttore di smartphone), in collaborazione con MediaTek, ha annunciato di aver implementato un modello AI Mixture-of-Experts (MoE) direttamente sul dispositivo a fine 2024 – a quanto pare il primo a farlo su uno smartphone Grandviewresearch. Questa avanzata architettura di rete neurale (MoE) può aumentare le prestazioni attivando solo le “sotto-reti esperte” rilevanti per ogni compito, e farlo on-device significa che i telefoni Oppo possono ottenere elaborazione AI più veloce e migliore efficienza energetica per compiti complessi, senza bisogno di assistenza dal cloud Grandviewresearch. Questo sottolinea come anche la ricerca AI più avanzata stia rapidamente arrivando nei nostri dispositivi portatili grazie a NPU sempre migliori.

Dentro i chip AI del 2025: le ultime novità da Apple, Google, Qualcomm e altri

La corsa a costruire hardware AI on-device migliore si è intensificata rapidamente. Ecco cosa hanno lanciato di recente (2024–2025) le principali aziende in termini di NPU/TPU e silicio AI:

- Apple: La strategia di Apple sui chip personalizzati ha da tempo posto l’accento sul machine learning direttamente sul dispositivo. Ogni anno, il Neural Engine di Apple è cresciuto in potenza. Nell’iPhone 15 Pro del 2023, il chip A17 Pro ha raggiunto con il suo Neural Engine 35 TOPS (trilioni di operazioni al secondo) con 16 core Fandom. Questo era il doppio della potenza grezza dell’NPU dell’A16, e Apple lo ha sfruttato per abilitare funzioni come il riconoscimento vocale di Siri direttamente sul dispositivo (finalmente elaborando molte richieste Siri senza internet) e nuove capacità della fotocamera (come la modalità Ritratto catturata automaticamente e la traduzione in tempo reale del testo tramite la fotocamera). I chip Apple del 2024 hanno continuato questa tendenza: la famiglia M3 per Mac (fine 2023) ha ricevuto un Neural Engine aggiornato (curiosamente ottimizzato per 18 TOPS nel chip base M3, puntando di più sull’efficienza) Fandom. Nel 2024, Apple ha introdotto il chip M4 (per iPad/Mac di fascia alta, metà 2024) che avrebbe portato il Neural Engine a 38 TOPS su un processo raffinato a 3nm Fandom. Oltre ai numeri, Apple ha utilizzato davvero quell’NPU: funzioni come Personal Voice (che crea un clone della voce dell’utente dopo 15 minuti di addestramento) funzionano privatamente sul Neural Engine degli iPhone, e le trascrizioni Live Voicemail avvengono localmente. Apple ha anche integrato le NPU in tutte le sue categorie di dispositivi – persino gli AirPods Pro hanno un piccolo chip neurale per l’Audio Adattivo. I dirigenti Apple sottolineano spesso l’aspetto privacy: “machine learning sul tuo dispositivo” significa che i tuoi dati restano con te. Entro il 2025, ci si aspetta che il Neural Engine di Apple possa espandersi ulteriormente o diventare disponibile alle app di terze parti in nuovi modi (già ora Core ML permette agli sviluppatori di usarlo, ma Apple potrebbe aprire ulteriormente l’accesso alle API neurali). Si vocifera anche che Apple stia progettando un acceleratore AI autonomo per futuri occhiali o auto, ma i prodotti attuali mostrano che preferiscono NPU integrate nei loro SoC delle serie A e M.

- Google: Google non solo ha fatto da pioniere con la cloud TPU, ma ha anche puntato molto sull’AI on-device per i telefoni Pixel e i dispositivi consumer. Il Google Tensor SoC (introdotto per la prima volta nel 2021 con Pixel 6) era unico perché Google, famosa per il cloud, ha realizzato un chip per telefoni in grado di eseguire l’AI direttamente sul dispositivo. Con il Tensor G3 (nel Pixel 8 del 2023), Google ha evidenziato aggiornamenti che permettono l’AI generativa on-device. Google ha dichiarato esplicitamente che il chip del Pixel 8 porta “la ricerca sull’AI di Google direttamente nei nostri telefoni più recenti” Blog. La TPU di nuova generazione del Tensor G3 (Google chiama ancora internamente il core AI “TPU”) permette al Pixel di eseguire modelli avanzati come Palm 2 o Gemini Nano (versioni ridotte dei grandi modelli linguistici di Google) direttamente sul dispositivo, per funzioni come il riassunto di siti web o il miglioramento della digitazione vocale Reddit. Una funzione di punta: Pixel 8 può eseguire localmente il miglior modello text-to-speech di Google (quello usato nei data center), permettendo al telefono di leggere le pagine web ad alta voce con voci naturali e persino tradurle in tempo reale, tutto offline Blog. Google utilizza inoltre la TPU nei Pixel per la fotografia (imaging multi-frame “HDR+”, rimozione di oggetti Magic Eraser tramite AI inpainting Blog), per la sicurezza (sblocco facciale on-device tramite AI ora considerato abbastanza sicuro per i pagamenti Blog), e per la voce (l’Assistant che non si preoccupa se dici “ehm”). Oltre ai telefoni, Google offre la Coral Dev Board e una chiavetta USB per hobbisti e aziende che vogliono aggiungere Edge TPU ai loro progetti, ciascuna contenente la Edge TPU di Google che fornisce 4 TOPS per compiti di visione a bassissimo consumo Coral. Viene utilizzata anche in alcuni prodotti Google come il Nest Hub Max per il riconoscimento dei gesti. Per Google, integrare le TPU all’edge fa parte di una strategia più ampia: Sundar Pichai (CEO di Google) ha affermato che il futuro dell’AI consiste nell’arricchire ogni esperienza, e chiaramente Google ritiene che “per portare il potere trasformativo dell’AI nella vita quotidiana, devi poterla usare dal dispositivo che usi ogni giorno” Blog – da qui i chip Tensor. Possiamo aspettarci un Tensor G4 nei telefoni Pixel della fine del 2024, forse costruito sul nuovo processo di Samsung o TSMC, con ulteriori miglioramenti in prestazioni ed efficienza AI, e forse anche con AI multimodale on-device (combinando modelli visione+linguaggio).

- Qualcomm: Il principale fornitore di chip mobili per telefoni Android ha promosso in modo aggressivo il suo AI Engine nella serie Snapdragon. Il Snapdragon 8 Gen 2 (fine 2022) ha introdotto il supporto dedicato a INT4 e ha mostrato la generazione di immagini stable diffusion in tempo reale su un telefono. Il Snapdragon 8 Gen 3 (annunciato a fine 2023, nei telefoni di punta del 2024) rappresenta un salto importante: Qualcomm afferma che la sua Hexagon NPU è più veloce del 98% rispetto a quella della Gen 2 e il 40% più efficiente dal punto di vista energetico Futurumgroup. Questo chip può eseguire modelli linguistici di grandi dimensioni con fino a 10 miliardi di parametri interamente sul dispositivo, elaborando circa 20 token al secondo – abbastanza per conversazioni semplici con un assistente AI senza il cloud Futurumgroup. Ha inoltre raggiunto la “generazione di immagini Stable Diffusion più veloce al mondo” su un dispositivo mobile nelle demo Futurumgroup. Qualcomm ha dichiarato apertamente che l’AI generativa on-device è un punto chiave di vendita per i nuovi telefoni. Ad esempio, hanno collaborato con Meta per ottimizzare l’LLM open-source Llama 2 per Snapdragon, con l’obiettivo di permettere di eseguire una chatbot AI sul telefono entro il 2024 Iconnect007. (Un dirigente Qualcomm ha dichiarato: “applaudiamo l’approccio aperto di Meta… per scalare l’AI generativa, deve funzionare sia su cloud che su edge”, rafforzando la filosofia edge AI Iconnect007.) Oltre ai telefoni, Qualcomm sta inserendo NPUs nei chip per laptop (le piattaforme di calcolo Snapdragon per Windows su ARM) – e la loro piattaforma automobilistica Snapdragon Ride utilizza gli stessi core AI per offrire fino a 30 TOPS per ADAS, con una roadmap che arriva a centinaia di TOPS. Nel 2025, Qualcomm ha persino annunciato una nuova CPU Snapdragon X Elite per PC che include una potente NPU, segnalando l’intenzione di sfidare Apple e Intel sulle prestazioni AI nei computer personali. Con l’ascesa dell’AI on-device, Qualcomm sta effettivamente marchiando alcuni telefoni come “AI phones”. Prevedono che molte app (dalla fotografia alla messaggistica alla produttività) sfrutteranno la NPU. Sul lato software, Qualcomm ha rilasciato la Qualcomm AI Stack per unificare il supporto ai framework più diffusi (TensorFlow Lite, PyTorch, ONNX) sulle loro NPU Iconnect007 – cercando di rendere più facile per gli sviluppatori utilizzare l’hardware AI senza una profonda conoscenza dei chip.

- MediaTek: Il secondo produttore di chip mobile (noto per la serie Dimensity) ha anch’esso aggiornato le sue NPU. MediaTek chiama i suoi motori AI “APU” (AI Processing Unit). Ad esempio, il Dimensity 9200+ (2023) ha una APU di sesta generazione con un notevole aumento delle prestazioni rispetto al chip precedente, abilitando funzionalità come la stable diffusion on-device e la riduzione del rumore AI nei video. Nel 2024, MediaTek ha annunciato il Dimensity 9400, e in una partnership con Oppo, hanno utilizzato la sua avanzata architettura NPU per introdurre nuove funzionalità AI (come menzionato, il remastering fotografico AI di Oppo Find X8 con rimozione dei riflessi e eliminazione della sfocatura è alimentato dalla NPU di MediaTek) Mediatek. I dirigenti MediaTek si sono esplicitamente posizionati all’avanguardia dell’AI on-device. Come ha affermato Will Chen di MediaTek, “il futuro dell’AI va oltre il cloud; è guidato dall’edge computing direttamente nel palmo della tua mano.” Secondo loro, l’AI sui telefoni deve essere veloce, privata, sicura e sempre accessibile Mediatek. MediaTek ha persino avviato una collaborazione “APU-centrica” con Meta per supportare i framework Llama e con produttori di dispositivi come Oppo e Xiaomi focalizzandosi su funzionalità AI per fotocamera e voce. Entro il 2025, MediaTek prevede di implementare queste NPU non solo nei telefoni, ma anche in smart TV (per upscaling AI e miglioramento delle immagini), dispositivi IoT, e persino auto (MediaTek ha una piattaforma AI automotive e ha collaborato con Nvidia per integrare la proprietà intellettuale GPU Nvidia per le auto, presumibilmente fornendo la propria NPU per l’AI dei sensori).

- Intel: Il 2024 ha segnato l’ingresso di Intel negli acceleratori AI su PC mainstream. L’Intel Core di 14a generazione (Meteor Lake, lanciato a dicembre 2023 e rinominato Core Ultra nel 2024) è il primo processore PC x86 con una Neural Processor Unit (NPU) integrata. La NPU di Meteor Lake (a volte chiamata VPU – Vision Processing Unit – basata sulla tecnologia Movidius di Intel) offre circa 8–12 TOPS di prestazioni AI Pcworld. Questa viene utilizzata per accelerare le funzionalità AI di Windows 11 come sfocatura dello sfondo, contatto visivo nelle videochiamate, e potrebbe essere usata dalle app per cose come trascrizione locale, soppressione del rumore o anche piccoli assistenti AI. Microsoft e Intel insieme hanno promosso il concetto di “AI PC”. Intel afferma che queste NPU saranno presenti in decine di milioni di laptop nel 2024 Pcworld. Dopo Meteor Lake, la roadmap di Intel menziona Arrow Lake (per desktop nel 2024) che include anch’esso una NPU (circa 13 TOPS, leggermente migliorata) Pcworld. Curiosamente, il primo tentativo di Intel di una NPU desktop è stato in realtà superato da AMD (vedi sotto), e Intel ha scelto di adottare un design NPU modesto per evitare di sacrificare l’area GPU/CPU nei chip per appassionati Pcworld. Ma entro la fine del 2024, Intel ha segnalato che i futuri chip Lunar Lake avranno una NPU molto più potente (~45 TOPS) per soddisfare i requisiti “Copilot” di Microsoft Pcworld. Tutto ciò indica che Intel vede l’AI come un elemento imprescindibile per i PC del futuro – non per addestrare grandi modelli, ma per accelerare le esperienze quotidiane potenziate dall’AI (dal miglioramento della suite da ufficio agli strumenti creativi che usano AI locale). Intel vende anche acceleratori AI edge come i chip Intel Movidius Myriad (usati in alcuni droni, fotocamere) e gli acceleratori Habana per server, ma la NPU integrata di Meteor Lake rappresenta una pietra miliare che porta l’AI nei dispositivi consumer comuni.

- AMD: AMD è entrata nel settore dell’AI on-device circa nello stesso periodo. I processori per laptop Ryzen serie 7040 (Phoenix) rilasciati nel 2023 presentavano il primo Ryzen AI Engine – in sostanza una NPU XDNA integrata (tecnologia derivata dall’acquisizione di Xilinx da parte di AMD). Questa NPU offriva fino a 10 TOPS sul chip mobile Wikipedia. AMD ha promosso casi d’uso come videochiamate potenziate dall’AI, app di produttività e simili, in linea con gli obiettivi di Intel. Successivamente AMD ha lanciato brevemente una serie desktop Ryzen 8000 (inizio 2024) con una NPU che raggiungeva i 39 TOPS – un valore molto elevato per l’unità AI di una CPU general purpose, superando persino i piani di Intel Pcworld. Tuttavia, AMD ha rapidamente cambiato strategia e saltato una generazione, concentrandosi sulla sua prossima architettura (il successivo Ryzen 9000, previsto per la fine del 2024, ha eliminato la NPU per dare priorità agli upgrade dei core) Pcworld. Nonostante ciò, si prevede che AMD reintrodurrà le NPU nei futuri chip per PC (probabilmente si tratta di una pausa temporanea mentre lavorano per integrare un potente motore AI senza compromettere altre prestazioni). Sul fronte dei prodotti, le NPU di AMD potrebbero abilitare funzionalità interessanti poiché AMD dispone anche di GPU potenti – una combinazione che potrebbe gestire i carichi di lavoro AI in modo collaborativo (alcune parti sulla NPU, altre sulla GPU). AMD ha inoltre integrato core AI nei suoi SoC adattivi (basati su FPGA) e nei chip per il settore automobilistico. In sintesi, entro il 2025 tutti i produttori di chip x86 per PC hanno adottato le NPU, allineandosi a quanto fatto dagli smartphone qualche anno prima, indicando che l’accelerazione AI sta diventando una caratteristica standard per tutti.

- Altri: Anche una varietà di aziende specializzate in chip e altre società tecnologiche stanno innovando nel campo delle NPU. NVIDIA, nota per le GPU, ora include Tensor Cores dedicati nelle sue GPU e offre un NVDLA open source (acceleratore di deep learning) per l’integrazione in prodotti System-on-Chip. Nei dispositivi edge come la serie NVIDIA Jetson (usata in robot, droni, sistemi embedded), sono presenti sia la GPU che “DLA” a funzione fissa – essenzialmente NPU – che scaricano parte dell’inferenza delle reti neurali dalla GPU. Il modulo Orin di NVIDIA, ad esempio, ha 2 DLA oltre alla GPU, contribuendo ai suoi 254 TOPS di prestazioni AI per auto ts2.tech. Apple si dice stia lavorando su coprocessori AI ancora più avanzati o motori neurali più grandi per i suoi occhiali AR o progetti futuri, anche se i dettagli sono segreti. Huawei (nonostante le sfide geopolitiche) continua a progettare chip mobili Kirin con NPU (la loro architettura NPU “DaVinci”) e anche NPU di classe server nei chip Ascend AI – il chip Kirin 9000S del 2023 mantiene, secondo quanto riferito, una NPU potente per attività di immagine e linguaggio sui loro telefoni. Vediamo anche startup come Hailo, Mythic, Graphcore e altre offrire i propri chip AI edge: ad es. Hailo-8 come menzionato (26 TOPS in una scheda mini PCIe per telecamere AI), IPU di Graphcore per datacenter (non esattamente on-device, ma una nuova architettura per reti neurali), Mythic che lavora su NPU analogiche, ecc. ARM, i cui progetti sono alla base della maggior parte dei chip mobili, offre la serie Ethos NPU (come Ethos-U, Ethos-N78) che i produttori di chip possono integrare per ottenere un acceleratore AI pronto all’uso in SoC IoT o di fascia media. Questo ha permesso anche a player relativamente piccoli di includere NPU nei loro chip tramite la licenza del design ARM.

In sintesi, dalle big tech alle startup, tutti stanno investendo nel silicio AI on-device. Di conseguenza, stiamo assistendo a rapidi miglioramenti: nuovi chip con TOPS più elevati, migliore efficienza (TOPS per watt) e supporto per nuovi tipi di dati (come la quantizzazione a 4 bit per modelli più grandi). Ad esempio, gli ultimi chip di Qualcomm e MediaTek possono eseguire la precisione INT4, ottima per i modelli di AI generativa dove la larghezza di banda della memoria è un limite Androidauthority. Queste innovazioni si traducono direttamente in vantaggi per l’utente – ad es. editing video AI mobile in tempo reale (rimozione di oggetti da video 4K al volo, come può fare Snapdragon 8 Gen 3 con la funzione AI “Video Object Eraser” Futurumgroup), oppure coprocessori AI nelle auto che abilitano assistenti vocali funzionanti senza rete e con risposte rapide quanto una conversazione umana.

Notizie chiave dal 2024–2025: Lanci, benchmark e partnership

Per illustrare la velocità dei cambiamenti, ecco alcuni eventi principali nel mondo di NPU/TPU e AI on-device dalla fine del 2024 al 2025:

- Presentazioni di Apple M3 e M4 (ottobre 2023 e maggio 2024): Hanno introdotto Neural Engine di nuova generazione. Il Neural Engine dell’M3 raggiunge 18 TOPS (16-core), e l’M4 è passato a 38 TOPS (sempre 16-core ma con clock/efficienza superiori) Fandom. Apple ha dimostrato che questi chip gestiscono compiti intensivi come la generazione di immagini stable diffusion on-device in macOS (con Core ML Stable Diffusion, gli sviluppatori hanno mostrato ~15 secondi per generare un’immagine su un M2 – ancora più veloce su M3/M4).

- Lancio di Google Pixel 8 (ottobre 2023): Ha enfatizzato l’IA “ovunque” nel dispositivo. L’evento di Google ha mostrato il riassunto on-device delle pagine web e la traduzione in tempo reale degli articoli su Pixel 8, utilizzando la NPU Tensor G3. Ha anche introdotto “Assistant with Bard”, che in futuro eseguirà alcune interazioni direttamente sul dispositivo. Google ha sottolineato che Pixel 8 può eseguire il doppio dei modelli on-device rispetto a Pixel 6, e modelli molto più sofisticati Blog. In altre parole, un enorme salto in soli due anni di sviluppo dei chip Tensor.

- Partnership Qualcomm–Meta (luglio 2023): Qualcomm e Meta hanno annunciato che stanno ottimizzando il modello linguistico Llama 2 di Meta per funzionare completamente su Snapdragon NPU entro il 2024 Iconnect007. L’obiettivo è permettere agli sviluppatori di distribuire chatbot e app di AI generativa su telefoni, visori VR, PC, ecc., senza cloud. Questo è stato un importante riconoscimento dell’AI on-device da parte di un grande proprietario di modelli AI (Meta) e di un grande produttore di chip. A fine 2024, hanno seguito con piani per l’ottimizzazione anche di Llama 3 12 .

- PC Microsoft Windows 11 “Copilot” (2024): Microsoft ha fissato un benchmark definendo “AI PC” i computer con oltre 40 TOPS di accelerazione AI locale, rendendoli idonei a funzionalità AI avanzate (come l’integrazione dell’assistente digitale Copilot). Questo ha spinto gli OEM – Lenovo, Dell, ecc. – ad adottare chip con NPU (che siano Intel, AMD o Qualcomm) per soddisfare le specifiche. Il risultato è un’ondata prevista di laptop AI-ready nel 2024, con Microsoft che annuncia dozzine di modelli in arrivo e prevede oltre 40 milioni di spedizioni di AI PC nel 2024 13 .

- Breve NPU Ryzen 8000 di AMD (gennaio 2024): AMD ha annunciato una CPU desktop con una sorprendente NPU da 39 TOPS (una sorpresa, dato che i chip desktop di solito non hanno tali acceleratori) Pcworld. Sebbene quel particolare prodotto sia stato rapidamente superato, ha dimostrato che anche le CPU desktop possono avere silicio AI in grado di rivaleggiare con i chip mobili in termini di TOPS. Questa è stata anche la prima CPU desktop x86 a integrare una NPU (anticipando di poco Intel Arrow Lake).

- Demo di Tesla FSD Beta v12 (fine 2023): Elon Musk ha mostrato la guida end-to-end tramite AI (senza radar, solo reti neurali visive) in esecuzione sulle NPU HW3/HW4 di Tesla. Notevole il fatto che la rete neurale guidasse l’auto utilizzando i flussi video elaborati interamente sul computer dell’auto in tempo reale. Gli osservatori hanno notato che FSD v12 sfruttava appieno le 2× 100 TOPS NPU per la visione, e Tesla ha lasciato intendere che futuri upgrade (HW5) puntino a 2000 TOPS per gestire modelli ancora più grandi (ci sono state voci che l’HW5 di Tesla potrebbe puntare a 2 petaFLOPS = 2000 TOPS) 14 .

- NVIDIA Drive Thor svelato (GTC 2024): NVIDIA ha presentato i dettagli del suo prossimo chip automotive, Drive Thor, che offre l’equivalente di 2× la potenza AI del suo predecessore Orin – fino a 2000 TOPS con due chip collegati ts2.tech. In modo significativo, Thor è pensato per gestire non solo i compiti di guida ma anche l’AI in abitacolo (come il riconoscimento vocale e il monitoraggio degli occupanti) su un’unica piattaforma, mostrando come NPU e GPU insieme possano consolidare molte funzioni AI nelle auto ts2.tech. Diversi produttori (Xpeng, BYD, Volvo) hanno annunciato che useranno Thor dal 2025 15 .

- MoE AI on-device di Oppo (ottobre 2024): Come accennato, Oppo ha implementato un modello Mixture-of-Experts sul telefono Find X8 Grandviewresearch. È una notizia rilevante perché i modelli MoE sono solitamente grandi e considerati da server per la loro complessità. L’esecuzione di MoE on-device suggerisce nuove tecniche di compressione dei modelli e una NPU molto potente (probabilmente la MediaTek Dimensity 9400 su quel dispositivo).

- Occhiali AI Ray-Ban di Meta (2025): (Previsti) Meta ha mostrato prototipi di occhiali intelligenti che possono identificare ciò che vedi e parlarti a riguardo – probabilmente utilizzando un acceleratore personalizzato a bordo (Meta sta prototipando silicio personalizzato per l’AR). Sebbene i dettagli siano scarsi, questo sottolinea la spinta a inserire l’IA in dispositivi molto vincolati (occhiali, auricolari a batteria), il che richiederebbe NPU ultra-efficienti.

- Benchmark MLPerf Mobile Inference (2023–24): MLCommons ha pubblicato risultati che mostrano la potenza dell’IA degli smartphone più recenti. Ad esempio, in MLPerf Inference v3.0 (ottobre 2023), Apple A16, Google Tensor G2 e Qualcomm Gen 2 sono stati tutti testati su compiti come classificazione di immagini e rilevamento di oggetti. I numeri hanno mostrato Apple e Qualcomm alternarsi nelle vittorie, ma in generale che le NPU mobili stanno colmando il divario con alcuni acceleratori di classe laptop/desktop per questi compiti – tutto mentre funzionano a batteria. Ha anche evidenziato differenze software (ad es. AI SDK di Qualcomm vs. Apple Core ML). I continui miglioramenti ogni anno (a doppia cifra percentuale) in questi benchmark dimostrano la sana competizione e il rapido progresso dell’IA on-device.

- Partnership strategiche: Sono nate molte partnership intersettoriali. Ad es., NVIDIA e MediaTek (maggio 2023) hanno annunciato una collaborazione per inserire la proprietà intellettuale GPU di Nvidia e l’ecosistema software nei futuri chip per smartphone e automotive di MediaTek, unendo di fatto i punti di forza di Nvidia nell’IA con l’esperienza di MediaTek nei SoC mobili. Inoltre, aziende come Qualcomm stanno collaborando con case automobilistiche (Mercedes, BMW) per inserire le piattaforme Snapdragon Cockpit e Ride (con NPU) nei nuovi veicoli per funzionalità IA. Arm sta collaborando con Fujitsu e altri per nuovi progetti di chip IA (come la partizione IA del supercomputer Fugaku, anche se questo è di fascia alta). Perfino IBM e Samsung hanno anticipato nuove tecnologie di chip (come il computing neuromorfico e la memoria IA) che un giorno potrebbero rivoluzionare le NPU – non ancora disponibili, ma a dimostrazione che le pipeline di ricerca sono piene.

In definitiva, l’ultimo anno è stato ricco di sviluppi, sottolineando che l’IA on-device è una delle aree più calde della tecnologia. Come ha osservato un analista del settore, “queste capacità on-device sbloccano orizzonti completamente nuovi… eseguire LLM su mobile aiuta a gestire scala e costi, mantiene i dati privati e garantisce che l’IA funzioni anche con connettività limitata” Futurumgroup. Questo riassume bene il motivo per cui tutte le grandi aziende tech stanno investendo qui.

Approfondimenti degli esperti: cosa dicono i leader tecnologici sull’IA on-device

Il dinamismo dietro NPU e TPU non è evidente solo nei prodotti ma anche nelle parole dei leader del settore. Ecco alcune citazioni e prospettive che fanno luce sull’importanza dell’IA on-device:

- Cristiano Amon (CEO di Qualcomm): “Se l’IA deve raggiungere la scala, la vedrai funzionare sui dispositivi… Questo segna un punto di svolta nell’IA: nessun problema di latenza — solo inferenza fluida, sicura, complementare al cloud e direttamente sul dispositivo. Il futuro dell’IA è personale, e inizia dal tuo dispositivo.” (Intervista a Bloomberg e post su X, 2023) X. Amon immagina un mondo ibrido dell’IA in cui il tuo telefono/PC gestisce molto tramite le proprie NPU, collaborando con il cloud quando necessario. Sottolinea che eseguire l’IA localmente è fondamentale per renderla ubiqua (non si può far affidamento solo sulle GPU del cloud – non ce ne sono abbastanza al mondo per miliardi di dispositivi).

- Durga Malladi (SVP, Qualcomm): “Apprezziamo l’approccio di Meta verso un’IA aperta e responsabile… Per scalare efficacemente l’IA generativa nel mainstream, l’IA dovrà funzionare sia sul cloud che sui dispositivi all’edge.” Iconnect007 Malladi ha detto questo nel contesto della partnership con Meta. Sottolinea una visione comune: scalare l’IA = cloud + edge che lavorano insieme. Ora si comprende che l’IA solo su cloud non sarà sufficiente (per motivi di costo, privacy e latenza), quindi l’IA edge deve condividere il carico.

- Will Chen (Vice Direttore Generale, MediaTek): “Il futuro dell’IA va oltre il cloud; è guidato dall’edge computing direttamente dal palmo della tua mano… OPPO e MediaTek sono pionieri dell’IA on-device, garantendo che le capacità intelligenti siano potenti, veloci, private, sicure e sempre accessibili.” (MediaTek Exec Talk, 2025) Mediatek. Questa citazione riassume perfettamente la proposta di valore dell’IA on-device: ottieni prestazioni e accessibilità più privacy e sicurezza. Mostra anche che persino aziende tradizionalmente meno visibili in Occidente (come MediaTek) stanno pensando all’avanguardia nel deployment dell’IA.

- Dr. Norman Wang (esperto di hardware IA, CEO di una startup di chip): “Nell’hardware IA, più vicino puoi mettere il calcolo alla fonte dei dati, meglio è. Si tratta di ridurre il movimento dei dati. Una NPU accanto al tuo sensore d’immagine significa che non stai inviando megapixel al cloud – stai distillando insight direttamente all’edge. Questo cambia le regole del gioco per latenza e consumo energetico.” (Panel a HotChips 2024 – parafrasato). Questa osservazione tecnica spiega perché le NPU spesso si trovano sullo stesso silicio di altri componenti: ad esempio, su un SoC di uno smartphone, la NPU può acquisire direttamente i dati della fotocamera dall’ISP. Minimizzare il movimento dei dati è una parte fondamentale dell’efficienza dell’IA, e l’IA edge lo realizza elaborando i dati alla fonte.

- Xinzhou Wu (VP Automotive, NVIDIA): “L’elaborazione accelerata ha portato a scoperte trasformative, inclusa l’IA generativa, che sta ridefinendo l’autonomia e l’industria dei trasporti.” (GTC 2024 Keynote) ts2.tech. Stava discutendo di come i potenti computer di bordo (con NPU/GPU) permettano alle auto non solo di guidare, ma anche di potenzialmente incorporare IA avanzata come i modelli generativi per cose come interfacce in linguaggio naturale in auto o una migliore comprensione delle situazioni. Sottolinea che anche settori come l’automotive vedono l’IA on-device non solo come funzionalità di base ma anche come miglioramento dell’esperienza utente (ad esempio, assistenti vocali in auto che possono sostenere conversazioni grazie agli LLM di bordo).

- Sundar Pichai (CEO di Google): “Il futuro dell’IA consiste nel renderla utile per tutti. Questo significa portare l’IA in tutti i dispositivi che usiamo – telefoni, elettrodomestici, auto – così che sia lì quando serve. Vogliamo raggiungere gli utenti ovunque si trovino, con un’IA che funzioni in tempo reale, in loco, e che preservi la privacy.” (Parafrasi da varie interviste/keynote). Pichai parla spesso di “IA ambientale” – l’idea che l’IA sarà ovunque intorno a noi, integrata nelle cose. L’impegno di Google con i chip Tensor nei Pixel è un’esecuzione diretta di questa filosofia.

- Statistiche di settore: Gli analisti hanno osservato la tendenza nei numeri. Un rapporto di Grand View Research del 2024 ha rilevato: “I recenti progressi nei chip AI specializzati e nelle NPU hanno permesso l’esecuzione di algoritmi AI complessi direttamente sui dispositivi, migliorando notevolmente prestazioni ed efficienza energetica… siamo vicini a una transizione cruciale verso l’IA on-device.” Grandviewresearch. Lo stesso rapporto prevede che il mercato dell’IA on-device esploderà nei prossimi anni, con il segmento hardware (NPU, ecc.) che rappresenterà oltre il 60% della quota di ricavi nel 2024 e crescerà man mano che quasi ogni nuovo dispositivo IoT o mobile adotterà capacità AI Grandviewresearch. Un’altra previsione di IDC e altri suggerisce che entro la metà degli anni 2020, quasi tutti gli smartphone di fascia alta e la maggior parte di quelli di fascia media avranno acceleratori AI, e che entro il 2030, miliardi di chip AI edge saranno in uso dall’elettronica di consumo alle infrastrutture intelligenti.

Il consenso tra gli esperti è che l’IA on-device non è solo un optional – è essenziale per la prossima ondata tecnologica. Il pioniere dell’IA Andrew Ng ha spesso affermato che la “tiny AI” e l’edge AI permetteranno all’intelligenza di penetrare ogni oggetto, in modo analogo a quanto avvenuto con l’elettricità o Internet in epoche precedenti. Superando i limiti dell’IA solo su cloud, NPU e TPU stanno rendendo possibile questa penetrazione.

La sfida dei tanti standard (e gli sforzi per semplificare)

Mentre l’hardware si è evoluto rapidamente, l’ecosistema di software e standard per l’AI on-device sta ancora cercando di recuperare terreno. Gli sviluppatori si trovano di fronte a una giungla di strumenti e SDK quando cercano di sfruttare le NPU su dispositivi diversi Nimbleedge. Punti chiave:- Ogni piattaforma ha la propria API o SDK: Apple ha Core ML (con API per indirizzare il Neural Engine), Android ha Neural Networks API (NNAPI) (anche se Google ha annunciato l’intenzione di evolverla oltre Android 14) Threads, Qualcomm offre la SNPE (Snapdragon Neural Processing Engine) o più in generale il Qualcomm AI Stack, NVIDIA ha TensorRT e CUDA per i suoi dispositivi, e così via. Ci sono anche ONNX Runtime, TensorFlow Lite, PyTorch Mobile, MediaTek NeuroPilot, Huawei HiAI e altri. Questi SDK diversi spesso hanno capacità differenti e richiedono l’adattamento dei modelli per funzionare in modo ottimale su ciascun target. Come osservato in un rapporto sull’AI on-device del 2025, “Molteplici SDK incompatibili (ad es. Core ML, LiteRT, ONNX Runtime) con supporto e prestazioni degli operatori variabili” costringono gli sviluppatori a fare lavoro extra 16 .

- Problemi di frammentazione: Un modello che funziona perfettamente su una GPU desktop potrebbe non funzionare immediatamente su una NPU di uno smartphone – alcuni operatori (le funzioni matematiche) potrebbero non essere supportati o necessitare di una quantizzazione diversa. Gli sviluppatori a volte devono mantenere build separate o ottimizzare manualmente i modelli per ciascun hardware. Questa è la lamentela del “ecosistema frammentato e di basso livello” Nimbleedge. Anche gli strumenti di debug sono scarsi – profilare una NPU per capire perché un modello è lento può essere difficile, soprattutto rispetto ai ricchi strumenti disponibili per CPU/GPU 17 .

- Sforzi di standardizzazione: Per affrontare questo, ci sono alcune iniziative in corso. ONNX (Open Neural Network Exchange) è emerso come formato comune, così puoi addestrare un modello in PyTorch o TensorFlow e poi esportarlo in ONNX per il deployment. Molti runtime (inclusi quelli on-device come quelli di Qualcomm e MediaTek) supportano l’importazione di modelli ONNX e tenteranno di compilarli per l’hardware. Questo aiuta a evitare il lock-in su un singolo framework. Android NNAPI è stato un tentativo di Google di fornire un’interfaccia universale – un’app può richiedere “esegui questa rete neurale” tramite NNAPI e il sistema operativo userà qualsiasi acceleratore sia presente (GPU, DSP o NPU) per eseguirla. NNAPI è stato adottato in molti dispositivi Android, ma aveva delle limitazioni e non tutti i produttori hanno fornito driver robusti, portando Google a indicare una nuova strategia (forse puntando su WebNN o integrazioni dirette con i vendor) oltre il 2024 Threads. Su PC, Microsoft ha introdotto DirectML e le API Windows ML per astrarre in modo simile le differenze hardware (consentendo a uno sviluppatore di usare la stessa API per NPU NVIDIA, Intel, AMD).

- Toolchain unificate: Le aziende stanno anche costruendo toolchain per semplificare il deployment. Abbiamo visto la AI Stack di Qualcomm che combina il loro compilatore (AI Model Efficiency Toolkit) e i runtime così gli sviluppatori possono puntare più facilmente alla loro Hexagon NPU Iconnect007. TensorRT di NVIDIA e gli SDK correlati fanno qualcosa di simile per i dispositivi Jetson, ottimizzando i modelli per GPU+NVDLA. Intel OpenVINO è un altro esempio – ti permette di prendere un modello e ottimizzarlo per CPU Intel, iGPU e VPU (NPU) per deployment edge. Questi framework spesso includono ottimizzatori di modelli che convertono i modelli (potatura, quantizzazione) per adattarli a dispositivi più piccoli.

- Interoperabilità: C’è movimento verso la possibilità di far funzionare diverse NPU con framework comuni. Ad esempio, TensorFlow Lite di Google ha dei delegati hardware – uno per NNAPI (copre genericamente i dispositivi Android), uno per Core ML (dispositivi iOS), uno per Edge TPU, ecc. L’idea è che scrivi il tuo modello TFLite e verrà eseguito usando il miglior acceleratore disponibile tramite il delegato. Allo stesso modo, PyTorch sta aggiungendo supporto per backend mobile e anche per cose come le Metal Performance Shaders di Apple (per usare GPU/NPU su iOS). ONNX Runtime può anche puntare a diversi acceleratori tramite plugin (ad esempio, si può collegare TensorRT di NVIDIA o ARM Compute Library o altri sotto il cofano).

- Standard emergenti: Il Khronos Group (dietro OpenGL/Vulkan) ha lavorato su NNEF (Neural Network Exchange Format) e c’è la WebNN API in discussione per permettere ai browser di accedere all’accelerazione AI locale. Nessuno di questi è ancora universalmente adottato. Ma uno sviluppo interessante: alla fine del 2024, diverse aziende hanno formato un’alleanza per promuovere standard “AI Hardware Common Layer” – in pratica, esplorando se si possa creare un’interfaccia comune di basso livello per le NPU (in modo analogo a quanto fatto da OpenCL per il compute su GPU). È ancora presto, però.

- Esperienza degli sviluppatori: È una lacuna riconosciuta. Come ha detto il blog di NimbleEdge, “sviluppare per l’AI on-device attualmente richiede di navigare in un ecosistema frammentato e di basso livello… costringendo gli sviluppatori a personalizzare le implementazioni per ogni hardware” Nimbleedge. L’industria sa che questo deve migliorare affinché l’AI on-device diventi davvero mainstream. Potremmo vedere una consolidazione – ad esempio, se Google, Apple e Qualcomm riuscissero a concordare un insieme di operazioni e API di base (forse un pensiero troppo ottimistico). Più probabilmente, framework come PyTorch e TensorFlow nasconderanno la complessità integrando tutte quelle librerie dei vendor e scegliendo quella giusta a runtime.

In sostanza, mentre NPU/TPU forniscono la potenza, la community sta lavorando su strumenti “brain-friendly” per usare quella potenza. La buona notizia è che rispetto a, diciamo, cinque anni fa, ci sono molte più opzioni per distribuire un modello on-device senza essere esperti di chip. Ma c’è ancora margine di crescita – soprattutto in debugging, profiling e supporto multi-hardware.

Tendenze di mercato e prospettive future

La proliferazione di NPU e TPU nei dispositivi sta guidando una tendenza più ampia: AI ovunque. Ecco alcune tendenze di alto livello e cosa aspettarsi per il futuro:

- Crescita del mercato Edge AI: Le ricerche di mercato indicano una crescita esplosiva dell’hardware AI edge. Il mercato dell’AI on-device (inclusi chip e software) dovrebbe crescere a un CAGR di circa il 29% per tutto il decennio Nimbleedge. Un rapporto lo ha valutato a circa 233 miliardi di dollari nel 2024, con una previsione di oltre 1,7 trilioni di dollari entro il 2032 Nimbleedge – gran parte di questa crescita trainata dalle implementazioni edge. Un’altra analisi di IDTechEx prevede che il mercato dei chip AI per dispositivi edge raggiungerà i 22 miliardi di dollari entro il 2034, con elettronica di consumo, automotive e industriale come segmenti principali Idtechex. Questo implica che centinaia di milioni di dispositivi all’anno verranno spediti con NPU come componente standard.

- Adozione ubiquitaria: Proprio come oggi ogni smartphone ha una GPU (anche se piccola), stiamo raggiungendo il punto in cui ogni nuovo smartphone avrà un acceleratore AI. I telefoni di fascia alta li hanno già; i telefoni di fascia media saranno i prossimi. Infatti, i chip di fascia media di Qualcomm (ad es. la serie Snapdragon 7) e MediaTek (serie Dimensity 700/800) ora includono NPU ridimensionate in modo che funzionalità come miglioramenti della fotocamera AI e assistente vocale possano funzionare anche su dispositivi economici. Oltre ai telefoni, le NPU si stanno diffondendo su PC (standard nei nuovi laptop Windows di diversi produttori), auto (quasi tutte le nuove auto con ADAS Livello 2+ hanno qualche tipo di chip AI), e IoT. Persino elettrodomestici come frigoriferi e lavatrici stanno iniziando a vantare funzionalità “AI” (alcune basate su cloud, ma alcune locali come cicli adattivi basati su sensori). La tendenza è chiara: se un dispositivo ha un chip di calcolo, avrà qualche accelerazione ML su quel chip.

- Traiettoria delle prestazioni: Le prestazioni dell’AI on-device stanno raddoppiando circa ogni 1–2 anni (combinazione di architetture migliori e passaggio a nodi semiconduttori avanzati come 5nm, 4nm, 3nm). Il Neural Engine di Apple è passato da 600 miliardi di operazioni/sec nel 2017 a 35 trilioni nel 2023 – quasi un aumento di 60× in sei anni Fandom. Anche i top di gamma di Qualcomm sono passati da pochi TOPS nel 2018 a oltre 27 TOPS nel 2023 (AI totale di SD 8 Gen 3, contando tutti i core). Possiamo aspettarci che entro il 2025–2026 le NPU mobili raggiungano oltre 100 TOPS, e gli acceleratori per PC anche di più, e questi numeri potrebbero diventare meno rilevanti man mano che l’attenzione si sposta su prestazioni utilizzabili su compiti AI specifici (ad esempio, quanto grande può essere un LLM che puoi eseguire senza problemi, o se puoi fare video AI 4K in tempo reale). Il divario tra cloud ed edge probabilmente si ridurrà per i compiti di inferenza. Tuttavia, l’edge sarà ancora indietro rispetto al cloud per i modelli di grandi dimensioni più all’avanguardia a causa dei limiti di potenza e memoria.

- Guadagni in efficienza energetica: Un aspetto sottovalutato è quanto queste NPU stiano diventando efficienti. La NPU delle auto Tesla raggiunge ~4,9 TOPS/Watt Wikichip che era lo stato dell’arte un paio di anni fa; ora alcune NPU mobili dichiarano valori simili o migliori. NPU efficienti significano maggiore durata della batteria anche con un uso crescente delle funzionalità AI. Significa anche che diventa possibile inserire AI in dispositivi minuscoli alimentati a batteria (ad es. apparecchi acustici AI, sensori intelligenti alimentati da batterie a bottone che fanno rilevamento anomalie). Il concetto di TinyML – machine learning su scala estremamente ridotta su microcontrollori – è un’estensione di questo, usando “NPU” semplificate o istruzioni ottimizzate su microcontrollori per fare AI nei sensori. L’Ethos-U NPU di ARM è pensato per quel segmento (ad es. keyword spotting always-on che funziona con pochi milliwatt). Aspettatevi più chip minuscoli specifici per l’AI che potranno essere integrati in sensori, dispositivi indossabili e oggetti di uso quotidiano (spazzolino smart? Rilevatore di fumo AI? Sta arrivando).

- Soluzioni ibride Cloud-Edge: Piuttosto che l’edge sostituisca completamente il cloud, il futuro è la collaborazione. I dispositivi faranno localmente ciò che possono e si collegheranno solo per ciò che non possono fare. Ad esempio, i tuoi occhiali AR potrebbero eseguire il riconoscimento della scena in locale per capire cosa stai guardando, ma se chiedi una domanda molto complessa (come una spiegazione approfondita), potrebbero interrogare un’IA nel cloud per un’analisi più potente e poi presentartela. Questo approccio ibrido offre il miglior equilibrio tra reattività e capacità. Le aziende stanno attivamente progettando esperienze attorno a questo: Copilot di Microsoft su Windows potrebbe usare la NPU locale per trascrivere rapidamente la voce in testo e analizzare i comandi, ma poi usare il cloud per i compiti più pesanti (a meno che tu non abbia una NPU PC molto potente che possa gestirlo). Idealmente, l’utente non dovrebbe sapere né preoccuparsi di quale sia usato, se non per il fatto che tutto è più veloce e rispettoso della privacy. Vedremo anche l’apprendimento federato diventare più comune – i modelli si allenano nel cloud ma con l’aiuto di dati criptati o elaborati sui dispositivi, e viceversa.

- Casi d’uso emergenti: Man mano che le NPU diventano più potenti, si aprono nuove applicazioni. L’IA generativa on-device è una delle principali – immagina la creazione di immagini AI, il montaggio video AI e chatbot personali tutti sul tuo telefono o laptop. Entro il 2025, potremmo vedere le prime versioni di assistenti personali offline che possono riassumere le tue email o scrivere bozze di messaggi senza il cloud. La traduzione linguistica in tempo reale durante una conversazione (due persone che parlano lingue diverse, con telefoni o auricolari che traducono quasi in tempo reale) sarà notevolmente migliorata dall’elaborazione on-device (nessun ritardo e funziona ovunque). L’IA per la salute potrebbe vivere su dispositivi indossabili – il tuo smartwatch che rileva la fibrillazione atriale o analizza i pattern di apnea notturna usando la sua NPU. Sicurezza: i dispositivi potrebbero eseguire localmente l’IA per rilevare malware o phishing in tempo reale (ad esempio, un antivirus che usa un modello AI sul tuo dispositivo invece di scansioni nel cloud). E nei veicoli, oltre alla guida, l’IA potrebbe personalizzare l’esperienza in auto (regolare il clima in base al tuo umore percepito tramite una IA con telecamera rivolta al conducente, ecc.). Molti di questi casi d’uso richiedono iterazione rapida e privacy, che si adattano bene all’on-device.

- Competizione e democratizzazione: I grandi attori continueranno a competere, il che è positivo per i consumatori – aspettati campagne di marketing tipo “il nostro chip AI fa X TOPS o abilita la funzione Y che gli altri non possono”. Ma anche la tecnologia si sta democratizzando – le NPU non sono solo nei telefoni da 1000 dollari; stanno arrivando su telefoni da 300 dollari, schede IoT da 50 dollari (Coral, Arduino Portenta, ecc.), e le comunità open-source stanno creando piccoli modelli AI che gli hobbisti possono eseguire su un Raspberry Pi o microcontrollore con un acceleratore di base. Questa ampia disponibilità significa che l’innovazione può arrivare da ovunque. Un singolo sviluppatore ora può creare un’app che usa l’IA on-device per fare qualcosa di intelligente senza bisogno di una server farm – abbassando la barriera d’ingresso per il software guidato dall’IA.

- Tecnologie future: Guardando ancora più avanti, la ricerca su neuromorphic computing (chip ispirati al cervello come Intel Loihi) e chip AI analogici potrebbe un giorno rivoluzionare le NPU, offrendo guadagni di efficienza di ordini di grandezza. Aziende come IBM e BrainChip stanno lavorando su questi fronti. Se avranno successo, un chip neuromorfico potrebbe permettere ad AI complesse di funzionare in modo continuo su dispositivi a batteria molto piccoli. Potremmo anche vedere 3D stacking e nuove tecnologie di memoria integrate nelle NPU per superare i colli di bottiglia della memoria (alcuni chip dal 2025 in poi potrebbero usare memoria HBM o nuove memorie non volatili on-chip per alimentare i core AI più velocemente). Inoltre, aspettatevi una maggiore specializzazione all’interno dei chip AI: ad esempio, acceleratori separati per la visione, per il parlato, per i modelli di raccomandazione, ecc., ciascuno ottimizzato per il proprio dominio. Alcuni SoC hanno già doppie NPU (una NPU “grande” per compiti pesanti, una micro NPU nell’hub sensori per compiti leggeri sempre attivi).

In conclusione, la traiettoria è chiara: le NPU e le TPU stanno diventando standard e indispensabili quanto le CPU nell’informatica moderna. Permettono ai dispositivi di essere più intelligenti, reattivi e rispettosi della nostra privacy. Come afferma un rapporto, “le unità di elaborazione ad alte prestazioni sui dispositivi sono in gran parte responsabili dell’esecuzione di funzioni AI complesse come il riconoscimento delle immagini, l’NLP e il decision-making in tempo reale”, e questo sta guidando una tecnologia più intelligente e reattiva in tutti i settori 18 .

Stiamo entrando in un’era in cui semplicemente ti aspetterai che il tuo dispositivo capisca e anticipi le tue esigenze – il tuo telefono modifica le foto e scrive messaggi nel tuo stile, la tua auto evita incidenti e ti intrattiene con l’AI, i tuoi dispositivi domestici imparano le tue preferenze – tutto reso possibile dai silenziosi processori neurali al loro interno. L’AI on-device non è fantascienza; è già qui e sta migliorando rapidamente. L’unione di NPU e TPU con i nostri dispositivi quotidiani sta rendendo l’AI personale, pervasiva e privata – portando davvero la potenza dell’intelligenza cloud a terra (o almeno, nella tua tasca).

Fonti:

- Bigelow, Stephen. “GPUs vs. TPUs vs. NPUs: Comparing AI hardware options.” TechTarget, 27 ago 2024 Techtarget. Descrive i ruoli e le differenze tra CPU, GPU, TPU e NPU nei carichi di lavoro AI.

- Backblaze Blog. “AI 101: GPU vs. TPU vs. NPU.” Backblaze, 2023 Backblaze. Spiegazione del design delle TPU di Google (array sistolici, bassa precisione) e dell’uso delle NPU nei dispositivi mobili.

- TechTarget WhatIs. “Tensor processing unit (TPU).” whatis.techtarget.com, 2023 Techtarget. Nota che le TPU sono specializzate in compiti di matematica matriciale e le NPU imitano le reti neurali cerebrali per l’accelerazione 19 .

- NimbleEdge Blog (Neeraj Poddar). “The State of On-Device AI: What’s Missing in Today’s Landscape.” 26 giugno 2025 Nimbleedge. Delinea i vantaggi dell’AI on-device (latenza, offline, privacy, costo) e le sfide come SDK frammentati.

- Qualcomm (OnQ Blog). “Bloomberg and Cristiano Amon talk on-device AI.” Luglio 2023 X. Il CEO di Qualcomm sull’importanza dell’inferenza on-device per il futuro dell’AI (citazione tweet su un punto di svolta nell’AI).

- MediaTek Blog (Exec Talk di Will Chen). “Shaping the future of AI mobile experiences.” 3 marzo 2025 Mediatek. Collaborazione tra MediaTek e Oppo sulle NPU; citazione sull’edge computing a portata di mano ed esempio di rimasterizzazione foto AI tramite la NPU.

- I-Connect007 / Qualcomm Press. “Qualcomm works with Meta to enable on-device AI (Llama 2).” 24 luglio 2023 Iconnect007. Comunicato stampa con citazione del SVP di Qualcomm Durga Malladi sull’espansione dell’AI generativa tramite dispositivi edge e cloud.

- PCWorld (Mark Hachman). “Intel’s Core Ultra CPUs keep AI simple….” 24 ottobre 2024 Pcworld. Discute di Intel Arrow Lake che utilizza la NPU di Meteor Lake (13 TOPS) e nota la NPU da 39 TOPS di AMD Ryzen 8000 e il requisito “Copilot” da 40 TOPS di Microsoft.

- Ts2 (Tech Empowerment). “Sfida tra supercomputer a guida autonoma: NVIDIA Thor vs Tesla HW4 vs Qualcomm Ride.” Set. 2023 ts2.tech. Fornisce stime TOPS: Tesla HW3 vs HW4 (72→100 TOPS per chip) ts2.tech, NVIDIA Thor ~1000 TOPS (o 2000 con dual) ts2.tech e cita il VP di NVIDIA sull’AI generativa nei veicoli 20 .