- A IBM planeja um supercomputador quântico com mais de 4.000 qubits até 2025, alcançado ao interconectar três chips Kookaburra de 1.386 qubits para formar um sistema de 4.158 qubits.

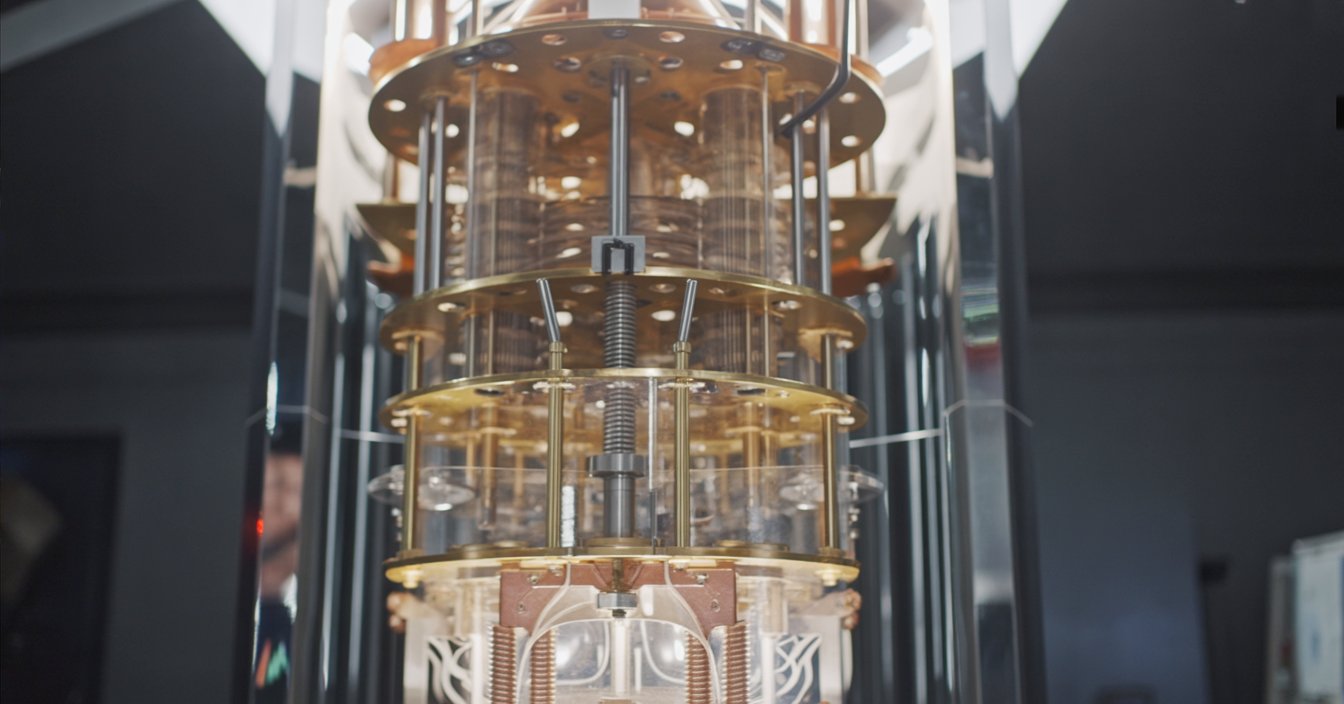

- A plataforma modular Quantum System Two, lançada em 2023, foi projetada para hospedar múltiplos chips e conta com um refrigerador criogênico e eletrônica de controle avançada.

- No final de 2023, a IBM ativou o primeiro Quantum System Two, operando três processadores Heron de 133 qubits em paralelo.

- Até o final de 2025, a IBM pretende hospedar três chips Kookaburra no System Two, criando uma única máquina com 4.158 qubits.

- A IBM utiliza acopladores de curto alcance entre chips e conexões criogênicas para conectar os chips em um único tecido computacional.

- A empresa chama essa abordagem de supercomputação centrada em quântica, entrelaçando QPUs com CPUs e GPUs em um tecido computacional unificado.

- O Qiskit Runtime e o circuit knitting permitem que desenvolvedores executem grandes cargas de trabalho quânticas em múltiplos chips com mitigação de erros integrada.

- O sistema com mais de 4.000 qubits operará no regime NISQ em 2025, contando com mitigação de erros em vez de correção total de erros quânticos.

- Especialistas estimam que quebrar o RSA-2048 exigiria cerca de 4.000 qubits lógicos com correção de erros, provavelmente milhões de qubits físicos.

- Os concorrentes incluem o Google, que busca computação quântica tolerante a falhas até 2029, a IonQ perseguindo qubits algorítmicos, a Quantinuum focando em alta fidelidade e tolerância a falhas, e a D-Wave oferecendo um sistema de recozimento com mais de 5.000 qubits.

A IBM está à beira de um avanço na computação quântica: um “supercomputador quântico” com mais de 4.000 qubits até 2025. O plano ambicioso do gigante da tecnologia – parte de uma estratégia quântica mais ampla – promete revolucionar a computação ao enfrentar problemas que os supercomputadores mais rápidos de hoje não conseguem resolver. Neste relatório, vamos detalhar a jornada quântica da IBM, o design do seu sistema com mais de 4.000 qubits, opiniões de especialistas (e o hype), como se compara a rivais como Google e IonQ, e o que uma máquina de 4.000 qubits pode significar para o mundo.

Contexto: A busca da IBM pela computação quântica

A IBM tem sido pioneira em computação quântica, liderando o avanço tanto no desenvolvimento de hardware quanto de software. Em 2020, a IBM apresentou um roteiro quântico e tem cumprido cada marco desde então. Eles demonstraram o processador Eagle de 127 qubits em 2021 – um chip tão complexo que seus circuitos “não podem ser simulados exatamente de forma confiável em um computador clássico” [1]. Em 2022, a IBM apresentou o chip Osprey de 433 qubits, um grande avanço em relação ao Eagle em número de qubits [2]. Mais recentemente, no final de 2023, a IBM atingiu a marca de 1.121 qubits com seu processador Condor – o primeiro processador quântico a ultrapassar a barreira de mil qubits [3]. Cada um desses avanços estabeleceu uma base crucial para a escalada para milhares de qubits.

Mas a estratégia da IBM não se resume apenas a adicionar mais qubits. A empresa enfatiza uma abordagem de pilha completa: hardware quântico robusto, software quântico inteligente e um amplo ecossistema de usuários e parceiros [4], [5]. Em 2016, a IBM colocou o primeiro computador quântico na nuvem para uso público e, hoje, mais de 200 organizações e 450.000 usuários estão conectados aos serviços quânticos da IBM via nuvem [6]. A estrutura de software da IBM (Qiskit) e o ambiente Qiskit Runtime permitem que desenvolvedores executem programas quânticos de forma eficiente, com ferramentas integradas para mitigar erros e orquestrar cargas de trabalho híbridas quântico-clássicas [7], [8]. Essa integração estreita de hardware e software – juntamente com uma rede de colaboradores acadêmicos e industriais – é central para o objetivo mais amplo da IBM: levar a computação quântica útil ao mundo, e não apenas demonstrações de laboratório.

A IBM gosta de chamar essa visão de “supercomputação centrada em quântica.” A ideia é, eventualmente, entrelaçar processadores quânticos (QPUs) com CPUs e GPUs clássicas em uma malha computacional contínua [9]. Assim como supercomputadores recentes combinam CPUs e aceleradores de IA para lidar com cargas de trabalho de IA, a IBM vê os supercomputadores do futuro combinando motores quânticos e clássicos para enfrentar problemas que nenhum deles poderia resolver sozinho [10]. Nas palavras do Dr. Jay Gambetta, vice-presidente de quântica da IBM, “Agora, a IBM está inaugurando a era do supercomputador centrado em quântica, onde recursos quânticos – QPUs – serão entrelaçados com CPUs e GPUs em uma malha computacional”, com o objetivo de resolver “os problemas mais difíceis” na ciência e na indústria [11]. É uma visão ousada que vai além de apenas criar um computador mais rápido; trata-se de mudar a própria forma da computação.

Projetando um Supercomputador Quântico com mais de 4.000 Qubits

Como construir um computador quântico com mais de 4.000 qubits? A resposta da IBM: modularidade. Em vez de um único chip gigante, a IBM está conectando vários chips quânticos menores em um único sistema – um pouco como ligar nós em um supercomputador. A próxima geração de plataforma da empresa, chamada IBM Quantum System Two, foi projetada especificamente para isso. Lançado em 2023, o System Two é o primeiro sistema de computação quântica modular da IBM, apresentando um refrigerador criogênico de última geração e eletrônica de controle que pode suportar múltiplos processadores quânticos simultaneamente [12], [13]. É a “casa” física que irá abrigar a futura frota de chips conectados da IBM, todos resfriados a quase zero absoluto. Ao combinar chips, a IBM pode aumentar rapidamente a contagem de qubits sem precisar fabricar chips únicos de tamanho impossível – uma abordagem crucial para saltar de centenas para milhares de qubits.

Figura: A visão da IBM para um supercomputador quântico é conectar múltiplos chips quânticos em um único sistema. Em 2025, a IBM planeja apresentar o “Kookaburra”, um processador de 1.386 qubits com links de comunicação quântica; três chips Kookaburra podem ser conectados em um único sistema de 4.158 qubits [14]. Essa arquitetura modular permite que a IBM escale para milhares de qubits interligando processadores menores em vez de depender de um único chip massivo.

O coração do plano de 4.000 qubits da IBM é sua próxima família de processadores com nomes de código de aves. Em 2024, espera-se que a IBM lance o “Flamingo”, um chip de 462 qubits projetado para testar a comunicação quântica entre chips [15]. A IBM planeja demonstrar o design do Flamingo conectando três processadores Flamingo em um único sistema de 1.386 qubits – basicamente mostrando que múltiplos chips podem trabalhar juntos como se fossem um só [16]. Depois vem o grande: em 2025, a IBM vai revelar o “Kookaburra”, um processador de 1.386 qubits construído para escalonamento modular [17]. Graças a conexões de comunicação integradas, três chips Kookaburra podem se interconectar para formar uma única máquina com 4.158 qubits [18]. Nas palavras da IBM, este será o primeiro supercomputador centrado em quântica, ultrapassando o marco de 4.000 qubits.Então, como é essa arquitetura? Essencialmente, a IBM está usando acopladores de curto alcance entre chips e conexões criogênicas para unir qubits em diferentes chips [19]. Pense em cada chip como um “azulejo” de qubits; acopladores permitem que azulejos adjacentes compartilhem informações quânticas, e cabos especiais de micro-ondas podem conectar chips um pouco mais distantes [20]. O desafio é fazer com que qubits em chips separados se comportem quase como se estivessem no mesmo chip – nada fácil, já que estados quânticos são frágeis. A IBM vem desenvolvendo nova tecnologia de acopladores para manter qubits emaranhados coerentes entre chips [21]. O System Two fornece o ambiente ultrafrio e livre de vibrações e uma configuração de cabeamento flexível para acomodar essas redes multi-chip [22]. Tudo isso é orquestrado por uma camada de controle “inteligente” (software e computação clássica) que direciona operações quânticas entre os diferentes chips, fazendo-os trabalhar em conjunto [23].

A linha do tempo da IBM prevê que o sistema com mais de 4.000 qubits esteja operacional em algum momento de 2025 [24]. Na verdade, as primeiras peças já estão no lugar. No final de 2023, na Cúpula Quantum da IBM, a empresa ativou o primeiro Quantum System Two, operando três processadores menores “Heron” de 133 qubits em paralelo [25]. Isso serviu como um protótipo: Heron é um chip de relativamente poucos qubits, mas com taxas de erro significativamente melhoradas, e a IBM usou o System Two para mostrar que pode operar múltiplos processadores juntos como um único sistema [26]. Ao longo do próximo ano ou dois, a IBM irá ampliar isso – trocando por chips maiores (como Flamingo e depois Kookaburra) e conectando mais deles. O objetivo é que até o final de 2025, o IBM Quantum System Two hospede três chips Kookaburra e assim mais de 4.000 qubits conectados em uma única máquina [27]. Olhando mais adiante, a IBM até imagina conectar múltiplos System Twos: por exemplo, conectar três desses sistemas poderia resultar em um cluster com mais de 16.000 qubits no futuro [28]. Em outras palavras, 4.000 qubits não é o objetivo final – é um degrau rumo a máquinas quânticas ainda maiores construídas pela interligação de módulos, assim como supercomputadores clássicos aumentam de escala com múltiplos nós.

A Visão da IBM: Insights dos Líderes em Quantum

A equipe quântica da IBM está compreensivelmente empolgada – e otimista – sobre o que esse salto para 4.000 qubits significa. O Diretor de Pesquisa da IBM, Dr. Darío Gil, frequentemente falou sobre alcançar uma nova era de computação quântica prática. “Executar nossa visão nos deu uma visão clara do futuro da computação quântica e do que será necessário para nos levar à era da computação quântica prática”, disse Gil, enquanto a IBM expandia seu roteiro [29]. Com a meta de mais de 4.000 qubits à vista, ele a descreveu como o início de “uma era de supercomputadores centrados em quântica que abrirá espaços computacionais grandes e poderosos” para desenvolvedores, parceiros e clientes [30]. Em outras palavras, a IBM vê isso como o início de computadores quânticos que não são apenas experimentos de laboratório, mas ferramentas poderosas para uso no mundo real.

Jay Gambetta, IBM Fellow e VP de Quantum, chamou 2023 de um grande ponto de inflexão – o momento em que o conceito de supercomputador centrado em quântica se tornou realidade em forma de protótipo [31]. Segundo Gambetta, simplesmente ter mais qubits não é suficiente; “supercomputação centrada em quântica exigirá mais do que apenas muitos qubits”, explicou ele – também é necessário maior profundidade de circuito e integração estreita com sistemas clássicos [32]. Isso reflete a ênfase da IBM na qualidade dos qubits e na fusão perfeita entre computação quântica e clássica. “Nossa missão é trazer a computação quântica útil para o mundo,” disse Gambetta. “Vamos continuar a fornecer a melhor oferta quântica full-stack da indústria — e cabe ao setor colocar esses … sistemas em uso” [33]. A mensagem: a IBM entregará o hardware e o software, e espera que empresas e pesquisadores comecem a fazer coisas impactantes com isso.

No Cúpula Quântica de 2023, a equipe da IBM adotou um tom otimista sobre a maturidade da tecnologia. “Estamos firmemente dentro da era em que computadores quânticos estão sendo usados como uma ferramenta para explorar novas fronteiras da ciência,” comentou o Dr. Darío Gil, observando que as máquinas quânticas não são mais apenas curiosidades [34]. Ele destacou o progresso da IBM em escalar esses sistemas por meio de design modular e prometeu “aumentar ainda mais a qualidade de uma pilha tecnológica quântica em escala utilitária – e colocá-la nas mãos de nossos usuários e parceiros, que irão ultrapassar os limites de problemas mais complexos” [35]. Em essência, à medida que a IBM aumenta o número de qubits, eles também estão trabalhando para melhorar a fidelidade dos qubits e a ‘inteligência’ do software, para que esses milhares de qubits possam realmente realizar trabalhos úteis em problemas complexos.

A IBM até usa uma metáfora vívida para a mudança que está por vir. A empresa compara a transição dos computadores quânticos incipientes de hoje para o supercomputador quântico de 2025 a “substituir mapas de papel por satélites de GPS” na navegação [36]. É uma imagem evocativa: supercomputadores quânticos poderiam nos guiar por problemas computacionais de uma maneira fundamentalmente nova, assim como o GPS revolucionou a forma como nos orientamos. Se a realidade corresponderá ao otimismo da IBM ainda está para ser visto, mas não há dúvida de que as mentes mais brilhantes da IBM acreditam estar à beira de algo grande.

O que dizem os especialistas: Hype e realidade

O anúncio dos 4.000 qubits da IBM gerou muito burburinho, mas especialistas externos frequentemente nos lembram de manter as expectativas sob controle. Um ponto-chave que eles destacam: mais qubits sozinhos não garantem resultados úteis. Os bits quânticos de hoje são “ruidosos” – propensos a erros – então simplesmente conectar milhares de qubits imperfeitos não resolve magicamente os problemas se esses qubits não conseguirem manter a coerência. IEEE Spectrum observou que o plano da IBM precisará ser acompanhado por uma “camada de software inteligente” para gerenciar erros e orquestrar a carga de trabalho híbrida quântico-clássica [37]. Na verdade, uma nova pilha de software poderosa pode ser “a chave para fazer qualquer coisa útil” com um processador de 4.000 qubits, ao lidar com mitigação de erros e dividir tarefas entre o hardware quântico e co-processadores clássicos [38]. Em resumo, a contagem bruta de qubits não é tudo – como você usa e controla esses qubits é igualmente crucial.

Alguns observadores da indústria também destacam a diferença entre qubits físicos e qubits lógicos. Um qubit lógico é um qubit corrigido por erro, efetivamente um agrupamento de muitos qubits físicos trabalhando juntos para agir como um qubit muito confiável. Especialistas estimam que quebrar a criptografia moderna (como as chaves RSA de 2048 bits que protegem a segurança online) exigiria cerca de 4.000 qubits lógicos corrigidos por erro – o que, na prática, pode significar milhões de qubits físicos, dado o atual custo de correção de erros [39]. Como disse um analista de segurança, “4.000 qubits lógicos não são o mesmo que 4.000 qubits reais” – um computador quântico totalmente corrigido por erros com milhares de qubits lógicos ainda é um sonho distante [40]. A máquina de mais de 4.000 qubits da IBM estará longe desse ideal tolerante a falhas; ela consistirá em qubits físicos que exigem técnicas inteligentes de mitigação de erros para serem úteis. Pesquisadores alertam rapidamente que não devemos esperar que essa máquina, por exemplo, quebre a criptografia da internet ou resolva todos os problemas insolúveis da noite para o dia.

Dito isso, o roteiro agressivo da IBM a coloca à frente de muitos concorrentes na corrida pelo número bruto de qubits, e alguns especialistas elogiam a abordagem modular como uma forma pragmática de escalar. “Acreditamos que os recursos clássicos podem realmente potencializar o que você pode fazer com o quântico e extrair o máximo desse recurso quântico,” observou Blake Johnson, líder da Quantum Platform da IBM, enfatizando a necessidade de orquestração entre a computação quântica e clássica para aproveitar esses grandes sistemas [41]. Esse sentimento é amplamente compartilhado: o futuro é “quântico-mais-clássico” trabalhando em conjunto.

Visões concorrentes: IBM vs. Google, IonQ e outros

A IBM não está sozinha na corrida quântica, mas sua estratégia contrasta com a de outros grandes players. O Google, por exemplo, tem se concentrado menos na contagem de qubits no curto prazo e mais em alcançar um computador quântico totalmente com correção de erros. O roteiro do Google visa realizar uma máquina quântica útil e com correção de erros até 2029, e a empresa tem trabalhado constantemente na demonstração de qubits lógicos e na redução de erros, em vez de tentar bater recordes de contagem de qubits [42]. (Os dispositivos atuais do Google, como o Bristlecone de 72 qubits ou as versões mais recentes do Sycamore de 53 qubits, têm bem menos qubits do que os da IBM, mas o Google mostrou recentemente que aumentar o número de qubits físicos em um qubit lógico pode reduzir a taxa de erro, um passo promissor rumo à escalabilidade [43].) Em declarações públicas, a liderança do Google projeta um prazo de 5 a 10 anos para que a computação quântica comece a ter impactos reais [44]. Assim, enquanto a IBM avança rumo a um protótipo de 4.000 qubits, o Google está jogando no longo prazo para alcançar um computador quântico totalmente tolerante a falhas, mesmo que tenha apenas dezenas de qubits no curto prazo.

Quantinuum (a empresa formada pela Honeywell e Cambridge Quantum) é outro peso-pesado, mas segue um caminho tecnológico diferente: qubits de íons aprisionados. A Quantinuum não está buscando milhares de qubits físicos de imediato – seu sistema mais recente de armadilha de íons tem cerca de 50 a 100 qubits de alta fidelidade – mas eles já demonstraram volume quântico recorde (uma medida da capacidade geral) e até criaram 12 qubits “lógicos” via correção de erros em 2024 [45]. O roteiro da Quantinuum tem como meta computação quântica totalmente tolerante a falhas até 2030, e a empresa enfatiza alcançar fidelidade de “três noves” (99,9% de confiabilidade) e avanços em qubits lógicos como etapas importantes [46]. O CEO deles, Rajeeb Hazra, argumenta que qualidade e avanços em correção de erros vão destravar um “mercado de trilhões de dólares” para o setor quântico, e afirma que a Quantinuum tem “o roteiro mais credível da indústria rumo… à computação quântica tolerante a falhas” [47]. Em resumo, o foco da Quantinuum é aperfeiçoar os qubits e a correção de erros, mesmo que isso signifique menos qubits por enquanto – um contraste com a grande aposta da IBM em escalar e lidar com o ruído por meio de mitigação.

Outro concorrente importante, IonQ, também utiliza tecnologia de íons aprisionados e igualmente enfatiza a qualidade dos qubits. A liderança da IonQ frequentemente destaca os “qubits algorítmicos” – uma métrica interna que leva em conta taxas de erro e conectividade – em vez do simples número de qubits físicos [48]. O roteiro da IonQ visa alcançar uma “vantagem quântica ampla até 2025”, mas por meio da melhoria contínua do desempenho de seus qubits e da construção de sistemas modulares de armários de íons aprisionados, não apenas atingindo um número específico e alto de qubits [49]. Na verdade, a IonQ projeta precisar de apenas algumas dezenas de qubits de alta qualidade para superar computadores quânticos barulhentos muito maiores em certas tarefas. O ex-CEO Peter Chapman previu que a tecnologia da IonQ “será fundamental para a vantagem quântica comercial,” especificamente enfatizando qubits algorítmicos em vez de contagens físicas como a chave para aplicações úteis [50]. Essa filosofia destaca um debate no campo: a computação quântica é um “jogo de números” (mais qubits mais rápido) ou um “jogo de qualidade” (qubits melhores mesmo que mais lentos para escalar)? A IBM está apostando nos números (com atenção à qualidade também), enquanto a IonQ está firmemente no campo da qualidade em primeiro lugar.

Há também a Rigetti Computing, uma empresa menor que trabalha com qubits supercondutores. O roteiro da Rigetti enfrentou atrasos – eles esperavam alcançar 1.000 qubits por meio de módulos multi-chip até 2024, mas na prática seus sistemas ainda estão na casa das dezenas de qubits. Em meados de 2025, a Rigetti está mirando um sistema mais modesto de 100+ qubits até o final de 2025 [51], focando na melhoria da fidelidade e do desempenho das portas de dois qubits ao longo do caminho. A empresa tem tido dificuldades para acompanhar a rápida escalada da IBM, ilustrando como é desafiador para os novos participantes igualarem os recursos e a expertise da IBM nesse setor. Ainda assim, a Rigetti e outras empresas contribuem para a inovação (por exemplo, a Rigetti foi pioneira em algumas técnicas iniciais de integração multi-chip), e destacam que a liderança da IBM não é inatingível se surgirem avanços fundamentais (como melhores designs de qubits ou materiais).

Também vale mencionar a D-Wave Systems neste contexto. A D-Wave, uma empresa canadense, possui máquinas de recozimento quântico (um modelo diferente de computação quântica) com mais de 5.000 qubits atualmente [52]. No entanto, os qubits da D-Wave são projetados para resolver problemas de otimização via recozimento, não para algoritmos quânticos gerais. Eles alcançam altos números de qubits por meio de uma arquitetura especializada, mas esses qubits não podem executar circuitos quânticos arbitrários como os dispositivos da IBM ou do Google. O CEO da D-Wave, Alan Baratz, observou que sua tecnologia já está gerando valor em certas aplicações (como otimização de escalas no varejo ou roteamento em telecomunicações) [53]. A existência de um sistema D-Wave de 5.000 qubits é um lembrete de que nem todos os qubits são iguais – os qubits da D-Wave são úteis para tarefas específicas, mas não são diretamente comparáveis aos qubits de computadores quânticos baseados em portas lógicas. A meta da IBM de mais de 4.000 qubits refere-se a qubits universais, baseados em portas lógicas, o que é um desafio muito maior em termos de complexidade e capacidade.

Em resumo, a IBM se destaca por escalar agressivamente o hardware de qubits supercondutores e buscar integrá-lo à computação clássica em um curto prazo. O Google foca em marcos de correção de erros, Quantinuum e IonQ priorizam a fidelidade dos qubits (com menos qubits no curto prazo), e empresas como a Rigetti ficam atrás com dispositivos menores. Cada abordagem tem seus méritos. Se a IBM tiver sucesso, estabelecerá um padrão elevado em número de qubits e poderá alcançar a vantagem quântica em tarefas úteis mais cedo. Mas se os qubits forem muito ruidosos, esses 4.000 qubits podem não superar os 100 qubits excelentes de um concorrente. Os próximos anos serão uma corrida fascinante entre diferentes filosofias na computação quântica – e não é garantido que mais qubits sempre vençam, a menos que venham acompanhados de qualidade e software inteligente.

Por que 4.000 qubits? Potenciais aplicações e desafios

O que um computador quântico de 4.000 qubits realmente poderia fazer, se funcionar como esperado? Para contextualizar, os computadores quânticos atuais (com dezenas ou poucas centenas de qubits) ainda não superaram claramente os computadores clássicos em nenhum problema prático. A IBM e outros acreditam que, ao avançar para milhares de qubits, entraremos na zona onde a vantagem quântica útil se torna possível para certas classes de problemas [54]. Aqui estão algumas aplicações e impactos que um sistema de 4.000 qubits pode desbloquear:

- Química e Ciência dos Materiais: Os computadores quânticos são especialmente adequados para simular sistemas moleculares e atômicos. Mesmo os maiores supercomputadores clássicos têm dificuldade em modelar exatamente o comportamento de moléculas complexas e reações químicas. Pesquisadores da IBM apontam que “poucos campos obterão valor da computação quântica tão rapidamente quanto a química,” porque as máquinas quânticas podem lidar nativamente com a natureza quântica das interações químicas [55]. Um sistema de 4.000 qubits poderia potencialmente simular moléculas de tamanho médio ou materiais inovadores com alta precisão – auxiliando na descoberta de medicamentos, desenvolvimento de novos materiais (para baterias, fertilizantes, supercondutores, etc.) e compreensão de processos químicos complexos. Estes são problemas onde os métodos clássicos encontram um limite devido à complexidade exponencial. Até 2025, a IBM prevê que os computadores quânticos começarão a explorar aplicações úteis nas ciências naturais como a química [56].

- Otimização e Finanças: Muitos problemas do mundo real – de logística de cadeias de suprimentos à otimização de portfólios – envolvem encontrar a melhor solução entre possibilidades astronômicas. Computadores quânticos, com algoritmos como QAOA ou técnicas de recozimento quântico, oferecem novas maneiras de atacar certos problemas de otimização. Uma máquina com milhares de qubits poderia lidar com instâncias de problemas maiores ou fornecer soluções mais precisas do que os dispositivos atuais. O CEO da IBM, Arvind Krishna, sugeriu que a computação quântica permitirá novos algoritmos para otimização que as empresas podem aproveitar, tornando-se potencialmente um diferencial chave para indústrias como finanças, energia e manufatura [57]. Um sistema de 4.000 qubits poderia, por exemplo, enfrentar análises de risco complexas ou problemas de otimização de rotas que algoritmos clássicos não conseguem resolver em tempo razoável.

- Aprendizado de Máquina e IA: Há pesquisas crescentes em aprendizado de máquina quântico, onde computadores quânticos podem acelerar certos tipos de tarefas de aprendizado de máquina ou oferecer novas capacidades de modelagem. Com milhares de qubits, computadores quânticos poderiam começar a implementar modelos de redes neurais quânticas ou executar sub-rotinas de álgebra linear mais rápidas que sustentam algoritmos de ML. A IBM, especificamente, está olhando para o aprendizado de máquina como um caso de teste para aplicações quânticas – esperando que até 2025, computadores quânticos sejam usados para explorar casos de uso de aprendizado de máquina ao lado do ML clássico, possivelmente melhorando como reconhecemos padrões em dados ou otimizamos modelos de ML [58]. Um exemplo prático poderia ser a seleção de características ou clusterização aprimorada por quântica em conjuntos de dados complexos, que podem ser acelerados por sub-rotinas quânticas.

- Pesquisa Científica e “Grandes Desafios”: Além das indústrias-alvo, um supercomputador quântico de 4.000 qubits seria uma bênção para a ciência fundamental. Ele poderia ser usado para simular cenários de física de altas energias, otimizar projetos de materiais quânticos ou até mesmo investigar questões em criptografia e matemática. A IBM mencionou as ciências naturais de forma ampla – por exemplo, problemas em física ou biologia que atualmente são intratáveis podem ceder a uma abordagem híbrida quântica [59]. Pense em projetar catalisadores para captura de carbono ou analisar sistemas quânticos em física nuclear – esses são cálculos extremamente complexos onde um computador quântico pode fornecer novos insights. Os próprios pesquisadores da IBM apontaram aplicações em química, otimização e aprendizado de máquina como alvos iniciais para a vantagem quântica [60].

Essa é a promessa brilhante – mas e quanto aos desafios? Um computador quântico de 4.000 qubits enfrentará obstáculos sérios:

- Ruído e Taxas de Erro: Os qubits atuais são propensos a erros; eles decoerem (perdem seu estado quântico) em microssegundos e as operações (“portas”) entre qubits são imperfeitas. Com apenas 50-100 qubits, algoritmos quânticos só podem executar uma sequência muito curta de operações antes que os erros dominem o resultado. Se você tem milhares de qubits, o desafio do ruído se multiplica. Na verdade, conectar três chips (como a IBM planeja) pode introduzir ainda mais erro devido a operações entre chips um pouco mais lentas e de menor fidelidade [61]. A IBM reconhece isso e está desenvolvendo o software do System Two para ser “consciente” da arquitetura – por exemplo, para agendar operações críticas no mesmo chip e gerenciar cuidadosamente as operações mais lentas entre chips [62]. Sem correção de erros (que não estará totalmente implementada até 2025), a IBM dependerá de mitigação de erros: truques inteligentes para reduzir o impacto dos erros. Isso inclui técnicas como cancelamento probabilístico de erros, onde você intencionalmente introduz ruído extra para aprender sobre o ruído e então processa os resultados classicamente para cancelar os erros [63]. Esses métodos são computacionalmente caros e não são perfeitos, mas a pesquisa da IBM sugere que alguns podem ser escalados para dispositivos desse porte [64]. Ainda assim, gerenciar o ruído é a questão central – é o motivo pelo qual computadores quânticos ainda não resolveram problemas do mundo real, e uma máquina de 4.000 qubits só terá sucesso se a IBM conseguir manter os erros sob controle o suficiente para realizar cálculos profundos.

- Correção de Erros & Qubits Lógicos: A solução de longo prazo para o ruído é a correção de erros quânticos (QEC), que agrupará muitos qubits físicos em um qubit lógico capaz de sobreviver a erros. O sistema de 4.000 qubits da IBM provavelmente ainda operará no regime “NISQ” (Quantum Intermediário com Ruído), ou seja, ainda sem correção de erros em larga escala – simplesmente não haverá qubits suficientes para corrigir totalmente todos os 4.000. (Para efeito de comparação, transformar até mesmo alguns milhares de qubits físicos em alguns poucos qubits lógicos pode consumir toda a máquina.) No entanto, a IBM está preparando o terreno para a correção de erros. A empresa tem pesquisado ativamente novos códigos QEC (por exemplo, um código LDPC quântico que é mais eficiente em qubits do que os códigos de superfície tradicionais) e decodificadores de erro rápidos [65]. Na verdade, a IBM recentemente estendeu seu roadmap até 2033, priorizando explicitamente melhorias na qualidade das portas e o desenvolvimento de módulos com correção de erros após 2025 [66]. O supercomputador de 4.000 qubits pode ser visto como uma ponte: ele deve ser grande o suficiente para realizar algumas tarefas úteis com mitigação de erros, enquanto ensina a IBM a implementar correção parcial de erros em escala. A IBM até anunciou um plano para um protótipo de computador quântico tolerante a falhas até 2029 [67], indicando que a correção de erros está realmente na agenda deles assim que o marco dos 4.000 qubits for atingido. Ainda assim, alcançar qubits totalmente corrigidos por erros (lógicos) exigirá ordens de magnitude mais qubits ou uma fidelidade de qubit muito melhor – provavelmente uma combinação de ambos.

- Software e Ferramentas de Desenvolvimento: Mesmo que você tenha uma máquina quântica de 4.000 qubits, é necessário um software que possa utilizá-la de forma eficaz. Os algoritmos quânticos precisam ser mapeados para esse hardware complexo de múltiplos chips. A IBM está abordando isso com ferramentas como Qiskit Runtime e arquitetura Quantum Serverless. Elas permitem que o usuário divida um problema em circuitos quânticos menores, execute-os em paralelo em diferentes chips quânticos e una os resultados com processamento clássico [68]. Por exemplo, “circuit knitting” é uma dessas técnicas destacadas pela IBM – dividir um circuito grande em partes que caibam em processadores menores e depois recombinar os resultados de forma clássica [69]. Até 2025, a IBM planeja ter recursos como circuitos dinâmicos (em que os resultados das medições podem influenciar operações futuras em tempo real) e supressão de erros integrada rodando em sua plataforma em nuvem [70]. O desafio será tornar tudo isso amigável para desenvolvedores. A IBM quer que a computação quântica seja acessível para que cientistas de dados e especialistas de domínio (não apenas PhDs em quântica) possam aproveitar esses 4.000 qubits [71]. Alcançar uma boa abstração – onde o usuário possa, por exemplo, chamar uma função de alto nível para simular uma molécula e o sistema descubra como usar 4.000 qubits para isso – será crucial para a utilidade prática. A abordagem da IBM aqui é o conceito de middleware quântico e uma “app store” de primitivas quânticas: funções pré-construídas para tarefas comuns como amostragem de distribuições de probabilidade ou estimativa de propriedades de sistemas [72]. Se for bem-sucedida, um químico em 2025 pode não precisar conhecer os detalhes do hardware; ele poderia simplesmente usar o software da IBM para acessar o poder dos 4.000 qubits para sua simulação.

- Infraestrutura Física: Escalar para milhares de qubits não é apenas um desafio computacional, mas uma maratona de engenharia. Os processadores quânticos precisam ser resfriados a temperaturas de milikelvin – mais frias do que o espaço sideral. A IBM teve que projetar um novo refrigerador de diluição (IBM Quantum System Two) que é maior e mais modular do que os anteriores para acomodar múltiplos chips e toda a fiação de controle [73]. A geladeira, a eletrônica e a fiação tornam-se cada vez mais complexas à medida que você adiciona qubits. Milhares de qubits significam milhares de linhas de controle de micro-ondas, filtragem sofisticada para evitar que calor e ruído vazem para os qubits, e enormes fluxos de dados provenientes das leituras dos qubits. Os engenheiros da IBM compararam a complexidade de escalar sistemas quânticos à dos primeiros supercomputadores ou missões espaciais. Até 2025, a IBM espera “remover as principais barreiras para o escalonamento” por meio de hardware modular e eletrônica de controle correspondente [74] – mas vale notar que a IBM está apenas atingindo esses limites agora. O System Two em Nova York é essencialmente um protótipo para gerenciar tal complexidade [75]. A IBM também está instalando um System Two na Europa (em parceria com o governo do País Basco, na Espanha) até 2025 [76], o que testará como essa infraestrutura de ponta pode ser replicada fora do próprio laboratório da IBM. O sucesso dessas implementações será uma prova importante de que a tubulação e fiação de um supercomputador quântico podem ser tornadas confiáveis e de fácil manutenção.

Diante desses desafios, especialistas moderam o hype ao observar que uma máquina IBM de 4.000 qubits provavelmente será uma ferramenta altamente especializada. Ela pode superar supercomputadores clássicos em problemas específicos (simulações de química quântica, certas otimizações ou tarefas de aprendizado de máquina, como mencionado), alcançando vantagem quântica ou até mesmo vislumbres de supremacia quântica em contextos úteis. No entanto, isso não tornará instantaneamente os computadores clássicos obsoletos. Na verdade, para muitas tarefas, supercomputadores clássicos e GPUs ainda serão mais rápidos ou práticos. O próprio roteiro da IBM reconhece essa sinergia: o supercomputador quântico foi projetado para funcionar com HPC clássico, cada um fazendo o que faz de melhor [77]. Portanto, devemos ver o sistema de 4.000 qubits como um dos primeiros verdadeiros “aceleradores quânticos” – algo que você usaria ao lado da computação clássica para enfrentar aqueles problemas realmente difíceis que as máquinas clássicas sozinhas não conseguem resolver. É um passo significativo em direção ao sonho final da computação quântica tolerante a falhas, mas não é o destino final.

O Caminho à Frente: O Roteiro Quântico da IBM Além de 2025

O supercomputador de mais de 4.000 qubits da IBM é um marco importante, mas é parte de um roteiro mais longo que se estende até a década de 2030. A IBM declarou publicamente que até 2025, com esse supercomputador centrado em computação quântica em funcionamento, terá “removido alguns dos maiores obstáculos para a escalabilidade do hardware quântico” [78]. Mas o desenvolvimento não vai parar por aí. Em 2025 e além, o foco da IBM vai se voltar cada vez mais para escalar com qualidade – melhorando a fidelidade dos qubits, a correção de erros e a complexidade dos circuitos que podem ser executados.

Na verdade, no final de 2023, a IBM atualizou seu Roteiro de Desenvolvimento Quântico até 2033. Um objetivo chave: por volta de 2026–2027, introduzir operações quânticas com correção de erros em seus sistemas, avançando para “sistemas avançados com correção de erros” mais adiante na década [79]. A IBM está priorizando melhorias na fidelidade das portas lógicas (redução das taxas de erro) para que circuitos quânticos maiores (com milhares de operações) se tornem viáveis [80]. Isso sugere que, após atingir o marco de contagem de qubits, a IBM vai se concentrar em tornar cada qubit melhor e integrar a correção de erros gradualmente. Um exemplo concreto é o trabalho da IBM em novos códigos de correção de erros como os códigos Quantum LDPC e algoritmos de decodificação mais rápidos, que visam lidar com erros de forma mais eficiente do que os códigos de superfície atuais [81]. Também há menção a um processador da IBM de codinome “Loon” por volta de 2025, destinado a testar componentes de uma arquitetura com correção de erros (como módulos para conectar qubits para um código QEC específico) [82]. Até 2029, a IBM aspira construir um protótipo quântico tolerante a falhas demonstrável, alinhando-se com concorrentes como o Google nesse objetivo final [83].

No front de hardware, a IBM provavelmente continuará sua linha de processadores com nomes de pássaros além do Kookaburra. O roteiro além de 2025 não é totalmente público, mas a IBM deu a entender que está explorando sistemas multi-chip ainda maiores e talvez tecnologias híbridas. Por exemplo, a visão da IBM de um supercomputador centrado em computação quântica eventualmente envolve links de comunicação quântica que podem conectar clusters de chips à distância, não apenas no mesmo refrigerador [84]. Podemos ver a IBM incorporar interconexões por fibra óptica ou outros métodos para conectar processadores quânticos em diferentes criostatos – semelhante a uma rede local quântica. Isso abriria caminho para dezenas de milhares ou até milhões de qubits a longo prazo, o que a IBM reconhece que será necessário para resolver os problemas mais difíceis (e realizar a correção total de erros) [85], [86]. Nas palavras da própria IBM, sua abordagem modular e em rede deve permitir a escalabilidade para “centenas de milhares de qubits” ao longo do tempo [87]. O sistema de 4.000 qubits é essencialmente a primeira implementação de uma arquitetura de supercomputador quântico que pode crescer ao conectar mais módulos.O roteiro mais amplo da IBM também envolve expandir o ecossistema quântico. A empresa está investindo em educação, parcerias e acessibilidade via nuvem para que, quando o hardware estiver pronto, haja uma comunidade pronta para usá-lo. Por exemplo, a IBM fez parcerias com laboratórios nacionais, universidades e até governos regionais (como no Japão, Coreia, Alemanha e Espanha) para hospedar sistemas quânticos e impulsionar o desenvolvimento local. O plano de implantar o primeiro IBM Quantum System Two da Europa na Espanha até 2025 [88] faz parte dessa estratégia – colocar mais pessoas em contato direto com hardware quântico avançado. A liderança da IBM prevê que a computação quântica se tornará um diferencial-chave para os negócios nos próximos anos [89], e eles querem estar no centro dessa economia quântica emergente.

Em conclusão, o projeto do supercomputador quântico de mais de 4.000 qubits da IBM representa um salto histórico em escala para a computação quântica. Se for bem-sucedido, marcará a transição de processadores quânticos isolados e experimentais para sistemas quânticos em rede que se aproximam do limiar de utilidade prática. Esse empreendimento está na interseção da física de ponta, engenharia e ciência da computação. É tanto uma conquista de software quanto de hardware, exigindo novas formas de gerenciar e programar um tipo totalmente novo de supercomputador. O mundo está observando atentamente – não apenas pelo número recorde de qubits, mas para ver se a IBM pode demonstrar resultados úteis com esta máquina que superem o que os computadores clássicos podem fazer.

Em meados de 2025, a IBM se encontra à beira dessa conquista: o design do hardware está em grande parte definido, protótipos iniciais estão em funcionamento, e a empresa corre para integrar tudo em um supercomputador funcional. O sucesso não é garantido, mas o ímpeto e o progresso até agora são inegáveis. Mesmo concorrentes e céticos concordariam que a IBM impulsionou dramaticamente o campo. Enquanto aguardamos a estreia completa do supercomputador quântico da IBM, uma coisa é clara – estamos entrando em um novo capítulo da saga da computação. Como a própria IBM proclamou, o próximo supercomputador quântico-centrado está prestes a se tornar “uma tecnologia essencial para quem resolve os problemas mais difíceis, para quem faz as pesquisas mais inovadoras e para quem desenvolve a tecnologia mais avançada” [90].

Os próximos anos dirão se essa promessa será cumprida, mas se a aposta da IBM der certo, 4.000 qubits podem realmente mudar a computação para sempre – abrindo a porta para soluções de problemas que antes considerávamos impossíveis e anunciando o início da era da computação quântica.

Fontes:

- IBM Newsroom: IBM Quantum roadmap and 4,000+ qubit system plans [91]

- IBM Research Blog: Quantum roadmap update for quantum-centric supercomputing (2024) [92]

- IBM Quantum Summit 2023 Press Release [93]

- TechMonitor: IBM apresenta supercomputador quântico que pode chegar a 4.000 qubits até 2025 [94]

- IEEE Spectrum: Meta da IBM: um processador de 4.000 qubits até 2025 (análise do roteiro e desafios) [95]

- InsideHPC: IBM no Think 2022 – visão de supercomputação centrada em computação quântica [96]

- The Quantum Insider: Roteiros de Computação Quântica dos Principais Atores (IBM, Google, IonQ, etc.) [97]

- TomorrowDesk: Visão geral da meta do supercomputador quântico da IBM para 2025 e design modular [98]

- Post-Quantum (blog do setor): Sobre os qubits necessários para quebrar a criptografia RSA-2048 [99]

- TechMonitor: Citações do Dr. Darío Gil da IBM e estatísticas da IBM Quantum Network [100]

References

1. insidehpc.com, 2. www.techmonitor.ai, 3. tomorrowdesk.com, 4. newsroom.ibm.com, 5. insidehpc.com, 6. www.techmonitor.ai, 7. newsroom.ibm.com, 8. insidehpc.com, 9. insidehpc.com, 10. insidehpc.com, 11. insidehpc.com, 12. www.techmonitor.ai, 13. newsroom.ibm.com, 14. www.ibm.com, 15. www.ibm.com, 16. www.ibm.com, 17. www.ibm.com, 18. www.ibm.com, 19. spectrum.ieee.org, 20. spectrum.ieee.org, 21. tomorrowdesk.com, 22. www.techmonitor.ai, 23. insidehpc.com, 24. www.techmonitor.ai, 25. newsroom.ibm.com, 26. newsroom.ibm.com, 27. www.techmonitor.ai, 28. www.techmonitor.ai, 29. newsroom.ibm.com, 30. newsroom.ibm.com, 31. www.techmonitor.ai, 32. www.techmonitor.ai, 33. www.techmonitor.ai, 34. newsroom.ibm.com, 35. newsroom.ibm.com, 36. www.ibm.com, 37. spectrum.ieee.org, 38. spectrum.ieee.org, 39. postquantum.com, 40. postquantum.com, 41. spectrum.ieee.org, 42. thequantuminsider.com, 43. thequantuminsider.com, 44. thequantuminsider.com, 45. thequantuminsider.com, 46. thequantuminsider.com, 47. thequantuminsider.com, 48. thequantuminsider.com, 49. thequantuminsider.com, 50. thequantuminsider.com, 51. thequantuminsider.com, 52. thequantuminsider.com, 53. thequantuminsider.com, 54. tomorrowdesk.com, 55. www.ibm.com, 56. www.ibm.com, 57. thequantuminsider.com, 58. www.ibm.com, 59. www.ibm.com, 60. www.ibm.com, 61. www.ibm.com, 62. www.ibm.com, 63. spectrum.ieee.org, 64. spectrum.ieee.org, 65. thequantuminsider.com, 66. newsroom.ibm.com, 67. www.hpcwire.com, 68. www.ibm.com, 69. www.ibm.com, 70. www.ibm.com, 71. www.ibm.com, 72. www.ibm.com, 73. www.techmonitor.ai, 74. www.ibm.com, 75. newsroom.ibm.com, 76. tomorrowdesk.com, 77. tomorrowdesk.com, 78. www.ibm.com, 79. newsroom.ibm.com, 80. newsroom.ibm.com, 81. thequantuminsider.com, 82. www.hpcwire.com, 83. www.hpcwire.com, 84. newsroom.ibm.com, 85. newsroom.ibm.com, 86. insidehpc.com, 87. newsroom.ibm.com, 88. tomorrowdesk.com, 89. thequantuminsider.com, 90. insidehpc.com, 91. newsroom.ibm.com, 92. www.ibm.com, 93. newsroom.ibm.com, 94. www.techmonitor.ai, 95. spectrum.ieee.org, 96. insidehpc.com, 97. thequantuminsider.com, 98. tomorrowdesk.com, 99. postquantum.com, 100. www.techmonitor.ai